Introduccin histrica

Anuncio

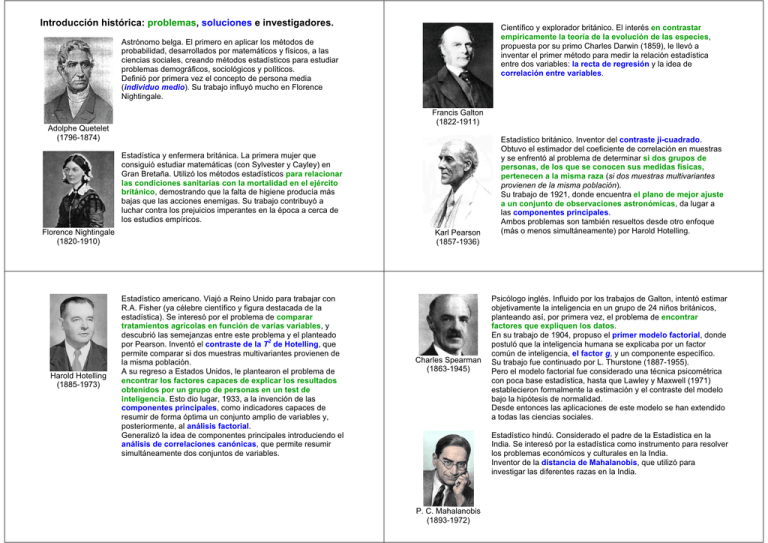

Introducción histórica: problemas, soluciones e investigadores. Científico y explorador británico. El interés en contrastar empíricamente la teoría de la evolución de las especies, propuesta por su primo Charles Darwin (1859), le llevó a inventar el primer método para medir la relación estadística entre dos variables: la recta de regresión y la idea de correlación entre variables. Astrónomo belga. El primero en aplicar los métodos de probabilidad, desarrollados por matemáticos y físicos, a las ciencias sociales, creando métodos estadísticos para estudiar problemas demográficos, sociológicos y políticos. Definió por primera vez el concepto de persona media (individuo medio). Su trabajo influyó mucho en Florence Nightingale. Francis Galton (1822-1911) Adolphe Quetelet (1796-1874) Estadística y enfermera británica. La primera mujer que consiguió estudiar matemáticas (con Sylvester y Cayley) en Gran Bretaña. Utilizó los métodos estadísticos para relacionar las condiciones sanitarias con la mortalidad en el ejército británico, demostrando que la falta de higiene producía más bajas que las acciones enemigas. Su trabajo contribuyó a luchar contra los prejuicios imperantes en la época a cerca de los estudios empíricos. Florence Nightingale (1820-1910) Harold Hotelling (1885-1973) Karl Pearson (1857-1936) Estadístico americano. Viajó a Reino Unido para trabajar con R.A. Fisher (ya célebre científico y figura destacada de la estadística). Se interesó por el problema de comparar tratamientos agrícolas en función de varias variables, y descubrió las semejanzas entre este problema y el planteado por Pearson. Inventó el contraste de la T2 de Hotelling, que permite comparar si dos muestras multivariantes provienen de la misma población. A su regreso a Estados Unidos, le plantearon el problema de encontrar los factores capaces de explicar los resultados obtenidos por un grupo de personas en un test de inteligencia. Esto dio lugar, 1933, a la invención de las componentes principales, como indicadores capaces de resumir de forma óptima un conjunto amplio de variables y, posteriormente, al análisis factorial. Generalizó la idea de componentes principales introduciendo el análisis de correlaciones canónicas, que permite resumir simultáneamente dos conjuntos de variables. Charles Spearman (1863-1945) Estadístico británico. Inventor del contraste ji-cuadrado. Obtuvo el estimador del coeficiente de correlación en muestras y se enfrentó al problema de determinar si dos grupos de personas, de los que se conocen sus medidas físicas, pertenecen a la misma raza (si dos muestras multivariantes provienen de la misma población). Su trabajo de 1921, donde encuentra el plano de mejor ajuste a un conjunto de observaciones astronómicas, da lugar a las componentes principales. Ambos problemas son también resueltos desde otro enfoque (más o menos simultáneamente) por Harold Hotelling. Psicólogo inglés. Influido por los trabajos de Galton, intentó estimar objetivamente la inteligencia en un grupo de 24 niños británicos, planteando así, por primera vez, el problema de encontrar factores que expliquen los datos. En su trabajo de 1904, propuso el primer modelo factorial, donde postuló que la inteligencia humana se explicaba por un factor común de inteligencia, el factor g, y un componente específico. Su trabajo fue continuado por L. Thurstone (1887-1955). Pero el modelo factorial fue considerado una técnica psicométrica con poca base estadística, hasta que Lawley y Maxwell (1971) establecieron formalmente la estimación y el contraste del modelo bajo la hipótesis de normalidad. Desde entonces las aplicaciones de este modelo se han extendido a todas las ciencias sociales. Estadístico hindú. Considerado el padre de la Estadística en la India. Se interesó por la estadística como instrumento para resolver los problemas económicos y culturales en la India. Inventor de la distancia de Mahalanobis, que utilizó para investigar las diferentes razas en la India. P. C. Mahalanobis (1893-1972) Ronald Aylmer Fisher (1890-1962) Estadístico británico, inventor del análisis discriminante, el método de máxima verosimilitud y del diseño estadístico de experimentos. Considerado el padre de la Estadística en el siglo XX. Da la primera solución al problema de la clasificación, inventando un método general, basado en el análisis de la varianza. El problema era clasificar un cráneo encontrado en una excavación arqueológica como perteneciente a un homínido o no. La idea de Fisher es encontrar una variable indicadora, combinación lineal de las variables originales de las medidas del cráneo, que consiga máxima separación entre las dos poblaciones en consideración (MANOVA). En 1937 visita la India invitado por Mahalanobis, donde descubre la relación entre la distancia de Mahalanobis y sus resultados en análisis discriminante. Consigue unificar estas ideas y relacionarlas con los trabajos de Hotelling sobre el contraste de medias de poblaciones multivariantes. Un estudiante de Mahalanobis, C. R. Rao, va a extender el análisis discriminante de Fisher para clasificar un elemento a más de dos poblaciones. Técnicas de clasificación: ¾ Análisis de conglomerados (cluster analysis): Clasificación o agrupación de los individuos de un conjunto en clases disjuntas, denominadas conglomerados o clusters, utilizando las distancias observadas entre ellos. ¾ Análisis discriminante: Asignar un individuo a una de varias poblaciones conocidas, utilizando una función de las variables observadas en estas poblaciones. Para todas las técnicas de análisis multivariante es fundamental el álgebra matricial: aritmética de matrices, producto escalar y proyección ortogonal, determinante, rango, traza, extremos de formas cuadráticas, matrices definidas positivas, inversa y g-inversa, matrices ortogonales, descomposición espectral, descomposición en valores singulares, operaciones de matrices por cajas… Clasificación de algunas técnicas de análisis multivariante Técnicas de representación y reducción de la dimensión: ¾ Análisis de componentes principales: Resumir la información contenida en unos datos mediante un número menor de variables que las observadas, sin gran pérdida de información. Estas nuevas variables (indicadores) facilitan la interpretación de los datos. ¾ Análisis canónico de poblaciones (MANOVA): Método descriptivo que permite representar varias poblaciones (sobre las que se ha observado el mismo número de variables) de forma óptima a lo largo de unos ejes ortogonales, con el fin de poder estudiar las relaciones entre ellas. ¾Análisis de coordenadas principales (Escalado multidimensional o MDS): Obtener una representación euclídea de un conjunto de individuos a partir de las distancias o similaridades observadas entre ellos.