Modelo de corrección de error y cointegración en E

Anuncio

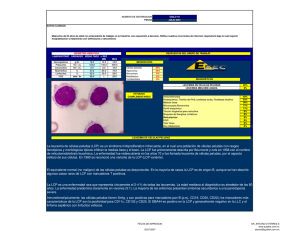

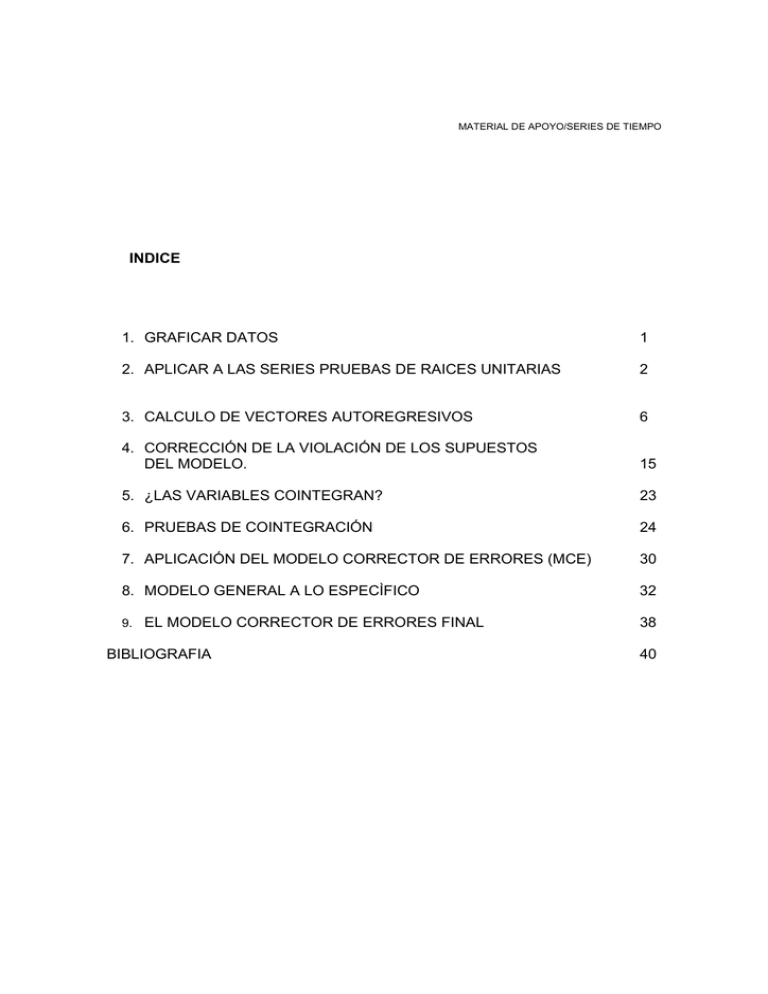

MATERIAL DE APOYO/SERIES DE TIEMPO INDICE 1. GRAFICAR DATOS 1 2. APLICAR A LAS SERIES PRUEBAS DE RAICES UNITARIAS 2 3. CALCULO DE VECTORES AUTOREGRESIVOS 6 4. CORRECCIÓN DE LA VIOLACIÓN DE LOS SUPUESTOS DEL MODELO. 15 5. ¿LAS VARIABLES COINTEGRAN? 23 6. PRUEBAS DE COINTEGRACIÓN 24 7. APLICACIÓN DEL MODELO CORRECTOR DE ERRORES (MCE) 30 8. MODELO GENERAL A LO ESPECÌFICO 32 9. EL MODELO CORRECTOR DE ERRORES FINAL 38 BIBLIOGRAFIA 40 MODELO DE CORRECCIÓN DE ERRORES Y COINTEGRACIÓN EN E-VIEWS Este es un ejemplo de un mecanismo corrector de errores realizado en E-views. Para este caso, plantearemos un modelo de consumo, el cuál podemos expresar de la siguiente manera: cp = y + i Donde: cp= Consumo privado y= Ingreso real i= Inflación Nota: Las series están expresadas en el mismo año base (1993), tienen periodicidad trimestral y el periodo es de 1980:1 a 2005:4. Antes de modelar, transformaremos las series en logaritmos de “y”, “i” y “cp” por conveniencia. 10. GRAFICAR DATOS Lo primero que se debe reportar en un trabajo (después de la introducción, el índice y el marco teórico-histórico) son los gráficos de las series, tanto en niveles como en logaritmos, así como el significado de cada variable y el período tomado. Nota: Las transformaciones de las variables a logaritmos y los gráficos pueden hacerlas desde Excel. Logaritmo del Consumo Privado Consumo Privado 1.4E+09 21.1 1.3E+09 21.0 1.2E+09 20.9 20.8 1.1E+09 20.7 1.0E+09 20.6 9.0E+08 20.5 8.0E+08 20.4 7.0E+08 6.0E+08 1980 20.3 1985 1990 1995 CP 2000 2005 20.2 1980 1985 1990 1995 2000 2005 LCP 1 Logaritmo del Ingreso Ingreso 21.4 2.0E+09 21.3 1.8E+09 21.2 1.6E+09 21.1 1.4E+09 21.0 20.9 1.2E+09 20.8 1.0E+09 8.0E+08 1980 20.7 1985 1990 1995 2000 2005 20.6 1980 1985 1990 Inflación 19.6 3.0E+08 19.4 2.5E+08 19.2 2.0E+08 19.0 1.5E+08 18.8 1985 1990 1995 I 2005 Logaritmo de Inflación 19.8 3.5E+08 1.0E+08 1980 2000 LY Y 4.0E+08 1995 2000 2005 18.6 1980 1985 1990 1995 2000 2005 LI Después de los gráficos, lo que se reporta son los resultados sintetizados de las pruebas de raíces unitarias. De preferencia, se realiza un cuadro personalizado como en el ejemplo (Cuadro 1 y Cuadro 2) el cual contenga la información más relevante. 11. APLICAR A LAS SERIES PRUEBAS DE RAICES UNITARIAS Tendrá que ser un cuadro por prueba (Dickey-Fuller Aumentada y Phillips-Perron) para cada variable (para este caso: lcp, li y ly): Cuadro 1. Dickey- Fuller 2 Variable lcp Modelo t-Statistic 5% Prob Constante CyT None .982190 -2.731937 2.457502 -2.892536 -3.458326 -1.944286 0.9962 0.2265 0.9965 Constante .859928 -2.892536 .9946 CyT -3.335868 -3.457808 .0668 None 2.747065 -1.944286 0.9985 -411141 -2.218209 0.885178 -2.889753 -3.454032 -1.943974 0.9022 0.4743 0.8982 ly Constante CyT None li Cuadro 2. Philips- Perron Variable lcp ly li Modelo Constante CyT None Constante CyT None Constante CyT None t-Statistic -0.057020 -4.567675 3.298468 0.124594 -5.708493 4.033356 -0.732297 -2.482334 0.758533 5% -2.889753 -3.454032 -1.943974 -2.889753 -3.454032 -1.943974 -2.889753 -3.454032 -1.943974 Prob 0.9503 0.0020 0.9997 0.9662 0.0000 1.0000 0.8330 0.3362 0.8763 Recuerde que para realizar las pruebas de raíces unitarias debe: 1) Seleccionar y abrir la ventana de la variable de nuestro workfile 2) Seleccionar de la barra de botones: View / Unit Root Test y realizar las pruebas de raíces unitarias. 3) Desplegará una ventana de diálogo, la cual mostrará las opciones para aplicar las pruebas. El primer campo tiene un combo de opciones de distintas pruebas en este ejercicio trabajaremos con la Dickey-Fuller Aumentada y la Phillips-Perron. Para la opción 3 de Lag Lenght utilizaremos el criterio que viene por default (Schwarz), con 12 rezagos. Para la prueba Dickey-Fuller los cálculos se presentan de la siguiente manera: (Ejemplo de la variable LCP) Modelos en niveles (levels): Cuadro 3. Constante (intercept) Null Hypothesis: LCP has a unit root Exogenous: Constant Lag Length: 9 (Automatic based on SIC, MAXLAG=12) t-Statistic Augmented Dickey-Fuller test statistic 0.982190 Test critical values: 1% level -3.501445 5% level -2.892536 10% level -2.583371 *MacKinnon (1996) one-sided p-values. Prob.* 0.9962 a) Cuadro 4. Constante y tendencia (trend and intercept) Null Hypothesis: LCP has a unit root Exogenous: Constant, Linear Trend Lag Length: 9 (Automatic based on SIC, MAXLAG=12) t-Statistic Augmented Dickey-Fuller test statistic -2.731937 Test critical values: 1% level -4.058619 5% level -3.458326 10% level -3.155161 *MacKinnon (1996) one-sided p-values. Prob.* 0.2265 b) Cuadro 5. Sin constante y sin tendencia (none) Null Hypothesis: LCP has a unit root Exogenous: None Lag Length: 9 (Automatic based on SIC, MAXLAG=12) t-Statistic Augmented Dickey-Fuller test statistic 2.457502 Test critical values: 1% level -2.589795 5% level -1.944286 10% level -1.614487 *MacKinnon (1996) one-sided p-values. Prob.* 0.9965 En primeras diferencias (1st difference): 4 c) Cuadro 6. Constante (intercept) Null Hypothesis: D(LCP) has a unit root Exogenous: Constant Lag Length: 8 (Automatic based on SIC, MAXLAG=12) t-Statistic Augmented Dickey-Fuller test statistic -3.706008 Test critical values: 1% level -3.501445 5% level -2.892536 10% level -2.583371 *MacKinnon (1996) one-sided p-values. Prob.* 0.0055 d) Cuadro 7. Constante y tendencia (trend and intercept) Null Hypothesis: D(LCP) has a unit root Exogenous: Constant, Linear Trend Lag Length: 8 (Automatic based on SIC, MAXLAG=12) t-Statistic Augmented Dickey-Fuller test statistic -4.058553 Test critical values: 1% level -4.058619 5% level -3.458326 10% level -3.155161 *MacKinnon (1996) one-sided p-values. Prob.* 0.0100 e) Cuadro 8. Sin constante y sin tendencia (none) Null Hypothesis: D(LCP) has a unit root Exogenous: None Lag Length: 8 (Automatic based on SIC, MAXLAG=12) t-Statistic Augmented Dickey-Fuller test statistic -2.709354 Test critical values: 1% level -2.589795 5% level -1.944286 10% level -1.614487 *MacKinnon (1996) one-sided p-values. Prob.* 0.0072 Este mismo proceso habrá que realizarlo para cada variable. Recordemos que la H0 es que existe raíz unitaria en nuestra serie y H1 es que la serie es estacionaria. Por tanto, para aprobar H1 la probabilidad debe ser menor a 0.05 (5%) o en su defecto, en términos absolutos al valor crítico del 5% (si no pasa al 5% podemos flexibilizarnos al 10%). Para aprobar H0, la probabilidad debe ser mayor a 0.05. 12. CALCULO DE VECTORES AUTOREGRESIVOS 5 El siguiente paso a seguir consiste en construir el modelo VAR. Es necesario reiterar que tenemos que las variables a utilizar deben ser de orden de integración 1, es decir I(1). La forma de demostrar el orden de integración, como lo vimos anteriormente, es a través de las pruebas de raíces unitarias. El VAR es un modelo que implica un sistema de ecuaciones. Todas las variables son endógenas en el sistema y son explicadas por los rezagos de las mismas, por tanto, es un modelo dinámico pero ateórico. Para especificar el VAR en el programa, es necesario seleccionar del menú principal: Quick/ Estimate VAR... Entonces, se abrirá la siguiente ventana de diálogo: En la opción Endogenous Variables pondremos las variables que queremos utilizar para estimar (lcp, ly y li). En la ventana siguiente (Lag Intervals for ...) se declaran el número de rezagos que emplearemos en el modelo. Para esta primer etapa, dejaremos el número de rezagos que aparece por default. También para la opción 6 de la siguiente ventana (Exogenous Variables) se dejará la opción que aparece (c: constante), oprima el botón Aceptar. Antes de especificar el número de rezagos a emplear, utilizaremos los criterios de decisión para el número de rezagos óptimo propuesto por el programa. Para esto, requerimos de seleccionar View / Lag Structure / Lag Lenght Criteria... en la ventana abierta de la especificación del VAR. Se despliega una nueva ventana que pide el número de rezagos a incluir en los criterios. En un modelo con series trimestrales es recomendable colocar 8, para datos mensuales 16. Para este caso, pondremos 8. VAR Lag Order Selection Criteria Endogenous variables: LCP LY LI Exogenous variables: C Date: 10/16/07 Time: 10:52 Sample: 1980:1 2005:4 Included observations: 96 Lag LogL LR FPE AIC SC HQ 0 1 2 3 4 5 6 7 8 300.3780 521.4061 615.7767 660.6556 722.9871 734.7455 739.0205 741.3733 751.7454 NA 423.6373 174.9787 80.40820 107.7815 19.59724* 6.857772 3.627264 15.34208 4.09E-07 4.94E-09 8.35E-10 3.96E-10 1.31E-10 1.24E-10* 1.38E-10 1.59E-10 1.57E-10 -6.195374 -10.61263 -12.39118 -13.13866 -14.24973 -14.30720* -14.20876 -14.07028 -14.09886 -6.115239 -10.29208 -11.83023 -12.33730 -13.20797* -13.02502 -12.68618 -12.30729 -12.09547 -6.162982 -10.48306 -12.16443 -12.81474 -13.82863* -13.78892 -13.59331 -13.35765 -13.28906 * indicates lag order selected by the criterion LR: sequential modified LR test statistic (each test at 5% level) FPE: Final prediction error AIC: Akaike information criterion SC: Schwarz information criterion HQ: Hannan-Quinn information criterion Los asteriscos indican cuál es el número de rezagos óptimo para el modelo. La 7 mayoría de los criterios señalan que el número de rezagos óptimo son 5 (Sólo el SC muestra que 4 es el número óptimo). Importante: Cabe aclarar que el número de rezagos óptimo que arrojan los criterios, no necesariamente son del todo exactos, únicamente nos dan un punto de referencia, es decir, puede que el número de rezagos óptimo se encuentre entre 3 y 6 rezagos. En función a los resultados obtenidos, se reestimará el modelo con 5 rezagos. Vector Autoregression Estimates Date: 10/16/07 Time: 11:00 Sample(adjusted): 1981:2 2005:4 Included observations: 99 after adjusting endpoints Standard errors in ( ) & t-statistics in [ ] LCP LY LI LCP(-1) 0.635209 (0.14180) [ 4.47962] -0.006522 (0.11509) [-0.05667] -0.151079 (0.38488) [-0.39253] LCP(-2) -0.122657 (0.13405) [-0.91502] 0.018578 (0.10880) [ 0.17076] -0.141770 (0.36384) [-0.38965] LCP(-3) 0.081468 (0.13176) [ 0.61831] 0.022282 (0.10695) [ 0.20835] 0.400854 (0.35763) [ 1.12085] LCP(-4) 0.513876 (0.12353) [ 4.15978] -0.249352 (0.10027) [-2.48685] -0.403221 (0.33530) [-1.20255] LCP(-5) -0.235578 (0.13880) [-1.69722] 0.169156 (0.11266) [ 1.50147] 0.252508 (0.37674) [ 0.67024] LY(-1) -0.249411 (0.19428) [-1.28379] 0.275059 (0.15769) [ 1.74432] -0.206584 (0.52732) [-0.39176] LY(-2) 0.709951 (0.13544) [ 5.24194] 0.534534 (0.10993) [ 4.86255] 1.229645 (0.36761) [ 3.34497] LY(-3) -0.394992 (0.15428) [-2.56022] -0.218568 (0.12522) [-1.74542] -0.256767 (0.41876) [-0.61317] 8 LY(-4) -0.020874 (0.15692) [-0.13303] 0.858230 (0.12736) [ 6.73843] 0.193422 (0.42591) [ 0.45414] LY(-5) 0.094843 (0.20451) [ 0.46376] -0.401713 (0.16599) [-2.42005] -0.613532 (0.55509) [-1.10527] LI(-1) 0.263224 (0.05860) [ 4.49157] 0.261340 (0.04757) [ 5.49417] 1.242574 (0.15907) [ 7.81165] LI(-2) -0.205622 (0.07038) [-2.92170] -0.204634 (0.05712) [-3.58235] -0.368439 (0.19102) [-1.92877] LI(-3) -0.049575 (0.07501) [-0.66087] -0.011596 (0.06089) [-0.19046] -0.250213 (0.20361) [-1.22888] LI(-4) 0.022599 (0.07561) [ 0.29889] -0.078221 (0.06137) [-1.27458] 0.183801 (0.20523) [ 0.89560] LI(-5) -0.026484 (0.05909) [-0.44817] 0.035907 (0.04796) [ 0.74861] -0.016337 (0.16040) [-0.10185] C -0.363391 (0.30816) [-1.17922] -0.095117 (0.25012) [-0.38028] -2.363547 (0.83643) [-2.82574] R-squared Adj. R-squared Sum sq. resids S.E. equation F-statistic Log likelihood Akaike AIC Schwarz SC Mean dependent S.D. dependent 0.991668 0.990162 0.034033 0.020249 658.5622 254.3144 -4.814432 -4.395019 20.60104 0.204155 0.993763 0.992636 0.022421 0.016436 881.7040 274.9728 -5.231774 -4.812360 20.95996 0.191531 0.969383 0.963850 0.250729 0.054962 175.1939 155.4611 -2.817395 -2.397982 19.24083 0.289073 Determinant Residual Covariance Log Likelihood (d.f. adjusted) Akaike Information Criteria Schwarz Criteria 7.93E-11 729.8145 -13.77403 -12.51579 Donde las ecuaciones quedan de la siguiente manera: VAR Model - Substituted Coefficients: 9 =============================== LCP = 0.6352090578*LCP(-1) - 0.1226568686*LCP(-2) + 0.08146835244*LCP(-3) + 0.5138764094*LCP(-4) - 0.2355782925*LCP(-5) - 0.2494110047*LY(-1) + 0.7099510195*LY(-2) 0.3949922689*LY(-3) - 0.02087417914*LY(-4) + 0.0948430648*LY(-5) + 0.263224497*LI(-1) 0.2056218455*LI(-2) - 0.04957480924*LI(-3) + 0.02259898405*LI(-4) - 0.02648408424*LI(-5) 0.3633912399 LY = - 0.006522011827*LCP(-1) + 0.01857843967*LCP(-2) + 0.02228245194*LCP(-3) 0.2493523974*LCP(-4) + 0.1691563095*LCP(-5) + 0.2750591988*LY(-1) + 0.5345340237*LY(-2) 0.2185676575*LY(-3) + 0.8582304662*LY(-4) - 0.4017127462*LY(-5) + 0.261340012*LI(-1) 0.2046339703*LI(-2) - 0.01159645535*LI(-3) - 0.07822145261*LI(-4) + 0.03590657554*LI(-5) 0.09511654109 LI = - 0.1510791423*LCP(-1) - 0.1417696261*LCP(-2) + 0.4008536103*LCP(-3) 0.4032210695*LCP(-4) + 0.2525084512*LCP(-5) - 0.2065844898*LY(-1) + 1.229645033*LY(-2) 0.2567672366*LY(-3) + 0.1934220338*LY(-4) - 0.6135323087*LY(-5) + 1.242574095*LI(-1) 0.368439102*LI(-2) - 0.2502130014*LI(-3) + 0.1838014295*LI(-4) - 0.01633677359*LI(-5) 2.363546655 No es fundamental reportar los resultados obtenidos por el modelo VAR, ya que los coeficientes no se pueden interpretar en relación con la teoría económica de fondo. La finalidad de presentarlo en este ejemplo es la de esclarecer los pasos a seguir en la metodología. A continuación se requiere aplicar las pruebas de diagnóstico a los errores del modelo. La primera prueba a realizar es una prueba de normalidad. En este caso, el programa maneja la prueba Jarque-Bera. La hipótesis nula (Ho) es que existe normalidad en el modelo. Obviamente, la hipótesis alternativa indica lo contrario. Para aceptar la hipótesis nula, es necesario que la probabilidad sea mayor a 0.05 (5%) . Para aplicar la prueba en el programa, seleccionamos en la ventana del modelo la opción: View / Residual Test / Normality Test... 10 Se desplegará una ventana de diálogo que pedirá cual método de ortogonalización se desea aplicar la prueba. Para nuestros propósitos seleccionaremos la opción de Cholesky propuesta por Lütkepol. VAR Residual Normality Tests Orthogonalization: Cholesky (Lutkepohl) H0: residuals are multivariate normal Date: 10/16/07 Time: 11:08 Sample: 1980:1 2005:4 Included observations: 99 Component Skewness Chi-sq df Prob. 1 2 3 -0.455317 0.127828 -0.596916 3.420674 0.269609 5.879098 1 1 1 0.0644 0.6036 0.0153 9.569381 3 0.0226 Joint Component Kurtosis Chi-sq df Prob. 1 2 3 3.902869 2.392141 4.276467 3.362584 1.524156 6.721139 1 1 1 0.0667 0.2170 0.0095 11.60788 3 0.0089 Joint Component Jarque-Bera df Prob. 1 2 3 6.783259 1.793765 12.60024 2 2 2 0.0337 0.4078 0.0018 Joint 21.17726 6 0.0017 En primera instancia, los primeros cuadros que reporta la prueba son las pruebas de Skewness (Simetría) y Kurtosis (Curtosis). La Jarque-Bera es una prueba que considera las otras dos, por tal motivo, la lectura de la prueba de normalidad se realiza en el último cuadro reportado. Los resultados remarcados en amarillo indica la probabilidad del estadístico de la prueba por ecuación. En la columna Component se hallan las ecuaciones del modelo. Para este ejemplo: 1 representa 11 la ecuación de lcp, 2 la ecuación de ly y 3 la de li. Joint es el resultado de la prueba en su conjunto, la cual está marcada en color verde. Como se puede observar en el cuadro anterior, el modelo en la prueba conjunta tiene problemas, ya que la probabilidad es menor a 0.05. Para poder solucionar el problema, es necesario revisar las pruebas individuales ecuación por ecuación. En este modelo, encontramos que tenemos problemas en las ecuaciones 1 y 3 (cp e i respectivamente). El orden de 1 a 3 representa el orden con el que se introdujeron las variables. Antes de solucionar el problema de normalidad hay que realizar las otras pruebas. La siguiente prueba a realizar será para detectar problemas de Autocorrelación. Las pruebas que maneja el paquete E-views para la autocorrelación son la Portmanteu y la prueba LM. Sin embargo, la prueba Portmanteu sólo sirve para un número de rezagos extenso, por tal motivo, no la registraremos para este trabajo. La prueba a utilizar será la prueba LM (Lagrange Multiplier) para autocorrelación. Para realizarla en el programa hay que seleccionar View / Residual Test / Autocorrelation LM Test... de la ventana del modelo, se abre una ventana de diálogo que pide el número de rezagos a incluir, el cuál será el número de rezagos utilizados en el modelo (en este ejemplo 5). VAR Residual Serial Correlation LM Tests H0: no serial correlation at lag order h Date: 10/16/07 Time: 11:25 Sample: 1980:1 2005:4 Included observations: 99 Lags LM-Stat Prob 1 2 8.853678 4.443033 0.4509 0.8799 12 3 4 5 14.28193 20.65970 8.991014 0.1126 0.0143 0.4381 Probs from chi-square with 9 df. Para analizar el resultado de esta prueba habrá que leer la probabilidad del estadístico LM de los cinco rezagos. Importante: Recuerde que la hipótesis nula (Ho) es No Autocorrelación y H1 es Existe Autocorrelación, por tanto, la probabilidad para aceptar Ho deberá ser mayor a 0.05 ó a 0.01. En este caso la probabilidad es 0.4381, lo cual indica que no tenemos problemas de autocorrelación. A continuación, se aplicará una prueba para heteroscedasticidad: La prueba de White para términos no cruzados. Para realizar la prueba en el programa hay que seleccionar View / Residual Test / White Heteroskedasticity en la ventana del modelo. VAR Residual Heteroskedasticity Tests: No Cross Terms (only levels and squares) Date: 10/16/07 Time: 11:29 Sample: 1980:1 2005:4 Included observations: 99 Joint test: Chi-sq df Prob. 220.0670 180 0.0224 Individual components: Dependent R-squared F(30,68) Prob. Chi-sq(30) Prob. res1*res1 res2*res2 res3*res3 res2*res1 res3*res1 res3*res2 0.336340 0.535706 0.247175 0.362340 0.253473 0.334039 1.148736 2.615293 0.744216 1.287995 0.769615 1.136934 0.3124 0.0005 0.8129 0.1936 0.7838 0.3245 33.29765 53.03485 24.47036 35.87163 25.09382 33.06981 0.3098 0.0059 0.7503 0.2123 0.7205 0.3195 13 Para este caso sólo se observa la probabilidad de la prueba conjunta (la cual está marcada con color verde en este ejemplo). Ho en esta prueba indica que la varianza de los errores es homoscedástica y H1 indica que la varianza es heteroscedástica. Por tanto, para aceptar Ho se requiere que la probabilidad sea mayor a 0.05 y en este caso no es así. Esto implica que tenemos problemas de heteroscedasticidad en el modelo. Encontramos, en síntesis, que el modelo presenta problemas de normalidad y de heteroscedasticidad. El problema de normalidad se podría arreglar con variables dummy, y el problema de heteroscedasticidad es posible corregirla mediante dos remedios utilizados frecuentemente: “Uno de ellos es la transformación logarítmica de las variables y el otro en deflactar todas las variables por alguna medida de <<tamaño>>”. Importante: - En dado caso que existan problemas de autocorrelación, la solución sería introduciendo rezagos al modelo. - Cuando agregamos variables dummy al modelo probablemente se corrija la normalidad de alguna de las ecuaciones. 4. CORRECCIÓN DE LA VIOLACIÓN DE LOS SUPUESTOS DEL MODELO Primero, se intentará corregir la normalidad. Para ello deberá acudir al cuadro en donde se reporta la prueba, recordemos que los problemas se encuentran en las ecuaciones de lcp y li. 14 Para ello requeriremos ver el comportamiento de los errores en el tiempo de dicha ecuación y será a través de los gráficos de los errores al seleccionar la opción Resids ó View / Residuals / Graph de la ventana del modelo. LY Residuals LCP Residuals .06 .06 .04 .04 .02 .02 .00 .00 -.02 -.02 -.04 -.04 -.06 -.08 1980 1985 1990 1995 2000 -.06 1980 2005 1985 1990 1995 2000 2005 LI Residuals .1 .0 -.1 -.2 -.3 1980 1985 1990 1995 2000 2005 Para generar los errores y tenerlos como series en nuestro workfile, se necesita seleccionar Procs / Make Residuals desde la ventana de nuestro VAR. Estos se abrirán en una ventana de grupo, la cual podemos cerrar porque se generaron como objetos series en el workfile. El nombre que recibirán los errores por default serán resid01, resid02 y resid03 los cuales representan los errores de las ecuaciones LCP, LY e LI, respectivamente. El orden depende de la manera en que hayamos colocado las variables en el VAR. 15 Importante: Para graficar los errores de manera independiente y copiarlos a WORD hay que seguir una serie de pasos: 1) Abrir el objeto serie del error o residual que deseamos graficar. 2) Seleccionar View / Graph / Line. 3) Una vez que el gráfico se encuentra en la ventana seleccionar Object / View Options / Save Metafile to disk... lo cual desplegará una nueva ventana de diálogo que pedirá una ubicación donde guardar el gráfico y con qué formato desea guardarlo. Habrá que dejar el formato que aparece por default y deshabilitar la opción Use color con el fin de guardar el gráfico en blanco y negro, lo cual nos dará un mejor manejo y mayor facilidad. Haga clic en el botón Aceptar para completar el proceso. Continuando con el análisis de los gráficos observe que en el primer gráfico, que corresponde a los errores de la ecuación LCP, podemos observar un pulso en el año 1995, pero como no sabemos exactamente en que trimestre se da este pulso 16 tenemos que acudir a la serie resid01 de nuestro workfile y encontrar en que trimestre del año 1995 se da esta situación. .06 .04 .02 .00 -.02 -.04 -.06 -.08 1980 1985 1990 1995 2000 2005 RESID01 Para regresar a la serie después del gráfico, hay que seleccionar la opción SpreadSheet del menú de nuestra serie. 1994q1 1994q2 1994q3 1994q4 1995q1 1995q2 1995q3 1995q4 0.023154 0.007128 -0.001449 0.014032 -0.076837 -0.048499 0.008811 0.000942 En esta serie observamos que el impulso se extiende en dos periodos, por tanto, lo recomendable es generar una variable dummy con dos números 1. En el periodo 1995Q1 y 1995Q2. Para crear una variable dummy en Eviews deberá escribir en la ventana de comando lo siguiente: genr d95=0, 17 Este proceso generará una serie de ceros en todos los periodos. Para poder agregar los números 1, tenemos que abrir la serie y seleccionar edit. Después buscaremos las fechas donde identificamos el impulso para sobrescribir sobre los número 0 los números 1. Por último, volvemos a seleccionar edit y cerramos la serie. Ahora nuestra variable dummy está fabricada. 1994Q2 1994Q3 1994Q4 1995Q1 1995Q2 1995Q3 1995Q4 1996Q1 1996Q2 0.000000 0.000000 0.000000 1.000000 1.000000 0.000000 0.000000 0.000000 0.000000 Para revisar los efectos de esta dummy en nuestro modelo, seleccionar Estimate de la ventana de nuestro modelo VAR, y en la ventana que despliega donde ya habíamos trabajado anteriormente, agregamos la variable dummy en el campo Exogenous Variable a lado de la constante (atención: NO HAY QUE BORRAR LA CONSTANTE PARA INTRODUCIR LA VARIABLE DUMMY). Haga clic en el botón Aceptar y se realizará un nuevo modelo VAR con la variable D95 incluida en el sistema. Nota: No es necesario reportar la salida del VAR como ya lo he mencionado con anterioridad. 18 Para verificar si hubo alguna corrección en la normalidad de la ecuación LCP necesitamos aplicar la prueba de normalidad una vez más: Component Jarque-Bera df Prob. 1 2 3 2.016872 2.377500 2.516743 2 2 2 0.3648 0.3046 0.2841 Joint 6.911115 6 0.3291 Observe que la normalidad de dicha ecuación mejoró. Ahora pasa la prueba, ya que la probabilidad es mayor a 0.05. En caso de que la probabilidad de la normalidad de las otras ecuaciones fuera menor a 0.05 se debería generar otra dummy que sirva a nuestros fines. Sin embargo para nuestro caso no es necesario. Comparemos los gráficos anteriores, con los gráficos siguientes que incluye la dummy donde observamos que modificó el año 1995. 19 LY Residuals LCP Residuals .04 .06 .03 .04 .02 .02 .01 .00 .00 -.01 -.02 -.02 -.04 -.06 1980 -.03 1985 1990 1995 2000 -.04 1980 2005 1985 1990 1995 2000 2005 LI Residuals .15 .10 .05 .00 -.05 -.10 -.15 -.20 1980 1985 1990 1995 2000 2005 Para efectos de completar las pruebas de diagnóstico, tenemos que realizar las pruebas restantes: Autocorrelación: VAR Residual Serial Correlation LM Tests H0: no serial correlation at lag order h Date: 10/31/07 Time: 13:37 Sample: 1980:1 2005:4 Included observations: 99 Lags LM-Stat Prob 1 2 3 4 5 11.68952 6.725507 9.744785 24.90975 11.44807 0.2314 0.6657 0.3715 0.0031 0.2462 Probs from chi-square with 9 df. Heteroscedasticidad: 20 VAR Residual Heteroskedasticity Tests: No Cross Terms (only levels and squares) Date: 10/31/07 Time: 13:39 Sample: 1980:1 2005:4 Included observations: 99 Joint test: Chi-sq df Prob. 234.9897 186 0.0087 La prueba de autocorrelación nos muestra la aceptación de la hipótesis nula, puesto que es mayor a 0.05, mientras que la de heteroscedasticidad es menor a 0.05, tenemos ahora un VAR que no pasa todas las pruebas de diagnóstico. Sin embargo, lo mejor es buscar otro modelo que pase las pruebas para tener más opciones. Nota: Es necesario hacer hincapié en que las variables dummy que agreguemos a nuestro modelo tienen que estar justificadas históricamente. Es decir, se necesita expresar las posibles causas que provocaron que la serie rompiera su ritmo de desarrollo en el tiempo. Por ejemplo, la variable dummy del 95 puede ser justificada por la crisis del 95 en México la cual provocó cambios en el movimiento de la mayoría de las variables macroeconómicas. Ahora especificaré el modelo con 7 rezagos para ver los efectos en mis pruebas. Normalidad Component Jarque-Bera df Prob. 1 2 3 1.999258 5.696329 0.751458 2 2 2 0.3680 0.0580 0.6868 Joint 8.447045 6 0.2071 Autocorrelación Lags LM-Stat Prob 21 1 2 3 4 5 6 7 12.31837 8.822315 13.34724 20.91348 9.708506 15.19974 5.474040 0.1960 0.4538 0.1475 0.0130 0.3746 0.0856 0.7912 Probs from chi-square with 9 df. Heteroscedasticidad Joint test: Chi-sq df Prob. 292.2160 258 0.0703 Este modelo reporta resultados más contundentes en las pruebas de diagnóstico. Nota: Este proceso se tiene que seguir con menos o más rezagos, para ver el comportamiento de los errores a través de las pruebas de diagnóstico, hasta tener más opciones y poder elegir el mejor de ellos. Hasta esta fase del desarrollo de nuestra metodología: Modelo Corrector de Errores, no podemos definir si es un buen modelo o no, ya que falta cumplir con otras condiciones antes de definir al “mejor de todos”. Mientras tanto, nos quedaremos con este modelo, esperando que cumpla con el resto de las condiciones. Si no es así, tendré que regresar a esta fase combinando otras dummy y reespecificando la cantidad de rezagos. 1. ¿LAS VARIABLES COINTEGRAN? Para el caso de cointegración, nuestras variables deben de ser de orden de integración 1 ó 2, es decir: I (d). Siguiendo la metodología de Engel y Granger (1987). Como podemos observar, en el cuadro las pruebas de raíces unitarias 22 sintetizado. En este caso, se realizó la prueba Dickey-Fuller para las tres variables. Cuadro 9. Dickey- Fuller en primeras diferencias: Variable Modelo Constante CyT None Constante CyT None Constante CyT Lcp Ly li None t-Statistic -3.706008 -4.058553 -2.709354 -5.465487 -5.672239 -2.347063 -9.093608 -9.168447 -9.067781 5% Prob -2.892536 0.0055 -3.458326 0.0100 -1.944286 0.0072 -2.891550 0.0000 -3.456805 0.0000 -1.944248 0.0190 -2.890037 0.0000 -3.454471 0.0000 -1.944006 0.0000 Podemos inferir, a partir de los resultados no pasa las pruebas en ninguno de los modelos en niveles. Sin embargo, pasa únicamente las pruebas en todos los modelos en primeras diferencias, por lo tanto LCP es I(1) (orden de integración 1). Además tenemos que comparar el resultado obtenido respecto al resultado obtenido por otra prueba (Phillips- Perron). Importante: 4) Se usará una tercera prueba (KPSS) para que el resultado obtenido permita la toma de una decisión de mayor contundencia. 5) Para la prueba KPSS, la Ho es que no existe raíz unitaria (la serie es estacionaria), por tanto, H1 es que existe raíz unitaria. Esto implica que el t-Statistic tiene que ser menor en términos absolutos que el valor crítico al 5% (o al 10% en su defecto).( Entiendo que esta explicación se aplica en la prueba KPSS? Ó está hablando de los resultados del cuadro anterior? 6) La prueba KPSS, en este programa, no reporta la probabilidad. 23 2. PRUEBAS DE COINTEGRACIÓN Para habilitar la prueba de cointegración de Johansen, se requiere seleccionar en nuestra ventana del modelo View / Cointegration Test. Esto desplegará otra ventana de diálogo, la cuál me presenta 6 opciones: Las opciones que presenta son: Ecuación de Cointegración (CE) Vector Autorregresivo (VAR) Asume no tendencia determinística en los datos No Intercepto o tendencia CE No intercepto o tendencia Intercepto (no tendencia) en CE No intercepto en el VAR Permite tendencia determinística lineal en los datos Intercepto no tendencia CE Intercepto no tendencia Intercepto y tendencia en CE No tendencia en el VAR Permite tendencia determinística cuadrática en los datos Intercepto y tendencia en CE Tendencia lineal en el VAR Resumen Resumen de los 5 conjuntos de supuestos 24 Se aplicará en primer lugar la 6ª opción para tener una mayor certeza de cuál de las otras opciones será la más adecuada. Para poder aplicar todas las opciones, deberá especificar el número de rezagos del modelo (1 7) y deberá eliminar en la ventanilla de las variables exógenas la variable dummy (d95). Arrojará el siguiente resultado: Date: 10/31/07 Time: 14:07 Sample: 1980:1 2005:4 Included observations: 96 Series: LCP LY LI Lags interval: 1 to 7 Data Trend: Rank or No. of CEs None None No Intercept Intercept No Trend No Trend Linear Linear Quadratic Intercept No Trend Intercept Trend Intercept Trend Selected (5% level) Number of Cointegrating Relations by Model (columns) Trace Max-Eig 0 0 1 1 1 1 1 1 1 1 729.9371 737.4210 741.0211 741.9977 729.9371 743.5461 750.3993 751.7454 736.3287 749.8739 751.5546 751.7454 736.3287 751.1132 758.9394 760.4301 737.8342 752.2600 758.9807 760.4301 -13.89452 -13.92544 -13.87544 -13.77079 -13.89452 -14.03221 -14.02915 -13.91136 -13.96518 -14.12237 -14.03239 -13.91136 -13.96518 -14.12736 -14.14457* -14.02979 -13.93405 -14.10958 -14.12460 -14.02979 0 -12.21167* -12.20219 -12.20219 -12.09092 1 2 3 -12.08231 -11.87204 -11.60712 12.21167* -12.16237 -11.97233 -11.66756 -12.19911 -11.94885 -11.66756 -12.17738 -12.00761 -11.70585 -12.10619 -11.96093 -11.70585 Log Likelihood by Rank (rows) and Model (columns) 0 1 2 3 Akaike Information Criteria by Rank (rows) and Model (columns) 0 1 2 3 Schwarz Criteria by Rank (rows) and Model (columns) 25 Esta opción me permite observar, de manera general si alguna de las opciones anteriores presenta vectores de cointegración al 5%. En esta tabla se puede ver claramente que si existen vectores de cointegración en alguna de las opciones. Para facilitar la búsqueda del modelo, se recomienda realizar la prueba de cointegración con varios rezagos, comenzando con un rezago y utilizando la 6ª opción. 1 rezago Data Trend: None Rank or No Intercept No. of CEs No Trend None Linear Linear Quadratic Intercept No Trend Intercept No Trend Intercept Trend Intercept Trend Selected (5% level) Number of Cointegrating Relations by Model (columns) Trace Max-Eig 3 3 2 2 2 2 2 2 3 3 2 rezagos Data Trend: None None Linear Linear Quadratic Intercept No Trend Intercept No Trend Intercept Trend Intercept Trend Rank or No Intercept No. of CEs No Trend Selected (5% level) Number of Cointegrating Relations by Model (columns) Trace Max-Eig 1 1 1 1 0 0 0 0 0 0 3 rezagos Data Trend: None None Linear Linear Quadratic Intercept No Trend Intercept No Trend Intercept Trend Intercept Trend Rank or No Intercept No. of CEs No Trend Selected (5% level) Number of Cointegrating Relations by Model (columns) Trace Max-Eig 1 1 1 1 1 1 1 1 1 1 4 rezagos Data Trend: None None Linear Linear Quadratic Intercept No Trend Intercept No Trend Intercept Trend Intercept Trend Rank or No Intercept No. of CEs No Trend Selected (5% level) Number of Cointegrating Relations by Model (columns) Trace Max-Eig 1 1 1 1 1 1 1 1 1 1 26 5 rezagos Data Trend: None Rank or No Intercept No. of CEs No Trend None Linear Linear Quadratic Intercept No Trend Intercept No Trend Intercept Trend Intercept Trend Selected (5% level) Number of Cointegrating Relations by Model (columns) Trace Max-Eig 1 0 1 1 0 1 1 1 1 1 6 rezagos Data Trend: None None Linear Linear Quadratic Intercept No Trend Intercept No Trend Intercept Trend Intercept Trend Rank or No Intercept No. of CEs No Trend Selected (5% level) Number of Cointegrating Relations by Model (columns) Trace Max-Eig 1 0 1 0 0 0 0 1 1 1 7 rezagos Data Trend: None None Linear Linear Quadratic Intercept No Trend Intercept No Trend Intercept Trend Intercept Trend Rank or No Intercept No. of CEs No Trend Selected (5% level) Number of Cointegrating Relations by Model (columns) Trace Max-Eig 0 0 1 1 1 1 1 1 1 1 Concluimos a través de las tablas presentadas el modelo presenta cointegración según las pruebas. Para el modelo con 7 rezagos tenemos que pasa las pruebas de normalidad, autocorrelación y heteroscedasticidad sin problemas (al 5%). Por tanto, es un modelo que, de antemano, sabemos que pasa la prueba de cointegración: 2ª OPCIÓN Date: 10/17/07 Time: 12:14 Sample(adjusted): 1982:1 2005:4 Included observations: 96 after adjusting endpoints Trend assumption: No deterministic trend (restricted constant) Series: LCP LY LI Lags interval (in first differences): 1 to 7 Unrestricted Cointegration Rank Test 27 Hypothesized No. of CE(s) Eigenvalue Trace Statistic 5 Percent Critical Value 1 Percent Critical Value None ** At most 1 At most 2 0.246874 0.133050 0.027654 43.61664 16.39852 2.692230 34.91 19.96 9.24 41.07 24.60 12.97 *(**) denotes rejection of the hypothesis at the 5%(1%) level Trace test indicates 1 cointegrating equation(s) at both 5% and 1% levels Hypothesized No. of CE(s) Eigenvalue Max-Eigen Statistic 5 Percent Critical Value 1 Percent Critical Value None ** At most 1 At most 2 0.246874 0.133050 0.027654 27.21812 13.70629 2.692230 22.00 15.67 9.24 26.81 20.20 12.97 *(**) denotes rejection of the hypothesis at the 5%(1%) level Max-eigenvalue test indicates 1 cointegrating equation(s) at both 5% and 1% levels Unrestricted Cointegrating Coefficients (normalized by b'*S11*b=i): LCP -5.063460 -9.019501 48.59542 LY -16.33484 11.23929 -46.42103 LI 15.50699 -0.362138 -3.839081 C 149.9910 -40.76894 45.72390 Unrestricted Adjustment Coefficients (alpha): D(LCP) D(LY) D(LI) -0.001378 -0.000465 -0.018747 1 Cointegrating Equation(s): 0.004576 0.005686 0.012005 -0.002258 -9.62E-05 -0.001492 Log likelihood 743.5461 Normalized cointegrating coefficients (std.err. in parentheses) LCP LY LI C 1.000000 3.226024 -3.062529 -29.62224 (0.85627) (0.61531) (7.36743) Adjustment coefficients (std.err. in parentheses) D(LCP) 0.006979 (0.01097) D(LY) 0.002356 (0.00919) D(LI) 0.094923 (0.02783) 28 2 Cointegrating Equation(s): Log likelihood 750.3993 Normalized cointegrating coefficients (std.err. in parentheses) LCP LY LI C 1.000000 0.000000 -0.824376 -4.993289 (0.11083) (2.11520) 0.000000 1.000000 -0.693780 -7.634461 (0.04900) (0.93524) Adjustment coefficients (std.err. in parentheses) D(LCP) -0.034293 0.073946 (0.02173) (0.04166) D(LY) -0.048929 0.071505 (0.01749) (0.03353) D(LI) -0.013352 0.441146 (0.05499) (0.10542) Podemos observar a través del cuadro que existe un vector de cointegración al 5%. Sin embargo, aún falta comprobar que los signos de dicho vector son los que esperamos según la teoría. En el mismo reporte, debajo de la información obtenida, tenemos a los coeficientes normalizados de cointegración, los cuáles nos darán los valores del vector de cointegración, que es información de largo plazo: LCP 1.000000 LY 3.226024 LI -3.062529 C -29.62224 Tenemos que esto está realmente expresado de la siguiente manera: LCP + 3.226024 * LY – 3.062529 * LI - 29.62224 = 0 Lo cual, después de despejar, obtenemos los verdaderos signos: LCP = - 3.226024 * LY + 3.062529 * LI + 29.62224 29 Los signos del vector son los esperados según la teoría. El ingreso y la inflación tienen un impacto positivo sobre el consumo. Sin embargo, la variable que tiene una mayor influencia sobre el consumo es el ingreso Encontramos que entre las variables existe una relación de largo plazo esperada. Es decir, el comportamiento de las variables es similar a lo largo del tiempo. 7. APLICACIÓN DEL MODELO CORRECTOR DE ERRORES (MCE). A continuación, representaremos el modelo corrector de errores. Para ello se requiere que las variables sean estacionarias. Como las variables utilizadas son de orden de integración 1, para que sean estacionarias, es necesario aplicarles primeras diferencias. Para aplicarles las primeras diferencias a las variables, tenemos que aplicar la siguiente orden en la ventana de comandos: Genr dlcp = d(lcp) Genr dly = d(ly) Genr dli = d(li) Estas nuevas variables aparecerán en el workfile. 30 Con estas variables generaremos un nuevo modelo lineal simple, el número de rezagos para este modelo no depende del modelo VAR hecho con anterioridad. Es decir, este es un modelo independiente. Para este modelo podríamos utilizar nuevos componentes (variables dummy, tendencia, componentes estacionales, etc.). Por tanto, este modelo lo especificaré con cinco rezagos. Para el mecanismo corrector de errores (MCE) es necesario introducir el vector de cointegración obtenido con un rezago. Para poder introducir el vector en el modelo es necesario crear una variable que llamaré V, la cual contendrá al vector. La variable se genera de la siguiente manera. En la barra de comandos escribiremos: Genr v = lcp + 3.226024 * ly – 3.062529 * li – 29.62224 Una vez generado el vector, lo introducimos en el modelo especificado. Quedaría de la siguiente manera: ls dlcp dlcp(-1) dlcp(-2) dlcp(-3) dlcp(-4) dlcp(-5) dly dly(-1) dly(-2) dly(-3) dly(-4) dly(-5) dli dli(-1) dli(-2) dli(-3) dli(-4) dli(-5) v(-1) Dependent Variable: DLCP Method: Least Squares Date: 10/17/07 Time: 12:38 Sample(adjusted): 1981:3 2005:4 Included observations: 98 after adjusting endpoints Variable Coefficient Std. Error t-Statistic Prob. DLCP(-1) DLCP(-2) DLCP(-3) DLCP(-4) DLCP(-5) DLY DLY(-1) DLY(-2) DLY(-3) DLY(-4) DLY(-5) -0.418351 -0.327113 -0.307174 0.403014 0.177017 0.531774 0.266008 0.472324 0.142382 -0.402696 -0.074312 0.107256 0.102699 0.105298 0.101552 0.102004 0.129887 0.155281 0.146207 0.156472 0.155769 0.148545 -3.900497 -3.185166 -2.917189 3.968563 1.735388 4.094142 1.713073 3.230511 0.909949 -2.585210 -0.500270 0.0002 0.0021 0.0046 0.0002 0.0865 0.0001 0.0906 0.0018 0.3656 0.0115 0.6183 31 DLI DLI(-1) DLI(-2) DLI(-3) DLI(-4) DLI(-5) V(-1) 0.143116 0.084400 -0.009241 -0.013337 0.028842 0.002144 -0.009420 R-squared Adjusted R-squared S.E. of regression Sum squared resid Log likelihood 0.928096 0.912816 0.013909 0.015477 289.8591 0.039622 0.042479 0.038783 0.040119 0.039707 0.040868 0.006380 3.612009 1.986850 -0.238287 -0.332425 0.726360 0.052456 -1.476545 Mean dependent var S.D. dependent var Akaike info criterion Schwarz criterion Durbin-Watson stat 0.0005 0.0504 0.8123 0.7404 0.4697 0.9583 0.1437 0.006631 0.047106 -5.548145 -5.073355 2.028913 8. MODELO GENERAL A LO ESPECÍFICO Lo que esperamos de este modelo es que el mecanismo corrector de errores, implica que nuestra variable v (la que incluye el vector) sea significativa (su probabilidad sea menor a 0.05) y el valor de su coeficiente sea negativo y menor que la unidad. El proceso es ir eliminando de la variable menos significativa a la más significativa hasta que se cumpla lo anterior, excepto el vector (v(-1)). También el modelo debe de aprobar las pruebas de diagnóstico (normalidad, autocorrelación y heteroscedasticidad). Para este caso la variable menos significativa es la que se encuentra en color verde agua (ecuación anterior). La variable, entonces, a eliminar sería el quinto rezago de dly. Entonces el modelo quedaría ahora: Ls dlcp dlcp(-1) dlcp(-2) dlcp(-3) dlcp(-4) dlcp(-5) dly dly(-1) dly(-2) dly(-3) dly(-4) dp dp(-1) dp(-2) dp(-3) dp(-4) dp(-5) vc(-1) Dependent Variable: DLCP Method: Least Squares Date: 10/18/07 Time: 08:39 Sample(adjusted): 1981:3 2005:4 Included observations: 98 after adjusting endpoints Variable Coefficient Std. Error t-Statistic Prob. 32 DLCP(-1) DLCP(-2) DLCP(-3) DLCP(-4) DLCP(-5) DLY DLY(-1) DLY(-2) DLY(-3) DLY(-4) DLI DLI(-1) DLI(-2) DLI(-3) DLI(-4) DLI(-5) V(-1) R-squared Adjusted R-squared S.E. of regression Sum squared resid Log likelihood -0.404979 -0.335696 -0.325606 0.398512 0.151918 0.522643 0.229759 0.493993 0.170196 -0.369915 0.143108 0.089451 -0.009597 -0.016571 0.027037 -0.009272 -0.008503 0.927871 0.913623 0.013845 0.015525 289.7061 0.103390 0.100786 0.098184 0.100683 0.088401 0.128001 0.136702 0.138996 0.145583 0.140661 0.039438 0.041071 0.038596 0.039412 0.039360 0.033746 0.006083 -3.917008 -3.330785 -3.316295 3.958091 1.718506 4.083110 1.680732 3.554011 1.169069 -2.629839 3.628650 2.177944 -0.248647 -0.420453 0.686931 -0.274775 -1.397978 Mean dependent var S.D. dependent var Akaike info criterion Schwarz criterion Durbin-Watson stat 0.0002 0.0013 0.0014 0.0002 0.0895 0.0001 0.0967 0.0006 0.2458 0.0102 0.0005 0.0323 0.8043 0.6753 0.4941 0.7842 0.1659 0.006631 0.047106 -5.565430 -5.117017 2.046872 Como podemos observar, la variable v(-1) sigue siendo no significativa y su coeficiente mayor a cero. Por lo tanto, se tienen que eliminar las variables que no sean significativas en el sistema. Continuamos este proceso hasta que todas las variables sean significativas (o por lo menos la mayoría) asimismo el coeficiente v(-1) sea mayor a -1 y menor a 0. Dependent Variable: DLCP Method: Least Squares Date: 10/18/07 Time: 09:12 Sample(adjusted): 1981:2 2005:4 Included observations: 99 after adjusting endpoints Variable Coefficient Std. Error t-Statistic Prob. DLCP(-1) DLCP(-2) DLCP(-3) DLCP(-4) DLY DLY(-2) DLY(-4) DLI DLI(-1) V(-1) -0.181062 -0.296968 -0.218691 0.440933 0.384175 0.315330 -0.356188 0.172673 0.081590 -0.012431 0.061532 0.075378 0.056934 0.080926 0.104040 0.075570 0.105520 0.035133 0.030928 0.004356 -2.942559 -3.939736 -3.841135 5.448565 3.692555 4.172689 -3.375536 4.914856 2.638041 -2.854026 0.0041 0.0002 0.0002 0.0000 0.0004 0.0001 0.0011 0.0000 0.0098 0.0054 R-squared Adjusted R-squared S.E. of regression Sum squared resid 0.918591 0.910358 0.014097 0.017687 Mean dependent var S.D. dependent var Akaike info criterion Schwarz criterion 0.007087 0.047084 -5.590163 -5.328030 33 Log likelihood 286.7131 Durbin-Watson stat 2.379287 La continuación del proceso condujo a este último modelo, el cuál presenta únicamente que la variable v(-1) es significativa al 5%, puesto que es menor a 0.05 (es más, se aproxima demasiado a ser menor a 0.05), asimismo las demás variables son significativas. Este cuadro si se tendrá que reportar, ya que expresa que existe cointegración en nuestras variables. A continuación aplicaremos las pruebas de diagnóstico al modelo: Normalidad: 12 Series: Residuals Sample 1981:2 2005:4 Observations 99 10 Mean Median Maximum Minimum Std. Dev. Skewness Kurtosis 8 6 4 2 Jarque-Bera Probability 0 -0.025 0.000 0.000777 -0.000276 0.032655 -0.037202 0.013411 0.135535 2.901165 0.343394 0.842234 0.025 Autocorrelación: Breusch-Godfrey Serial Correlation LM Test: F-statistic 3.329461 Probability 0.040430 Obs*R-squared 6.726898 Probability 0.034616 Heteroscedasticidad: White Heteroskedasticity Test: F-statistic 0.902921 Probability 0.584415 Obs*R-squared 18.61143 Probability 0.547197 Como podemos observar en las pruebas, la prueba de normalidad pasa sin problemas al 5%, la prueba de heteroscedasticidad también pasa sin problemas. 34 En el caso de la prueba de autocorrelación, la prueba pasa también aunque no tan holgadamente como en los otros dos casos. Para esta prueba la probabilidad es mayor a 0.01 y es aceptable el resultado. Podemos concluir que lo que tenemos aquí es un buen modelo que va acorde a la teoría y entrega buenos resultados. Por ultimo, quiero hacer una síntesis de lo que tiene que estar reportado en el trabajo dentro del contexto técnico: 1. Las variables a utilizar en el modelo, su periodicidad, su interpretación y su gráfico correspondiente, así como un pequeño análisis del comportamiento dinámico de la variable. También debemos incluir las variable dummy creadas. 2. Las pruebas de raíces unitarias: Dickey-Fuller aumentada y Phillips-Perron (en dado caso de una contradicción entre las pruebas se utilizará la prueba KPSS). Los resultados obtenidos a través de las pruebas se reportará en un cuadro que sintetice la información (como ya lo he indicado anteriormente) para cada prueba y cada una de las variables: Dfuller Variable lcp ly li Modelo Constante CyT None Constante CyT None Constante CyT t-Statistic 5% Prob 35 None 3. Los criterios para el número de rezagos óptimo: VAR Lag Order Selection Criteria Endogenous variables: LCP LY LI Exogenous variables: C Date: 10/16/07 Time: 10:52 Sample: 1980:1 2005:4 Included observations: 96 Lag LogL LR FPE AIC SC HQ 0 1 2 3 4 5 6 7 8 300.3780 521.4061 615.7767 660.6556 722.9871 734.7455 739.0205 741.3733 751.7454 NA 423.6373 174.9787 80.40820 107.7815 19.59724* 6.857772 3.627264 15.34208 4.09E-07 4.94E-09 8.35E-10 3.96E-10 1.31E-10 1.24E-10* 1.38E-10 1.59E-10 1.57E-10 -6.195374 -10.61263 -12.39118 -13.13866 -14.24973 -14.30720* -14.20876 -14.07028 -14.09886 -6.115239 -10.29208 -11.83023 -12.33730 -13.20797* -13.02502 -12.68618 -12.30729 -12.09547 -6.162982 -10.48306 -12.16443 -12.81474 -13.82863* -13.78892 -13.59331 -13.35765 -13.28906 * indicates lag order selected by the criterion LR: sequential modified LR test statistic (each test at 5% level) FPE: Final prediction error AIC: Akaike information criterion SC: Schwarz information criterion HQ: Hannan-Quinn information criterion VAR Lag Order Selection Criteria Endogenous variables: LCP LY P Exogenous variables: C Sample: 1980Q1 2005Q4 Included observations: 96 Lag LogL LR FPE AIC SC HQ 0 1 2 3 4 5 6 7 8 21.21740 225.1515 288.7351 338.2330 383.5469 399.2383 407.1158 413.9813 423.3963 NA 390.8738 117.8944 88.68388 78.35516 26.15235* 12.63694 10.58426 13.92642 0.000137 2.37e-06 7.59e-07 3.27e-07 1.54e-07 1.35e-07* 1.39e-07 1.46e-07 1.47e-07 -0.379529 -4.440657 -5.577814 -6.421521 -7.178059 -7.317464* -7.294080 -7.249610 -7.258257 -0.299393 -4.120113 -5.016862 -5.620163 -6.136293* -6.035290 -5.771498 -5.486621 -5.254860 -0.347137 -4.311088 -5.351068 -6.097599 -6.756960 -6.799188* -6.678628 -6.536981 -6.448451 4. El modelo VAR final, es decir, el modelo con el cual nos quedamos al final. En este punto colocaremos también los gráficos de los errores que justifican 36 la introducción de las variables dummy utilizadas en el modelo, así como la justificación teórica-histórica. 5. Las pruebas de diagnóstico o de los residuales en un cuadro resumen para el modelo VAR final. 6. La prueba de cointegración de Johansen. Se presentara la séptima opción que elegimos. Data Trend: None Rank or No Intercept No. of CEs No Trend None Linear Linear Quadratic Intercept No Trend Intercept No Trend Intercept Trend Intercept Trend Selected (5% level) Number of Cointegrating Relations by Model (columns) Trace Max-Eig 0 0 1 1 1 1 1 1 1 1 Date: 10/17/07 Time: 12:14 Sample(adjusted): 1982:1 2005:4 Included observations: 96 after adjusting endpoints Trend assumption: No deterministic trend (restricted constant) Series: LCP LY LI Lags interval (in first differences): 1 to 7 Unrestricted Cointegration Rank Test Hypothesized No. of CE(s) Eigenvalue None ** At most 1 At most 2 0.246874 0.133050 0.027654 Trace Statistic 43.61664 16.39852 2.692230 5 Percent 1 Percent Critical Value Critical Value 34.91 19.96 9.24 41.07 24.60 12.97 *(**) denotes rejection of the hypothesis at the 5%(1%) level Trace test indicates 1 cointegrating equation(s) at both 5% and 1% levels Hypothesized No. of CE(s) Eigenvalue Max-Eigen Statistic 5 Percent 1 Percent Critical Value Critical Value None ** 0.246874 27.21812 22.00 26.81 At most 1 0.133050 13.70629 15.67 20.20 At most 2 0.027654 2.692230 9.24 12.97 *(**) denotes rejection of the hypothesis at the 5%(1%) level 37 Max-eigenvalue test indicates 1 cointegrating equation(s) at both 5% and 1% levels 7. El vector normalizado que arroja la prueba de cointegración LCP LY LI C 1.000000 3.226024 -3.062529 -29.62224 (0.85627) (0.61531) (7.36743) LCP = - 3.226024 * LY + 3.062529 * LI + 29.62224 9. El modelo corrector de errores final Dependent Variable: DLCP Method: Least Squares Date: 10/18/07 Time: 09:12 Sample(adjusted): 1981:2 2005:4 Included observations: 99 after adjusting endpoints Variable Coefficient Std. Error t-Statistic Prob. DLCP(-1) DLCP(-2) DLCP(-3) DLCP(-4) DLY DLY(-2) DLY(-4) DLI DLI(-1) V(-1) -0.181062 -0.296968 -0.218691 0.440933 0.384175 0.315330 -0.356188 0.172673 0.081590 -0.012431 0.061532 0.075378 0.056934 0.080926 0.104040 0.075570 0.105520 0.035133 0.030928 0.004356 -2.942559 -3.939736 -3.841135 5.448565 3.692555 4.172689 -3.375536 4.914856 2.638041 -2.854026 0.0041 0.0002 0.0002 0.0000 0.0004 0.0001 0.0011 0.0000 0.0098 0.0054 R-squared Adjusted R-squared S.E. of regression Sum squared resid Log likelihood 0.918591 0.910358 0.014097 0.017687 286.7131 Mean dependent var S.D. dependent var Akaike info criterion Schwarz criterion Durbin-Watson stat 0.007087 0.047084 -5.590163 -5.328030 2.379287 Las pruebas de diagnostico realizadas al modelo corrector PRUEBA SUPUESTO ESTADISTICO PROBABILIDAD JARQUE-BERA NORMALIDAD 0.343394 0.842234 LM TEST NO AUTOCORRELACIÓN 3.329461 0.040430 HOMOSCEDASTICIDAD 0.902921 0.584415 WHITE (NCT) 38 NOTA: Se deben incluir el sistema de ecuaciones del modelo VAR y el modelo corrector en su forma de ecuaciones. El reporte final puede estar incluido dentro del trabajo conforme el análisis va desarrollándose o en un apéndice al final del trabajo, sin embargo en la segunda opción el análisis deberá estar incluido en el desarrollo del trabajo y no al final junto con el apéndice, además deberán señalarse en el desarrollo del trabajo a manera de nota la referencia a cada cuadro o gráfico del apéndice. Bibliografía: • Maddala G.S., “Econometría”, Ed. McGraw Hill, ed.1985, pp.271 • Engel R.F y Granger , CWJ “Co-integration and error correction: representation, estimation and testing” , Ed. ed. 1987, pp. 251-276 39