Diagonalización

Anuncio

Tema 5

Diagonalización

5.1

5.1.1

Introducción. Valores y vectores propios.

Planteamiento del problema.

Problema general de diagonalización. Dado un operador lineal f sobre un espacio vectorial V de dimensión n, nos planteamos el problema de cuándo es posible encontrar una base de

V respecto de la cuál la matriz de f sea diagonal. Si A es la matriz del operador f con respecto

a una determinada base entonces el planteamiento anterior es equivalente a preguntarse cuándo

existe un cambio de base tal que la matriz del operador en la nueva base sea diagonal. Esa

nueva matriz sabemos que viene dada por P −1 AP , donde P es la matriz de paso de la nueva

base a la anterior (Teorema de Semejanza).

Problema de la diagonalización ortogonal. Dado un operador lineal f sobre un espacio

vectorial V con producto interior y de dimensión n, nos planteamos el problema de cuándo es

posible encontrar una base ortonormal de V respecto de la cuál la matriz de f sea diagonal. Si

V es un espacio con producto interior y las bases son ortonormales entonces se tendrá que P

será ortogonal.

Podemos pues formular los dos problemas anteriores en términos de matrices.

? Problema 1. Dada una matriz cuadrada A, ¿existe una matriz P inversible tal que P −1 AP

sea diagonal?

? Problema 2. Dada una matriz cuadrada A, ¿existe una matriz ortogonal P tal que P t AP

sea diagonal?

Definición 5.1 – Se dice que una matriz A cuadrada es diagonalizable si existe una matriz P

inversible tal que P −1 AP es diagonal. En ese caso se dice que P diagonaliza a la matriz A.

Si existe una matriz ortogonal P tal que P −1 AP es diagonal, entonces se dice que A es

diagonalizable ortogonalmente y que P diagonaliza ortogonalmente a A.

5.1.2

Diagonalización. Valores y vectores propios.

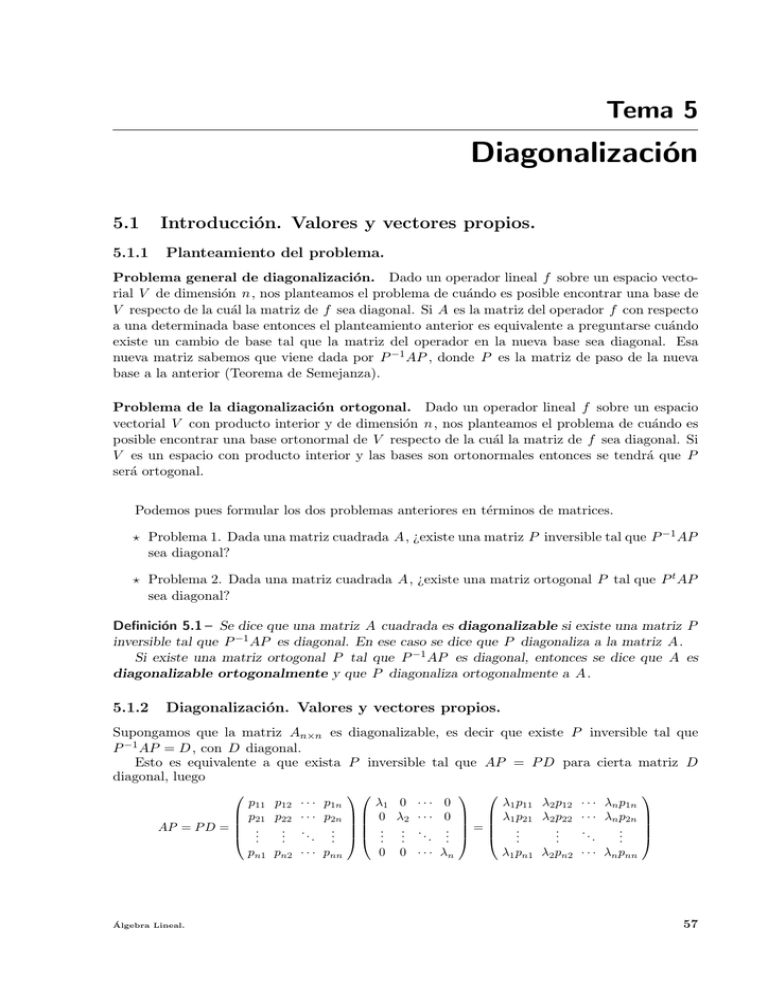

Supongamos que la matriz An×n es diagonalizable, es decir que existe P inversible tal que

P −1 AP = D , con D diagonal.

Esto es equivalente a que exista P inversible tal que AP = P D para cierta matriz D

diagonal, luego

p11 p12

p21 p22

AP = P D = .

..

..

.

pn1 pn2

Álgebra Lineal.

· · · p1n

· · · p2n

..

..

. .

· · · pnn

λ1 0 · · · 0

λ1 p11 λ2 p12

λ1 p21 λ2 p22

0 λ2 · · · 0

.. .. . . .. = ..

..

. . .

. .

.

0 0 · · · λn

λ1 pn1 λ2 pn2

· · · λn p1n

· · · λn p2n

..

..

.

.

· · · λn pnn

57

5.1 Introducción. Valores y vectores propios.

Si llamamos p1 , p2 , . . . , pn a los vectores columnas de P , como las columnas de la matriz AP

y las correspondientes de la matriz P D han de coincidir, lo anterior puede escribirse de la forma

Ap1 = λ1 p1 ,

Ap2 = λ2 p2 ,

...,

Apn = λn pn ,

es decir, han de existir n vectores pi y n números reales λi tales que Api = λi pi , para los

i = 1, . . . , n. Como la matriz P es inversible, los vectores pi son distintos del 0 y linealmente

independientes.

Definición 5.2 – Si A es una matriz cuadrada de orden n, diremos que λ es un valor propio,

valor caracterı́stico o autovalor de A si existe un p ∈ IRn , p 6= 0 , tal que Ap = λp.

Del vector p diremos que es un vector propio, vector caracterı́stico o autovector de

A correspondiente al valor propio λ.

Teorema 5.3 – Si A es una matriz de orden n, las siguientes proposiciones son equivalentes:

a). λ es un valor propio de A.

b). El sistema de ecuaciones (λI − A)x = 0 tiene soluciones distintas de la trivial.

c). det(λI − A) = 0.

Demostración:

λ es un valor propio de A ⇐⇒ existe un vector x ∈ IRn diferente de cero, tal que Ax = λx

⇐⇒ el sistema (λI − A)x = 0 tiene soluciones distintas de la trivial. ⇐⇒ |λI − A| = 0

Al polinomio en λ, P(λ) = |λI −A|, se le denomina polinomio caracterı́stico de la matriz

A, y a la ecuación P(λ) = |λI − A| = 0 ecuación caracterı́stica de A.

Definición 5.4 – Sea A una matriz de orden n y λ un valor propio de A, al espacio de las soluciones del sistema (λI − A)x = 0 se le denomina espacio caracterı́stico de A correspondiente

al valor propio λ y lo denotaremos por V (λ).

Observación:

Si λ es un valor propio de A, V (λ) = {x : (λI − A)x = 0} 6= {0} y por tanto dim V (λ) ≥ 1.

En el estudio sobre la diagonalización realizado hasta ahora, hemos buscado la diagonalización de matrices, separándolas del operador lineal que aparece en el planteamiento inicial del

problema. Lo que hemos encontrado hasta ahora ¿es reutilizable también para el estudio de ese

operador? En efecto:

Definición 5.5 – Sea f : V −→ V un operador lineal, diremos que un escalar λ es un valor

propio de f si existe un vector v ∈ V , diferente de cero, tal que f (v) = λv .

Al vector v se lo denomina vector propio de f correspondiente a λ.

Teorema 5.6 – Los vectores propios de f correspondientes al valor propio λ son los vectores,

distintos de cero, del núcleo de la aplicación λId −f (denotaremos por Id la aplicación identidad).

Demostración:

Si v un vector propio correspondiente a λ, entonces f (v) = λv =⇒ f (v) − λv = 0 =⇒

v ∈ ker(λId − f ).

Por otra parte si v 6= 0 pertenece al ker(λId − f ) se tiene que (λId − f )v = 0 =⇒

λv − f (v) = 0 =⇒ f (v) = λv , luego v es un vector propio de f correspondiente a λ.

Observación:

Este núcleo se denominará, espacio caracterı́stico de f correspondiente al valor propio λ.

Álgebra Lineal.

58

5.2 Diagonalización

Teorema 5.7 – Sean V un espacio vectorial de dimensión n, f : V −→ V un operador lineal y

A la matriz de f con respecto a una base B = {v1 , v2 , . . . , vn }. Entonces:

a) Los valores propios de f son los valores propios de A

b) Un vector v ∈ V es un vector propio de f correspondiente al valor propio λ si y sólo si

su matriz de coordenadas [v]B es un vector propio de A correspondiente a λ.

Demostración:

a) Sea λ un valor propio de f , es decir, ∃v ∈ V , distinto de 0 , tal que f (v) = λv =⇒

[f (v)]B = [λv]B =⇒ A[v]B = λ[v]B , luego λ es un valor propio de A al ser [v]B 6= 0.

Sea λ un valor propio de A, entonces ∃x ∈ IRn , x 6= 0 tal que Ax = λx. Si tomamos

x∗ = x1 v1 + · · · + xn vn , siendo x = (x1 , . . . , xn ), lo anterior quiere decir que A[x∗ ]B =

λ[x∗ ]B ⇒ [f (x∗ )]B = [λx∗ ]B ⇒ f (x∗ ) = λx∗ y λ es un valor propio de f ya que x∗ 6= 0

b) v es un vector propio de f correspondiente a λ si y sólo si

f (v) = λv ⇐⇒ [f (v)]B = [λv]B ⇐⇒ A[v]B = λ[v]B

si y sólo si [v]B es un vector propio de A correspondiente a λ.

A la vista de este resultado y siempre que trabajemos en términos de valores y vectores

propios, el problema de encontrar una base del espacio en la cual la matriz asociada al operador

sea diagonal, se reduce al estudio de la diagonalización de las matrices.

5.2

Diagonalización

Teorema 5.8 – Si A es una matriz de orden n, son equivalentes:

a) A es diagonalizable.

b) A tiene n vectores propios linealmente independientes.

Demostración:

a) ⇒ b). Lo hemos probado en los comentarios anteriores.

b) ⇒ a). Sean los n vectores p1 , p2 , . . . , pn vectores propios linealmente independientes

de A correspondientes a los valores propios λ1 , λ2 , . . . , λn . Consideremos la matriz

p11 p12

p21 p22

P =

..

..

.

.

pn1 pn2

· · · p1n

· · · p2n

..

..

. .

· · · pnn

que tiene por vectores columna los p1 , p2 , . . . , pn .

Las columnas de la matriz producto AP son Ap1 , Ap2 , . . . , Apn y los pi son vectores

propios, luego Ap1 = λ1 p1 , . . . , Apn = λn pn , por lo que:

λ1 p11 λ2 p12

λ1 p21 λ2 p22

AP = .

..

..

.

λ1 pn1 λ2 pn2

· · · λn p1n

· · · λn p2n

..

..

.

.

· · · λn pnn

p11 p12

p21 p22

= ..

..

.

.

pn1 pn2

· · · p1n

λ1 0 · · · 0

0 λ2 · · · 0

· · · p2n

. . . .

.

..

. .. .. .. . . ..

· · · pnn

0 0 · · · λn

= PD

donde D es la matriz diagonal que tiene como elementos en la diagonal principal a los valores

propios λ1 , λ2 , . . . , λn . Dado que los vectores columnas de P son linealmente independientes,

P es inversible y por tanto se tiene que D = P −1 AP , es decir, A es diagonalizable.

Álgebra Lineal.

59

5.2 Diagonalización

Proposición 5.9 – Sea f : V −→ V un operador lineal, siendo V un espacio vectorial de

dimensión n. Entonces, existe una base de V con respecto a la cual la matriz de f es diagonal

si y sólo si f tiene n vectores propios linealmente independientes.

Teorema 5.10 – Sean v1 , v2 , . . . , vk vectores propios de una matriz A asociados a los valores

propios λ1 , λ2 , . . . , λk respectivamente, siendo λi 6= λj , ∀i, j = 1, 2, . . . , k , con i 6= j . Entonces

el conjunto de vectores {v1 , v2 , . . . , vk } es linealmente independiente.

Demostración:

Supongamos que v1 , v2 , . . . , vk son linealmente dependientes.

Por definición, un vector propio es distinto de cero, luego el conjunto {v1 } es linealmente

independiente. Sea r el máximo entero tal que {v1 , v2 , . . . , vr } es linealmente independiente.

Puesto que hemos supuesto que {v1 , v2 , . . . , vk } es linealmente dependiente, r satisface que

1 ≤ r < k . Además, por la manera en que se definió r , {v1 , v2 , . . . , vr , vr+1 } es linealmente

dependiente. Por tanto, existen escalares c1 , c2 , . . . , cr+1 , al menos uno diferente de cero, tales

que

c1 v1 + c2 v2 + · · · + cr+1 vr+1 = 0.

h5.1i

Multiplicando en ambos lados de la igualdad por A y haciendo las sustituciones

Av1 = λ1 v1 , Av2 = λ2 v2 , . . . , Avr+1 = λr+1 vr+1

se obtiene

c1 λ1 v1 + c2 λ2 v2 + · · · + cr λr vr + cr+1 λr+1 vr+1 = 0

h5.2i

Multiplicando los dos lados de (5.1) por λr+1 y restándole a (5.2) la ecuación resultante se

obtendrá

c1 (λ1 − λr+1 )v1 + c2 (λ2 − λr+1 )v2 + · · · + cr (λr − λr+1 )vr = 0.

Y dado que los vectores v1 , v2 , . . . , vr son linealmente independientes, necesariamente

c1 1(λ1 − λr+1 ) = c2 (λ2 − λr+1 ) = · · · = cr (λr − λr+1 ) = 0

Como los λ1 , λ2 , . . . , λr+1 son distintos entre si, se deduce que c1 = c2 = · · · = cr = 0.

Sustituyendo estos valores en (5.1) resulta que cr+1 vr+1 = 0 , y como vr+1 6= 0 se deduce

que cr+1 = 0, lo que contradice el hecho de que al menos uno de los escalares c1 , c2 , . . . , cr+1

debı́a de ser distinto de cero. Luego no se puede suponer que v1 , v2 , . . . , vk sean linealmente

dependientes y tenemos probado el teorema.

Corolario 5.11 – Si una matriz A de orden n tiene n valores propios distintos, entonces A es

diagonalizable.

Proposición 5.12 – Sea A una matriz de orden n y λi un valor propio de A de multiplicidad

ni , si V (λi ) es el espacio caracterı́stico correspondiente al valor propio λi . Entonces

1 ≤ dim V (λi ) ≤ ni .

Demostración:

Evidentemente dim V (λi ) ≥ 1, como ya observamos en la definición 5.4.

Supongamos entonces que dim V (λi ) = d, y consideremos el operador lineal f : IRn −→ IRn

definido por f (v) = Av Sea {v1 , . . . , vd } una base del espacio caracterı́stico V (λi ), que podemos

completar hasta obtener una base de IRn , {v1 , . . . , vd , vd+1 , . . . , vn }. En dicha base, la matriz

del operador será de la forma

λi 0 · · · 0

0 λi · · · 0

. . .

..

.

.

.

.

0

.

.

.

B

A =

0 0 · · · λi

0

Álgebra Lineal.

B0

60

5.3 Diagonalización ortogonal.

Como A y A0 son matrices semejantes tienen el mismo polinomio caracterı́stico, es decir, |λI −

A| = |λI − A0 | = (λ − λi )d |λI − B 0 |, de donde se obtiene que d ≤ ni .

Teorema fundamental de la diagonalización 5.13 – Sea A una matriz de orden n. Entonces

A es diagonalizable si y sólo si se cumplen las condiciones:

a) Las n raices de la ecuación caracterı́stica de A son todas reales. Es decir, |λI − A| =

(λ − λ1 )n1 · · · (λ − λm )nm con n1 + n2 + · · · + nm = n.

b) Si V (λi ) es el espacio caracterı́stico de A correspondiente a λi , 1 ≤ i ≤ m, y ni es la

multiplicidad de λi en la ecuación caracterı́stica de A, entonces dim V (λi ) = ni .

Demostración:

⇒ Si A es diagonalizable, existe una matriz P inversible tal que P −1 AP = D (diagonal),

es decir, A y D son matrices semejantes y por tanto poseen el mismo polinomio caracterı́stico,

luego |λI − A| = |λI − D| = (λ − λ1 )n1 · · · (λ − λm )nm siendo λi ∈ IR un valor de la diagonal de

D repetido ni veces. Luego, por ser D de orden n se verificará que n1 + n2 + · · · + nm = n, es

decir, que las n raices son reales.

Además, por ser A y D matrices semejantes, también lo son λI − A y λI − D para todo

λ ∈ IR, ya que λI − D = λP −1 P − P −1 AP = P −1 (λI − A)P , ∀λ ∈ IR. De donde se deduce que

rg(λI − A) = rg(λI − D), ∀λ ∈ IR.

Ahora bien, si hacemos λ = λi , ∀i/1 ≤ i ≤ m, entonces rg(λi I − A) = rg(λi I − D) =

n − ni ⇒ dim V (λi ) = ni , ∀i = 1, 2, . . . , m, lo que prueba b).

⇐ Si |λI − A| = (λ − λ1 )n1 · · · (λ − λm )nm , con n1 + n2 + · · · + nm = n, y dim V (λi ) = ni

para todo i = 1, 2, . . . , m, consideremos en cada V (λi ) una base Bi , de la forma

B1 = {p1 , . . . , pn1 }, B2 = {pn1 +1 , . . . , pn1 +n2 }, . . . , Bm = {pn1 +n2 +···+nm−1 +1 , . . . , pn1 +n2 +···+nm }

Tomemos entonces B = B1 ∪ B2 ∪ · · · ∪ Bm , un conjunto de n vectores propios de A, si vemos

que son linealmente independientes, tendremos que A es diagonalizable.

Planteemos una combinación lineal igualada a cero:

(β11 p1 + · · · + βn11 pn1 ) + (β12 pn1 +1 + · · · + βn22 pn1 +n2 )+

+ · · · + (β1m pn1 +···+nm−1 +1 + · · · + βnmm pn1 +···+nm ) = 0

Llamemos v1 al primer vector situado entre paréntesis, v2 al segundo vector situado entre

paréntesis, etc. Los vectores v1 , v2 , . . . , vm son vectores del espacio caracterı́stico correspondientes, respectivamente, a los valores propios distintos λ1 , λ2 , . . . , λm y por tanto, si no son cero,

son linealmente independientes. Pero la combinación lineal v1 + v2 + · · · + vm = 0 nos indicarı́a que son dependientes, luego la única forma de eliminar esa contradicción es que vi = 0 ,

∀i = 1, 2, . . . , m, lo cual nos llevará por otra parte a que βji = 0 ∀i, j , con lo cual se obtiene que

B es linealmente independiente.

5.3

Diagonalización ortogonal.

Teorema 5.14 – Sea A una matriz de orden n, entonces son equivalentes:

a) A es diagonalizable ortogonalmente.

b) A tiene un conjunto de n vectores propios ortonormales.

Álgebra Lineal.

61

5.4 Ejercicios

Demostración:

En efecto, A es diagonalizable ortogonalmente ⇐⇒ existe P ortogonal tal que P t AP = D

(con D diagonal) ⇐⇒ existe P ortogonal tal que AP = P D .

Si llamamos p1 , p2 , . . . , pn a los vectores columnas de P , éstos vectores son ortonormales

y

lo mismo que escribir Ap1 = λ1 p1 , . . . , Apn = λn pn , supuesto que D =

lo anterior es

λ1 0 · · · 0

0 λ2 · · · 0

. .

. , y como al ser P inversible se tiene que p1 , p2 , . . . , pn son linealmente inde . . ..

. ..

. .

0 0 · · · λn

pendientes y por tanto no nulos ⇐⇒ A tiene n vectores propios ortonormales.

Teorema fundamental de la diagonalización ortogonal 5.15 – Una matriz A de orden n es

diagonalizable ortogonalmente si y sólo si A es simétrica.

Teorema 5.16 – Si A es una matriz simétrica, entonces los vectores propios que pertenecen a

valores propios distintos son ortogonales.

Demostración:

Sean λ1 y λ2 valores propios distintos de una matriz simétrica A y sean u y v vectores

propios correspondientes a λ1 y λ2 respectivamente.

Tenemos que probar que ut v = 0. (Notar que ut Av es un escalar).

Se tiene que

ut Av = (ut Av)t = v t Au = v t λ1 u = λ1 v t u = λ1 ut v ,

y por otra parte que ut Av = ut λ2 v = λ2 ut v ,

por tanto λ1 ut v = λ2 ut v ⇒ (λ1 − λ2 )ut v = 0 y como λ1 − λ2 6= 0, entonces ut v = 0.

5.4

Ejercicios

5.1 Hallar las ecuaciones caracterı́sticas, los valores propios

terı́sticos de las siguientesmatrices:

Ã

!

5 6

2

4 0

−2 −7

a)

b) 0 −1 −8 c) −2 1

1

2

1 0 −2

−2 0

y bases de los espacios carac

1

0

1

5.2 Sea T : M2×2 −→ M2×2 el operador

por:

à lineal!definido

Ã

!

a b

2c

a+c

T

=

c d

b − 2c

d

Hallar los valores propios de T y bases para los subespacios caracterı́sticos de T .

5.3 Demostrar que λ = 0 es un valor propio de una matriz A si y sólo si A es no inversible.

5.4 Probar que el término constante del polinomio caracterı́stico P (λ) = |λI − A| de una

matriz A de orden n es (−1)n det(A).

5.5 Demostrar que si λ es un valor propio de A entonces λ2 es un valor propio de A2 .

Demostrar por inducción que, en general, λn es un valor propio de An , ∀n ∈ IN.

5.6 Estudiar si son o no diagonalizables las siguientes matrices y en caso de que lo sean hallar

una matriz

P talque P −1 AP = D con D matriz

diagonal:

Ã

!

−1 4 −2

3 0 0

−14 12

c) −3 4 0

a) 0 2 0 b)

−20 17

−3 1 3

0 1 2

Álgebra Lineal.

62

5.4 Ejercicios

x1

2x1 − x2 − x3

x1 − x3

5.7 Sea T : IR3 −→ IR3 el operador lineal T x2 =

. Hallar una base

x3

−x1 + x2 + 2x3

3

de IR respecto de la cual la matriz de T sea diagonal.

5.8 Sea P1 (x) el espacio vectorial de los polinomios de grado menor o igual a 1. Sea T : P1 (x) −→

P1 (x) el operador lineal T (a0 +a1 x) = a0 +(6a0 −a1 )x. Hallar una base de P1 (x) respecto

de la cual la matriz de T sea diagonal.

5.9 Sea A una matriz de orden n y P una matriz inversible de orden n. Demostrar por

inducción que (P −1 AP )k = P −1 Ak P , ∀k ∈ IN.

Ã

5.10 Calcular A40 siendo A =

1 0

−1 2

!

.

5.11 Estudiar la diagonalizabilidad

de la matriz A, dada en función de los parámetros a y b,

5 0 0

siendo A = 0 −1 a . En los casos posibles diagonalizarla.

3 0 b

5.12 Sea A una matriz de orden 2 tal que A2 = I . Probar que A es diagonalizable.

5.13 Hallar una matriz P que diagonalice ortogonalmente a

una de las siguientes matrices:

5

Ã

!

2 −1 −1

−2

−7 24

a)

b) −1 2 −1 c)

0

24 7

−1 −1 2

0

5.14

A y calcular P −1 AP para cada

−2 0

0

2

0

0

0

5 −2

0 −2 2

a) Demostrar que si D es una matriz diagonal con elementos no negativos entonces

existe una matriz S tal que S 2 = D .

b) Demostrar que si A es una matriz diagonalizable con valores propios no negativos

entonces existe una matriz S tal que S 2 = A.

5.15 Probar que A y At tienen los mismos valores propios siendo A una matriz de orden n.

5.16 Sea A una matriz de orden n y P (λ) = |λI − A|. Probar que el coeficiente de λn−1 en

P (λ) es el opuesto de la traza de A.

5.17 Sea A una matriz de orden n inversible, demostrar que los valores propios de A−1 son los

inversos de los valores propios de A.

5.18 Sea A una matriz de orden n ortogonal, probar que todos los valores propios de A son

uno o menos uno.

5.19 Se sabe que (1, 0, 0), (1, 1, 0), (0, 1, 0) y (0, 0, 1) son vectores propios de una matriz de

orden 3 y que hay vectores de IR3 que no lo son. Calcular todos los vectores propios de la

matriz.

(

un = 3un−1 + 3vn−1

. Utilizar la divn = 5un−1 + vn−1

agonalización para calcular un y vn en función de n, sabiendo que u0 = v0 = 1.

5.20 Se dan las siguientes ecuaciones de recurrencia:

5.21 Los dos primeros términos de una sucesión son a0 = 0 y a1 = 1. Los términos siguientes

se generan a partir de ak = 2ak−1 + ak−2 ; k ≥ 2. Hallar a127 .

Álgebra Lineal.

63

5.4 Ejercicios

5.22 El propietario de una granja para la crı́a de conejos observó en la reproducción de éstos

que:

i). Cada pareja adulta (con capacidad reproductora) tiene una pareja de conejos cada

mes.

ii). Una pareja recién nacida tarda dos meses en tener la primera descendencia.

Si partimos de una pareja adulta y siendo an el número de parejas nacidas en el n-ésimo

mes (a0 = 0), se pide:

a) Obtener una fórmula recurrente para an en función de términos anteriores.

√

√

(1 + 5)n − (1 − 5)n

√

b) Probar que an =

2n 5

an+1

c) Calcular, si existe: lim

.

n→∞ an

5.23 Sea el determinante n × n siguiente:

¯

¯

¯

¯

¯

¯

¯

¯

Dn = ¯¯

¯

¯

¯

¯

¯

¯

3

1

0

0

..

.

1

3

1

0

..

.

0

1

3

1

..

.

0

0

1

3

..

.

···

···

···

···

..

.

0

0

0

0

..

.

¯

0 ¯¯

0 ¯¯

0 ¯¯

¯

0¯

.. ¯¯

.¯

¯

0 0 0 0 · · · 3 1 ¯¯

0 0 0 0 ··· 1 3 ¯

Dar una expresión de Dn en función de los determinantes de tamaño menor que n y

obtener las ecuaciones de recurrencia para hallar su valor.

5.24 Determinar para qué valores de

a,

1

A= 0

0

b y c son

las matrices

simultáneamente

diagonalizables

a b

1 a b

2 c

y

B= 0 1 c

0 2

0 0 2

c 2a 0

a

5.25 Estudiar para qué valores de a, b y c es diagonalizable la matriz A = b 0

0 2b −c

a −a 0

0 . Estudiar para qué valores de a y b la matriz A

5.26 Dada la matriz A = −a a

b

0 2b

es diagonalizable.

5.27 Sea f : IR3 −→ IR3 el operador lineal cuya

matriz asociada

a la base canónica es:

m 0 0

A= 0 m 1

1 n m

a) Determinar para qué valores de m y n existe una base de IR3 de tal forma que la

matriz en esa base sea diagonal. En los casos que f sea diagonalizable calcular una

base en la cuál la matriz de f sea diagonal.

b) Si n = 0, observando la matriz A y sin hacer ningún cálculo, determinar un valor

propio y un vector propio asociado a dicho valor propio, razonando la respuesta.

Álgebra Lineal.

64

5.4 Ejercicios

−1 0 0 0

a −1 0 0

5.28 Dada la matriz A =

. Encontrar para qué valores de los parámetros

b

d 1 1

c

e f 1

a, b, c, d, e, f ∈ IR la matriz A es diagonalizable. Para dichos valores encontrar las matrices

P y D tales que P −1 AP = D , donde D es una matriz diagonal.

5.29 En IR4 consideramos el subconjunto: S = {(x1 , x2 , x3 , x4 ) / x2 − x4 = 0}. Sea T : IR4 −→

IR4 el operador lineal que verifica:

i). ker(T ) = {x ∈ IR4 / < x, y >= 0, ∀y ∈ S}.

ii). T (1, 0, 0, 0) = (−1, 3, 1, −2).

iii). T (1, 1, 1, 1) = (−3, m, n, p).

(

x1 + x2 + x3 + x4 = 0

es el conjunto de vecx2 + 2x3 + 2x4 = 0

tores propios correspondientes a un mismo valor propio de T.

iv). El subespacio solución del sistema:

Se pide:

a) Probar que S es un subespacio vectorial de IR4 .

b) Hallar ker(T ).

c) Encontrar una base para el subespacio de vectores propios de la propiedad (iv).

d) La matriz estándar de T .

5.30 Sean f : IR4 −→ IR4 un operador lineal, y B = {e1 , e2 , e3 , e4 } la base canónica de IR4 ,

verificando lo siguiente:

i). f (e1 ) ∈ H = {x ∈ IR4 / x2 = 0}

ii). f (e2 ) ∈ S = {x ∈ IR4 / x2 = 1 y x4 = 0}

iii). f (e3 ) = (α, β, 1, −2); f (e4 ) = (1, 0, −2, γ)

iv). ker f es el conjunto de soluciones del sistema:

2x1 + x2 + 2x3 − 2x4 = 0

3x + 3x + x + x = 0

1

2

3

4

x − x − x + 3x = 0

1

2

3

4

v). Las ecuaciones implı́citas de la imagen de f son y1 − 2y3 − y4 = 0.

vi). El operador f es diagonalizable.

Hallar la matriz estándar de f .

Álgebra Lineal.

65