Modelo Econométrico

Anuncio

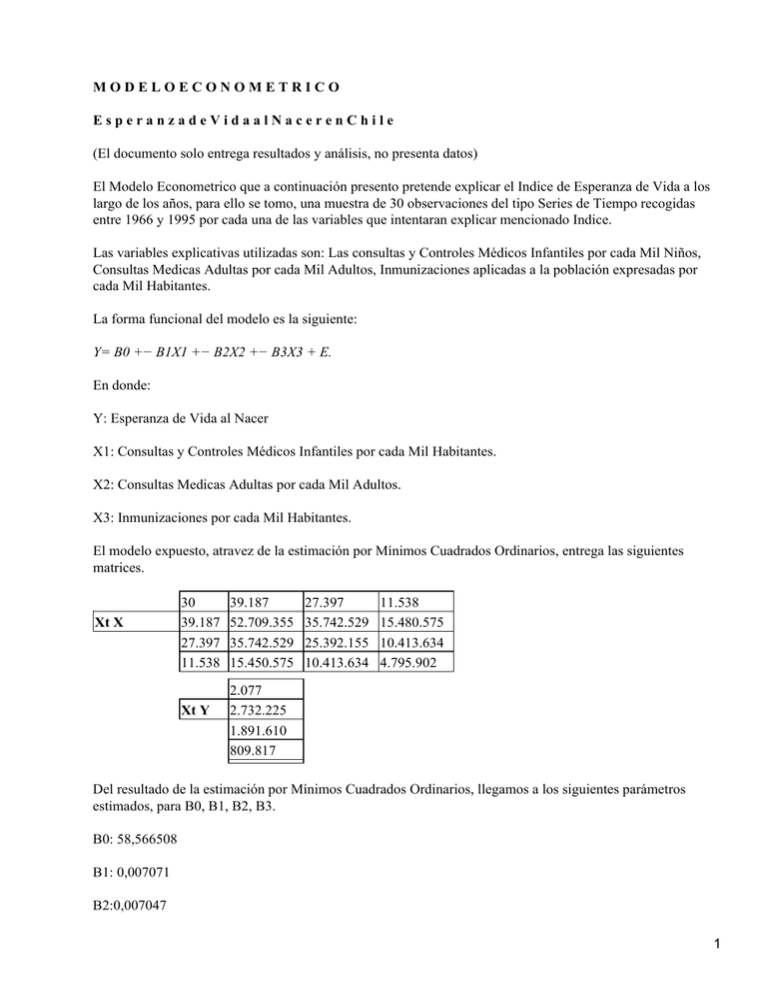

MODELOECONOMETRICO EsperanzadeVidaalNacerenChile (El documento solo entrega resultados y análisis, no presenta datos) El Modelo Econometrico que a continuación presento pretende explicar el Indice de Esperanza de Vida a los largo de los años, para ello se tomo, una muestra de 30 observaciones del tipo Series de Tiempo recogidas entre 1966 y 1995 por cada una de las variables que intentaran explicar mencionado Indice. Las variables explicativas utilizadas son: Las consultas y Controles Médicos Infantiles por cada Mil Niños, Consultas Medicas Adultas por cada Mil Adultos, Inmunizaciones aplicadas a la población expresadas por cada Mil Habitantes. La forma funcional del modelo es la siguiente: Y= B0 +− B1X1 +− B2X2 +− B3X3 + E. En donde: Y: Esperanza de Vida al Nacer X1: Consultas y Controles Médicos Infantiles por cada Mil Habitantes. X2: Consultas Medicas Adultas por cada Mil Adultos. X3: Inmunizaciones por cada Mil Habitantes. El modelo expuesto, atravez de la estimación por Mínimos Cuadrados Ordinarios, entrega las siguientes matrices. Xt X 30 39.187 27.397 11.538 Xt Y 39.187 52.709.355 35.742.529 15.450.575 27.397 35.742.529 25.392.155 10.413.634 11.538 15.480.575 10.413.634 4.795.902 2.077 2.732.225 1.891.610 809.817 Del resultado de la estimación por Mínimos Cuadrados Ordinarios, llegamos a los siguientes parámetros estimados, para B0, B1, B2, B3. B0: 58,566508 B1: 0,007071 B2:0,007047 1 B3:0,020657 De esta forma, nuestro modelo funcional queda de la siguiente forma: Y= 58,5665 + 0,007071X1 + 0,007047X2 + 0,020657X3 + 1,78 B0: Tiene relación directa con la variable Indice de Esperanza de Vida, y explica en un 58,566508% la Esperanza de Vida en ausencia de las otras variables. B1: Tiene relación directa con la variable Indice de Esperanza de Vida, y explica en un 0,007071% la variabilidad del Indice de Esperanza de Vida en ausencia de las otras variables. B2: Tiene relación directa con la variable Indice de Esperanza de Vida, y explica en un 0,007047% la variabilidad del Indice Esperanza de Vida en ausencia de las otras variables. B3: Tiene relación directa con la variable Índice de Esperanza de Vida, y explica en un 0,020657% la variabilidad del Índice Esperanza de Vida, en ausencia de las otras variables. (Ver Análisis de Regresión Lineal Múltiple en Anexos) Análisis Grafico: Para este análisis grafico, se tomo, la variable respuesta, Indice de esperanza de Vida, comparándose con cada una de las variables explicativas en forma independiente, y de esta forma, se comprobó el supuesto de linealidad existente. En el grafico numero 1, la variable Y, toma los valores del Indice de Esperanza de Vida, y como variable X, las Consultas y Controles Médicos Infantiles por cada Mil Niños; en donde los datos se ajustan a la recta en un 71,01%. En el grafico numero 2, la variable Y, toma los valores del Indice de Esperanza de Vida, y como variable X, las Consultas Medicas Adultas por cada Mil Adultos, en donde los datos se ajustan a la recta en un −37.619%. En el grafico numero 3, la variables Y, toma los valores del Indice de Esperanza de Vida, y como Variable X, las Inmunizaciones por cada Mil Habitantes, los datos se ajustan a la recta en un 83,4515%. En el grafico numero 4, se muestran en su conjunto todas la variables explicativas, v/s la variable respuesta. Los gráficos anteriormente mencionados se mostraran a continuación. Varianza − Covarianza. La matriz varianza − covarianza, se deduce de la siguiente formula: Var − COV (B ) = Varianza (Xt X) *−1 Como la matriz Xt X es de 4 X 4, entonces esta matriz, la varianza covarianza, también será de 4X4; el objetivo fundamental de esta matriz, es la de poder determinar atravez de la raíz cuadrada de la vertical central las desviaciones estándar de cada uno de los parámetros estimados; de esta forma la matriz varianza covarianza queda de la siguiente forma: COVM COVM COVM COVM 2 Var − Cov 12,4226 2064,89 9050,33 3557,71 206,489 2956780 57389300 3345380 9050,33 57389300 9387030 3224970 3557,71 3345380 3224970 130909 Entonces la desviación estándar para cada uno de los parámetros son las siguientes, B0:3,524570 B1:1719,52 B2: 3063,826 B3:361,813 (Ver matriz Varianza Covarianza en Anexos) Coeficiente de Determinación y Coeficiente de Determinación Ajustado: El coeficiente de determinación, mide la bondad de ajuste de la ecuación de regresión, es decir da la proporción o porcentaje de la variación total en la variable dependiente Y explicada por las variables explicativas X . Si el coeficiente de determinación es 1, la línea de regresión ajustada explica el 100% de la variación en Y, por otra parte si es 0, el modelo no explica parte alguna de la variación en Y El coeficiente de determinación ajustado, este coeficiente de determinación se ajusta por los grados de libertad asociados a la suma de los cuadrados, este R2 ajustado, tiene como principal importancia determinar la variabilidad que es explicada por las variables explicativas, con respecto a la variable respuesta cuando se introduce una variable adicional al modelo. Para nuestro modelo, el Coeficiente de Determinación, es de un 0,829827, es decir que el 82,98% de la variabilidad de la variable respuesta es explicada por las variables explicativas, para el caso puntual. El Coeficiente de Determinación Ajustado, para nuestro modelo es de 0,810192, es decir que el 81,01% de la variabilidad de la variable respuesta es explicada por las variables explicativas, si se introduce una variable adicional al modelo. (Ver Análisis de Regresión Lineal Múltiple en Anexos) Test de Significancia Individual: En terminos generales, los test de significancia conforman un procedimiento, mediante los cuales se utilizan los resultados muestrales para verificar la verdad o falsedad de la hipótesis nula que se plantea. L a idea basica detras de las pruebas de significancia es la de un estadístico de prueba (t.student) y su distribución muestral bajo la hipótesis nula. La decisión de aceptar o rechazar Ho se lleva a cabo con base en el valor del estadístico de prueba (alfa; n−2) obtenido a partir de los datos disponibles. T= Bo − bo Se Bo 3 En base a el estadístico notado anteriormente se plantea la prueba de hipótesis, que servira para notar nuestro test de significancia individual, de la forma que se muestra a continuación. Bo = 0 B1 = 0 En donde Bo es igual a cero, lo que muestra que la variable, no aporta información al modelo, es decir, aporta cero información; si se acepta la hipótesis alternativa ( B1) y se rechaza la hipótesis nula ( Bo), el aporte de la variable es distinto de cero, por lo tanto entrega aporte al modelo. Entonces, probaremos las variables de nuestro modelo, considerando los antecedentes teóricos. Test de Significancia Individual para el Intercepto: Bo = 0 B1 = 0 T= B0 − b0 = 16.6166 Se B0 T= (0.05; 28) =1.7011 Por lo tanto se rechaza Ho, y se acepta H1, es decir, la variable correspondiente al intercepto aporta información significativa en forma independiente al modelo. Test de Significancia Individual para Consultas Medicas Infantiles (X1) Bo = 0 B1 = 0 T= B1 − b1 = 4.1123 Se B1 T= ( 0.05; 28) = 1.7011 Por lo tanto se rechaza Ho, y se acepta H1, e decir, la variable Consultas Medicas Infantiles, aporta información significativa en forma individual al modelo. Test de Significancia Individual para Consultas Medicas Adultos (X2) Bo = 0 B1 = 0 T = B2 − b2 = 2.3002 Se B2 4 T = (0.05; 28) = 1.7011 Por lo tanto se rechaza la hipótesis nula (Ho) y se acepta la hipótesis alternativa (B1), lo que demuestra que la variable Consultas Medicas Adultas si aporta información significativa en forma individual al modelo. Test de Significancia Individual para Inmunizaciones. Bo = 0 B1 = 0 T = B3 − b3 = 5.7093 Se B3 T = (0.05; 28) = 1.7011 Por lo tanto se rechaza la hipótesis nula (Ho) y se acepta la hipótesis alternativa (B1), lo que demuestra que la variable Inmunizaciones si aporta información significativa en forma individual al modelo. Como conclusión general al los test de significancia individual, se puede afirmar que las variables presentadas, si aportan información significativa al modelo, en forma individual. (Ver Análisis de Regresión Lineal Múltiple en Anexos) Test de Significancia Global para el Modelo: Para desarrollar este test de significancia global, se conciderara la siguiente hipótesis: Ho : B0 = B1 = B2 = B3. H1 : B0 = B1 = B2 = B3. Esta prueba de hipótesis, considera como la hipótesis nula, que ninguna de las variables aporta información significativa al modelo, en forma conjunta o simultanea, la hipótesis alternativa demuestra todo lo contrario a la hipótesis, nula , es decir, que existe una relación con respecto a la línea de regresión observada o estimada; para probar la hipótesis conjunta, se utilizan los datos muéstrales, se estará violando el supuesto existente detrás del procedimiento de pruebas ( En cualquier muestra dada la cov ( BO B1 B2 B3 ) no puede ser cero; es decir ( BO B1 B2 B3) pueden estar correlacionadas) R2 F=K (1 − R2) N−K−1 H0 = B0 = B1 = B2 = B3 H1 = B0 = B1 = B2 = B3 5 Para este caso, utilizaremos una ANOVA ( Analisis Of Varianza) ANOVA Sourse Model Error Total (Corr) Sum of Squares 404,184 82,8861 487,0701 DF 3 26 29 Man Squares 134,728 3,18793 F 42,2619066 (Ver Análisis Of Varianza en Anexos) Para la prueba que se presento, se utiliza un estadístico de Fissher, el cual se distribuye F(Alfa, N, N−K−1), de esta forma el estadístico para la prueba queda de la siguiente manera: F = (0.05, 3, 30−3−1) = 2.9752 Como se puede concluir, se rechaza Ho (hipótesis nula), y se acepta la Hipótesis Alternativa, es decir H1, lo que demuestra que las variables en su conjunto aportan información para explicar la Esperanza de Vida al Nacer, que es el tema de nuestro modelo. 2.9752 42.2619 F Intervalos de Confianza: Los intervalos de confianza que a continuación se muestran, traspasan a la forma grafica las pruebas de significancia individual, para las variables que se analizaron anteriormente,, en este análisis grafico, se demostrara de mejor forma, la calidad de los test aplicados. s Intervalo para Bo; Intercepto. 0 1.7011 16.6166 Intervalo para B1; Consultas Medicas Infantiles. 0 1.7011 4.1123 Intervalo para B2; Consultas Medicas Adulto. 0 1.7011 2.3002 Intervalo para B3; Inmunizaciones. 0 1.7011 5.7093 En las graficas correspondientes a cada prueba se puede ver claramente que la raya de color rojo, significa el nivel de t critico, es decir del punto de rechazo 1.7011, para las variables, distribuidas t(0.05, 28). De esta forma queda totalmente demostrado que las variables en forma individual aportan información significativa al modelo. (Ver Análisis de Regresión Lineal en Anexos) 6 Correlación Simple: La correlación se define, como el grado en que las variables explicativas se relacionan con la variable respuesta, en forma individual; para ello es necesario que el indice de correlación sea en parte superior en extricto rigor a 0.80. Correlacion Simple: Indice Esperanza de Vida Y ; Consultas Medicas Infantiles X1: Correlacion Simple Espera Y CMI X1 Espera Y 1 0,7101 CMI X1 0,7101 1 Como se puede apreciar la variable Consulta Medica Infantil, posee mencionado indice en 0.7101, lo que se hacerca bastante al 0.80, lo que quiere decir, que existe correlación. Correlacion Simple: Indice Esperanza de Vida Y ; Consultas Medicas Adultas X2: Correlacion Simple Espera Y CMA X2 Espera Y 1 −0,3762 CMA X2 −0,3762 1 Como se puede apreciar la variable Consulta Medica Adulto, posee mencionado indice en −0.3762, lo que se aleja bastante al 0.80, lo que quiere decir, que no existe correlación, por lo tanto se recomendara sacar la variable. Correlación Simple: Indice Esperanza de Vida Y ; Inmunizaciones X3: Correlacion Simple Espera Y INMU X3 Espera Y 1 0,8345 INMU X3 0,8345 1 Como se puede apreciar la variable Inmunizaciones, posee mencionado indice en 0.8345, lo que sobrepasa bastante al 0.80, lo que quiere decir, que existe correlación. Como conclusión, se estima que dos de las variables presentadas presentan calidad, y por lo tanto se recomienda sacar la variable, Consultas Medicas Adultas (X2) Correlaciones Parciales: La correlación parcial se define, como el grado en que las variables explicativas se relacionan con la variable respuesta, en forma conjunta; para ello es necesario que el indice de correlación sea en parte superior en extricto rigor a 0.50. Matriz de Correlación Parcial. Correlacion Parcial 7 Espera CMI X1 MCA X2 INMU X3 Espera −1 0,62777 −0,41121 0,74585 CMI X1 0,6277 −1 0,33544 −0,18942 MCA X2 −0,41121 0,33544 −1 0,13005 INMU X3 0,7458 −0,18942 0,13005 −1 Como se puede apreciar; todas la variables expuestas, tienen un coeficiente mayor a 0.50, excepto la variable, consultas medicas adulto, que presenta un coeficiente negativo, para lo cual se solucionara eliminando esta variable del modelo, presentado originalmente Multicolinealidad: En base a la teoría analizada en cátedras, el modelo que presentamos, no tiene multicolinelidad, puesto, que: El R2, no es tal alto, y las pruebas de significancia individual o pruebas t, son todas significativas, por lo tanto no se corre riesgo alguno de rechazar la hipótesis de que los coeficientes parciales de pendiente son simultáneamente iguales a cero No existe alta correlación entre las parejas de regresores, como en el modelo presentado las correlaciones no sobrepasan el factor 0.80, a excepción de la variables inmunizaciones, se puede concluir de buena forma que con las medidas empíricas de detección de multicolinealidad, no se presenta este problema. Por otra parte el modelo no cuenta con regresiones auxiliares; puesto que la multicolinealidad surge debido a que uno o mas regresores son combinación lineal exacta o aproximada de los otros regresores. Como se concluye el modelo presentado no cuenta con multicolinealidad. Heterocedasticidad: Uno de los supuestos importantes del modelo clásico de regresión lineal es que la variable de cada termino de perturbación ui condicional a los valores seleccionados de las variables explicativas, es algun numero constante o igual a la varianza; este es el supuesto de la homosedasticidad , igual dispersión, es decir igual varianza. Para su detección utilizaremos la prueba de Park; este popular método es aplicable si se supone que la varianza heterocedastica esta relacionada con una variable explicativa en el modelo de regresión, para comprobar ello, se utiliza una prueba de hipótesis, en donde: Ho = Homocedasticidad H1 = Heterocedasticidad LN ei2 = Bo + B1 ln X1 + E LN ei2 = Bo + B2 ln X2 + E LN ei2 = Bo + B3 ln X3 + E Esta prueba distribuye t (alfa n−2) grados de liberta; lo que para nuestro modelo quedara de la siguiente forma. 8 T ( 0.05; 2) = 1.8595 T obs CMIX1= 0.5699, no cae en la region de rechazo por lo tanto por esta variable existe homesedasticidad T obs CMAX2 = −0.4090, se encuentra fuera de la region de rechazo por lo tanto no existe heterosedasticidad, por esta variable. T obs INMUNIX3 = 1.0993, se encuentra fuera de la regíon de rechazo por lo tanto existe homocedasticidad En conclusión se puede decir que se rechaza la hipótesis alternativa y se acepta la nula, es decir, el modelo no tiene heterosedasticidad, segun prueba de Park. Autocorrelación: Un supuesto importante en el modelo de regresión lineal es que no hay correlación serial o autocorrelación entre las perturbaciones ui consideradas dentro de la función de regresión poblacional. Para detectar la no existencia de este supuesto se utilizara la prueba del estadístico d, de Durbin y Watson, el cual define como la razón de la suma de las diferencias al cuadrado de residuales sucesivos sobre la suma residuo cuadrado, considerando la siguiente formula. D = Sumatoria ( ui − ui − 1) 2 Sumatoria ui2 Esta prueba entrega un resultado ejecutado por el programa Statgraf, de 0.639, lo que evidencia la existencia de autocorrelacion serial, entre las variables. 0.639 0 dl dv 2 4−dv 4−dl 4 1.214 1.650 2.35 2.786 Como en la grafica se muestra, los valores dl y dv, son sacados de una tabla que esta expresada en un grado de 0.05 es decir 5% de significancia, con 30 observaciones y 3 variables, esto demuestra la existencia de autocorrelación. La autocorrelacion existente, se tratara corregir a traves del método de las primeras diferencia. ( yt − pyt−1)=Bo (1−p)+ B1 ( xt − pxt−1) + B2 ( x2t − px2t−1) + E El modelo quedara con solo dos variables, representadas por: X1: Consultas y Controles Medicos Infantiles. X2: Inmunizaciones. Esta transformación del modelo, se realiza dado que el análisis de correlación simple y parcial recomienda sacar la variable, Consultas Medicas Adultas, y dada la existencia de autocorrelacion avala este procedimiento, para la mejora del Modelo. 9 De esta forma y luego de la estimación de ro, y posterior aplicación del método de las primeras diferencias, en nuevo modelo queda sin autocorrelacion.( Ver anexo, método de primeras diferencias) Ro = p = Sumatoria (et * et−1) Sumatoria et2 p= 790477,615 793359,9645 0,99636691 El nuevo modelo corregido, queda con un estadístico d, de 1.707, que se muestra en la grafica siguiente. 1.707 0 dl dv 2 4−dv 4−dl 4 1.270 1.563 2.437 2.73 El modelo corregido por el método de las primeras diferencia no tiene autocorrelacion, puesto que el estadístico d, cae junto en la zona de no autocorrelacion. Los nuevos estimadores, para el modelo corregido y con solo dos variables, son los siguientes. Bo = 0.733573 B1 = 0.000059 B2 = −0.000763 La forma funcional es la siguiente: Y = 0.733573 + 0.000059 X1 − 0.000763 X2 + E En donde Bo, tiene una relación directa; B1 relación directa, y B2 relación indirecta. La siguiente grafica muestra el nuevo modelo ajustado. Serie de Tiempo: El grafico que mostraremos a continuación corresponde a las series de tiempo del modelo original, y el que sigue del modelo ajustado. 10 Serie de Tiempo: El grafico que mostraremos a continuación corresponde a las series de tiempo del modelo original, y el que sigue del modelo ajustado. 11 12 13 14 15 16