Distancias Estadísticas - Instituto Nacional de Estadistica.

Anuncio

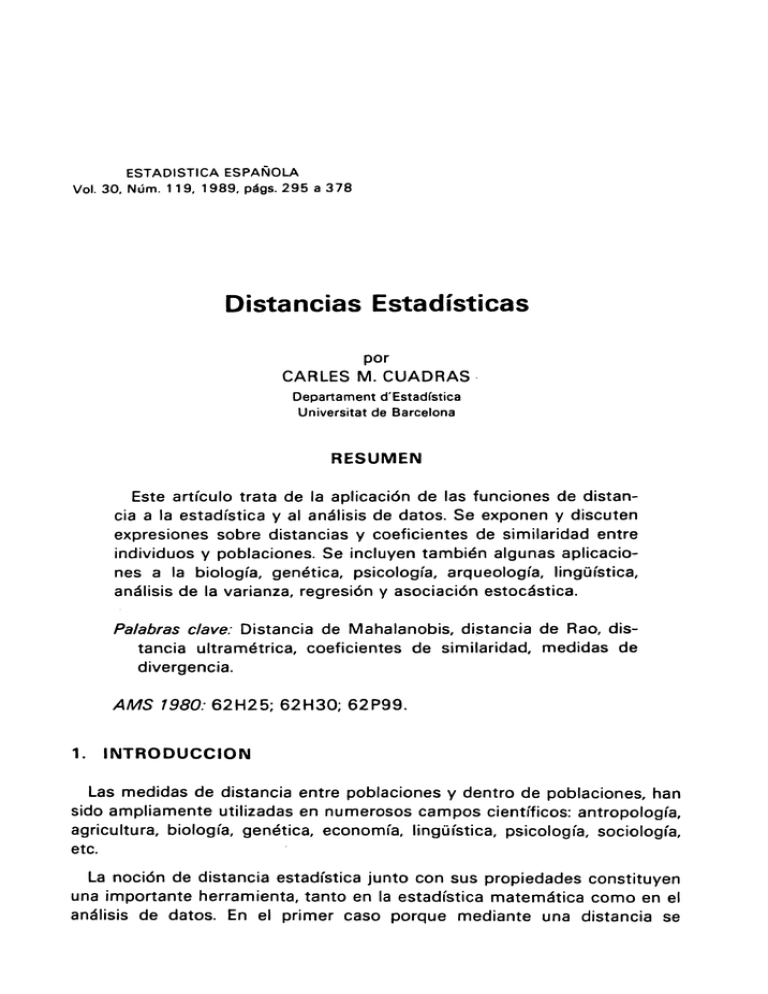

ESTADISTICA ESPAÑOLA

Vol. 30, Núm. 1 19, 1989, p^gs. 295 a 378

Distancias Estadísticas

por

CARLES M. CUADRAS ^

Departament d'Estadística

Universitat de Barcelona

RESUMEN

Este artículo trata de la aplicación de las funciones de distancia a la estadística y a1 análisis de datos. Se exponen y discuten

expresiones sobre distancias y coeficientes de similaridad entre

individuos y poblaciones. Se íncluyen también algunas aplicaciones a la biología, genética, psicología, arqueología, lingi.iística,

anélisis de la varianza, regresión y asociación estoc^istica.

Palab^as clave: Distancia de Mahalanobis, distancia de Rao, distancia ultramétrica, coeficientes de similaridad, medidas de

divergencia.

AMS 1984: 62H25; 62H30; 62P99.

1.

INTRODUCCION

Las medidas de distancia entre poblaciones y dentro de poblaciones, han

sido ampliamente utilizadas en numerosos campas científicos: antropología,

agricultura, biología, genética, economía, lingiiística, psicología, sociología,

etc.

^

La noción de distancia estadística junto con sus propiedades constituyen

una importante herramienta, tanto en la estadística matem^tica como en el

análisis de datos. En el primer caso porque mediante una distancia se

?9fi

C^STAC^ISTIC'A ESF'A!^Ol_.A

pueden construir contrastes de hipótesis, estudiar propiedades asintóticas

de estimadores, comparar par^imetros, etc. En el segundo caso, porque fa

distancia es un concepto muy intuitivo, que permite obtener representaciones geométricas, fáciles de entender, ofreciendo al investigador una

importante ayuda para interpretar la estructura de !os datos.

En líneas generales consideramos dos clases de distancias estadísticas

entre individuos y poblaciones:

a1 Los n individuos de una población S2 quedan descritos por una nnatriz

de datos X(n x p), donde p es el número de variables estadísticas (cuantitativas, cualitativas, binarias o categóricasl. EI número n suele ser el tamaño

de una muestra de la población (ejemplo: n= 75 estudiantes universitarios},

pero puede darse el caso de que Sl sea una población finita de n elementos

(ejemplo: las n= 50 provincias españolas). Una distancia ^5;^ = ó(i,j) entre

dos individuos o elementos i,j de S2 es una medida simétrica no negativa

que cuantifica la diferencia entre ambos en relación con las variables. ^ se

puede sumarizar a través de ia matriz de distancias

^f1

^12 • . . ó1n

^2 r

^22 . . . Ú2 n

...............

^n ^

siendo ^5;; = o, cS;,

^n2 ' ' ' ann

V J; .

TABLA 1

Matriz de distancias genéticas entre 6 poblaciones de Drosophila subobscura: Heriot (H), Dalkeith (D), Groningen (G), Viena (V}, Zurich (Z},

Drobak ( Dr)

H

D

C;

^/

Z

Dr

H

D

G

V

Z

Dr

O

0.083

O

0.290

©.276

O

0.399

0.370

0.187

0

0.331

0,3

0.112

0.128

O

0.307

0.307

0.152

0.260

0.235

^

b) Los individuos de cada pablación están caracterizados por un vector

aleatorio X=(X,, ..., XP}, que sigue una distribución de probabilidad f(x^, ...,

xP; f^}. La distancia entre dos individuos i,j, caracterizados por los puntos x;,

DISTANCIAS ESTADISTICAS

297

xj de Rp, es una medida simétrica no negativa ^S Cx,,x^) que dependerá de Q.

Análogamente la distancia entre dos poblaciones será una medida de divergencia ^S (8,,Q2) entre los parámetros que las caracterizan. También puede

ser conveniente introducir una distancia c^ (x;,Q) entre un individuo i y las

parámetros 8.

Se pueden definir también distancias no paramétricas que miden la

divergencia funcional entre funciones de densidad. En .algunos casos están

relacionadas con medidas de entropia.

Tanto en el caso a) como en el b^, en muchas aplicaciones interesa

representar el conjunto S1 con la distancia ^, es decir, (S2, ^), mediante un

espacio geométrico modelo (V,d), donde V es un conjunto geométrico

(espacio euclídeo, variedad de Riemann, grafo, curva, etc.) y d es una

distancia sobre V. Según la técnica de representación utilizada ( análisis de

componentes principales, análisis de coordenadas principales, análisis de

proximidades, análisis de correspondencias, anélisis de cluster, etc.), la

distancia d puede ser euclídea, ultramétrica, aditiva, no euclídea, riemaniana, etc.

La tabla 1 contiene un ejemplo de distancia genética entre un conjunto S^

de poblaciones europeas de D. subobscura. Aunque la distancia d no es

ultramétrica ni aditiva, puede representarse aproximadamente mediante un

espacio ultramétrico (figura 3) o un espacio aditivo (figura 8).

1.1. Propiedades generales

Una distancia ^S sobre un conjunto Sl es una aplicación de S^ x S1 en R, tal

que a cada par (i,/1 hace corresponder un número real ^(i,/1 = S;j, cumpliendo algunas de las siguientes propiedades:

P. 1

^S; j > 0

P. 2

^5;; = 0

P. 3

cSi; _ ^;i

P'

^ij ^ ^ik + ajk

^

P. 5

^;j - 0 si y sólo si

i= j

P. 6

^;j < max { a;k, ^;k }

(desigualdad ultramétrica)

P. 7

^;j + ^k, < max { ^;k + ^^, , ó;, + ^^k }

P. 8

^S;j

es euclídea

P. 9

^S;j

es riemanniana

P.10

^;j

es una divergencia

(desigualdad aditiva)

298

ESTADISTICA E:SPA!'^iC7LA

Observaciones:

1) Una distancia debe cumplir por lo menos P.1, P.2, P.3. Cuando sólo

cumple tales propiedades recibe el nombre de disimi/a^idad.

2) P.8 significa que existen dos puntos x; -{x;,, ..., x;,^)', x^ -{x;,, ..., x;m1'

de R^ tales que

{2)

es decir, ^;^ es la distancia euclídea entre los puntos x;, x^. Entonces {S^ , d)

puede representarse mediante el espacio euclídeo {Rm, dy.

3) P.9 significa que {S^ , ^S) puede ser representado mediante una variedad de R iemann { M, dM).

4) P. 6--^ P.8 ---^ P.4.

5) P. 6-^ P. 7---^ P.4.

6y Supongamos que hernos definido una medida de probabilidad ,u s©bre

S2. Entonces P.1 D significa que ^ es una expresión funcional sobre ^c.

Algunas distancias poseen un calificativo propio según las propiedades

que cumplen ( cuadro 1). Todas estas propiedades las hemos referido a

{S^ , a). En algunos casos, como la distancia de Mahalanobis, ^ verifica

directamente las propiedades P.1 a P.4 y P.8 a P.10. Sin embargo, en

general ^S cumple solo aproximadamente algunas de las propiedades expuestas. Se trata entonces de representar {S2 , ó) a través de un modelo

{V,dj, aproximando cS a d, donde ^ cumple con las suficientes propiedades

requeridas. Por ejemplo, si podemos aproximar á a d, siendo d una distancia

ultramétrica, entonces {V,r^ es un espacio ultramétrico y{S2 ,^S) puede ser

representado a través de un dendograma.

CUADRO 1

Calificación de una distancia según sus propiedades.

Disimilaridad: P.1, P.2, P.3

Distancia métrica: P.1, P.2, P.3, P.4, P.5

Distancia ultramétrica: P.1, P.2, P.3, P.6

Distancia euclídea: P.1, P.2, P.3, P.4, P.8

Distancia aditiva: P.1, P.2, P.3, P.7

Divergencia: P.1, P.2, P.1 O

DISTANCIAS ESTA,DISTIC'AS

2.

299

DlSTANCIAS S06RE MATRICES DE DATOS

2.1. Similaridades

Una similaridad s sobre un conjunto S2 con n individuos, es una aplicacidn de Sl x S2 en R verificando las siguientes propiedades:

1}

0 < s;j < 1

2}

s;; = 1

3}

La cantidad s;^ = s(i,^^ es una medida del grado de semejanza entre dos

elementos i,j, en el sentido de que si ambos son muy parecidos entonces s;j

se aproxima 1. EI concepto de similaridad es especialmente utilizado cuando sobre S^ se han introducido p características cualitativas, que se asocian

a otras tantas variables binarias, que toman el valor 0 si la característica

está ausente y el valor 1 si está presente. La matriz de incidencia individuos x características es una matriz X^(x;k), cuyos elementos son ceros y

unos. La similaridad entre dos individuos i,j queda bien descrita a través de

a, b, c, d, siendo

n

a = ^ x. ikx^^k

k= i

b = ^ (1 - xik} xjk

k=1

C - ^ X;k ( 1 - Xjk}

k=1

d = ^ (1 - x;k} (1 - x^k) ^

^ >'

es decir, a es el número de caracteres presentes comunes, b es el número

de caracteres ausentes en i pero presentes en j, etc. Una similaridad s;^ es

entonces una función de a, b, c.

s;; = f( a, b, c)

tal que es creciente en a, decreciente y simétrica en b y c, vale s;^= 0 si

b+c=p, y s;^= 1 si a+d=p.

NumerOSOS autores (Jaccard, 1900; Kulcynski, 19^8; Russell y Rao,

1940; Sorensen, 1948; Sokal y Michener, 1958) han propuesto coeficientes de similaridad verificando tales propiedades:

s;; _

a

a+b+c

(Jaccard)

^QQ

ESTADISTICA ESPA110LA

a

(Russell y Rao}

D

s;;

a+d

(Sokat y Michener}

p

Sin embargo, otros coef^cientes como

a

s;^ '

(KulcZynski}

b+c

cuyo rango es ^O, ^), no las cumplen.

La asociación entre los n elementos de s2 se expresa a través de una

matriz de simiiaridades

S ^

S1 f

S12 ' ' ' Sfn

S21

S?2 ` ` • S2n

...............

(3)

sn2 ... Snn

sn f

A menudo S se puede expresar operando en forma etementai la matriz X.

Por ejemplo, para los coeficientes de Russell-Rao y Sokal-Nlichener, se

tiene, respectiva mente:

S,=(XX')/p

S2 = ^xx' + (J - x) (J - X}'^ / p

En otros casos ( Gower, 1971), la expresión es rnás comp{eja. Por ejemplo,

para el coeficiente de Jaccard, se tiene:

XX'

XX'

^J 3 - ____.__ ♦ ^

P

P

•

[ ^ t.1 - ^^C } (.J - X }' „ (J - X } (.J - X)' i Pk ]

k^ 1

indicando A^, B la matriz cuyos e{ementos son a;^ x b;^ (producto matricial

de Hadamard).

Para pasar de una disimilaridad a.una distancia basta utilizar la fórmula

1 - s;^

(4}

Sin embargo, es más aconsejable utilizar

(5i

3U1

D[STANC'IAS EST.ADISTIC'.AS

En efecto, (5} da lugar a una distancia rnétrica, incluso euclídea, para la

mayor parte de similaridades utilizadas en las aplicaciones (véase el cuadro

2). En general, dada una similaridad cualquiera (no necesariamente comprendida entre O y 1), podemos definir la distancia (Gower, 1966}

^5;; =

_______

s;; + s^^ - 2 s;^

(6)

Si S es una matriz (semi) definida positiva, entonces ^;; es euclídea (ver

sección 4.1 }, y por lo tanto podremos representar (^, ^S) a través del espacio euclídeo (R^, d). En cambio, como se desprende del cuadro 2, pocas

veces la distancia (4) es métrica y en ninguno de los casos presentados es

euclídea.

Sobre los criterios que deben seguirse para elegir el coeficiente de similaridad (que dependerá del tipo de datos y el peso que se desea dar a las

frecuencias a, b, c, d) véase Legendre y Legendre (1979), Gower y Legendre (1986).

CUADRO 2

Propiedades de algunos coeficientes de similaridad para variables binarias.

SIMILARIDAD

AUTOR

RANGO

$ ^ ^

K ulczyns k y

O, ^

Sí

a

a+b+c+d

R usse ll y R ao

0,1

a

a+b+c

Jaccar d

a+d

a+b+c+d

METRICA

EUCLIDEA

Sí

Sí (Sí)

Sí

0,1

Sí

Sí (Sí)

Sí

S o k a l y Michener

0,1

Sí

S í 1 S i^

Sí

a

a+2 (b+c)

A n derberg

0,1

Sí

S í( S í)

Sí

a+d

a+2 (b+c)+d

R ogers y Tanimoto

0,1

Sí

S í( S ii

Sí

S orens en

0 ,1

Sí

S í( N o 1

Sí

a

b+c

a

a+2 (b+c)+d

^ (Siguel

(1 ^

S^ 0 significa que la matriz de similaridades es (semi) definida positiva.

(2) La propiedad métrica se refiere a la distancia d;i= ^s;;+s^^-2S;1 y a la distancia

d;^ = 1 -s;^ ( entre paréntesis).

(3)

Ninguna de las distancias d;; es euclídea.

^sr,At^isr^cA t-^sr^,^^vc^^.^

30?

CUADRO 2

/Final)

Propiedades de algunos coeficientes de similaridad para variables binarias.

AUTOR

SIMILARIDAD

a+d

RANt30

S^ ^ METRICA

EUCLfDEA

Sneath y Soka/

0,1

No

S í( N o)

No

Harman

-1,1

Sí

Sí (Si1

Sí

a )

^( a+b

a + a+c

Ku/cryns kr

0,1

Na

N o( N o)

No

, ( a + a + °r + °^ )

` a+b

a+c

c+d 6+d

Anderberg

0,1

No

No (No)

No

a

--.

r

^ (a+b) (a+c)

Ochiai

0,1

Sí

Sí (No)

Sí

0,1

Sí

Sí (No)

Sí

Pearson

-1,1

Sí

Sí (No)

Sí

Yu/e

-1,1

No

No (No)

No

a+^ (b+c)+d

a- (b+c^ +d

a+b+c+d

ad

^ (a+b) ( a+c) (b+d) (c+d)

ad-bc

ti (a+b) (a+c) (b+d) (c+d)

ad-bc

ad+bc

(1 )

S^ O significa que la matriz de similaridades es (semi^ definida positiva.

(2) La propiedad métrica se refiere a la distancia d;l=

d;i = 1 - s;r lentre paréntesis).

(3)

Ninguna de las distancias

s;;+s^^-2s;^ y a fa distancia

d;^ es eucl(dea.

2.2. Distancias sobre datos cuantitativos

Supongamos que los valores observados para p variables aleatorias sobre n individuos, son cuantitativos, formando una matriz de datos

X11

X12 ' ' ' X1P

X21

X22 . . . X2P

(7)

Xn l

Xn2 ' ' ' XnP

303

DISTANC{AS ESTr1DISTIC'AS

Entonces cada individuo i puede representarse como un punto x; E RP. La

distancia más familiar entre dos individuos í,j es la distancia euclídea (2),

es decir,

__.___

p

d2 (i, jy _

^ (X^k _ X^k)2

($}

k=1

Tal distancia es un caso particular de las distancias de Minkowski

dQ ^^.^ ! = ( ^ ^ %'^ik + xjk

k=1

^ <Q^ ^

(9)

que verifican P.1, P.2, P.3 y P.4. No son distancias euclideas, salvo el caso

q= 2. Para q= 1 se tiene

d, (i,jl - ^ ^ X;k

k=1

que se denomina distancia "ciudad". Una expresión límite de 19) es

d^ (i,j) = max { ^ X;k - x^k ( }

Ilamada distancia "dominante"'. Véase la figura 1.

Volviendo de nuevo a la distancia euclídea (8), vemos que tiene algunos

inconvenientes: a) no está acotada; b) no es invariante por cambios de

escala; c) considera la p variables estocásticamente independientes.

Se han propuesto diferentes modificaciones sobre d2(i,j) a fin de evitar

tales inconvenientes. Una prirnera modificación consiste, simplemente, en

dividir por el número de variables, es decir, introducir la distancia (al cuadrado)

c^2 (í,/^ = p^ d2(i,/1

Orloci (1 967) ha propuesto otras transformaciones, que permiten acotar la

distancia, y que en general están basadas en métricas geodésicas sobre la

hiperesfera de radio 1(ver sección 5.4^

E^ST'•1DISTK':^ E^.SP.^tiC)L:A

a

b

C

X1

Fig.1. Distancias de Minkowski en dimensión p=2, Distancia euclídea d2=c. Distancia '"ciudad"': d^ = a+ ó. Distancia " dominante": d^, = a.

La invarianza por cambios de escala se resuelve dividiendo cada término

{x;k - x^uk) por la desviación típica de !a variable k, lo que nos Ileva a la

distancia de K. Pearson {sección 3.1 }. EI inconveniente c) puede resolverse

introduciendo 1a distancia de Mahalanobis {sección 3.2) que tiene en cuenta las correlaciones entre !as variables, y por tanto la redundancia existente

entre las mismas.

Otras variantes de {9) son la métrica de Canberra

P

E

K=1

`x^k-x^k ^

I x^k ^+ I x^k ^

que ha sido utilizada por Lance y Williams {1967), y el coeficiente de

divergencia {Clark, 1952).

{

P k^ ^

xik

xjk \2

xik + xjk

Las propiedades métricas y euclídeas de estas y otras distancias para

matrices de datos positivos, se consideran en el cuadro 3. Sobre los criterios que deben seguirse para la elección de la distancia, véase Legendre y

Legendre (1 979), Gower y Legendre (1 986), y Legendre, Dallot y Legendre

{ 1985). En este último trabajo, las distancias son clasificadas en tres tipos,

según el peso que se quiera dar a las diferencias entre variables con

diferentes rangos de variación {suponiendo variables dimensionalmente homogéneas y no negativas).

3p5

f)IST.Ati('IA5 ESTAU{STI('AS

CUADR03

Distancias y disimilaridades para datos cuantitativos (no negativos)

n

^

( E (x

ikX

- /k

METRICA

EUCLi[^EA

Euclides

S1

SI

Minkowski

SI

NO

K. Pearson

SI

SI

Canberra

SI

NO

Clark

SI

SI

AUTOR

DISTANCIA

2 ^ 1/2

k=1

n

q 1/q

^ ^ {xik - Xjkl ^

k=1

X^k _ x^k ^ 2 ^ 1 /2

Sk

n

^ X^k - Xjk (

E

k ^( xík ^+ I Xjk

^Xik ' X^k)2

1 /2

^X;k

3.

DISTANCIA DE MAHALAN4BIS

3.1. Distancia euclídea normalizada

Dada una matriz de datos X en los términos de la sección 2.2, la

distancia euclídea normalizada K(i,j) es la raíz cuadrada de

..

p

K 2 (i,^ ) = ^

(X;k - xjk)2

k^ r

donde ak es la varianza de la variable k. La distancia K(%j^ es invariante por

cambios de escala y es una distancia entre individuos relacionada con el

coeficiente de semejanza racial introducido por K. Pearson ( 1 926), que ha

sido utilizado en antropología para diferenciar cráneos. Dadas dos poblaciones representadas por (,u,, ^) y(^CZ, ^), donde ^C^c,, ^c2 son los vectores de

medias y^ es la rnatriz de covarianzas ( común) en reCación a p variables

aleatorias, el coeficiente de semejanza racial, también Ilarnada distancia de

K. Pearson, es proporcional a

_ (^^ ' ^2)^ [diag (^y ]^' (^.tl - ,u2)

11 ^ )

EST4[)ISTK'4 ESPAtiOL.4

K es también invariante por cambios de escala y puede considerarse un

precedente de la distancia de Mahalanobis (14). Ambas distancias han sido

comparadas por diversos autores. Véase Mardia (1977).

3.2. Definición y propiedades de la distancia de Mahalanobis

Supongamos que una poblacián S2 está caracterizada por p variables

aleatorias, siendo ^c =(µ,, ..., icp}' el vector de medias y^ la matriz de

covarianzas no singular. La distancia de Mahalanobis M(i,j) entre dos individuos i,j, representados por Ios vectores x;, x^, se define como

M 2 (i, j }

(x;-x;}'^-'(x;-x;)

(12}

Análagamente, !a distancia entre un individuo i y la población S2 es

M ^ ( i, S^ } _ (x; - ,u )' ^-' (x; - ,u )

(13 }

La distancia entre dos poblaciones 52,, S^2 es

M2 (^'^ ^2^ _ (^' ' l^2)^ ^-r (^f

" lu2)

(1 4)

Desde luego, estrictamente la distancia es M(i,j), M(i, S2} y M(5^,, 522)

aunque es preferible manejarla elevada al cuadrado. La distancia (14) fue

introducida por Mahalanobis ( 1936), alegando criterios heurísticos. Sin

embargo, aparece de forma natural por diferentes caminos, como comentamos seguidamente.

a) Sea E = c X,, ..., XP > e! espacio vectorial generado por p variables

aleatorias. Sea ^!a matriz de covarianzas no singular. Considerando E*,

espacio dual de E, a cada individuo i de S^ le podemos hacer corresponder

la forma lineal i* de E* tal que i*(^C) = X (i}, donde ^C E E. Luego, a través de

las variables X,, ..., Xp podemos proyectar S2 en E*. Entonces, como la

métrica natural en E* viene dada por la matriz inversa E-' la distancia en E*,

es decir, la distancia entre individuos, es M(i,j}.

b)

La función de densidad normal multivariante Np (µ,^} es

f(x) _ ^ 2 n ^ ^"^

exp {-2 (x _ ^)^ ^-^ (x_ ^} }

es decir, es una funcián exponencial de la distancia de Mahalanobis entre x

y^c. Obsérvese que la distribución de esta distancia es ji-cuadrado.

e) Consideremos g poblaciones 5^,, ..., 5^9, g > 2. Supongamos asociada

a cada población S2; una distribución NP {,u;, ^) y que sabre un individuo

DISTA^IC'I,AS E^STADIS-TfCAS

^a^

^.v tenemos la inforrnación multivariante x. En análisis discriminante es

conocida la regla de la máxima verosirnilitud para asignar cv a 5^^, donde

j E { 1,...,g ^. Es fácil demostrar que esta regla es equivalente a asignar cv a

fa población S^^ tal que la distancia de Mahalanobis M(cv , S2^) es mínima

IMardia et al, 1979}.

d1 Consideremos el modelo estadístico Np(^c , E) de !as distribuciones

normales, con ^ fijo, iC ^ Rp. Dotando al espacio paramétrico Rp de estructura de variedad riemanniana entonces fa distancia de Mahalanobis

M(^c,, ,u2} es una distancia geodésica entre dos puntos de la variedad (sección 5.4}.

Por otra parte, la distancia de Mahalanobis goza de interesantes propiedades, que vamos a comentar para fa versián (12).

1^

M (i, j )> 0 y M(i, j)= 0 si y sólo si x; = x^ .

2}

M (i,j} = M ^j,i) .

3)

M (i,j) < M (i,k) + M ^j,k) .

4) M(í,j} es invariante por transformaciones lineales no singulares de

{as variables. En particular, es invariante por cambios de escala.

5) lntroduciendo el cambio de variable y =^-^ x, es fácil ver que la

distancia de Mahalanobis es euclídea.

6} Es una distancia normalizada, que puede expresarse en unidades de

desviación típica. Además, tiene en cuenta las carrelaciones entre las variables, es decir, la redundancia entre las variables.

7} Indiquemos por Mp la distancia basada en p variables y por M^ la

distancia basada en p+q variabfes, conteniendo estas p+q a las p primeras.

Entonces

MP ^ MP♦a

8j Sean Mp, MQ las distancias tomando las variables X=(X,, ..., Xp)

Y=(Y,, ..., YQ). Supongamos que las variables X están incorrefacionadas

con las variables Y. Entonces

2

MP+Q

= Mp2 + MQ2

Las propiedades 7j y 8) se ilustran en la figura 2, en la que puede

apreciarse que la distancia de Mahalanobis es mayor para dos variables

que para una sola, disminuyendo a medida que aumenta la correfación

entre las variables.

ESTADlSTiC^A ESPA*^l(^LA

`

^^

^

Fig. 2.

^

.^^

^^

^

i

.^^

^

i

^^

^

Distancia de Mahalanobis en el caso de variables incorrelacionadas y de variables

correlacionadas. Obsérvese que M> M' > a.

Es de esperar, por otra parte, que en las aplicaciones la distancia sea

estable

Lim M p = a < ^

p -^ °b

es decir, si el número de variables p es grande, la distancia de Mahalanobis

no aumentará o al menos tenderá a un valor finito a, debido a que las

variables añadidas serán redundantes respecto a las p anteriores.

3.3, Distancias singulares

Supongamos ran E= r c p y que ^, -,u2 es combinación lineal de las

columnas de E. Se define la distancia de Mahalanobis singular entre las

poblaciones de vectores de medias ^c,, µ2 y matriz de covarianzas ^ como

M2 = (^, - 1^2^^ ^ (l^ ^ - ^2^

donde ^ - es una g-inversa de ^. La distancia singular tiene aplicaciones a

la genética (sección 7.^2), al análisis factorial y a la comparación de curvas

de crecimiento. Véase Rao { 19541 y Mardia { 1977^.

DISTAN('IAS ES7ADISTIC^AS

4.

^oy

DISTANCIAS EUCLIDEAS, ULTRAMETRICAS Y ADITIVAS

4.1. Caracterización de una distancia como distancia euclídea

Las distancias de K. Pearson, Mahalanobis y Minkowski para q=2, son

euclídeas por propia definición. Sin embargo, en otros casos, la decisión

sobre si la distancia S definida en un conjunto S2 es euclídea o no, no puede

tomarse tan directamente. Es entonces cuando adquiere importancia fundamental el teorema 1, puesto que nos permite representar (,51, ^) a través

de un espacio euclídeo (Rm, d).

Sea S2 un conjunto formado por n elementos y sea ^;^= cS (i,j) una distancia sobre S2. Diremos que la matriz de distancias 1^ _{^;^Í es euclídea

m-dimensional si existen n puntos x,,x2,...,x„ se un espacio euclídeo Rm tales

que

^S? _ (x; - x;)' (x; - x;)

(15)

En otras palabras, d es euclídea si existe una matriz de datos X cuyas filas

SOnX;,X2, ...,X^

xr1

xr2

.

.

xl m

x21

x22 • ' •

^ x2 m

X=

..................

xnr

xn2

(16)

xn m

Verificándose

m

2 _ ^ /x^k _ X,k) 2

k=1 t

Consideremos ahora la matriz identidad In, la matriz Jn de orden n x n

cuyos elementos son todos iguales a 1, la matriz

H=1-^J

n

n n

y la m atriz A = (a. ^^^), siendo a ^^_^ _ - 1^2^

2 , ^ , pa ra i,I'= 1,2,...,n. Sea ta m bién

B=HAH

(17y

Obsérvese que !os elementos de la matriz B=(b;^) verifican

- a^ + a

E:STAF)15T1('4 E.SPAtiC^LA

siendo a, , a` las medias de la fila i y de la columna j respectivamente, y a la

media de los n2 elementos de A.

Teorema 1

La matriz de distancias !^ es euclídea m-dimensional si y sólo si B es

semidefinida positiva de rango m.

Demostración: Véase Seber { 1984),

Si B es semidefinida positiva y de rango m, entonces existe una matriz

X(n x m) ta I qu e

B=XX'

(18}

Cua^quier matriz X cumpliendo ( 1 $), puede tomarse como matriz de datos,

es decir, tal que sus filas contengan las coordenadas de los puntos de Rm

cuyas intradistancias reproduzcan d .

Este importante resultado fue primeramente obtenido por Schoenberg

(1935), fecha en verdad tardia tratándose de una propiedad fundamental

de la geometría euclídea. Cuanda X proviene de la descomposición espectral de B, se obtiene la solución del anáiisis de proximidades {"metric

multidimensional scaling"), utilizada por Torgerson (1958) en psicología, y

replanteada con mayor claridad por Gower { 1966), con el nombre de

análisis de coordenadas principales. Desde entonces ha sido ampliamente

utilizada también en ecología, botánica, etc. Gower ( 1982) propone y discute ciertas generalizaciones del Teorema 1.

Sea ahora S una matriz de similaridad t semi) definida positiva. Luego

S= X)G' para alguna matriz X(n x mi y por tanto s;^ = x,.' x^, donde x; ,..., x^

representan las filas de X. Entonces, tomando la distancia c^;^ definida por S,

como

(19j

resulta que r^;^ es una distancia euclídea. En consecuencia, para conseguir

una representación euclídea de S^ de modo que la proximidad entre puntos

sea el equivalente geométrico de la similaridad entre individuos, es preferible utilizar (5) ó(6) en vez de (4).

Supongamos ahora que la matriz de distancias t^^ no es euclídea. Entonces B tiene valores propios negativos, no existe ninguna matriz X verificando { 1$) y por lo tanto S2 no puede representarse en un espacio euclídeo.

Este problema se presenta con frecuencia en psicología. Para solventarlo,

se debe aproximar f a una distancia euciídea d, a fin de que {S^ , rSi admita

DISTANCIAS ESTAC^IST 1CAS

3l 1

una representación euclídea aproximada. Después de los trabajos de

Shepard (1962 a,b) y Kruskal (1964 a,b), quedó establecido que h debía

transformarse en d= f(ó), donde f es una función monótona no decreciente,

a fin de que se conservara la preordenación de las d^stancias originales, es

decir,

y ^ ^jl

(20)

Las transformaciones pueden ser algebraicas o numéricas. Entre las primeras, las más sencillas son (suponiendo i^ j) :

d;^=^;;+c

{Cooper, 1972; Cailliez, 1983) ,

cf^^ = c^? - 2 a

{Lingoes, 1971; Mardia, 1978) ,

d;^=a^;^+b

(Cuadras y Ruiz-Rivas, 1980) .

Se demuestra que si ^;; no es euclídea, existen constantes adecuadas a,

b, c tales que d;^ es una distancia euclídea. Respecto a las segundas, existe

abundante literatura sobre el tema de transformar, por procedímientos

numéricos, una distancia no euclídea en euclídea. Véase De Leeuw y Heiser

(1982), Cuadras etal. (1985).

4.2. Distancias ultramétricas

En esta sección estudiamos la propiedad

P.6

^;^ < max { ó;k, ^^k }

d i, j, k

asi como sus principales consecuencias. Cuando se cumple P.6 se dice que

(S2,ó) es un espacio ultramétrico. Sin embargo, dificilmente una distancia

calculada a partir de unos datos estadísticos, cumplirá una propiedad tan

restrictiva como la desigualdad ultramétrica. En realidad, se trata de aproximar rS a una ultrarnétrica ^,,, y representar aproximadamente (S^,ó) a través

de un espacio ultramétrico, en el sentido de la sección 1.

EI axioma ultramétrico para una distancia fue introducido por primera vez

por M. Krassner en 1930, en ciertas investigaciones de la teoría de números y series formales, demostrando que ciertas distancias, como la distancia p-ádica entre números enteros y la distancia entre los rangos de dos

series, cumplían la propiedad ultramétrica. Posteriormente Benzecri (1965 ^ ,

Jardine, Jardine y Sibson (1967) y Johnson (1967), establecieron la relación entre distancia ultramétrica y jerarquia indexada. Desde entonces, las

E ST ^1[)I^si I(^:^ E.tiE'.^ti(1[_ ^

distancias con la propiedad P.6 juegan un papel fundamental en análisis de

datos.

Supongamos que (S2,í^} es un espacio ultramétrico. Es bien conocido

(Jonhson, 1967; Benzecri, 1976}, que puede asociarse a S^ una jerarquia

indexada (C,a} donde C es una colección de subconjuntos ("clusters"} de

S^, a es un índice sabre C, unívocamente determinado por 1a distancia

ultrarnétrica a, con ciertas propiedades de monotonía. La idea principal es

que en un espacio ultrarnétrico, la nación de proximidad entre dos individuos, en el sentido de que su distancia es inferior a un valor x> O dado,

define una relación de equivalencia en S^ y por tanto una partición de S^. Es

decir, la relación i^^ si .y sólo si S;^^ ^ x, es de equivalencia y define una

partición ("clustering") de S^ para cada nivel x. Aumentando x se obtiene

particiones progresivamente menos finas, que engloban a las anteriores,

formando una estructura jerár+quica. La representación geométrica de (S2,c^)

se Ileva a cabo a través de un dendograma, que refleja métrica (a través de

a) y jerarquicamente la estructura de S^ (figura 3).

La aplicación de estos canceptos para resalver problemas de clasificación, taxonomía y sistemática, es bien conocida (Jardine y Sibson, 1971;

Sneath y Sokal, 1 973; Benzecri, 1 976; Cuadras, 1 981 }. Por otra parte, es

bastante frecuente en las aplicaciones, la doble representación de {S^,d 1,

bien a través de un espacio euclídeo, bien a través de un espacio ultramétrico (véase, por ejemplo, Escarré, 1972; Canton y Sancho, 1976,

D'Andrade et a/., 1972; Rapoport y Fillenbaum, 1972; Del Castilla, 1986)

hasta el punto de que la relación entre ambas representaciones ha interesado a los estadísticos.

La pre+gunta básica es la siguiente: ^ cuál es la conexión que existe entre

la representación a lo largo de unos ejes de coardenadas y a través de un

dendograma?. Un primer paso sobre este tema fue dado por Holman

{ 1 972), que demostró el siguiente:

Tec^rema 2

Si 1^,ó) es un espacio ultramétrico, S2 tiene n elementos y^;^ ^ 0 para

todo i ^ j, entonces la matriz de distancias tS =(ó;;) es euclídea (n-1 }dimensional.

De este resultada, que habría sido conjeturado por Gower (1 971), se han

dado diferentes demostraciones: Gower y Bandfield { 197 5), Caifliez y

Pagés { 1976}, Cuadras y Carmona { 1 983}. Otros autores han relacionado

ambas clases de representaciones. Ohsumi y Nakamura (1 981) estudian la

relación entre la formación de '"clusters" y I^s valores propias de la matriz

asociada a a{teorema 1}. Carroll (1 976) introduce estructuras de árbol

n^s^r;^^c^i,^^ ^sr:^^^sTic^,^^

313

como modelos intermedios entre los modelos espaciales y el esquema de

representación jerárquico, describiendo un algoritmo para ajustar una estructura de árbol a(S2,^S). Por otra parte, Pruzansky et a/. (1 982) estudian y

comparan representaciones en el plano euclídeo y a través de un árbol

aditivo (ver sección siguiente), proponiendo índices y criterios de ajuste

para decidir el modelo más aprapiado.

Por lo demás, no parece fácil interpretar e1 teorema 2. Holman (1972)

observa que mientras un conjunto finito en el que hay definida una distancia ultramétrica, puede representarse integramente en el piano mediante un

dendograma, la dimensión exacta en una representación euclídea vale

exactamente ( n-1 }, luego parece estar reñida con una reducción de la

dimensión, es decir, con una representación tomando ( por ejemplo), los 2

primeros ejes principales. Sin embargo, Critchley ( 1985) demuestra que

una distancia ultramétrica puede Ilegar a estar arbitrariamente próxima a

una distancia euclídea m-dimensional, incluyendo m=1.

Cuadras ( 19$3), Cuadras y Oller ( 1 987) discuten este problema analizando las coordenadas euclídeas X(n x(n-1) ) que verifican ( 1$), obtenidas por

descompasición espectral de B, es decir, las coordenadas principales asociadas a una matriz de distancias ultramétricas 0. La estructura de los

vectores propios de B está relacionada con la formació

'"' ^ " Y

algunos valor^es propios pueden obtenerse explicitamente.

Existe una partición

^ _ ^ , ^- . . . -^- ^ C r -f- ^ r+ 1 -f- . . . -^- S^ k

(21)

tal que cada 5^;, 1< i< r, contiene n; > 1 elementos, mientras que cada

5^;, r< i< k, contiene n;=1 elementos, siendo

k

t) = ^ /Z;

i-1

el número de elementos de S^. La partición ( 21) está formada por r"clusters'" maximales de elementos equidistantes y (n-r) elementos aislados

(pudiendo verificarse r> 1 y r^k). Si h, < ...< h, son las distancias (comunes) en 5^,, ..., S^r respectivamente, entonces

^ , = 1 h; < . . . < ^,, -- 1 h?

2

2

son vaiores propios de B y cada ^.; tiene multiplicidad (n;-1). Además ^., es

el menor va{or propio de B. Por otra parte, la matriz de coordenadas

principales puede ser arreglada en la forma

X = (Xa, X,, . . ., Xr^

314

ESTA[71ST1C'A E^SPAti()LA

donde X, tn x( n,-1 }} contiene las coordenadas principales asociadas a^.;

que discriminan solamente los objetos contenidos en 5^;, siendo 1< r< r.

Las demés coordenadas principales ubicadas en Xa permiten representar, a

lo largo de (k-1 } dimensiones, los "clusters"" que constituyen la partición

(21 }. Luego, la dimensión (n-1 } necesaria según el teorema de Holman,

puede quedar reducida a(k-1 }. Otra consecuencia es que la utilización de

los dos primeros ejes principales tasociados a los dos primeros valores

propios de B}, puede ser inadecuada puesto que, en ciertos casos, podrían

no discrirninar adecuadamente los diferentes "ciusters" de S^ .

Ejemplo: Cansideremos el conjunto ^={ 1, ..., 7} y la matriz de distancias

ultramétricas sobre S^ .

O

1

0

2

2

0

2

2

1

0

4

4

4

4

0

4

4

4

4

4

0

5

5

5

5

5

5

O

Los valores propios de la matriz B asociada a 0 son

,^, = 21 ^.2 = 1 6,43

^.3 = 3, 5 ^.4 = ^.5 = ^.^

2

La figura 4 contiene ta representación de ta distancia a través de un

dendograma. La partición (21 } es en este caso

^ ={ 1 .2} + { 3 , 4 } + {5,6} + { 7 }

Las figuras 5,6,7, contienen las representaciones euclídeas a lo targo de los

diferentes ejes principates. Obsérvese que ta representación tradicional tomando tos dos primeros ejes principales (figura 5}, coloca tos elementos 1

a 4 en el mismo punto. Sin embargo, tomando los ejes primero y tercero,

conseguimos discriminar et "cluster" { 1,2 } del { 3,4 }, es decir, la figura 6

refleja ta partición anterior. Por otra parte, los elementos dentro de los

"clusters" { 1,2 }, { 3,4 }, { 5,6 }, quedan diferenciados a la largo de los ejes

cuarto, quinta y sexto (figura 7).

D1ST.AtiC`IAS ESTADISTIC',^S

31 5

^^

0.

322

^- 0 . 083

0.0

G

Z

V

Dr

Fig. 3.- Representacián mediante un dendograma (distancia ultramétrical de las poblaciones

cuya matriz de distancias genéticas viene dada en la tabla 1.

Figura 4

5

4

r

.,

i

^

^

I

I

I

1

1

2

3

4

5

6

7

3

1

J o

3 i fi

FSTADfSTIC'A ESPAtiC)[..A

Figura 5

5 x 6

^ 4

2 3

?

X

^isT^>tici:^s ^s^r:^^^is-ric.^as

317

Figura 6

a3

1 X 2

6

5

?

3 x 4

Figu ra 7

5

4

1

6

2

3

1

2

5

[^^..1 ! !^ ^^I.? 1 Il.. !^`

C^.'...7f

r^ ^Yl.^^_...'^

4.3. Distancias aditivas

Una distancia ^,^ es aditiva si verifica la desigualdad aditiva (también

Ilamada axioma de los cuatro puntos)

P. 7

^,^ + c^k, ^ max {^,^. +^5^, ,^,, + b^k }

b i, j, k, l

Cuando se cumple P.? diremos que (S^,d) es un espacio aditivo. De hecho,

una distancia estadística no cumpliré, en general, la desigualdad aditiva,

sino que se trata de aproximar ^ a una distancia aditiva ^58, a fin de poder

aproximar (5^,^5) a través de un espacio aditivo, en el sentido de la sección1.

EI interés por ^a desigualdad aditiva surge al considerar la desigualdad

ultramétrica como demasiado restrictiva para ajustarle una distancia estadística. Se puede probar la siguiente implicación entre las desigualdades

P.4, P.6, P.7;

ultramétrica -^ aditiva -^ triangular

Por lo tanto, un espacio ultramétrico es un caso particular de un espacio

aditivo. Si S^ es un conjunto finito y^ es una distancia métrica no se

conace ninguna forma de representación de (S^,ó) a través de una estructura geométrica conocida. Pero si ó es ultrarnétrica entonces la representación puede hacerse en forma de dendograma. Y si ó es aditiva, S^ puede

representarse a través de los extremos de un grafo simplemente conexo,

tomando como distancia la longitud del camino que 1os une. Esta es la

llamada representación a través de un árbol aditivo 4figura 8).

V

Fig. 8.- Representación mediante un árbol aditivo Ídistancia aditiva) de las p©blaciones cuya

matriz de distancias genéticas viene dada en la tabla 1.

[)IS^I- ^tiC^I-^S E-:^T -^C)IS-TIí -^^

31y

Buneman ( 1971) demuestra que un espacio (S^,c>) puede representarse a

través de un espacio aditivo si y sólo si ^S verifica la desigualdad aditiva o

axioma de los cuatro puntos. Además, como Waterman et al. (1977)

demuestran esta representación es única. (Jtra formalización de ia representación aditiva ha sido desarrollada por Arcas ^ 1 987).

Un dendograma es un caso particuiar de un árbol aditivo. En efecto, es

un árbo! aditivo con un nodo distinguido ( Ilamado rai^) que es equidistante

de todos los extremos. Como la desigualdad aditiva es más flexible que la

ultramétrica, resulta más fácil ajustar una distancia aditiva a una distancia

estadistica. En otras palabras, en lugar de un dendograma, resulta más

aproximada la representación a través de un árbol aditivo, que usualmente

se realiza en forma paralela.

^as diferencias entre ambos tipos de representación son:

a) En el caso ultramétrico, las n(n-1 )/2 interdistancias entre los individuo^ vienen determinados por al menos (n-1) valores intermedios, mientras

que en el caso aditivo este número se eleva a(2n-3).

b) Una distancia ultramétrica define una jerarquía indexada (C,x), que es

la forma más perfecta de clasificación. La distancia entre indiwiduos del

mismo "cluster" ( distancía intracluster) es siempre menor que la distancia

entre individuos de distinto "" cluster" ( distancia intercluster).

c) Una distancia aditiva no ultramétrica na define ninguna jerarquia

indexada. La distancia intracluster puede superar a la distancia intercluster.

d) Toda distancia ultramétrica es euclídea ( teorema 2). Una distancia

aditiva puede ser no euclídea.

e) En un árbol aditivo no existe un nodo equidistante de los extremos. EI

problema de fijar una raíz (similar a la elección del origen de coordenadas

en una representación espacial) depende del algoritrno de clasificación.

Diferentes raices inducen diferentes jerarquías de particiones o"clusters".

f) ^i mediante algoritmos adecuados ajustamos una distancia ultrarnétrica y una distancia aditiva a una misma distancia estadística, la distorsión

(que puede medirse utili2ando la correlación cofenética) es menor en el

caso aditivo.

^

Un importante resultado es el teorema 3, que permite estudiar y clasificar las distancias aditivas.

ES^T:^DISTIC^:1 F SP:>tiC)L_:^

TEOREMA 3

Si (5^,^) es un espacio aditivo, existe entonces una distancia u{tramétrica

y una funcián ^: Sl --^ R tal que

+ ^(i} + ^(j}

.

(22)

Demostración: Ver Buneman (1971).

De la descomposición (22} podemos obtener tres clases de distancias

aditivas, dando lugar a tres tipos simples de árboles aditivos:

a)

U Itra m étricos:

^^i ^ ^%i

b^

Singulares:

^ ^(ij + ^(j)

En este caso, el árbol aditivo tiene un único nodo interno.

c) Lineales: Si todos los puntos pueden representarse a lo largo de una

línea recta.

Otros tipos de árboles pueden construirse combinando los tres anteriores. Véase Sattah y Tversky (1 977}, Barthelemy y Guénoche (1 988).

Por otra parte, existen diversos algoritmos para ajustar una distancia

aditiva, que presentan díversas ventajas e inconvenientes (Arcas y Cuadras,

1987). E1 más conocido es el ADDTREE, eiaborado por A. Tversky e

implementad© por Corter t 1 982).

Un algoritmo sencillo puede deducirse partiendo de (22). Mediante alguno de los algoritmos de clasificaci+^n jerárquica, ajustemos una distancia

estadística d;i a una ultramétrica u;^ . Sea

Ajustemos seguidamente y;j a un modelo lineal de la forma a; + ai por el

criterio de los mínimos cuadrados. Entonces es fácil ver que

G^; _ ^ (2/^-2)

..

n

.^ (d;k-U;i} - ^ (dik

k^j

k=l

..

..

-u;kl ] l 2 Cn -2} ^%^!- ^ )

De este modo, ^;i ^ u;^^ + a; + ai es una distancia aditiva que se ajusta a d;i .

f)ISTA,1(^IAS EST,ADISTIC^AS

5.

DiSTANCIA DE RAO

En esta sección iniciamos el estudio de las distancias estadísticas definidas sobre distribuciones de probabilidad, en el sentido del apartado b^ de la

sección 1. A causa de sus interesantes propiedades y su conexión con

otras distancias, empezaremos comentando una distancia introducida p©r

Rao (^ 945) y estucliada por Atkinson y Mitchell (1981), Burbea y Rao

(1982a,b}, Oller y Cuadras { 1982a, 1985), Oller (1987), Amari (1985),

Cuadras et al. (1 985), Burbea (19$6i, Mitchell (1988}.

5.1. Definición y propiedades generales

Sea S=^ p(X,^) } un modelo estadístico, donde X es un vector aleatorio,

f^ _(D,, ..., f^„) es un parámetro n-dimensional, p(X,Q) es una función de

densidad de probabilidad de X parametrizada por ^. Podernos considerar

que ^ pertenece a una variedad diferenciable O y tomar la matriz de

información de Fisher

G=E{[

a

a8

^09 p(X;f^l ] ^

a

aa

^09 p(X;©? ]' }

como tensor métrico fundamental sobre O. I ndicando G=

elemento del arco (al cuadrado) es

ds2(©)= ^ g;;(©) df^;d8^

;,;- ^

Debido a que G se comporta como un tensor covariante simétrico de

segundo orden para todo ^, resulta que ^25) es invariante por transformaciones adrnisibles de los parámetros. Fijando entonces dos puntos eA , 8^ de

O, y una curva paramétrica ©_ ^(t), tA < t^ tB, con 8(tA) _©a, e{tB1= BB, !a

distancia entre ambos a lo largo de la curva es

tB ds (fI)

`A

tB

.

n

dt =

[ ^ 9;;(©) 0;

tA ^,;_^

fl t

' ^2 d t

(26)

donde 0; significa la derivada respecto t. La distancia geodésica entre dA y

f)B es la distancia a lo largo de una curva geodésica, es decir, a l0 larga de

una curva tal que (26) sea mínima. La curva geodésica se obtiene resolviendo la ecuaciór^ de Euger-Lagrange

n

•

n

.

.

^ g;h E^; +.^

r;;,, r^ ;^;= o

^,^_ ^

^^ ^

h

E51 .^i)IS1It`A E^^'^^`(:)l A

^^^

con ias condiciones de contorno f>(tA) = f^A, fl {te} = f^B , siendo

r,^n = 2 ^^, 9^n + a^ 9r^^ -^n 9,^ ^

los simbolos de Christoffel de primera clase.

La distancia geodésica R(f/A,f^e} sobre C-^, basada en la matriz de información de Fisher, recibe el nombre de distancia geodésica informacional o

distancia de Rao. Utilizada como distancia entre dos densidades de probabilidad de S goza de las siguientes propiedades:

1} Es invariante por transformaciones admisibles, tanto de 1as variables

como de los parámetros.

2) Si las variables aleatorias contenidas en X son estocasticamente

independientes y con distribucianes uniparamétricas, entances !a distancia

geodésica es euclídea.

3} Se puede relacionar con el contraste de hipótesis y está conectada

con las propiedades asintóticas de ciertas estimadores de parámetros.

La distancia de Rao puede también introducirse relacionándola con ciertas medidas de divergencia ( ver sección siguiente), o par via axiomática,

exigiendo ciertas condiciones generales a una distancia entre distribuciones

de probabilidad ( Cuadras et al., 1985}. Otro camino para introducir esta

distancia consiste en considerar el espacio tangente T^^ definido en cada

punto de la variedad. T„ es un espacio vectorial local, que está generado

por los n vectores ^^ 1 d fl,, i^ 1, ..., n. Todo vector tangente puede ser

representado como una combinación lineal de la base natura! a; = a/ a f^;

n

v -- ^'

v ^ ^;

Consideremos ahora el modelo estadístico S={ p(X,©} } y las n variables

aleatorias

a

a f^;

log p( X, fl}

i= 1 ,...,n

c28y

y supongamos que son linealmente independientes en X para cada valor de

fl. Definimos entonces el espacio vectoriai

T^'^

t^

= C Z^,

., Z n í1

de !as variables aleatorias que son combinación fineal de Z; .

^isT^^^ tic^i.a^ E.s-r^^r^iSTic-.^s

Existe un isomarfismo natural entre Tf, y T^'^. En efecto, basta establecer

la correspondencia

^

a; c--> Z; _

a ^;

log p(X , ^)

129)

según la cual la imagen de (27) será la variable aleatoria

n

vX =i=1^ v^ Z;

Luego podemos identificar T^ con T^'^ y referirnos a T^,'^como la representación en términos de variables aleatorias de T^.

Observando que, bajo ciertas condiciones de regularidad, se verifica

E (Z;)=o i= 1,...,n

el producto escalar natural en Tá'^ es

< UX, VX >= cov (UX, VX) = E(UX. VX)

luego los productos escalares de la base { Z; ^ son

g;;(8)-E (Z;.Z;}

i,j= 1,...,n

que constituyen la matriz de información de Fisher (24). Puesto que hemos

definido un praducto escalar en cada. espacio tangente Ti'^ resulta entonces que hemos dotado a S de una estructura de espacio de Riemann. La

distancia geodésica entre dos puntos de !a variedad se obtiene minimizando (2 6 ).

Con el propósito de estructurar las propiedades intrínsecas de un modelo estadístico, Amari (1985) considera la a-conexión

r^^ _

r;;k

_ r;;k +

1-a

2

T;;k

siendo T;;k el tensor simétrico

T;;k = E ( Z; . Z; . Zk )

Las geodésicas asociadas a un a-conexión son aquellas curvas cuyo

vector tangente se desplaza paralelamente a lo largo de si misma y pueden

considerarse como rectas. Tomando como tensor métrico la matriz de

E_ST^f^^iST^I(.'A E_SP^tif^)l_^^1

infarmación de Fisher, resulta que la O-conexión coincide con la conexión

de Levi-Civita, que es la única que hace compatible la noción afín de

paraielismo con 1a noción métrica de distancia. Las demás conexiones son

menos naturales desde el punto de vista métrico, pero tienen interesantes

interpretaciones estadísticas.

La 1-conexión fue introducida por Efron ^ 19? 5), y tiene una interpretación natural si consideramos la familia exponencial. Para esta familia se

verifica

r(zl _

ij k ^

2

ijk

que es identicamente 0 para a= 1. La familia exponencial constituye un

espacio sin curvatura respecto a la 1-conexión y las geodésicas asociadas

pueden interpretarse como rectas.

La -1 -conexión fue introducida por Dawid (1975). Si consideramos una

mixtura de distribuciones

p (x, f^1 = (1 -^^1 P, ( x) + ^^ Qz {x)

0 ^ fI < 1

entonces

r^i _

r

1 ^ jk -

1 + QC

^

T

1 ijk

que es idénticamente o para a=-1. obtenemos una familia de distribuciones que constituyen un espacio sin curvatura respecto a la -1 -conexión. La

familia puede considerarse como una línea recta conectando dos distribu-

c^ones.

La teoría de las a-conexiones puede aplicarse para estudiar la familia de

distribuciones exponenciales, así como la familia exponencial curvada de

Efron. Véase Amari (1 9$5), Burbea (1986).

La distancia de Rao, es decir, la distancia geodésica en S basada sOI^rF la

rnétrica asociada a(24), ha sido calculada para la mayoría de discr^k^^^ciones univariantes y algunas distribuciones multivariantes. Si en cierta ^ s casos

el cálculo es sencillo, en otros es bastante complejo o no ha sido resuelto

todavía. Por ejemplo, para el sistema uni-paramétrico bivariante propuesto

por Cuadras y Augé (1981 ), en la expresión de la distancia intervienen

diversos desarrollos en serie (Ruiz-Rivas y Cuadras, 1988). La distancia

entre dos normales multivariantes con distinta matriz de covarianzas, todavía no ha sido resuelta, aunque se han intentado algunas aproximaciones al

problema (oller y Cuadras, 1 983, Calvo, 1 988).

ni^^ ^ti<^i.^S F-s^ .^r^i^ 1 ic a^

5.2. Distancias entre distribuciones univariantes

Supongamos que p(x ^ fl) es una función de densidad univariante y uniparamétrica. Es fácil ver que la distancia de Rao entre a,b ^ O viene dada por

R(a , b) _ ^ a y(f^) df^ ^

(30)

A continuación damos las distancias para algunas de estas distribuciones.

a. Binomial.•

p (x ( p) _ { N) ^X { 1 _^)N-X

x

x = 0,1,. . .,N

0 < f^ <

R (a,b) = 2 ti N arcos { ti'ab + ti^ (1 -a) (1 -b) }

b. Poísson:

^X

p(x ^ f^) - e-^'

x- 0,1,2,,.. f^ > 0

x!

R ( a, b) = 2 ^ ti^ - ^^ ^

c. Bínomial negativa ( r fijo):

p(x ^ 8) =

I^ (x + r)

x ! r (r)

f^x (1-f^)'

x= 0,1,2,...

1 - ^ ab

R(a, b) = 2^ cos h-' (

^' (1 -a) (1 -b)

)

d. Gamma (r fi jo)

p(x ^ ^) =

1

x'- ^ e-X^ ^^

I' (r)

x > 0, f^ > 0

R (a, b) _ ^r ^ log (a/b)

e. Weibull ( a f i j o)

p(x ^ f^) = a x^ -' f^ e-X^°

R(a, b) _ ^ log (a / b) ^

x> O,f/> O,a> 0

0< ^< 1

E^ T^1F)IST^IC ,A E tiF' 1tiC)LA

Nótese que, como la distribución de Weibull es la que sigue X"x donde X

es Gamma Cr=1 ), se obtiene un caso particular de la distancia anterior,

pues la distancia de Rao es invariante.

f. Pareto Cr fi j o)

pCx ^ 4} = Q r" x re+ ,a

x> r, ^> o

R( a, b)_(/og^ (a l b} ^

g. Normal N{^c, 42), {^c fi jo)

1

R (a, b) =

v 2

I ^og (a /b i I

h. Normal N C,u, a2) ,(^ fijo)

^a-b ^

R {a, b) _

a

5.3. Distancia entre distribuciones univariantes biparamétricas

Supangamos que ahora O tiene dimensión n=2. Entonces es necesario

calcular la matriz de información de Fisher y proceder como hemos explicado al principio de esta sección, es decir, resolviendo las correspondientes

ecuaciones geodésicas. Las distancias que exponemos seguidamente han

sido obtenidas por A^tkinsan y Mitchell C 1981 ), Burbea y Rao (1982 a,b),

011er C1987).

a. Distribucián normal

La distaneia de Rao entre N(^,, a; ) y N{/c2, o2i, es decir, entre los puntos

C/c,,cr; l, t^c2,a-^), es

^

R C 1, 2 ) _ ,._.. /og

^i2

1+ó(1,2)

1 -^C1 ,2)

siendo

S{ 1,2) _

^^^ - 1^2^2 + 2 ^^>' - a2)2

[

C,u ,-,u 2)

2

+ 2 t Q, + Q2 )

2

^^2

DIST.A^+t'I.AS ES^TAC)ISTIC'AS

b. Distribución de valores extremos de Gumbel

p(x ^ a,f1) _ ^ exp ( -exp

^

tx-a) / a) 1 exp 1- (x-a) / f^)

^>O,x>O,aER

Sea y la constante de Euler. I ndicando a=1-y, b=^c 1^ 6, la distancia

entre los puntos {a,,f^, ) y{a2,El^) es

1 +^{1,2)

R (1, 2 ) = b log

1 -^(1,2)

donde

[ (a2-a^) - a(^2-Or) ]2+b2 {^^-Q^)2 ^^^

[ ( az - a ^ ) - a ( ^z - ^ ^ ) l 2 + b2 ( ^2+ ^, ) 2

c. Distribución de valores extremos de Gauchy-Frechet

p(x ^ ^3,^.) = exp (- (x/^3)-' ^ {x,/j3)-r^ ♦ ^^ í^//(3

^3,^. , x > 0

La distancia entre los puntos (^3,,^,,) y(^32,^,2) es

R(1,2) = 6 . log

1 + ^(1,2)

1 - ó(1,2)

donde

^ l09' (l3z/^^ )+a(^,2-^,,) / í^, í^2]2 + b^(í^2-í^,)Z ^,; ^.2

^S{1,2) _

[ l09 (^2/^^ ) +a(/^^2-í^^,) / /^., /^.2]2 + b2(/^.2+^,,)2 ^.; /^,2

-y, b=^/y6.

d. Dis tribución logís tica

p(x ^a,f3)=

1

4^

sech2(

x-a

2^

1

x,a E R,^3 > 0

.^^^

E^,ty^^f>1^Tf('^^ f^P^^`^i)1 ^>

La distancia entre los puntos (.z,, ^^,) y(x^, j^2) es

R (1,2} =

^, ,6

3

log

1 + ^S (1 , 2 )

1 ` ^3(1 ,2}

donde

(3 /b) (a2 - x, )z + (^2 _ ^^ }z

C^^ 1,2} - C

2

( 3 /b} t ^^ - ^r } + {^z + ^T }

2

b=n2+3.

5.4. D^stancias entre distribuciones multivariantes

La distancia de Rao para diversas distribuciones multivariantes ha sido

estudiada por Bhattacharyya ^ 1946}, Atkinson y IVlitchell { 1981 ^, Burbea y

Rao (1982a,b}, Oller y Cuadras {1982a, 1983, 1985), Ruiz-Rivas y Cuadras (19$8}. Actualmente se intenta encontrar la distancia de Rao para

distribuciones multivariantes en las que ni ,c^ ni ^ están fijos.

a. Multinomíal ( N f i j o}

p(x ^ ^) =

N!

(D,)X^ . . . (E^„}xn

xll...x„I

x,>0 0<

n

n

i-T

r=1

^ x;= N ; ^ f^;= 1

La distancia de Rao entre los puntos {a,, ..., a„), {b,, ..., b„) es

R(1,2 )= 2^' N a rcos { ^ ti^ a b^)

;- ^

es decir, hemos obtenido la distancia de Hellinger-Battacharyya inicialmen

te propuesta por Bhattacharyya (1946) (ver sección 7.2^.

b. Mult^nomia/ negativa (r fijo)

I'(x,+..+x„+r}

{^, )xT. . . (Qn)Xn {^k+T )r

^^ ^X' i^} _

X, ^... X^ ^ r Í r)

nis^r.^:^c^i:^s Esr^^n^sric^^s

3?9

n

n

siendo E f^; < 1, ^> n+l

,- ^

= 1 -^ f),

,> >

La distancia entre ( a,, ..., an, a"+,) Y(b,, .. ., b", bn+,) es

n

^

R(1,2 )= 2 y' r cos h-'

1 - ^ ^ a; b,

,_ ^

^ ak+ 1 bk+ 1

c. Normal multivariante (E fijo)

La distancia de Rao entre Nn(,cc,,E) y Nn(µ2,^), donde ^c^,, I^2 E R" y^

permanece fijo es

R S ^ ^2) _

{ (^^^ _ ^^2)• ^-^ (^1' _ ^12^ } ^^2

es decir, es la conocida distancia de Mahalanobis (1936).

d. Normal multivariante (/^ fi jo )

La distancia entre N" (,uo, ^, ) y N"(,clo, ^2), donde ,uo perrnanece fijo, es

R (1,2)=( ^ ^ l0g2^,.)^^z

,

2 ;,,

donde ^.,, ..., ^," son los valores propios de ^2 respecto de ^,, es decir, ias

soluciones de la ecuación en determínantes

I ^ 2 -^, ^, 1=0

e. Nvrmal multivariante

La distancia entre dos norrnales Nn(,c^,, ^,), Nn(,u2, ^2) es un problerna

todavía no completamente resuelto. Aunque se han podido integrar las

geodésicas, el problema algebraico de determinar las constantes de integración para enlazar dos puntos de la variedad todavía no se ha podido

resolver. Sin embargo, se conoce la solución para algunos casos particulares. Además se ha podido demostrar que existe una isometría entre la

variedad y el grupo Pnt,(R) de todas las matrices definidas positivas de

orden n+ 1, con la métrica

c A, B > = tr(A B')

Considerando entonces que se puede obtener una distancia para una

subvariedad de P"+, (R), se ha conseguido la siguiente cota inferior para la

distancia de Rao

^ ^ c^

E:tir.lvi^rNC-r^ t.sN:^^c^t.;>

d (1 . 2 } _ ( ^ ^ ^ lag? ( ^., }

2 ^- ^

donde ^,,, ..., ^^n, ^.,,+1 son los valores propios de S^ respecto S,, siendo

^i + ^i ^i

i = 1,,2

,

l^;

Véase Burbea (19$fi), Calvo (19$8), Skovgaard (1984}.

5.5. Una distancia intrapobtacional

Supongamos ahora que el vector aleatorio X toma valores en una población S2. La correspondencia (29) permite definir una distancia entre los

individuos de S^ caracterizados por un punto fl de O. En efecto, podemos

caracterizar S^ a través del espacio dual E;,, siendo E f,=T^, el espacio tangente introducido anteriorrnente, haciendo corresponder a cv E S2 la forma

lineal c.^* ^ E^1 tal que cc^* (Z1 = Z(c^), para toda variable aleatoria Z E E^.

Como la métrica en E;, inducida por la métrica en E,,, tiene como matriz

asociada G-' respecto a la base dual de Z,, ..., Zn, podemos definir una

distancia entre individuos

R( cv, , c^2 )= dE^r ( cv ;, cv2 f

( 31 }

donde dE« es una distancia euclídea local.

Por ejemplo, consideremos una población Np(^^;^), con ^ fijo. Entonces E^^

está generada por el vector aleatorio Z=^^' (X - ,c^) y la métrica en E^1 viene

dada por ^-', luego la métrica en E^^ viene dada por E. La distancia (al

cuadrado) entre dos individuos con vafores z, _ ^-' (x, - ^^), z2 = ^^' (x2 - ^c^),

es

(x, -x2 )' ^-1 ^ ^-^ !xl _x2 ) _ (x' _x2 ^• ^-r (X' _x2)

es decir, coincide con la distancia de Mahalanobis 112).

Consideremos ahora n+ 1 sucesas mutuamente excluyentes A,, ..., An,

A„+, de probabilidades p,, ---- Pn- pn+l Y la función de densidad

f(x,, . . ., x„/p,, .

E{o,^},o<,^;<1,

. ., pn ) _ ^ ' . . . ^7^n ( 1

...,n,

C)IS7AtiC'IAS EST.^DIS^TIt^,^1S

es decir, x; = 1 si cv E A; , x; = 0 en caso contrario. Indicando

n

Xn+ 1 - 1 - ^ X;

i-1

n

pn+ ^ _

,-1

el tensor métrico G sobre a={(p,,

b;;

1

+

pi

^ ^ p; < 1 } es

'^ pn

i= l

i, j = 1 ,...,n

Pn+ 1

Con algo de esfuerzo se obtiene entonces que la distancia entre un

individuo cv, que presenta la característica A,, es decir, cv, E A;, y otro

individuo cv2 E A^, es

R (cw,,cv^) _

^ . 1 1

1

+

( 1 - d;;) (

P;

!^;

siendo rS;; la delta de KronPCker. Finalmente, si consideramos k particiones

independientes de S2

A ^;^ , . ., A»'^ , A^^^^

;

,

i = 1, . . ., k

la distancia entre cv, y cv2 tales que

c.^, E A;^^ U... U A;k^

cv2 E A^ ^^ U... U A^k^

viene dada por

k

R (cv,, cv2) _ ^

x- ^

(1 - ^;^;^) (

^µ

1

p^^

+

1

)

(32 )

p^x

siendo p;^ = P(A;x^ ). La distancia (32) puede ser utilizada para diferenciar

individuos de una población conocida la presencia o ausencia de características cualitativas.

6.

DIVERGENCIAS

Las medidas no paramétricas de divergencia entre distribuciones de probabilidad se definen como expresiones funcionales ta menudo relacionadas

con la teoría de la información), que miden el grado de discrepancia entre

3 ^^

F=s-r ^>t^iS^ ic _^ Es[^ ^^c^^_.^

dos distribuciones cuaiesquiera, no necesariamente pertenecientes a una

misma familia paramétrica. aespués de los trabajos pioneros de Pearson

{prueba ji-cuadrado) y Hellinger (la famosa distancia de Hellinger, publicada

en 1909), otros autores han estudiado divergencias {Shannon, Kullbach y

Leibler, Renyi, etc.`. La divergencia aplicada a distribuciones de probabilidad

serían introducidas por Csiszar { 1963, 1967, 1972, 1975), estudiadas en

diferentes versiones por Matusita (1955, 1964), Havrda y Charvat { 1967),

Vajda (1972) y generalizadas por Burbea y Rao (1982 a,b).

^as divergencias tienen aplicaciones en inferencia estadística y en procesos estocásticos. Véase Bishop et al. (1975), Liese y Vajda (1987).

6.1. Distribució^n multinomial

Sea p =(p,, ..., p„} e! vector de probabiiidades correspondiente a una

distribución multinomial. Un funcional ^- entropia es

H¢{p)=^p;¢^(p;)

(33)

donde rp es una función estrictamente convexa tal que q^ (1 ) = 0. H^, es una

función sobre ia clase de distribuciones muftinomiales n-dimensionales que

es máxima cuando los p; son iguales y alcanzan e{ vaior mínimo (cero)

cuando algún p; = 1. H^ mide ei grado de discrepancia con la distribución de

máxima entropía, y ha sido ampliamente utilizada como medida de diversidad.

Sean p= ^p,, ..., p„), q=(q,, ..., q„) dos distribuciones multinomiales. La

divergencia entre p y q se puede medir como !a discrepancia entre el

cociente x; = q; / p; y 1. Basándonos en el significado de (33), definimos una

divergencia entre p y q, ilamada ¢^-divergencia de Csiszar (1 972), como el

valor esperado de x,, ..., x„

C ^ (1^- 4') _ ^ p; ^ ( q, / p;)

(34)

Por la desigualdad de Jensen se tiene

C4(p,q}=^p;^(x;}> ^(^p;x;)=^(1)=0

aicanzándose el vaior 0 si y sólo si p=q. ^34) se puede tomar como una

medida de disimilaridad entre p y q, pero en general no es una distancia,

pues no siempre es simétrica, o si lo es, puede no cumplir la desigualdad

triangular. Sin embargo, tiene dos interesantes propiedades: C^, (p, q} aumenta cuando se considera una partición más fina, y bajo la hipótesis

C,^ (p, q) = 0, e! estadistico

UIST•^ti(^1-15 f ^T^11)ItiTI( .^^^

2N,N2

,,

(N,+Nz) ¢

(1)

„ „

e^, (p . 4')

^^^

(35)

sigue (asintóticamente) la distribución ji-cuadrado con n-1 grados de liber..

^

tad, siendo p,, q, las frecuencias reiativas muestrales para muestras de

tamaños N,, N2 (Takeuchi e^ a/, 1982).

EI cuadro 3 contiene diversas formas de (34) según diferentes expresiones de ^(x), incluyendo, en su caso, la distancia genética que da lugar (ver

sección 7.2). Un caso importante es ¢(x) _-log x. Entonces H^ es la farnosa

entropia de Shannon y(34) es

p (p,q)=^^P,lo9' (p,/q,)

(36)

conocida como medida de información de Kullback-Leibler. (36i mide la

ganancia de información al pasar de la distribución p a la q, y ha sido

utilizada en estadística, especialmente en estadística bayesiana (Bernardo,

1981, 1987). La simetrización de (36)

J^ (p,q) = I^^ (p,q) + I,,(q,p)

es el invariante de Jeffreys, también Ilamada L-divergencia.

Obsérvese que para ^(x) _ ^ 1 -x ^ se obtiene ^ ^ p; - q; j distancia que ha

sido utilizada en genética ( Prevosti, et^ al, 1975). Sin embargo, en este caso

no se puede utilizar (35) porque ^' '(1 ) no existe.

Por otra parte, si consideramos las entropias H,_;(p), H,;(q) y la entropia

correspondiente a la mixtura ^^p +(1 - ^.)q, entonces mediante la diferencia de

Jensen

J,, (p, q) = H r, ( r p + (1 -r.) q) - ^- H,,; (p) - (1 -^ ) H,; (q)

obtenemos una distancia, liamada J-divergencia, entre p y q. Por ejemplo,

utilizando (a entropia de Gini-Simpson

H^(p)= 1 _^pz

se obtiene la distancia

2 ^^ (1 - ^^ ) ^ (p; - q^ ) ^

que ha sido utilizada en genética por Nei (1 971 ). Véase Rao (1982). Tanto

la J-divergencia como la L-divergencia son estudiadas, con más generali-

^ S^t;1O1^^ ^íf( .A E ^Y:^tit)L•^

dad, en la siguiente sección. Por otra parte Pérez et al. (1 986) prueban que

la entropia de Gini-Sampson puede ser estimada (en poblaciones finitas)

más fácilmente que la de Shannon, por lo que recomiendan (a primera para

estimar la diversidad.

CUADR03

Algunas ¢ -divergencias: Ca (p, q) = ^ p; ¢ {q; / p;)

¢ ( x)

NOMBRE

C (p. 4')

- log x

^ p, log(p,/q,)

Kuliback-Leibler

1 - ^ qz' p;z

Havrda-Charvat

2(1 -^; x)

^(ti p; -^, q,i^

Bhattacharyya

^ 1 - x^

^ ^ p; - q, ^

GENETICA

^ ^ - Xx-^)

^

{x _ 1 )^

(x+ 1 )

Cavalli-Sforza

Prevosti

{p` _ ql)2

Balakrishnan-Sanghvi

(p;+q,)

Salicrú y Cuadras (1988) prueban que todo funcional ¢-entropia {33)

puede interpretarse como una medida de Csiszar ( 34) entre p y la distribu-ción de máxima entropia e=(1 1n, ..., 1/n ^ . Por ejemplo, para la entropia

H^,(pj de Havrda-Charvat, en la que

¢ (x) _ ( a - 1 j -' (1 _ x^-' )

tx > 1

se verifica

n

H4 Íp) = Cf (p,e) =^ f{(n p; ^ -' ) p;

,-^

para la función

f (x) ^ (a _ 1)-^ ^^ _ (n X)^-^ ^

^

^

Por otra parte, la rninirnización de C^(p,f), donde f representa el vector de

frecuencias relativa y¢ se eiige adecuadamente, es equivalente a ciertos

procedimientos clásicos en el tratamiento estadístico de datos multinomiales. Por ejemplo, tornando ¢(x) _- ln x haflar la estirnación máximo verosí-

r^^srr^^c^i^^s E^:^r^^^^isric^^^s

^3^

^

mil de p es equivalente a hallar,. p que minimiza C^(p, . Tomando ^(x) _

(x-1 )2, entonces minimizar C^,Íp,f) es equivalente al método de la mínima

ji-cuadrado

n

min ^

P ,_ ^

(f!_ p^}z

=C^, (^f)

p,

/1,

Véase B ishop et al. (19 7 5).

6.2. Distribuciones absolutamente continuas

Sea p(x) una función de densidad de un vector multivariante con distribución absolutamente continua y soporte en ^. Sea ^ una función real, dos

veces derivable, sobre un intervalo T^, tal que [0,1 ]^ T^z,C[o, ^). Se define el

funcional ^ entropia

H^, (p) _ - ^, ^ [p(x) J dx

(38)

La J-divergencia entre dos distribuciones p, q, con respecto H^,,, se define

como la diferencia de Jensen

J^(p,q) = H

^ ( p+q ) - [H ^(p) + H^^ (q)) / 2

2

(39)

La K-divergencia y la L-divergencia se definen como

K^p (p, q) _ ^ (p-ql [^ (p) /p - ^ (q) /q) ] dx

(40)

y (suponiendo T^^, = R+)

L^(p,q) _ ^ [p ^(q/p) + q ^(p/q) ) dx

(41 )

Finalmente, se define la M-divergencia corno

NI^ (p,q) _ ^, (^ ^(p) - ^ ^{q) )2 dx

(42}

Todas estas definiciones pueden ser generalizadas facilmente escribiendo

d,u en vez de dx, donde ^c^ es una medida aditiva rr-finita y X es un espacio

medible Lebesgue.

Las J,K,L,M-divergencias son siempre simétricas. La M-divergencia es no

negativa. Las condiciones para que las demás sean no-negativas son:

t5T ^1[)ISI I(^^^ f^Sf'-1tiO1_->

i ^f^

a) J^^, (p, q} ^i-^ 0 si y sólo si ^U {u) es convexa en T^,.

b) K^I,{p, q) ^ O si y sólo si +^U {u) /u es creciente en T^,.

c) L^i,,p, q) _^ 0 si y sólo si u^U {u ') +^(u) es no negativa en R+.

Para otras propiedades generales, véase Burbea y Rao (1 982 a,b^.

Estudiemos ahora casos particulares de las L-divergencias, en especial

aquellas que están relacionadas con la función

c^x (u} _ (^ - 1 )-' (u^ - u)

a ^ 1,

^43)

-- u log u

a-- 1

En este caso indicaremos Jz, K^, Lz .

1)

Tomando la función

f* (u) = ^ (u) + u ^ (1 /u)

vemos que una L-divergencia coincide con la f* - divergencia de Csiszár

^-^1

U P 9', )=C•(p,

4` )=^,, pf*(p^4')dx

r

2)

t441

Tomando ^=1 en {43) obtenemos

K, (p, qi = L, (p, q^ ) _;^ (p-q) (log p- lc^g q) dx

{45)

que es la divergencia de Jeffreys- Kullback- Leibler, que juega un papel

destacado en inferencia estadística.

3}

Tomando :^=2 en ( 43) obtenemos

J2 (p,q )=2,^, ( P- 9'

)2dx

4)

Para ^(u) = u en ( 42) y tomando la raíz cuadrada obtenemos

M{p ,q}= ^.^, (ti^-ti`

P

q )2dx] '

(4^6)

que es la distancia de Matusita (1955), ampliamente utilizada en inferencia

estadística y teoría de la decisión (Matusita, 1 964}. M(p,q) esta relacionada

con la afinidad entre p y q.

^

^> ( p, q} _^, 1, p ti q dx

.^ ^7

[)Iti^T^^-1ti(^1^15 E;ti^T^•\UI^i I(^^^^

Se verifica

M 2(p. q) = 2^ 1- P(p, q) ^

Para el caso particular de dos distribuciones normales N(i^;,^;) , i=1,2, la

afinidad p(p, q) es

^ ^r ^2

r i4

I (^, + ^2) ^ 2 I

^l2

z

exp[-( ^

^.r^

(^c;-i^c^ ) ' ^^' ( ^;' + ^^' ) ^;' i^; ) ^

Si ^, _ ^2 = ^ entonces

Í , )=exp^

Ppq

5)

-^8 (^-^j'^_r(^-^

^r ^2) ^

^-r ^2

NI (p,q) está relacionada con la distancia de Hellinger

E..^^(f,9,) = I y( frix_ 9,rix)x dx ^

a> 1

(47)

que verifica 0< H,, < 1. Por otra parte, si consideramos el espacio de las

funciones de cuadrado integrable sobre un soporte X, con el producto

escalar

<f,g>=rfgdx

obtenemos un espacio de Hilbert en el que ^' H2 es la distancia entre dos

funciones. Además, para la esfera de radio unidad

E_{ f ^ f=ti p, p es densidad de probabilidad }

entonces M(p,q) = H2(p,q)^ representa la cuerda, mientras que

^

^

B(p,q) = arcos < ti' p, ti' q> = arcos p(p,q)

(48)

representa el arco que une los puntos p,q sobre la esfera E. (48) es una

distancia geodésica sobre E, que en general será rnás pequeña que la

distancia de Rao definida para una clase de densidades p(x,(l), parametrizada por f), y que constituyen una subvariedad S de E. Asimismo, la métrica

diferencial en S inducida por la distancia de M(p,q) da también la distancia

de Rao, como vemos en la sección siguiente. La relación entre las tres

distancias es

M (p,q) < B (p,q) < R (p,q)

i ti[^11)ttiT It ^1 i tiP^1tit)1 A

6.3. M^tricas diferenciales a partir de divergencias

En la sección 5.1. introduciamos una distancia geodésica sobre un modela estadística S={ p(X,fl) }, donde ll E ^, utilizando ei elemento de arco (25)

y la matriz de información de Fisher. De forma análoga, utilízando la métrica diferencial definida por el Hessiano de una divergencia D^(p,q), donde

ptx,f.i) es una família paramétrica, a lo ^argo de una direccián dei espacio

tangente de ^ ,

149^

ds2^ (f^) = c^ { D^, (p, p) } (f^)

pademos construir una geometria riemanniana sobre S. Por e^emplo, para

la J -divergencia tenemos

1/^J^ ^" ()

c^{JmÍ,)}Íf^)=

Pp

Pd

( p(f^)] 2dx

y como

dP(

(^) = E ^p df^^,

,^r ^^.,

podernos tomar el elemento de arco

ds2^ (f^) = 1/4 ^ g^; (H) d(^; d0^

%.r ^

siendo

^, ^ ` (' ^..

{ )

( )

J

9"

^

p

`^p

^ f^;

ap dx

a f) ^-

La matriz (q;^(f^) ) define un tensor covariante, y si ^ es convexa en T^

entonces define una métrica riemanniana sabre O. ^a distancia geodésica

entre (^A y flB es la que minimiza (26).

Se obtienen expresiones análogas para e1 elemento de arco para la K, ^

y M-divergencias, tomando:

^^ ^^^^ = x (^(p)1p]'

^^ (^^) _ f -^

9^,

,^ p

^p

^I f^;

p

9'^^', t ^^) --- ,^ ,^ t (^^

ap

ap

r^ f);

a ()^

dx

(K-divergencia)

(L-divergencia)

ap dx

r? f)^

dp

^P

d (I;

r^ f^^

dx

.

( M -divergencia)

C)ISi^.^1ti('1-15 E.ST.IUIS^T^1(^AS

3^9

Observaciones:

1)

Para la L-divergencia se verifica

g^(f^) = E^,l

a

a^^;

log p (X,f^)

a

aE^;

log p ÍX,f^) )

luego es fácil ver que

ds^ ( f^) = 2^" (1) ds2 ( fl)

Si ^" (1) > 0, la métrica coincide ( salvo una constante) con la métrica

informacional o distancia de Rao. Encontramos un resultado similar para la

distancia de Matusita.

2)

Para la clase de funciones ^^ definidas en (43) se obtiene

g,(; ^( 8) = X p^

a

aa;

log p

a

aa;

log^ p dx

(50)

que da lugar a la métrica informacional de orden a. En este caso, las cuatro

métricas coinciden (salvo constantes). En particular, si a=1, en todos los

casos obtenemos la métrica informacional o distancia de Rao.

3) Las distancias abtenidas son todas invariantes por transformaciones

admisibles de los parámetros. Para ciertas funciones d^ las distancias son

además invariantes frente a transformaciones admisibles de las variables

aleatorias. Por ejemplo, para la K=divergencia se cumple para ^lu) _

au log(u) + bu + c. En realidad se verifica esta propiedad para aquellas funciones ^ tales que (g^; (f^) ) es la matriz de información de Fisher. En efecto

(Cuadras, et al., 1 985; Oller y Cuadras, 1987) la invarianza para las variables es una cualidad que prácticamente sólo se cumple para la distancia de

Rao.

Para más información sobre este tema, véase Burbea y Rao t 1982a,b),

Salicrú ( 1987). La construcción de medidas paramétricas de información

sobre funciones de densidad p(x, f^) a partir de medidas no paramétricas,

había sido planteada de manera análoga por diversos autores ( Kagan, Vajda,

Aggarwal y Boeke). Véase Ferentinos y Papaionnau ( 1981).

3 -^4l

7.

til ^1()f^ [ It •1 F tiF'^^til ^i. ^1

ALGUNAS APLICACIQNES

7.1. Biologia

La aplicación de las distancias estadísticas a la biología, especialmente

antropologia y genética, son muy numerosas. Con la obtención de distancias entre poblaciones, especies, razas geográficas, etc., se han abordado

probiemas de sistemática, fiiogenia y clasificación taxonómica.

Pearson (1 926i utiliza un coeficiente de semejanza raciai para diferenciar razas humanas (ver sección 3.1.}. Pero la distancia de Mahalanobis

(14) es la más utilizada, especialmente combinada con el análisis canónico

de poblaciones. Pueden verse aplicacione^ a la biología sistemática en Seal

(1 964), Reyment (1 973), Petitpierre y Cuadras (1 977}, Cirer (19871.

La utilización de distancias basadas en coeficientes de similaridad, combinadas con el análisis de coordenadas principales y el análisis de conglomerados, han significado una importante herramienta metodológica en

Botánica, 2oología, Microbiología y Ecología. Los trabajos de Escarré

(1 973), Cantón y Sancho (1976} son bien representativos en este sentido.

En ecología se han utilizado tar^nbién las distancias basadas en la métrica

de Canberra, que presenta ciertas ventajas. véase Lance y Williams (1967},

Legendre y Legendre (1 979) y una interesante aplicación en Del Castillo

(1 986).

Para una visión general del tema se recomienda consultar Constandse

(1972), Goodman (1972), Sneath y Sokal (1973), Cuadras (1980). Respecto de la dimensión s^gnificativa o número de "clusters" signifícativos,

véase Cuadras (1 987).

7.2. Genética

Las Ilamadas distancias genéticas entre poblaciones son distancias estadísticas que se calculan sobre datos basados en frecuencias genéticas en

loci polimórficos. Se trata, por lo tanto, de medidas que cuantifican la

diferencia genética entre pobiaciones en términos de las frecuencias alélicas de diferentes ioci, es decir, de distancias " genotípicas", que se distinguen de otras ( coma el índice de semejanza racial de K. Pearson) +que se

considerarían distancias " fenotípicas".

Dados n sucesos mutuamente excluyentes A,,...,A„ una distancia genética es una rnedida de divergencia entre dos distribuciones de probabilidad

p= (p,,...,p„)", q= (q,,..., q„)`. Si se conoce una matriz de covarianzas ^,

asociada a una distribución a=(a,,...,a„)', es decir,

DIS1 Ati('1-^^ f:tiT^^E)Iti^TI(.'^tti

Q;^ -

a; (1 - a^}

_ a; a^

i=j

;^ j

entonces podemos utilizar una distancia de Mahalanobis singular

(p-q)' ^i(p-q)

(51}