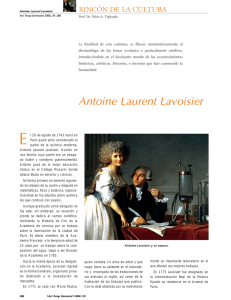

Ignis Mutat Res El calórico y la estructura de la materia en los

Anuncio