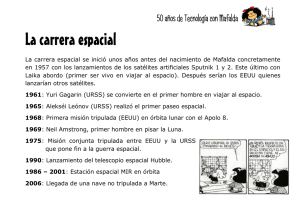

Del espacio al subsuelo

Anuncio