VOLCANES, TERREMOTOS Y MATEMÁTICAS

Anuncio

VOLCANES, TERREMOTOS Y MATEMÁTICAS

José Miguel Lorenzo Salazar

Universidad de La Laguna

"Cuando Marte, Mercurio y la Luna entren en conjunción, hacia el sur habrá una gran

sequía. En las profundidades de Asia habrá un terremoto:

Corinto y Efeso quedaran perplejos"

Cfr. Centurias Astrológicas (1547)

Nostradamus (1503-1556)

“Todos los cambios tienen lugar de acuerdo con la ley que enlaza causa y efecto”

Segunda Analogía, Principio de la Sucesión Temporal según la Ley de la Causalidad

Crítica de la Razón Pura (1781)

Emmanuel Kant (1724-1804)

1. Introducción

Las erupciones volcánicas y los terremotos constituyen una experiencia

impactante para las sociedades modernas. A su espectacularidad debemos añadir que

son fenómenos naturales que pueden representar un riesgo para la seguridad personal y

colectiva e, incluso, para el Medio Ambiente. Los fenómenos volcánicos y sísmicos, en

todas sus variadas manifestaciones, han constituido un atractivo indudable para los

estudiosos y curiosos a través de todas las épocas de la historia. Una de las primeras

crónicas escritas acerca de la destrucción ocasionada por la erupción de un volcán se

debe a Plinio el Jóven en el año 79 D.C., quien describió los efectos devastadores de la

erupción del volcán Vesubio sobre Pompeya, a los pies del cual se expande hoy la

ciudad italiana de Nápoles.

En el siglo XXI las nuevas Tecnologías de la Información y de la Comunicación

nos permiten conocer al instante hechos que suceden a miles de kilómetros de distancia.

Los efectos de las erupciones volcánicas sobre la población y las infraestructuras no son

una excepción. Ejemplos recientes son la erupción del Nevado del Ruiz en Colombia en

1985 y la erupción pliniana del volcán Pinatubo en Filipinas en 1993. En ambos casos

los científicos reconocieron con antelación los procesos de reactivación que se estaban

sucediendo bajo dichos volcanes. En el caso del Nevado del Ruiz, los flujos de lodo que

produjo el deshielo acelerado de la cima del volcán - como consecuencia del

calentamiento interno del mismo - arrasaron la ciudad de Armero, causando la muerte a

25.000 personas. En el caso de Pinatubo, la población fue evacuada.

Los registros históricos de terremotos anteriores al siglo XVIII son casi

inexistentes o poco fidedignos. Entre los sismos antiguos para los que existen registros

fiables está el que se produjo en Grecia en el 425 a.C., que convirtió a Eubea en una

isla; el que destruyó la ciudad de Éfeso en Asia Menor en el 17 d.C.; el que arrasó

Pompeya en el 63 d.C., y los que destruyeron parte de Roma en el 476 y Constantinopla

(ahora Estambul) en el 557 y en el 936. En la Edad Media se produjeron fuertes

terremotos en Inglaterra en 1318, en Nápoles en 1456 y en Lisboa en 1531 y 1756.

Recientemente, Bam, una de las antiguas ciudades de la Ruta de la Seda, sufrió

un terremoto de 6,3 grados de magnitud en la escala Ritcher que produjo la muerte de

miles de personas y la destrucción total de la ciudad. En 2003 un terremoto de 7,9

grados de magnitud provocó la muerte de al menos 50.000 personas en Nueva Delhi,

India, el segundo estado más industrializado de Asia. En 2004 un terremoto sacudió la

ciudad marroquí de Alhucemas produciendo un número indeterminado de víctimas. Los

efectos de este terremoto fueron sentidos en el sur de la península Ibérica.

La cuestión que emerge de una manera explícita tras reconocer estos hechos es

la siguiente: ¿no es posible predecir y/o prevenir estas catástrofes naturales? La

respuesta es compleja y admite múltiples matizaciones. De hecho, no es infrecuente que

salgan a la palestra pública toda suerte de adivinos y pseudocientíficos que pecan de

adivinadores y futurólogos. Para predecir cualquier fenómeno es indispensable

observarlo, caracterizarlo, establecer hipótesis de trabajo que expliquen su

comportamiento, construir modelos y elaborar mecanismos explicativos, etc. En

definitiva, es preciso emplear las pautas del Método Científico para estudiar y

comprender bien el fenómeno.

A medida que la Ciencia evoluciona, las formas de describir y predecir lo que

acontece en la Naturaleza, esto es, las Teorías, se vuelven cada vez más exactas, es

decir, más matemáticas. Es indudable que el grado de desarrollo en las matemáticas

también tiene una relación directa con el desarrollo científico. Pero ¿qué ciencia o

ciencias incluyen los fenómenos volcánicos y sísmicos como objetos de estudio? La

Geofísica. En 1838, el profesor de Cambridge W. Hopkins introduce por primera vez el

1

término “Geología Física” para designar la ciencia que trata de los aspectos físicomatemáticos de la Geología. Podemos entender, por tanto, que la Ciencia Geofísica

unifica los aspectos físico-matemáticos de los fenómenos relacionados con la Tierra.

Comoquiera que haya sido considerada a lo largo de los últimos dos siglos (“Theorie de

la Terre”, “Physique du Globe”, «Physikalische Geographie”, “Physical Geology”, etc.),

la Geofísica Moderna emplea los métodos matemáticos y físicos para el estudio de

problemas geológicos [1]. Por otro lado, debido a que la Geofísica tiene que enfrentarse

con problemas cada vez más complejos (por ejemplo, la dinámica interna del manto

terrestre o la predicción de terremotos), necesita de la interpretación que facilitan otras

disciplinas (i.e. la Geoquímica). Según la Unión Internacional de Geodesia y Geofísica

(IUGG), la Geofísica puede dividirse en siete disciplinas: Geodesia; Sismología y Física

del Interior de la Tierra; Meteorología y Física de la Atmósfera, Geomagnetismo y

Aeronomía; Ciencias Físicas de los Océanos; Hidrología; Volcanología y Química del

Interior de la Tierra.

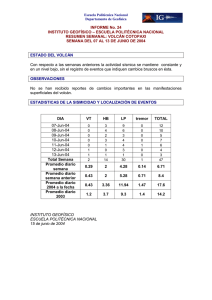

2. Algunos hitos en el desarrollo de la Volcanología y Sismología

Casi todas las disciplinas que conforman la Ciencia Geofísica tienen un origen

en las primeras civilizaciones. Los primeros cálculos geodésicos se deben a Eratóstenes

y Aristóteles (s. III y IV a.C.). La Geofísica moderna se desarrolla de la mano de

Galileo, Gilbert, Newton, Halley, etc. [1]. La Sismología y la Volcanología, entendidas

como disciplinas de la Geofísica moderna, son ciencias de reciente aparición.

El primer sismógrafo reconocido como tal fue diseñado por Chang Heng en

China en el año 132 de nuestra era. No obstante, hasta el siglo XX no aparecen los

primeros sismógrafos capaces de registrar la señal sísmica. Hacia 1870, el geólogo

inglés John Milne (1850-1913), considerado como el padre de la Sismología moderna,

ideó el predecesor de los actuales sismógrafos (del griego, seismos, ‘agitación’).

Consistía en un péndulo con una aguja suspendido sobre una plancha de cristal

ahumado. Éste fue el primer instrumento utilizado en sismología que permitiría

discernir entre las ondas primarias (P) y secundarias (S). En 1906, Boris B. Golitzin

(1862-1916) construye el primer sismógrafo electromagnético con grabación

fotográfica.

Beno Gutenberg (1889-1960) desarrolló diversos modelos matemáticos del

interior de la Tierra a partir del estudio de las ondas sísmicas. A él se debe el

descubrimiento de la discontinuidad entre el manto y el núcleo terrestre que lleva su

nombre. Andrija Mohorovicic (1857-1936), de origen croata, descubre en 1909 la

discontinuidad entre la corteza y el manto terrestre que lleva su nombre. Kiyoo Wadati,

sismólogo japonés, demostró en 1928 la existencia de terremotos con hipocentros

profundos. Sus trabajos, juntos con los de Hugo Benioff (1894-1968), permitieron

identificar lo que hoy conocemos como zonas de subducción y, en particular, zona de

Benioff/Wadati. A Benioff se debe el primer “strainmeter” o instrumento para medir las

deformaciones (contracciones o dilataciones) de la corteza terrestre (1936). La

sismóloga Ingle Lehmann (1888-1993) descubre en 1936 el núcleo interno de la Tierra

y define sus capas interna y externa.

A Giuseppe Mercalli, sismólogo italiano, debemos la primera escala de

intensidades (1902). En 1931 adquiere su aspecto definitivo con doce grados de

intensidad y pasa a denominarse Escala de Mercalli Modificada. Charles Richter (19001985) introduce en 1935 el concepto de magnitud de un terremoto, vinculando este

nuevo parámetro a la energía liberada en el foco del evento sísmico, de tal manera que

puede ser calculado directamente a partir de un sismograma, ofreciendo una lectura

cuantitativa del fenómeno.

2

El origen y la distribución geográfica de los fenómenos sísmicos y volcánicos

fueron discutidos intensamente durante la primera mitad del siglo XX. Finalmente, en la

década de los sesenta la Teoría de la Deriva Continental y la Tectónica de Placas,

desarrollada originalmente por Alfred Wegener (“The Origins of Continents and

Oceans”, 1915) es aceptada por la comunidad científica al mismo nivel que la Teoría de

la Evolución por selección natural. Por lo tanto, y sin menoscabar la importancia de los

trabajos de investigación realizados con anterioridad a 1965, podemos aseverar que la

Sismología y la Volcanología comienzan a evolucionar hasta adquirir su relevancia

actual a partir de la consolidación de aquellas.

3. Aportaciones de la Matemática a la Sismología y la Volcanología

Uno de los problemas más importantes resueltos por la Matemática que resulta

de gran aplicación en todas las disciplinas de la Ciencia Geofísica es la interpolación.

El objeto de los estudios de la Geofísica (i.e. el flujo de calor en una superficie, el

potencial eléctrico propio en una zona geotermal, la emisión difusa de gases en los

flancos de un volcán, la resistividad eléctrica en una zona fracturada de la corteza

terrestre, la distribución geográfica de la pluviosidad y escorrentía superficial, etc.)

puede expresarse en forma de campo, escalar o vectorial. A su vez, éste puede variar en

el espacio y/o en el tiempo. La interpolación es vital para la interpretación de las mapas

o imágenes 2D y 3D obtenidos a partir de muestreos discretos.

Si usamos el formalismo matemático, podemos definir un campo geofísico, Θ,

escalar o vectorial, que depende del valor del campo en las condiciones iniciales, Θ0, del

valor que tome r, la posición dada por las coordenadas espaciales rx (latitud), ry

(longitud), rz (altitud) y t, el tiempo:

Θ = Θ( Θ 0 , r , t )

(1)

El problema esencial de la interpolación radica en la estimación del valor del

campo Θ en unas condiciones (r, t) distintas a las observadas durante la realización de

las medidas. Para simplificar, consideraremos dos casos particulares de la ecuación (1):

(i) Análisis espacial en condiciones estacionarias durante la realización de las medidas

Θ = Θ(Θ 0 , r ) ; t = constante

(2)

(ii) Análisis temporal en condiciones espaciales fijas durante la realización de las

medidas

Θ = Θ(Θ 0 , t ) ; r = constante

(3)

En el caso (i), hablaremos directamente de la aportación matemática derivada de la

aplicación del variograma y del kriging.

En el caso (ii), podemos analizar la variación temporal del campo geofísico en el

dominio de tiempos a partir del análisis de autocorrelación (el equivalente del

variograma), en el dominio de frecuencias a partir del espectro de frecuencias (análisis

de Fourier) o en el dominio de tiempo-frecuencias a partir del estudio del escalograma

(análisis wavelet).

3.1. Análisis Espacial: kriging y variograma

El análisis espacial de campos geofísicos, supuestos estacionarios o no, tiene su

origen en una disciplina multidisciplinar: la Geoestadística. La Teoría Geoestadística

nace en la década de los 50 gracias a los trabajos de Kolgomorov y Wiener quienes la

formulan empleando la notación matricial en el espacio de Hilbert. Esta teoría comienza

3

a ser conocida de una manera más inteligible para el público no especialista a partir de

los 60 (Matern, 1960; Whitle, 1963 y Matheron, 1965, entre otros).

Un procedimiento rápido para interpolar un campo geofísico, de aspecto espacial

aparentemente aleatorio, consiste en asumir un modelo determinista que describa la

variación espacial entre dos puntos en donde el valor del campo geofísico es conocido.

Las técnicas de interpolación determinista, incluyendo la triangulación y el inverso de la

distancia a una potencia (~1/dn), no consideran la posibilidad de que el campo geofísico

se distribuya espacialmente con una determinada función de densidad de probabilidad,

por lo que no permiten realizan una estimación de la eficiencia de la interpolación. Por

el contrario, las técnicas de interpolación probabilística, como el kriging ordinario que

comentaremos brevemente a continuación, permiten asignar una varianza o error a la

estimación realizada en cada punto del espacio [2].

La expresión "kriging" es sinónima de “predicción óptima”. Básicamente

consiste en un método de interpolación que predice el valor del campo geofísico en un

punto no muestreado a partir del valor observado para dicho campo geofísico en

localizaciones conocidas. Para ello se emplea el variograma, que permite expresar de

una manera directa la variación espacial observada mientras se minimiza el error de los

valores predichos. En la literatura especializada, el kriging también recibe el nombre

dado por el acrónimo B.L.U.E. (best linear unbiased estimator o mejor estimador lineal

insesgado). Se dice que es “lineal” porque los valores estimados se obtienen como

combinaciones lineales ponderadas de los datos disponibles. Es “insesgado” porque la

media de su error es cero. Es el “mejor” porque persigue minimizar la varianza de los

errores. Esta es precisamente la diferencia del kriging respecto a otros métodos de

estimación lineal: su objetivo de minimizar la varianza del error.

En el kriging ordinario, el estimador empleado para calcular el valor del campo

∧

geofísico en un punto no medido, θ , es el siguiente:

n

∧

θ = ∑ λ j ∗θ

(4)

j =1

n

∑λ

i =1

=1

i

(5)

donde λi representa el peso asignado a cada medida.

El error de la estimación i-ésima, ri, es:

∧

ri = θ i − θ i

El error promedio de un conjunto de k estimaciones es:

1 k

1 k ∧

m R = ∑ ri = ∑ θ i − θ i

k i =1

k i =1

Y, finalmente, la función que debe minimizar el kriging, la varianza [3], es:

(6)

(7)

2

1 k

1 k ∧

1 k ∧

σ = ∑ (ri − m R )2 = ∑ θ i − θ i − ∑ θ i − θ i

(8)

k i =1

k i =1

k i =1

La herramienta básica para la interpretación estructural (espacial) del fenómeno

así como para efectuar la estimación es el variograma. Matemáticamente, el variograma

se define como

2γ (h ) = Var [θ (r + h ) − θ (r )]

(9)

donde la función γ(h) recibe el nombre de semivariograma [4] y h es la distancia entre

la posición del punto a estimar y una observación próxima a él. El variograma recoge

toda la información acerca de la variabilidad espacial del campo geofísico e incluye los

2

R

4

pesos asignados a cada punto de medida durante el proceso de interpolación. El estudio

y la elección de un modelo adecuado para el variograma son de crucial importancia ya

que éste incide directamente sobre el resultado de la interpolación. El variograma

permite reflejar las condiciones de heterogeneidad y anisotropía observadas

frecuentemente cuando se estudia la distribución espacial de un campo geofísico (i.e. la

permeabilidad de un conducto volcánico al paso de los gases; la distribución espacial de

la emisión difusa de gas volcánico a través de los suelos, etc.).

La varianza a minimizar, expresada a través de la ecuación (8) puede ser

reescrita en términos del semmivarigrama de la siguiente manera:

σ R2 = 2∑ λi γ (ri , V ) − ∑∑ λi λ j γ (ri , r j ) − γ (V , V )

n

i =1

−

n

n

−

(10)

i =1 j =1

−

donde γ (ri , V ) representa el promedio del semivariograma entre el punto ri y el volumen

ocupado por el total de observaciones V [5].

A modo de ejemplo, podemos considerar dos tipos de semivariogramas observados

frecuentemente:

(a) semivariagrama de modelo esférico

3 h 1 h 3

si h < a

−

γ (h ) = C

3

a

2

2

a

γ (h ) = C si h ≥ a

(b) semivariograma de modelo exponencial

h

γ (h ) = C − exp −

a

(11)

(12)

Un ejemplo del uso de la interpolación probabilística en los estudios de

Volcanología puede encontrarse en [6]. En este caso, el kriging ha sido utilizado para

estimar la distribución espacial de las emisiones difusas de dióxido de carbono en los

flancos y cráteres del volcán Cerro Negro, Nicaragua, en 1999. Cerro Negro es el

volcán más joven del hemisferio Norte (“nació” en 1951) y es uno de los más activos

(su ciclo eruptivo es inferior a los diez años). Sus erupciones más recientes ocurrieron

en 1992, 1995 y 1999.

Figura 1. Distribución

espacial de las emisiones de

dióxido de carbono en el

volcán Cerro Negro,

Nicaragua, en diciembre de

1999. El kriging permite

estimar la emisión difusa de

gas por medio de la

interpolación a partir de las

observaciones realizadas en

algo más de 200 puntos sobre

los flancos y cráteres

históricos del volcán.

5

La aplicación del variograma y del kriging nos permite obtener imágenes ndimensionales del fenómeno en estudio [7]. A partir de ellas es posible discernir gráfica

y/o numéricamente la presencia de regiones donde el campo geofísico adopta valores

anómalos. En especial, resultan de gran utilidad los métodos matemáticos de detección

de anomalías y valores frontera (outliers). Ejemplos de estos métodos son el análisis de

colas (heavy tails), el análisis gráfico de Sinclair (1974), el estadístico de salto o GAP

(Miesch, 1981), U* y análisis multifractal de Cheng (1999), análisis de los estadísticos

de orden superior, etc.

3.2. Análisis de Series Temporales: uso de las transformaciones matemáticas

La aparición de los materiales semiconductores extrínsecos en la década de los

50 condujo a la fabricación de los primeros transistores (1947). La carrera por la

miniaturización, la reducción del consumo eléctrico de los componentes electrónicos y

de los costes ha impulsado un desarrollo tecnológico que también se ha dejado sentir en

disciplinas científicas como la Sismología y la Volcanología. La mejora continua en la

instrumentación científica, en especial en los instrumentos portátiles o de campo, en los

sistemas de adquisición de datos (conversión analógico-digital más rápida y eficiente) y

en los sistemas de telecomunicación (telemetría) está permitiendo la observación y

recogida de una ingente cantidad de información geofísica, bien sea desde la superficie

terrestre o desde el espacio. En muchos casos, dicha información se presenta con el

aspecto de una serie de datos en los que la ordenación temporal es relevante. En este

caso, hablamos de series temporales (caso (ii)). Ejemplos de series temporales de interés

para la Sismología y la Volcanología son, entre otras:

•

•

•

•

•

•

•

•

el registro sísmico

la deformación de la corteza terrestre en una zona sísmicamente activa o de un

edificio volcánico activo

las mareas oceánicas y terrestres

el nivel de agua en el interior de un pozo

la variación del campo magnético interno terrestre

la emisión de gases a través de los suelos

la composición química de los gases fumarólicos

las anomalías de gravedad, etc.

Y aquí es donde la Matemática nuevamente está contribuyendo de una manera decisiva

en la interpretación de los fenómenos sísmicos y/o volcánicos. Algunas de las

contribuciones más evidentes en el análisis de series temporales (auque también es

aplicable al análisis espacial) son las siguientes:

•

•

Filtrado. Se emplea para reducir o eliminar el ruido inherente al registro

instrumental de series temporales o para separar las distintas componentes

periódicas de las componentes irregulares. También puede emplearse para

reducir el tamaño de los archivos digitales en los que se almacena la

información.

Descomposición y reconstrucción. La descomposición de una serie temporal en

componentes deterministas y no deterministas puede facilitar su análisis e

interpretación. Asimismo, es posible eliminar información redundante de los

registros y así facilitar la transmisión de información a distancia. Para ello se

puede emplear algunas de las técnicas del análisis estadístico multivariante

6

clásico como son la extracción de factores (componentes principales), análisis de

conglomerados (clusters), acumulación de histogramas (método HiCUM),

estudio de los momentos de orden superior, etc.

• Modelado. El establecimiento de modelos matemáticos, una vez validados con

datos obtenidos empíricamente, permite a los científicos predecir el

comportamiento del sistema en estudio.

• Detección de anomalías y predicción. El estudio de determinadas propiedades de

una serie temporal permite establecer criterios de alarma, es decir, valores

umbral por encima o por debajo de los cuales los valores observados pueden

considerarse como anómalos o no normales. Entre ellas podemos citar la

varianza (o covarianza), la dimensión de Hausdorf, la dimensión fractal, etc.

Una serie temporal puede ser analizada, al menos, en dos dominios distintos: en el

dominio temporal (figura 2) y en el dominio de frecuencias (figura 3). En la figura 2 se

muestra el registro sísmico de un terremoto de magnitud 5,8 en la escala de Ritcher

ocurrido el veinte de marzo de dos mil cuatro en la región de Kamchatka, Rusia, a una

profundidad de 31 km. En la figura 3 se muestra el análisis espectral o análisis de

Fourier obtenido utilizando una ventana de tiempo de promediado muy ancha, con

objeto de suavizar el aspecto de la función de densidad espectral resultante. El análisis

espectral de la señal sísmica revela la presencia de distintas componentes de baja

frecuencia y la ausencia de componentes periódicas de frecuencias altas.

Figura 2. Sismograma de un terremoto

registrado a 31 km de profundidad en

Kamchatka. Datos del sismo: latitud 53,74

ºN, longitud 160,74 ºE. Del total de 120.000

muestras (tomadas a intervalos de 9 ms) se

muestran alrededor de 10.000, lo que

equivale a un periodo de 100 segundos de

registro.

Figura 3. Análisis espectral aplicado a una serie de

80 segundos del sismograma de la figura 2 efectuado

con el programa STATISTICA v6.0. El análisis

espectral del sismograma revela la presencia de

diversas componentes periódicas en la región de

bajas frecuencias y la ausencia de componentes

periódicas de frecuencias elevadas.

Densidad Espectral

Análisis Espectral del Sismograma

1E+13

1E13

8E+12

8E12

6E+12

6E12

4E+12

4E12

2E+12

2E12

La representación de una serie temporal en

el dominio de tiempos, esto es, el gráfico de

la señal versus tiempo, nos proporciona una

lectura directa del fenómeno que produce la señal. También resulta de especial utilidad

la función de autocorrelación, γ(τ), definida como

γ (τ ) = E{[θ (t ) − µ ] ⋅ [θ (t + τ ) − µ ]} = Cov[θ (t ), θ (t + τ )]

(14)

donde θ(t) representa el campo geofísico dependiente del tiempo, es decir, la serie

temporal, t y τ representan el tiempo, µ es la esperanza matemática del campo geofísico

(µ=E[θ(t)]) y Cov representa la covarianza del proceso. Nótese que se ha empleado una

notación para la función de autocorrelación, γ(τ), similar a la empleada para el

semivariograma, γ(h). De hecho, ambas funciones son equivalentes: una se emplea en el

dominio espacial y otra en el dominio temporal. El análisis de la función de

autocorrelación (dominio de tiempo) nos permite obtener información indirectamente

0E-01

0.00

0.02

0.04

0.06

0.08

Frecuencia

7

0

0.10

sobre las distintas frecuencias presentes en la señal original. No obstante, su uso no está

indicado para señales de cierta complejidad donde pueda resultar harto difícil identificar

componentes de frecuencias muy parecidas. En este caso es preciso transformar la serie

temporal original al dominio de las frecuencias empleando una base de funciones

ortogonales. Para ello recurrimos al análisis espectral.

El análisis espectral tiene su origen en las investigaciones desarrolladas por Jean

Baptiste Joseph Fourier (1768-1830) sobre las propiedades de la transferencia de calor

en sólidos conductores. Sus trabajos a comienzos del siglo XIX (“La Teoría Analítica

del Calor”) sentaron las bases para la disciplina matemática del Análisis de Señales.

Fourier introdujo un nuevo concepto en la matemática de su época (con la oposición

frontal de Biot, Laplace, Poisson, etc.): cualquier función arbitraria, incluso aquellas que

muestran discontinuidades, puede ser aproximada mediante una expresión analítica

sencilla. Fourier estableció las ecuaciones en derivadas parciales que gobiernan la

difusión del calor y encontró una solución empleando series infinitas de funciones

trigonométricas de senos y cosenos (base ortogonal).

Sea una función continua, θ(t), de periodo T. Dicha función puede expresarse

como serie de Fourier en los siguientes términos [8, 9]:

a0 ∞

2nπ

2nπ

t + bn sen(

+ ∑ a n cos

t )

2 n =1

T

T

donde los coeficientes an y bn pueden ser calculados a partir de:

C +T

2

2 nπ

θ (t ) cos(

an =

t )dt

∫

T C

T

θ (t ) =

(15)

(16)

C +T

2

2 nπ

(17)

θ (t ) sen(

bn =

)dt

∫

T C

T

Los coeficientes de estas funciones base ortonormales representan la contribución de las

componentes cosenoidales y sinusoidales de la señal en todas las frecuencias [10]. De

esta manera, una señal geofísica cualquiera puede ser descompuesta en las distintas

componentes periódicas presentes.

Por tanto, el análisis de Fourier consiste en obtener una representación en

frecuencia de la señal original a partir del cálculo de los coeficientes ao, an y bn. Sin

embargo, el cálculo de estos coeficientes requiere un elevado coste computacional. Este

problema quedó resuelto con el descubrimiento de un algoritmo que denominamos

Transformada Rápida de Fourier (FFT). Fue propuesto por J. W. Cooley, J. W. Tukey y

G. Sande en 1965 para el análisis de series temporales. Sin entrar en mayor detalle,

baste decir que si el número de medidas, N, de la serie temporal es o puede expresarse

(i.e. mediante truncamiento de la serie original o por adición de ceros) como múltiplo de

dos (2n), entonces el número de operaciones necesarias para completar el análisis de

Fourier se reduce de NN a N2. El descubrimiento del algoritmo FFT permitió la

implementación de los primeros circuitos integrados analizadores de espectros en

tiempo real.

La Transformada de Fourier de la señal original, Θ(w), esto es, la transformación

de la señal temporal original al dominio de las frecuencias, se puede realizar de la

siguiente manera para una serie temporal continua:

+∞

Θ( w) = ∫ θ (t )e − jwt dt

(18)

−∞

8

donde w es la frecuencia, t es el tiempo y j permite usar la notación compleja

( j = − 1 ). Una vez obtenida la representación espectral o en frecuencia de la señal

original, es posible recuperar la señal original a partir de

+∞

θ (t ) = ∫ Θ( w)e jwt dw

(19)

−∞

En el caso de que la serie temporal sea discreta, la transformada de Fourier se escribe

usando un sumatorio [10]:

−2π ⋅ jkn

∧

1 N −1

Θ( w) ≡ θ k = ∑θ ne N

(20)

N n=0

En la actualidad, existen sismógrafos que registran la actividad sísmica en un

amplio rango de frecuencias (estaciones sísmicas de banda ancha como las instaladas

por el Instituto Geográfico Nacional en Canarias recientemente), de manera que es

factible adquirir la señal sísmica y procesarla en tiempo real para estimar su espectro de

frecuencias. El espectro de frecuencias nos proporciona información sobre la naturaleza

de la señal sísmica. Las señales sísmicas conocidas como tremor volcánico se asocian a

la resonancia de estructuras rellenas de fluidos, bien sean estáticos o estén en

movimiento, localizadas bajo un volcán activo. El tremor volcánico se caracteriza por

formas de onda persistentes o sostenidas en el tiempo. El tremor refleja una vibración

continua del suelo o pequeños sismos muy frecuentes cuyas ondas se solapan. Si la

señal sísmica presenta una frecuencia constante, hablamos de tremor armónico. Si la

señal sísmica varía ostensiblemente en frecuencia o amplitud, hablamos de tremor

espasmódico [11]. Los sismos de largo período o sismos LP pueden atribuirse a la

resonancia provocada por cambios en la presión de los fluidos alojados en grietas,

cavidades y conductos [12]. En este tipo de eventos predominan las bajas frecuencias.

En un volcán activo o en un sistema volcánico donde comienza a alojarse magma poco

desgasificado es frecuente observar enjambres de terremotos de tipo LP con eventos

individuales de frecuencias dominantes bien definidas (i.e. 4 Hz).

Un ejemplo de aplicación del análisis espectral se refleja en la figura 4, donde se

puede observar el resultado de aplicar la transformada rápida de Fourier a una serie

temporal de la emisión difusa de dióxido de carbono en las faldas de un volcán activo en

Centro América.

Figura 4. Serie temporal de la emisión difusa de dióxido de carbono en el volcán San Vicente, El

Salvador (izquierda). A la derecha se muestra el espectro de frecuencias obtenido a partir del análisis de

Fourier de la señal original.

A pesar de la versatilidad de la transformada de Fourier, existen una serie de

inconvenientes. En primer lugar, la transformada de Fourier falla cuando tratamos de

representar con exactitud funciones de componentes no periódicas bien localizadas en el

tiempo (o en el espacio), como pueden ser los transitorios o impulsos (i.e. la llegada de

9

un tren de ondas P o S a un sismógrafo; la llegada de un pulso de gas a la superficie en

forma de solitón). En segundo lugar, la transformada de Fourier no proporciona

información sobre la dependencia temporal de la señal ya que la transformada refleja el

promediado a través de toda la duración de la serie temporal. Estas limitaciones son

patentes cuando se analizan señales geofísicas no estacionarias y de naturaleza no

periódica. Muchas series temporales geofísicas exhiben un comportamiento no

estacionario en su estadística. Generalmente presentan componentes periódicas

dominantes (tendencia o deriva) superpuestas con una serie irregular o ruidosa, y

pueden variar tanto en amplitud como en frecuencia. Por eso es interesante poder

separar las variaciones de periodo corto de las variaciones de periodo largo y distinguir

éstas de las variaciones no periódicas.

Para mitigar las limitaciones del análisis de Fourier la Matemática proporciona

nuevos métodos: el análisis tiempo-frecuencia. Una aproximación al problema consiste

en dividir la señal original en ventanas de duración temporal conocida y analizar el

contenido frecuencial de cada una de ellas por separado. Otra aproximación consiste en

filtrar diferentes bandas de frecuencia y después dividir estas bandas para analizar la

varianza o energía en cada una de ellas. El primer método recibe el nombre de

transformada corta o de periodo corto de Fourier (STFT; Dennis Gabor, 1946) y

también se usa para construir la transformada de Wigner-Ville:

+∞

τ

τ

W ( w, t ) = ∫ θ (t + ) ⋅ θ (t − ) ⋅ e − jwt dt

(21)

2

2

−∞

El segundo método recibe el nombre de transformada de ondícula o

transformada wavelet. La transformada wavelet es un procedimiento empleado para

diseccionar la señal en sus partes constituyentes permitiendo el análisis de los datos en

distintas bandas de frecuencias por comparación con una función átomo denominada

wavelet, ψo(η). En otras palabras, se descompone la señal original en un conjunto de

funciones base denominadas wavelets (y que deben cumplir una serie de condiciones),

análogas a los cosenos y senos de la transformada de Fourier. Estas funciones base se

obtienen por dilatación y traslación de una función wavelet madre. La principal

diferencia entre la transformada wavelet y la de Fourier es que la primera permite la

localización temporal de determinadas componentes periódicas. Para la localización

temporal se emplean versiones trasladadas de la función wavelet madre, mientras que

para la localización en escala (frecuencia) se emplean versiones dilatadas o contraídas

de la misma.

Los fundamentos de la transformada wavelet se remontan a los trabajos

originales de Alfred Haar en 1909. No obstante, el gran desarrollo de esta transformada

y de sus múltiples aplicaciones se debe a las investigaciones de Grossmann (físico

teórico) y Morlet (geofísico) en los años 80. Estos investigadores emplearon el análisis

tiempo-frecuencia para estudiar terremotos y obtener modelos del desplazamiento de las

ondas sísmicas a través de la corteza terrestre. Otros nombres destacados son los Ingrid

Daubechies (1988), Stéphane Mallat (1989) y Yves Meyer (matemático especialista en

análisis armónico; 1993).

La función wavelet empleada en los trabajos de Morlet puede definirse como

−1

−η

2

e jϖ oη e 2

(22)

donde η representa la variable tiempo sin dimensiones y wo es el número de onda. La

versión dilatada y escalada de la función wavelet madre es:

ψ o (η ) = π

4

(n´−n)δt δt 2 (n'− n )δt

ψ

= s ψ o s

s

1

(23)

10

donde s es el parámetro de dilatación para cambiar de escala (banda de frecuencia) y n

es el parámetro de traslación. El factor s-1/2 normaliza la expresión para mantener

constante la energía total de la función wavelet en todas las escalas.

La transformada wavelet puede entonces definirse como el producto interior

(convolución matemática) de la función wavelet con la serie temporal geofísica [13]:

N −1

(n'− n )δt

Wn ( s ) = ∑ θ n ' (t )ψ *

(24)

s

n '= 0

donde el asterisco denota el complejo conjugado.

En la práctica la transformada wavelet no es calculada en el dominio temporal

(ecuación 23) sino en el dominio de Fourier [14]. Para ello se calcula la convolución de

las transformadas de la señal original y de la función wavelet modificada:

N −1 ∧

∧

Wn ( s ) = ∑ θ k ψ * ( sϖ k )e jϖ k nδt

(25)

k =0

La representación bidimensional escala (o frecuencia) versus tiempo de la transformada

Wn(s) resulta de utilidad para la interpretación geofísica de un fenómeno. La

representación cuadrática, [Wn(s)]2, nos proporciona información sobre la potencia de la

señal en una determinada escala y a un tiempo determinado [15].

En la figura 5 se presenta un análisis completo de la serie temporal estudiada por

Salazar et al. [16] acerca de la variación temporal de la emisión difusa de dióxido de

carbono en el flanco del volcán San Vicente, El Salvador, en 2001. Junto con la serie

temporal original se puede observar un gráfico bidimensional tiempo-frecuencia

(también conocido como escalograma) obtenido aplicando la transformada de wavelet

con una wavelet de Morlet, la potencia espectral asociada a cada frecuencia y la

reconstrucción “suavizada” de la serie a partir del promediado de la varianza para

oscilaciones de periodo comprendido entre 2 y 24 horas.

Figura 5. Análisis tiempo-frecuencia mediante transformada wavelet usando la función wavelet definida

por Morlet.

11

En la figura siguiente se muestra la representación tridimensional del escalograma de la

figura anterior modificando los ejes de frecuencia y potencia espectral (se han tomado

logaritmos de base 2).

Figura 6. Escalograma 3D de

la serie temporal de la emisión

difusa de dióxido de carbono en

el volcán San Vicente, El

Salvador, en 2002.

3.3. Modelos matemáticos para la interpretación de fenómenos geofísicos

La mayor parte de los modelos matemáticos aplicados en Geofísica persiguen

distinguir el comportamiento determinista (predecible) del no determinista

(parcialmente predecible). La contribución determinista a una serie temporal o espacial

puede ser descrita por la tendencia o deriva, Θdet, así como por componentes periódicas

de frecuencias conocidas, como las que se obtienen en el análisis de Fourier o análisis

armónico. La contribución no determinista, Θno-det, puede reflejar la presencia de

componentes irregulares, complejas, no estacionarias, posiblemente no lineales. Esta

aproximación común puede describirse de la siguiente manera:

Θ(Θ o , r , t ) = Θ det + Θ no −det

(26)

En función de la naturaleza del campo geofísico que se estudie, el enfoque matemático

elegido será uno u otro. En particular, podemos citar el uso de los modelos

autorregresivos integrados de medias móviles o ARIMA, propuestos por George E. P.

Box y Gwilym M. Jenkins en 1976 en su libro Time Series Analysis: Forecasting and

Control [17]. Estos modelos encuentran hoy una versátil aplicación en el estudio de

series econométricas y bursátiles. La forma más general de los modelos ARIMA

obedece la siguiente formulación:

ϕ ( B) y t = φ ( B)∇ d y t = θ o + θ ( B)at

(27)

φ ( B) = 1 − φ1 B − φ 2 B 2 − ... − φ p B p

(28)

(29)

θ ( B) = 1 − θ 1 B − θ 2 B − ... − θ q B

y se denota por las siglas ARIMA(p,d,q). En este caso la serie temporal a modelar es yt

y at representa una variable aleatoria (ruido). Este tipo de modelos es aplicable a series

temporales estacionarias o cuasi-estacionarias y permite incluir el comportamiento

autorregresivo (o autosimilar) de la serie así como la existencia de un comportamiento

promediado en el tiempo (medias móviles).

Un ejemplo reciente de la aplicación de este tipo de modelos en Volcanología lo

constituye el trabajo de Granieri et al. en 2003 [18] quienes han obtenido una expresión

para predecir el comportamiento de la emisión difusa de dióxido de carbono en los

2

q

12

campos fumarólicos de la Solfara di Pozzuoli, Italia, bajo la forma de un proceso

ARIMA:

By t = (0.44 ± 0.03) y t −1 + [η t − (0.77 ± 0.02)η t −1 ]

(30)

donde ηt representa la serie temporal yt filtrada para eliminar las componentes

periódicas conocidas (i.e. como la influencia de la presión barométrica sobre la emisión

difusa de gas hidrotermal). El filtrado puede consistir en la eliminación de las

principales componentes periódicas reflejadas en el análisis espectral. Otro

procedimiento factible consiste en realizar una regresión lineal multivariable entre el

flujo difuso de dióxido de carbono y otras variables independientes, como la radiación

solar, la presión barométrica, la velocidad del viento, etc. La serie filtrada se obteniene

al sustraer de la serie original la serie temporal obtenida por regresión lineal.

La descripción matemática de las mareas oceánicas y terrestres ha evolucionado

mucho en los últimos treinta años gracias a la mejora en la instrumentación y, por ende,

en la calidad de los datos geofísicos (i.e. medida de velocidades angulares, amplitudes,

etc.). Las mareas oceánicas y terrestres son debidas a la influencia gravitatoria de la

Luna y el Sol (la marea lunar es 2,2 veces mayor que la marea solar). Newton (1687)

fue el primero es formular modelos para describir las mareas. Sus ideas fueron

desarrolladas por D. Bernouilli (1700-1782), L. Euler (1707-1783) y C. Maclaurin

(1698-1746). Pierre Simon, marqués de Laplace (1749-1827), fue el primero en

reconocer la dificultad de una solución extacta para modelar las mareas y propuso

soluciones aproximadas para describir la fluctuación de las mareas oceánicas.

Uno de los modelos más usados para caracterizar y predecir las mareas es el

siguiente [19]:

M

K

m =1

k =0

y t = ∑ (α m C mt + β m S mt ) + ∑ bk y t − k + d t + ε t

(31)

donde el primer sumando de la ecuación representa la respuesta de la Tierra a la fuerza

gravitatoria ejercida por la Luna y el Sol; el segundo sumando representa las

perturbaciones no gravitatorias ejercidas sobre la marea, como la influencia de la

presión barométrica y la temperatura; el tercer sumando representa la tendencia o deriva

de la serie temporal (uno de los términos más difíciles de modelar); y, finalmente, el

cuarto sumando representa la componente irregular o residuo en las observaciones que

no es explicada por las variables anteriores. La obtención de un modelo adecuado para

explicar las observaciones requiere el uso de Mínimos Cuadrados para minimizar la

siguiente expresión:

N

J (d ) = ∑ {residuo} + v

2

t =1

2

2

N

∑ { funcion(d )}

t =1

t

(32)

Para determinar el aspecto final del modelo (calcular las constantes de marea αm, βmt,

los pesos de la perturbación bk, etc.) es preciso asignar un valor al parámetro v (su

cuadrado, v2, recibe el nombre de hiperparámetro). Para ello se elige un valor inicial del

hiperparámetro y se emplea el Criterio de Información Bayesiana (ABIC) propuesto por

Akaike en 1980 [20] para ajustar el valor de v2 que produzca el modelo más

parsimonioso (equilibrio entre la complejidad del modelo y el ajuste a las observaciones

ya realizadas):

ABIC = −2 log ∫ LP d d

(33)

{

}

donde L y P son funciones que dependen de la componente irregular o residuo y de la

segunda diferencia de la deriva dt, respectivamente.

La microsismicidad de una región puede estar modulada por la acción de las

mareas oceánicas (en función de su proximidad al mar) o de otro tipo de cuerpos

hídricos (como los lagos o embalses) y mareas terrestres (oscilaciones de menor

13

amplitud de la corteza terrestre). Las mareas actúan como un pistón de movimiento

alternativo sobre los fluidos y materiales que conforman la corteza terrestre. Si ésta se

encuentra en un estado de tensiones crítico, la fluctuación de la presión ocasionada por

las mareas puede actuar como mecanismo modulador de la liberación de energía sísmica

acumulada en la corteza terrestre.

En la figura 7 se muestra un ejemplo de aplicación del modelo (31) para el

cálculo de la marea oceánica en la estación Miyato, Japón. En la figura 7 puede

observarse la serie temporal original, expresada en centímetros, que refleja las

variaciones temporales del nivel del mar en dicha estación. La aplicación del criterio de

Akaike permite extraer la respuesta de la marea oceánica debida a la presión

barométrica, lo que facilita el aislamiento de la deriva y la componente irregular de

dicho registro.

Otros modelos proceden de diversas teorías matemáticas desarrolladas en los

últimos años. Entre ellas podemos citar las Redes Neuronales, Lógica Borrosa,

Máquinas de Vectores Soporte [21], Fractales [22, 23], Criticalidad Auto-organizada

[24, 25, 26], Filtros de Kalman, Modelos de Espacio-Estados, Procesos de Markov,

Espectroscopía de Ruido Flicker [27], etc.

Figura 7. Análisis de

mareas oceánicas

realizado sobre una

serie de mediciones del

nivel del mar en la

estación Miyato,

Japón. Para ello se ha

empleado el programa

Baytap-G. [19, 20]. La

componente de marea

(TIDAL) puede

aislarse de la respuesta

a la presión

barométrica de la

marea (RESP), de la

tendencia o deriva

ocasionada por

aspectos instrumentales

(TREND) y de una

componente irregular o

residual (IRREG).

Nótese que todas las

magnitudes se han

expresado en

centímetros.

4.

Predicción

de terremotos y erupciones volcánicas

La predicción de terremotos y erupciones volcánicas quizás constituye el aspecto

más relevante y de interés social de las investigaciones realizadas por sismólogos,

14

volcanólogos y geofísicos en general. Y la razón es obvia: si sabemos dónde, cuándo y

de qué magnitud será el terremoto (o dónde, cuándo y de qué índice de explosividad

volcanica será la erupción volcánica) podríamos salvar vidas y minimizar el impacto

sobre las infraestructuras y el Medio Ambiente de estos fenómenos naturales.

En especial, la predicción de terremotos ha sufrido serios cambios en las últimas

décadas. En primer lugar debemos recordar que la fuente de los terremotos no fue

renocida como tal hasta 1960 y que las primeras redes sismográficas modernas

empezaron a establecerse entre 1970 y 1980. A la euforia desatada en la década de los

setenta por la predicción exitosa de algunos terremotos en China, le siguió una década

de fracasos predictivos, lo que condujo a modificar el paradigma de la predicción de

terremotos: de un paradigma casi determinista a uno probabilista y la introducción de

nuevos conceptos físicos: la criticalidad auto-organizada [24, 26]. Durante la década de

los 90, y bajo este nuevo paradigma, se han realizado grandes progresos. Son numerosas

las investigaciones que ponen de manifiesto la existencia de fenómenos precursores de

muy diversa naturaleza que anteceden a los terremotos [28-33]. No obstante, existe una

corriente escéptica liderada por R. J. Geller [34, 35] que establece la total imposibilidad

de la predicción de terremotos. Una vez aceptado el concepto de la criticalidad autoorganizada en la superficie terrestre [36, 37], se ha reconocido la existencia y ubicuidad

de comportamientos transitorios de la corteza que pueden haber sido identificados

erróneamente como precursores de terremotos y que resultaron falsas alarmas [38]. La

corteza terrestre está en plena transformación a distintas escalas temporales y

geológicas. Con la intención de poner orden a este confuso escenario, la Asociación

Internacional de Sismología y Física del Interior de la Tierra (IASPEI) formó una

Subcomisión para la Predicción de Terremotos quien ha establecido una clara definición

de “precursor” y las condiciones para que una observación anómala pueda ser

catalogada como tal [39].

Definición de Precursor

Un “precursor” se define como un cambio cuantitativamente medible en un parámetro

(geofísico) ambiental que ocurre antes de un terremoto (mainshock) y que está

relacionado con el proceso de preparación del mismo”.

Los candidatos a precursores deben reunir una serie de requisitos:

a) la anomalía observada debe tener alguna relación con el esfuerzo o tensión

(stress), deformación (strain) o con algún mecanismo que conduzca al

terremoto.

b) la anomalía debe ser observada smultáneamente al menos con dos

instrumentos, o en más de un sitio de observación.

c) la amplitud de la anomalía observada debe presentar alguna relación con la

distancia al eventual terremoto.

d) la proporción entre el tamaño de la zona de riesgo (en el tiempo y en el

espacio) y el tamaño de la zona vigilada por instrumentos debe ser discutida

para evaluar la utilidad el método de predicción.

Atendiendo al Principio de la Sucesión Temporal según la Ley de Causalidad de Kant,

“todos los cambios tienen lugar de acuerdo con la ley que enlaza causa y efecto” [40].

Hablar de predicción implica hablar de probabilidades, de nivel de confianza, de riesgo

o valor crítico, de estimadores, de distribuciones de probabilidad, etc. Y nuevamente es

aquí donde la matemática, con su versión probabilística de los fenómenos naturales,

desempeña un papel relevante [41, 42]. Nombres propios de la contribución de la

matemática de la probabilidad al resto de las Ciencias son Laplace (probablidad

clásica), Émile Borel (teoría de conjuntos), Henri Lebesgue (teoría de la medida),

15

Andrei Nicolaievich Kolgomorov (axiomática del cálculo de probabilidades), Richard

von Mises (definición de probabilidad empleando la notación de límite) y Thomas

Bayes (teorema de Bayes), entre otros.

La definición clásica de probabilidad propuesta por el marqués de Laplace en

1774 (proporción del número de casos favorables a un suceso A al número de casos

posibles) quedó superada por la definición del pastor presbiteriano Thomas Bayes

(1702-1761) en su conocido teorema:

p( Ai ) ⋅ p( B / Ai )

p( Ai / B) =

[34]

p( A1 ) ⋅ p( B / A1 ) + p( A2 ) ⋅ p( B / A2 ) + ... + p( An ) ⋅ p ( B / An )

donde A1, A2,…,An es un sistema completo de sucesos tales que la probabilidad de cada

uno de ellos es distinta de cero y B es un suceso cualquiera para el que se conocen las

probabilidades p(B/Ai). Las probabilidades p(Ai) se denominan a priori (i.e. la

probabilidad asociada a la observación de un determinado tipo de anomalía

potencialmente precursora de un terremoto, como el cambio en el nivel de agua de un

pozo o un aumento súbito de la emisión difusa de gas volcánico en el flanco de un

volcán); las probabilidades p(B/Ai) se denominan verosimilitudes (i.e. la probabilidad

de que ocurra un terremoto habiendo sido observada una anomalía de un determinado

tipo); y las probabilidades p(Ai/B) se denominan a posteriori (i.e. la probabilidad de que

se observe una anomalía de un determinado tipo habiendo ocurrido un terremoto en la

zona de observación). Por otro lado, estos sucesos pueden ser independientes,

p(B)=p(B/A), o dependientes, p(B)≠p(B/A). Lo dicho hasta ahora es válido para el

estudio de los precursores de una erupción volcánica. En el caso de la erupción

volcánica el pronóstico es más sencillo, en principio, debido a que en este caso el área

donde podría ocurrir la erupción es conocida de antemano: el propio volcán [43], si éste

ya existiera.

Dos diferencias notables entre la predicción de una erupción volcánica y la de un

terremoto son la cinética y la profundidad del fenómeno [44]. Por lo general, la cinética

de una erupción es más lenta que la de nucleación y disparo de un terremoto, por lo que

se dispone de un intervalo de tiempo mayor para actuar en el primer caso. Asimismo, la

erupción volcánica se fragua a pocos kilómetros de profundidad y suele manifiestarse en

la superficie antes de que ocurra la erupción (aumentos de la temperatura del gas y del

suelo, cambio en los niveles de agua de pozos, deformación del terreno, muerte de

animales por asfixia, tremor volcánico, etc.). Por el contrario, la mayor parte de los

terremotos destructivos tienen su foco a profundidades no alcanzables por los

instrumentos actuales. Las dificultades experimentales encontradas para la predicción de

terremoto parecen, de momento, insalvables. Por un lado, nos encontramos con la

imposibilidad de observar directamente la zona de preparación y generación del

fenómeno (región sismogenética) [37]. Por otro lado, el parámetro geofísico de mayor

interés, el nivel de estrés (debido a las tensiones internas en la corteza), no puede ser

medido directamente. Plantear la imposibilidad de la predicción de terremotos también

depende de otros aspectos: ¿han hecho lo suficiente los gobiernos para sufragar los

costes de la investigación de estos fenómenos? La Sismología moderna es una ciencia

reciente y la predicción está dando tan sólo sus primeros pasos. Para ello es preciso

desplegar densas redes terrestres de sistemas GPS, usar técnicas de observación espacial

(satelital) como la interferometría de radar de apertura sintética (InSAR) e instalar

estaciones geofísicas terrestres multivariables (sísmicas y geoquímicas, etc) con

sistemas de comunicación automáticos y en tiempo real. Se trata, por tanto, de adoptar

un enfoque plenamente multidisciplinar [33].

16

5. Conclusiones

La Naturaleza es compleja per se. Pero es posible dar una descripción de su

comportamiento empleando un lenguaje exacto como el de las Matemáticas. La

aportación de la Ciencia Matemática en el campo de estudio de la Geofísica, y de la

Sismología y de la Volcanología en particular, no se reduce a la mera introducción de

fórmulas y ecuaciones más o menos inteligibles. A largo de esta exposición hemos

presentado algunas de las aplicaciones matemáticas más importantes en la Sismología y

Volcanología modernas, así como los nombres propios de los grandes científicos

responsables de dichos desarrollos matemáticos en los últimos siglos. Juntamente con la

evolución tecnológica acaecida en el último medio siglo (Tercera Revolución

Tecnológica), en el que instrumentación científica y los sistemas de comunicaciones se

han desarrollado enormemente, las Matemáticas están desempeñando una labor

imprescindible en todas las disciplinas de la Geofísica moderna. No es posible

axiomatizar los fenómenos sísmicos y volcánicos, esto es, los terremotos y las

erupciones volcánicas. Ambos constituyen sistemas multivariables con un número

elevado e indeterminado de grados de libertad. Sin embargo, el uso del lenguaje

matemático permite expresar de una manera exacta y útil la información observacional

que de estos fenómenos naturales obtienen los científicos. A partir de ella es posible

elaborar modelos que los describan y nos permitan realizar pronósticos sobre su

evolución futura [24, 34, 36, 45]. Sin duda, este es uno de los mayores retos que las

sociedades modernas demandan a la comunidad geofísica internacional para minimizar

y mitigar el impacto de los terremotos y las erupciones volcánicas.

6. Reconocimientos

Deseo expresar mi gratitud al vicedecano y profesor de la Facultad de

Matemáticas de la Universidad de La Laguna Dr. Rodrigo Trujillo por su invitación

para impartir esta conferencia y por su apoyo incondicional. El sismograma del

terremoto de Kamchatka fue cedido por el Dr. Serge Timashev, del Instituto Karpov de

Físico-Química de la Academia de Ciencias de la Federación Rusa. Los datos de nivel

de marea fueron cedidos por Yoshiaki Tamura, del National Astronomical Observatory,

y Makio Ishiguro, del Institute of Statistical Mathematics, Japón.

17

7. Referencias

[1] Agustín Uías y Julio Mézcua, “Fundamentos de Geofísica”, Alianza Universidad, 1997.

[2] Andre G. Journel, “Fundamentals of Geostatistics in Five Lessons”, Short Course in Geology:

volume 8, American Geohysical Union, 1989.

[3] Margaret Armstrong, “Basic Linear Geostatistics”, Springer, 1998.

[4] Noel A. C. Cressie "Statistics for Spatial Data", Wiley-Interscience, 1991.

[5] Jean Paul Chilès y Pierre Delfiner, “Geostatistics: modeling spatial uncertainty”, Wiley Series in

Probability and Statistics, John wiley & Sons, 1999.

[6] Edward H. Isaaks y R. Mohan Srivastava, "An Introduction to Applied Geostatistics", Oxford

University Press, 1989.

[7] J. M. L. Salazar, P. A. Hernández, N. M. Pérez, G. Melián, J. Álvarez y K. Notsu, “Diffuse

emission of carbon dioxide from Cerro Negro volcano, Nicaragua, Central America”,

Geophysical Research Letters, 28, 4275-4278, 2001.

[8] Chris Chatfield, “The analysis of time series: an introduction”, Chapman & Hall/CRC, 5ª

edición, 1996.

[9] Alan V. Oppenheim, Ronald W. Schafer y John R. Buck, “Tratamiento de señales en tiempo

discreto”, Prentice Hall, 2000.

[10] Alan V. Oppenheim, Alan S. Willsky y Ian T. Young, “Señales y Sistemas”, Prentice Hall, 1983.

[11] B. Chouet, “A seismic model for the source of long-period events and harmonic tremor”, en

Gasparini et al. (editores.), Volcanic Seismology, IAVCEI Proceedings in Volcanology 3,

133-156, 1992.

[12] Jr. A. S. Ryall y F. Ryall, “Spasmodic tremor and possible magma injection in Long Valley

caldera, eastern California”, Science, 219, 4591, 1432-1433, 1983.

[13] Stéphane Mallat, “A wavelet tour of signal processing”, segunda edición, Academic Press, 1999.

[14] Ingrid Daubechies, “Ten lectures on wavelets”, CBMS-NSF Regional Conference Series in

Applied Mathematics 61, 1992.

[15] Efi Foufoula-Georgiou y Praven Kumar (editors), “Wavelets in Geophysics”, Academic Press,

1994.

[16] J. M. L. Salazar, N. M. Pérez, P. A. Hernández, T. Soriano, F. Barahona, R. Olmos, R.

Cartagena, D. L. López, R. N. Lima, G. Melián, I. Galindo, E. Padrón, H. Sumino y K.

Notsu, “Precursory diffuse carbon dioxide degassing signature related to a 5.1 magnitude

earthquake in El Salvador, Central America”, Earth and Planetary Science Letters, 205/1-2,

81-89, 2002

[17] George E. P. Box, Gwilym M. Jenkins y Gregory C. Reinsel, “Time Series Analysis: forecasting

and control”, tercera edición, Prentice Hall, 1994.

[18] D. Granieri, G. Chiodini, W. Marzocchi, R. Avino, “Continuous monitoring of soil CO2 diffuse

degassing at Phlegraean Fields (Italy): influence of environmental and volcanic parameters”,

Earth and Planetary Science Letters, 212, 167-179, 2003.

[19] Y. Tamura, T. Sato, M. Ooe and M.Ishiguro, “A Procedure for Tidal Analysis with a Bayesian

Information Criterion”, Geophysical Journal International, 104, 507-516, 1991.

[20] M. Ishiguro y Y. Tamura, “BAYTAP-G in TIMSAC-84”, Computer Science Monographs, 22,

Institute of Statistical Mathematics, 1985.

[21] V. Vapnik, “The Nature of Statistical Learning Theory”, Springer-Verlag, New York, 1995.

[22] Benoît B. Mandelbrot, “La geometría fractal de la Naturaleza”, Tusquets editores, 2ª edición,

2003.

[23] Benoît B. Mandelbrot, “The fractal geometry of nature”, W. H. Freeman and Company, 1983.

[24] P. Bak, C. Tang y K. Wiesenfeld, “Self-organized criticality”, Phys. Rev. A, 38, 364-374, 1988.

[25] Donald L. Turcotte, “Fractals and Chaos in Geology and Geophysics”, segunda edición,

Cambridge University Press, 1997.

[26] Stefan Hergarten, “Self-organized Criticality in Earth Systems”, Springer, 2002.

[27] A. V. Descherevsky, A. A. Lukk, A. Ya. Sidorin, G. V. Vstovsky y S. F. Timashev, “Flickernoise spectroscopy in earthquake prediction research”, Natural Hazard and Earth System

Sciences, 20, 1-6, 2002.

[28] W. P. Irwin y I. Barnes, “Tectonic relations of carbon dioxide discharges and earthquakes”, J.

Geophys. Res. 85, 3115-3121, 1980.

[29] T. Gold, S. Soter, “Fluid ascent through the soil lithosphere and its relation to earthquakes”, Pure

Appl. Geophys. 122, 493-530, 1984/85.

[30] E. A. Roeloffs, “Hydrologic precursors to earthquakes: a review”, Pure App. Geophys., 126,

177-209, 1988.

[31] P. G. Silver, H. Wakita, “A search for earthquake precursors”, Science 273, 77-78, 1996.

18

[32] J.-P. Toutain y C.-J. Barbon, “Gas geochemistry and seismotectonics: a review”,

Tectonophysics, 304, 1-27, 1999.

[33] D. Sornette, “Towards a truly interdisciplinary approach to earthquake prediction”, Nature,

webpage: debate (http://helix.nature.com/debates/), 1999.

[34] R. J. Geller, D. D. Jackson, Y. Y. Kagan, F. Mulargia, “Earthquakes cannot be predicted”,

Science, 275, 1616-1617, 1997.

[35] R. J. Geller, “Earthquake prediction: a critical review”, Geophys. J. Int., 131, 425-450, 1997.

[36] Max Wyss, “Cannot earthquakes be predicted?”, Science, 278, 487-488.

[37] Max Wyss, “Why is earthquake prediction research not progressing faster?”, Tectonophysics

338, 217-223.

[38] Pascal Bernard, “From the search of ‘precursors’ to the research on ‘crustal transients’”,

Tectonophysics, 338, 225-332, 2001.

[39] M. Wyss (editor), “Evaluation of proposed earthquake precursors”, American Geophysical

Union, 1991.

[40] Immanuel Kant, “Crítica de la razón pura”, Prólogo, traducción, notas e índices por Pedro Ribas,

Alfaguara, 2000.

[41] David W. Simpson y Paul G. Richards, “Earthquake prediction: an international review”,

Maurice Ewing Series 4, American Geophysical Union, 1981.

[42] Max Wyss y Renata Dmowska (editores), “Earthquake prediction – state of the art”, Pageoph

topical volumes, Birkhäuser, 1997.

[43] H. Sigurdsson (editor), “Encyclopedia of Volcanoes”, Academic Press, 2000.

[44] Roberto Scarpa y Robert I. Tilling (editores), “Monitoring and Mitigation of Volcano Hazards”,

Springer, 1996.

[45] Andreas S. Weigend y Neil A. Gershenfeld (editores), “Time Series Prediction: forecasting the

future and understanding the past”, Santa Fe Institute Series, Addison Wesley, 1994.

19