Herramientas básicas de

Anuncio

In English

Herramientas básicas de

Matemáticas

David Casado

Universidad Complutense de Madrid

∟ Facultad de Ciencias Económicas y Empresariales

∟ Departamento de Estadística e Investigación Operativa II

31 enero 2014

∟ David Casado de Lucas

Puedes no imprimir este archivo y consultarlo en formato digital, ahorrarás papel y tinta. Si decides imprimirlo,

por favor hazlo en papel reciclado, a doble cara y con poca tinta. Sé ecológico. Muchas gracias.

Índice

Teoría de conjuntos

Álgebra y Análisis

2

4 – 14

Combinatoria

14 – 15

Probabilidad y Estadística

15 – 37

Apéndices

38 – 39

Referencias

39

Prólogo

Escribo este documento para mis estudiantes (de Estadística). Espero que sea útil para otras personas. Al final

de cada sección se ha añadido un cuadro de texto, para que los estudiantes anoten lo que quieran

(normalmente es necesario sobreescribir el archivo o guardarlo con un nombre differente).

Agradecimientos

Este documento ha sido creado con LibreOffice, OpenOffice.Org, GIMP y R. Doy las gracias a aquellos que

hacen que estos programas informáticos estén disponibles gratuitamente. De vez en cuando dono dinero a este

tipo de proyectos.

Nota cultural

En las expresiones numéricas escritas con cifras, la normativa internacional establece el uso de la coma para

separar la parte entera de la parte decimal. La coma debe escribirse en la parte inferior del renglón, nunca en la

parte superior: π = 3,1416. Pero también se acepta el uso anglosajón del punto, normal en algunos países

hispanoamericanos (→ punto, 4.4): π = 3.1416. (De: Diccionario panhispánico de dudas, de las Academias de

la lengua española, accesible aquí.)

Más matemáticas más básicas

Véase Repaso de matemáticas elementales, en http://www.casado-d.org/edu/RepasoMatematicas.pdf.

Teoría de conjuntos

Álgebra y Análisis

Algunas expresiones

Teorema binomial

Potenciación y radicación

Funciones elementales

Exponencial y logaritmo

Funciones trigonométricas

Ecuación de segundo grado

Desigualdades

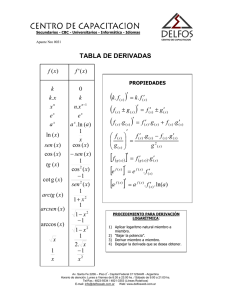

Derivación

Tabla de derivadas

Integración

Optimización de funciones: máximos y mínimos locales

Logaritmo de funciones positivas

Compleción de expresiones

Sumar y restar una cantidad

Multiplicar y dividir por una cantidad

Combinatoria

Probabilidad y Estadística

Axiomas

Experimento y variable aleatoria

Definiciones

Propiedades y resultados

Esperanza o media

Varianza

Momentos

Covarianza y correlación

Distribución de Poisson

Suma de variables de Poisson

Distribución normal

Estandarización

Suma de variables normales

Probabilidades y cuantiles: la ecuación Fθ(a) = p

¿Por el qué me preguntan?

Pregunta indirecta

Otros tipos de sucesos

Formas de buscar soluciones

Operando en la ecuación

Consultando una tabla

Discreción y acotamiento

Simetría

Tablas de una o dos colas

Utilizando un programa informático

Sucesiones de variables aleatorias

Tipos de convergencia

Algunos resultados teóricos

Estimaciones puntuales. Estadísticos y estimadores

Tipos de consistencia

Método de los momentos

Método de máxima verosimilitud

Intervalos de confianza

Definición e interpretación

Método de la cantidad pivotal

Margen de error

Tamaño muestral mínimo

Contrastes de hipótesis

1

Herramientas básicas de Matemáticas

Definición e interpretación

Proceso de contraste

Apéndices

Ecuaciones aleatorias y no aleatorias

Alfabeto griego

Prefijos métricos

Referencias

Teoría de conjuntos

Unión: El suceso A∪ B ocurre cuando alguno de los sucesos A o B sucede.

Intersección: El sucedo A∩ B ocurre cuando ocurren A y B a la vez.

Exclusión mutua: A y B son mutuamente excluyentes (o disjuntos) si A∩ B=∅ .

Complemento:

Diferencia: El suceso A ∖ B= A∩B c ocurre cuando A ocurre y B no ocurre.

Diferencia simétrica: El suceso A Δ B=(A∖ B)∪( B ∖ A) ocurre cuando sólo uno de A y B ocurre.

Ac ocurre cuando A no ocurre. Entonces, A∪ Ac =Ω y A∩ Ac =∅.

Mis notas:

Álgebra y Análisis

Algunas expresiones

2

2

2

2

(a+ b) =(a+ b)(a+ b)=a + ab+ ba+ b =a + 2ab+ b

2

(a−b) 2=(a−b)(a−b)=a 2−ab−ba+ b2=a 2−2ab+ b 2

(a+ b)( a−b)=a 2−ab+ ba−b 2=a 2 −b2

2

Herramientas básicas de Matemáticas

(a+ b) 2−( c+ d )2=(a+ b+ c+ d )⋅(a+ b−c−d )

(Utilizando la igualdad anterior.)

(a+ b)(a 2−ab+ b 2)=⋯=a 3+ b 3

(a−b)(a 2+ ab+ b 2)=⋯=a 3−b 3

Si n! denota el factorial de n, esto es, n !=n⋅(n−1)⋅(n−2)⋯2⋅1 , los coeficientes binomiales se definen

como

( nk) = k !⋅( nn−k! ) ! .

Teorema binomial

Se cumple que

()

()

()

()

( nk) =( n−kn ) ,

( )

()

( kn) x y

(x+ y )n= n x n y 0 + n x n−1 y 1+ n x n−2 y 2+ ⋯+ n x n−k y k + ⋯+ n x 1 y n −1+ n x 0 y n

0

1

2

k

n−1

n

()

n

(x+ y )n=∑k=0 n x n−k y k

k

o, dado que

n

(x+ y )n=∑ k=0

Como caso particular,

()

n

(1+ x)n=∑k=0 n x k

k

Nota: 0! = 1 y 1! = 1.

Nota: Hay una relación entre los coeficientes binomiales (o combinatorios) y el triángulo de Pascal. De la Wikipedia:

http://es.wikipedia.org/wiki/Coeficiente_binomial

http://es.wikipedia.org/wiki/Tri%C3%A1ngulo_de_Pascal

Estos coeficientes también aparecen en Combinatoria.

Mis notas:

Potenciación y radicación

Para números reales a > 0 y b > 0, y enteros (o también reales) n, m:

(1)

(3)

(5)

(7)

(9)

(11)

(13)

a 0=1

1n=1

a n a m=a n+ m

an

=a n−m

am

n

a

an

= n

b

b

n

√ ab= n √ a⋅n √ b

n

a n / m=( m √ a ) = m √ a n

(2)

a 1=a

(4)

a =

(6)

(8)

(10)

()

(12)

3

1

an

(a n )m=a nm

a n bn =( ab)n

a 1/ m= m √ a ,

n

a

n a

=n√

b

√b

−n

√

Herramientas básicas de Matemáticas

a 1/ 2= √ a

k

n−k

Nota: No es cierto: (i) Que

2

n

n

a =b

↔

a=b.

Por ejemplo,

(+ 1)2=(−1)2 .

(ii) Que

n

a =a

m

↔

n=m .

Por ejemplo,

3

(+ 1) =(+ 1) .

Mis notas:

Funciones elementales

Exponencial y logaritmo

Las propiedades de las funciones exponenciales, ax, son las mismas que en Potenciación y radicación. Para las

funciones logarítmicas (a > 0),

(1)

(3)

(5)

(7)

log a (a)=1

log a ( x y )=log a ( x )+ log a ( y)

1

log a

=log a ( x−1 )=−log a ( x)

x

log ( x)

log a ( x)= b

logb (a)

()

(2)

(4)

(6)

log a (1)=0

log a ( x n )=n log a (x )

x

log a

=log a (x )+ log a ( y−1)=log a ( x)−log a ( y )

y

()

Dado que ax y log(x) son una la inversa de otra, en el sentido funcional, se cumple que

(8)

log a (a x )=x

(9)

a

log a( x)

=x

Nota: El logaritmo natural o neperiano, caso a = e = 2.71..., se denota usualmente como ln ó log.

(Caso a > 1)

Corriendo el siguiente código de R:

x = seq(from=-5, to=+5, by=0.01) # Grid of values

f1 = exp(x)

f2 = log(x[x>0])

yLim = c(-5,+5)

x11()

# New window to plot the two functions

plot(x, f1, xlim=c(min(x),max(x)), ylim = yLim, xlab='x',

ylab='f(x)',main='Exponencial y logaritmo', type='l')

lines(x[x>0], f2)

Mis notas:

Funciones trigonométricas

Funciones directas:

sen(α)=

co

h

cos (α)=

co

sen( α) h co

tg (α)=

= =

cos (α) c a ca

h

ca

h

4

Herramientas básicas de Matemáticas

Funciones inversas, en el sentido numérico:

csc(α)=

entonces

1

h

=

sen (α) c o

sec(α)=

sen( α)csc( α)=1

1

h

=

cos (α) c a

cot( α)=

cos (α) sec( α)=1

cos (α) c a

= ,

sen(α) c o

tg (α) cot(α)=1

Funciones inversas, en el sentido funcional:

arcsen( x)=α ↔ sen( α)=x

entonces

arccos( x)=α ↔ cos (α)= x

arctg ( x)=α ↔ tg (α)=x ,

sen( arcsen( x ))= x

cos (arccos( x ))=x

tg (arctg ( x ))=x

arcsen(sen ( x ))= x

arccos(cos ( x ))=x

arctg (tg ( x ))=x

Algunas propiedades y fórmulas:

sen( x)2 + cos( x)2 =1

1+ tg ( x )2=1+

sen( x )2 cos (x )2+ sen ( x )2

1

=

=

2

2

cos( x)

cos( x)

cos (x )2

sen( x± y)=sen( x) cos( y)±cos( x)sen ( y )

cos ( x± y )=cos ( x )cos ( y )∓sen( x) sen( y )

tg ( x± y )=

tg( x)±tg ( y )

1∓tg ( xy)

entonces

entonces

sen( 2 x)=2 sen( x) cos ( x)

cos (2 x )=cos (x )2−sen( x) 2

tg (2 x )=

entonces

2 tg (x)

1−tg ( x 2 )

( ) ( )

x+ y

x− y

cos( x)+ cos ( y)=2 cos (

cos (

)

2

2 )

x+ y

x− y

cos (x)−cos ( y)=−2 sen (

sen

( 2)

2 )

x

1−cos( x)

x

1+ cos ( x )

x

1−cos ( x )

sen ( ) =±

cos ( ) =±

tg ( ) =±

2

2

2

√ 2

√ 2

√ 1+ cos ( x )

sin( x)±sin ( y)=2 sin

x± y

x∓ y

cos

2

2

Algunos valores:

(Las raíces cuadradas de

los numeradores son una

regla mnemotécnica)

0º

30º

45º

60º

90º

0

π/6

π/4

π/3

π/2

sen(α)

√0/2 = 0

√1/2 = 1/2

√2/2

√3/2

√4/2 = 1

cos(α)

√4/2 = 1

√3/2

√2/2

tg(α)

0

1/√3 = √3/3

1

√1/2 = 1/2 √0/2 = 0

√3

-------

Las siguientes relaciones pueden deducirse fácilmente dibujando los ángulos en el círculo unitario:

sin( π ∓α)=cos (α)

sen(−x )=−sen( x)

sen( 2 π−α)=−sen(α)

sen( π∓α)=±sen (α)

2

5

Herramientas básicas de Matemáticas

cos (−x)=cos( x)

cos (2 π−α)=cos (α)

tg (−x)=−tg (x )

cos ( π ∓α)=±sin(α)

2

cos (π∓α)=−cos(α)

tg (2 π−α)=−tg (α)

1

cos ( π ∓α)=±

2

tg(α)

tg (π∓α)=∓tg(α)

Figuras:

De la Wikipedia:

Mis notas:

Ecuación de segundo grado

El Teorema Fundamental del Álgebra garantiza que hay dos soluciones, ambas reales o ambas complejas (un

par de números complejos conjugados). Las soluciones de la ecuación general

2

a x + b x+ c=0

pueden obtenerse completando cuadrados:

2

→

a x + b x=−c

→

(

√ a x+

b

2√ a

)

2

( √ a x) + 2 √ a

2

=−c+

(√)

b

b

2√ a

x=−c

2

→

2 a

→

√ a x+

→

b

2√ a

2

( √ a x) + 2 √ a

√

= −c+

b2

2

( 2 √ a)

b

2√ a

→

x+

(√)

b

2 a

√ a x=

2

=−c+

(√)

b

2

2 a

−b √ b2 −4ac

±

2√ a

2√ a

−b±√ b2 −4ac

x=

2a

Normalmente aplicamos esta última fórmula, pero si la olvidamos también podemos repetir los pasos

anteriores.

De la Wikipedia

6

Herramientas básicas de Matemáticas

Mis notas:

Desigualdades

Las desigualdades son expresiones algebraicas que involucran relaciones como «menor» (<), «menor o igual»

(≤), «mayor» (>) y «mayor o igual» (≥). Para trabajar con ellas, es útil ver antes las ideas que hay detrás de las

igualdades.

Igualdades

Se cumple que:

(a) Transitividad: Si a = b y b = c, entonces a = c.

(b) Adición y sustración: Dado que los dos miembros son iguales, ambos permanecen iguales después de

sumarles o restarles la misma cantidad.

(c) Multiplicación y división: Dado que los dos miembros son iguales, ambos permanecen iguales

después de multiplicarlos o dividirlos por la misma cantidad.

(d) Transformación general: Dado que los dos miembros son iguales, ambos permanecen iguales

después de aplicarles la misma transformación. Algunas transformaciones interesantes son:

f(x) = x+c y f(x) = x–c llevan a (b).

f(x) = cx y f(x) = x/c llevan a (c).

f(x) = 1/x, definida para x ≠ 0, lleva a que a = b → 1/a = 1/b (para a y b no nulos).

f(x) = x2 lleva a que a = b → a2 = b2.

f(x) = log(x), definida para x > 0 (se puede definir para x < 0 utilizando números complejos).

f(x) = √x, definida para x ≥ 0 (se puede definir para x < 0 utilizando números complejos).

f(x) = |x|.

Hablando con ligereza se dice que algunas cantidades «se mueven» de un miembro al otro, desde un

numerador a un denominador o viceversa, pero de hecho nada se mueve: lo que sucede es que estas cantidades

desaparecen porque se le aplica una cantidad opuesta a ambos miembros, de manera que el par se convierte en

el elemento neutro (cero para la suma y uno para la multiplicación). Por ejemplo:

2

2

2

2x −3=1 → 2x −3+ 3=1+ 3 → 2x =1+ 3 →

1 2 1

1+ 3

2x = (1+ 3) → x 2=

=2 → x=±√ 2

2

2

2

Desigualdades

Para las desigualdades, algunos cálculos son algo más difíciles que para las igualdades, pero la forma de

pensar es la misma:

7

Herramientas básicas de Matemáticas

(a) Transitividad: Si una primera cantidad es menor que una segunda cantidad, y esta segunda es menor

que una tercera, entonces la primera es menor que la tercera.

Si a < b y b < c, entonces a < c (lo mismo se cumple con ≤, > o ≥ en vez de <)

Si a < b y b ≤ c, entonces a < c (lo mismo se cumple con > y ≥ en vez de < y ≤)

Si a < b y b = c, entonces a < c (lo mismo se cumple con ≤, > o ≥ en vez de <)

(b) Adición y sustración: Si un miembro es menor o igual (por ejemplo) que otro, sigue siendo menor o

igual cuando a ambos se les suma o resta la misma cantidad.

Si a < b, entonces a + c < b + c y a − c < b − c (lo mismo se cumple con ≤, > o ≥ en vez de <)

(c) Multiplicación y división: Si un miembro es menor o igual (por ejemplo) que otro, sigue siendo

menor o igual cuando a ambos se les multiplica o divide por la misma cantidad positiva, pero se

convierte en mayor o igual si a ambos miembros se les multiplica o divide por la misma cantidad

negativa.

Para c positiva y a < b, ac < bc y a/c < b/c (lo mismo se cumple para ≤, > o ≥ en vez de <)

Para c negativo y a < b, ac > bc y a/c > b/c (lo mismo se cumple con > y < en vez de < y >,

con ≤ y ≥ en vez de < y >,

y con ≥ y ≤ en vez de < y >)

Como caso particular (c = –1): si a < b entonces −a > −b, si a > b entonces −a < −b, si...

(d) Transformación general: En general, la relación de una desigualdad cambia después de aplicar la

misma transformación a ambos miembros. Esto depende tanto de los miembros concretos como de la

transformación particular. Es necesario razonar con algunas propiedades en mente, por ejemplo: (1) si

a < b y g(x) es estrictamente creciente, entonces g(a) < g(b); (2) si a < b y g(x) es estrictamente

decreciente, entonces g(a) > g(b); (3)...

f(x) = x+c y f(x) = x–c llevan a (b). (Ambas son crecientes.)

f(x) = cx y f(x) = x/c llevan a (c). (Ambas son crecientes para c > 0 y decrecientes para c < 0.)

f(x) = 1/x, definida para x ≠ 0, lleva a a = b → 1/a = 1/b. (Es decreciente pero discontinua.)

f(x) = x2 (Es decreciente en x < 0 y creciente en x > 0.)

f(x) = log(x), definida para x > 0. (Es creciente.)

f(x) = √x, definida (números reales) para x ≥ 0. (Es creciente para las raíces positivas.)

f(x) = |x| (Es decreciente en x < 0 y creciente en x > 0.)

El dibujo de una función nos dice cómo cambia una inigualdad cuando a sus dos miembros se les

aplica la función.

8

Herramientas básicas de Matemáticas

Cualquier función estrictamente creciente (decreciente) preserva (invierte) el orden de las cantidades,

lo que implica que las funciones g(x) y f(g(x)) tienen los máximos y mínimos relativos en las mismas

posiciones (aunque los valores que alcanzan ambas funciones en estas posiciones son distintos).

Cuando el interés está en la posición, este hecho puede utilizarse es más fácil trabajar con f(g(x)). Estas

afirmaciones se pueden probar fácilmente utilizando la regla de la cadena, aunque sólo se incluye aquí

un ejemplo:

(e) La función g ( x)=( x−1)2+ 2 tiene un mínimo en x0 = 1:

g ' (x )=2( x−1)=0 → x 0=1 es un extremo

g ' ' ( x)=2 > 0 → El extremo es un mínimo

2

Para la función estrictamente creciente f (x )=e x , se cumple que h( x)= f (g ( x ))=e( x−1 ) + 2 tiene

también un mínimo en x0 = 1:

2

h ' ( x)=e(x−1) + 2 2( x−1)=0 → x 0=1 es un extremo

( x−1) +2 2

2

(x−1) + 2

2

h ' ' ( x )∣x=x =[ e

2 ( x−1) +e

2 ]∣x= x =e 2 > 0 → El extremo es un mínimo

2

2

0

0

2

Para la función estrictamente decreciente f (x )=e− x , se cumple que h( x)= f ( g (x ))=e−( x−1) −2

tiene un máximo en 1:

2

h ' ( x)=e(x−1) + 2 2( x−1)=0 → x 0=1 es un extremo

−( x−1 ) −2 2

2

−( x−1) −2

−2

h ' ' ( x )∣x=x =[ e

2 ( x−1) −e

2 ]∣x=x =−e 2 > 0 → El extremo es un máximo

2

2

0

0

Ver Logaritmo de la función sobre la importancia de log(x) cuando se buscan máximos y mínimos.

Entonces, los posibles cambios en las desigualdades se pueden deducir. Por ejemplo, si f(x) = 1/x:

Si a y b son ambas positivas o ambas negativas

Si a < b entonces 1/a > 1/b

Si a > b entonces 1/a < 1/b

Si alguno de a ó b es negativo (pero no ambos)

Si a < b entonces 1/a < 1/b

Si a > b entonces 1/a > 1/b

O, para f(x) = log(x):

Si a y b son positivos (necesario para aplicar esta función),

Si a < b entonces log(a) < log(b)

Mis notas:

Derivación

Tabla de derivadas

•

x a , donde a es un número real → ax a −1 (a puede ser positivo, negativo, entero, decimal...)

•

1

x

•

x →

→

−1

x2

1

2 x

(Es un caso particular del punto anterior.)

(Es un caso particular del primer punto.)

9

Herramientas básicas de Matemáticas

1

log a e

x

•

log a x

•

ln x

•

a

x

→

a x ln a

•

e

x

→

e

•

sen x

→

cos x

•

cos ( x )

→

−sen x

•

tg x

•

arcsen x

→

1

1−x 2

•

arccos x

→

−1

1−x 2

•

arctg x

→

1

x

→

x

(Es un caso particular del punto anterior.)

(Es un caso particular del punto anterior.)

1

cos x2

→

→

ó 1+ tg ( x )2 (Ambas expresiones son equivalentes.)

1

2

1x

Combinaciones de funciones

•

Adición: f x g x⋯

•

Sustración: f x −g x−⋯

•

Multiplicación: f x ⋅g x

•

Multiplicación por una constante: c⋅ f x

•

División:

•

Inversión, en el sentido numérico:

•

•

f x

g x

f ' x g ' x⋯

→

→

→

f ' x− g ' x−⋯

f ' x⋅g x f x ⋅g ' x

→

c⋅ f ' x (Es un caso particular del punto anterior.)

f ' x ⋅g x− f x⋅g ' x

g 2 x

→

− f ' x

(Es un caso particular del punto anterior.)

f 2 x

1

Inversión, en el sentido funcional: f −1( x) →

f ' ( f −1 ( x ))

1

f x

→

Composición: ( g ∘ f )( x)=g ( f (x )) → g ' f x ⋅ f ' x (Regla de la cadena)

La tabla anterior de derivadas y la regla de la cadena implican que:

•

a

a −1

f x , donde a es un número real → a f x f ' x

•

1

f ( x)

•

√ f ( x)

•

log a f x

→

→

−1

f ' ( x) (Es un caso particular del punto anterior.)

f ( x)2

1

f ' (x ) (Es un caso particular del primer punto.)

2 √ f ( x)

→

1

log e f ' x

f x a

10

Herramientas básicas de Matemáticas

1

f ' x (Es un caso particular del punto anterior.)

f x

•

ln f x

→

•

a f x

→

a

f x

ln a f ' x

•

e

f x

→

e

f x

f ' x (Es un caso particular del punto anterior.)

•

sen f x

→

cos f x f ' x

•

cos f x

→

−sen f x f ' x

•

tg f x

•

arcsen f x

→

1

f ' x

1− f x 2

•

arccos f x

→

−1

f ' x

1− f x 2

•

arctg f x

→

1

f ' x

cos f x2

ó

[1tg f x 2 ] f ' x

1

f ' x

1 f x 2

→

Nota: Para recordar esta última tabla a partir de la primera: (1) x → f(x) and (2) · f '(x).

Mis notas:

Integración

Integrales indefinidas

Propiedades

•

•

•

∫ [ f xg x ⋯]dx=∫ f x dx∫ g x dx⋯

Sustración: ∫ [ f x−g x −⋯]dx=∫ f x dx−∫ g x dx−⋯

Multiplicación por una constante: ∫ k⋅ f x dx=k⋅∫ f x dx

Adición:

Integrales inmediatas

Para resolver estas integrales, normalmente es suficiente tener en mente la Tabla de derivativas; algunas veces

es necesario ajustar o reescribir factores: véanse los ejemplos dados en Sumar y restar una cantidad y

Multiplicar y dividir por una cantidad. Integrales algo más complicadas se han resuelto en [1].

Integrales definidas

Propiedades

b

•

b

a

b

•

b

∫ [ f ( x)± g ( x )]dx=∫ f ( x) dx±∫ g ( x ) dx

a

a

b

∫ k⋅ f x dx=k⋅∫ f x dx

a

a

11

Herramientas básicas de Matemáticas

b

•

∫ k dx =k⋅b−a

a

a

•

∫ f x dx=0

a

b

•

a

∫ f x dx=−∫ f x dx

a

b

•

∫

a

b

c

b

f (x )dx=∫ f ( x ) dx+ ∫ f (x )dx , if a<c<b

a

c

Teoremas

Primer Teorema Fundamental del Cálculo Integral

x

d

∫ f t dt= f x

dx a

Segundo Teorema Fundamental del Cálculo Integral o Regla de Barrow

b

∫ f x dx=F b−F a

a

donde F(x) es la integral indefinida de f(x), es decir, F'(x) = f(x).

Algunas aplicaciones: cálculo de áreas

b

Área bajo una función positiva =

∫

b

Área sobre una función negativa = −∫ f x dx

f x dx

a

a

c

Área determinada por una función positiva en x < c y negativa en x > c =

b

∫

a

f x dx−∫ f x dx (a<c<b)

c

c

∫ g x− f x dx ,

Área determinada por dos funciones =

si g(x) es siempre mayor que f(x)

a

(en otro caso, se deben considerar varios intervalos)

b

Área de la superficie generada al girar una gráfica sobre el eje horizontal =

∫ 2 f x 1 f ' x 2 dx

a

Algunas aplicaciones: cálculo de la longitud de arco

b

Longitud de una curva t = x t , y t =

∫ x ' t2 y ' t 2 dt

a

b

Longitud de un gráfico x= x , f x =

∫ 1 f ' x 2 dx

a

Algunas aplicaciones: cálculo de volúmenes

b

Volumen cuyas secciones sonA(x) =

∫ A( x)dx

(Principio de Cavalieri / Método de las secciones)

a

12

Herramientas básicas de Matemáticas

b

Volumen determinado al girar un gráfico alrededor del eje horizontal =

∫ f x2 dx

a

(pensar en el método anterior)

b

Volumen determinado al girar un gráfico sobre el eje vertical =

∫ 2 x f x dx

a

(pensar en cortezas cilíndricas de radio x y altura f(x))

Mis notas:

Optimización de funciones: máximos y mínimos locales

Una variable

Para encontrar los valores extremos x0 de una función derivable unidimensional f(x), debe resolverse la

ecuación

d

f ( x )=0 ,

dx

dado que es una condición necesaria. La segunda derivada contiene información sobre la forma de la función:

d2

f (x ) < 0 , la función f(x) tiene un máximo relativo o local en x0.

(a) Si

dx 2

d2

f (x ) > 0 , la función f(x) tiene un mínimo relativo o local en x0.

(b) Si

dx 2

d2

f (x ) = 0 , la función f(x) tiene un punto de inflexión en x0.

(c) Si

dx 2

Dos variables

Para encontrar los valores extremos (x0,y0) de una función derivable bidimensional f(x,y), debe resolverse el

sistema de ecuaciones

∂ f ( x , y )=0

∂x

∂ f ( x , y )=0

∂y

{

dado que supone una condición necesaria. La derivadas de segundo orden contienen información sobre la

forma de la función y para D = B2–AC, donde

2

A= ∂ 2 f (x , y ),

∂x

(a)

(b)

(c)

(d)

B=

2

∂

f ( x , y ),

∂x∂y

2

C= ∂ 2 f ( x , y ) ,

∂y

Si D < 0 y A < 0, la función f(x,y) tiene un máximo relativo o local en (x0,y0).

Si D < 0 y A > 0, la función f(x,y) tiene un mínimo relativo o local en (x0,y0).

Si D > 0, la función f(x,y) tiene un punto de inflexión en (x0,y0).

Si D = 0, no se puede decir nada sobre el comportamiento de la función f(x,y) en (x0,y0).

Logaritmo de funciones positivas

Cualquier función estrictamente creciente (decreciente) f(x) preserva (invierte) el orden de las cantidades, lo

13

Herramientas básicas de Matemáticas

que implica que las funciones g(x,y) y f(g(x,y)) tienen los máximos y mínimos relativos en las mismas

posiciones (aunque los valores que alcanzan ambas funciones en esas posiciones son distintos). Cuando el

interés está en la posición, este hecho puede utilizarse si es más fácil trabajar con f(g(x,y)). Dado que f(x) =

log(x) es estrictamente creciente —véase la figura en Exponencial y logaritmo—, convierte los productos en

sumas y los exponentes en factores multiplicativos, frecuentemente se utiliza para buscar la posición de los

máximos y mínimos relativos (nótese que, dado que la función logaritmo está definida sólo para x positivos,

es necesario que g(x,y) > 0). Ver, por ejemplo, los ejercicios de [1].

Mis notas:

Compleción de expresiones

En ocasiones nos gustaría tener una cantidad concreta en la expresión con la que estamos trabajando. Algunos

trucos para hacerla aparecer son los siguientes:

Sumar y restar una cantidad

f (x )= f (x )+ 0= f ( x )+ c−c=[ f ( x )+ c ]−c

Ejemplo:

x2

x 2+ 1−1

x 2 + 1−1

dx=

dx=

∫ x 2+ 1 ∫ x 2+ 1

∫ x 2+ 1 dx=∫ 1 dx−∫ x 21+ 1 dx=x−arctg ( x )+ c

Mis notas:

Multiplicar y dividir por una cantidad

c

1

f ( x )= f (x )⋅1= f ( x)⋅ =[ f (x )⋅c ]⋅

c

c

Ejemplo:

3

1

3

1

3

1

3

∫ x 2 e x dx =∫ 3 3 x 2 e x dx= 3 ∫ 3 x 2 e x dx= 3 e x + c

Mis notas:

Combinatoria

Sea A = {a1, a2, ..., an} un conjunto de elementos distintos. Para formar todos los posibles vectores de tamaño

k, donde los elementos deben ser diferentes (k < n) y su posición (en el vector) tiene significado, hay n

candidatos para la primera posición, n–1 candidatos para la segunda... y n–(k–1) para la k-ésima posición. El

número total de posibles vectores es:

V nk =n⋅( n−1)⋅(n−2)⋯(n−[k −1])=

n!

.

( n−k ) !

Si los elementos pueden repetirse, está permitido cualquier valor para k (menor, igual o mayor que n) y hay n

candidatos para cada posición, por lo que:

14

Herramientas básicas de Matemáticas

VRkn=n⋅n⋅⋯n=n k .

Si deben colocarse todos los elementos de A, esto es, si la longitud del vector es n, los elementos deben ser

diferentes y su posición tiene significado, el número de posibles vectores es:

P n=n⋅(n−1)⋅(n−2)⋯1=n ! ,

esto es, P n=V nn . Si se permiten elementos repetidos, podemos empezar considerando que a1 aparece k

veces. Definamos A' = {a1,1, a1,2,... a1,k, ak+1, ..., an}, donde a1,1, a1,2,... a1,k son indistinguibles. Entonces, hay Pn

posibles vectores, de los cuales Pk son indistinguibles (para cada combinación global):

PRkn =

Pn n !

= .

Pk k !

Ahora, si se permite que p elementos se repitan, y ai aparece ki veces, con

PR

k 1, k 2, ⋯, k p

n

k 1, k 2, ⋯, k p−1

=⋯=

PRn

Pk

=

p

p

∑i=1 k i =n ,

n!

.

k 1 !⋅k 2 ! ⋯k p !

Para formar todos los posibles vectores de tamaño k, donde los elementos deben ser diferentes (entonces k <

n) y su posición no tiene significado, Pk de ellos son indistinguibles (todas las posibles permutaciones de las

posiciones, no los propios elementos) por lo que:

k

C kn =

Vn

n!

=

= n .

P k (n−k )!⋅k ! k

()

Por último, si ai de A aparece ki veces (la longitud del vector puede ser menor, igual o mayor que n) y la

posición no tiene significado, es posible pensar en un vector con k elementos y (n–1) símbolos separadores

que dividen el vector en n regiones con ki posiciones, una para cada ai. Entonces, cuando se eligen las

posiciones de los k elementos —o, alternativamente, de los símbolos— el vector está determinado, por lo que

k

k

CR n=C k+ n−1 .

Mis notas:

Probabilidad y Estadística

Para experimentos aleatorios o estocásticos, todos los posibles resultados («cosas que pueden ocurrir»)

forman el espacio muestral Ω . Un suceso es cualquier subconjunto del espacio muestral, y puede ser

elemental o ser la unión o intersección de otros; todos estos sucesos forman una colección A (σ-álgebra) de

subconjuntos del espacio muestral. Hay una función P (probabilidad) que asigna a cada suceso un número

entre 0 y 1 (probabilidad). Una distribución de probabilidad está determinada una vez que se conocen los

valores y sus probabilidades. Es suficiente con definir esta función sobre una base de A. Por ejemplo, la

colección de sucesos {X ≤ x} es una base de la σ-álgebra definida para variables aleatorias reales (σ-álgebra

de Borel); por este motivo la función de distribución determina la distribución de probabilidad.

15

Herramientas básicas de Matemáticas

Axiomas

La probabilidad P debe verificar algunos axiomas:

a) P (Ω)=1

b) P (A)≥0

∀A∈ A

∞

c) Para sucesos mutuamente excluyentes (disjuntos) Ai, P (U ∞i=1 Ai)=∑ P( Ai )

i =1

Mis notas:

Experimento y variable aleatoria

Una variable aleatoria es una función que traduce la información de un experimento al lenguaje numérico.

Por ejemplo, para el experimento de lanzar una moneda:

→ X →

Ω

ℝ

{Cara}

→

{X = 1}

{Cruz}

→

{X = 0}

Como consecuencia, aparece otro espacio de probabilidad. En este documento, las letras A y B representarán

sucesos en cualquiera de los dos espacios. Sin embargo, podemos hablar directamente de variables aleatorias,

sin mencionar ningún experimento, como «modelos teóricos que pueden utilizarse para representar cualquier

experimento de un tipo concreto».

Mis notas:

Definiciones

Número de casos favorables a A

.

Número de casos posibles

Regla de Laplace: Cuando es posible contar, P (A)=

Probabilidad condicional: Si P (B)≠0 ,

Independencia: A y B son independientes si P (A∣B)=P ( A) , esto es, si a A no le influye B.

P ( A∣B)=

P ( A∩ B)

.

P ( B)

Mis notas:

16

Herramientas básicas de Matemáticas

Propiedades y resultados

La mayoría de estos puntos son fáciles de recordar o deducir dibujando diagramas de Venn.

P (∅)=0 .

Suceso vacío:

Inclusión:

Exclusión mutua: Si A∩ B=∅ ,

Complemento: 1=P (Ω)=P (A∪ Ac )= P( A)+ P ( Ac ) → P (Ac )=1−P ( A) .

Unión (2):

A⊆ B → P ( A)≤P (B). También, P (A∩ B)≤P (A) y P (A∩ B)≤P (B).

P ( A∩B)=P (∅)=0 .

P (A∪ B)=P (A)+ P (B)− P( A∩B) .

Como consecuencia, P (A∪ B)≤P (A)+ P (B) . Si A∩ B=∅ ,

P (A∪ B)=P (A)+ P (B) .

Intersección (2): P (A∩ B)=P (B)⋅P ( A∣B).

Se cumple que P ( A∩B)=P ( A)+ P ( B)−P ( A∪B) , por lo que P ( A∩B)≤P ( A)+ P ( B) .

Por otro lado, si P (A∣B)=P ( A) entonces P (A∩ B)=P (B)⋅P ( A).

A⊆ B → P (B ∖ A)=P ( B)− P( B∩ A) .

Diferencia:

Diferencia simétrica:

Probabilidad condicional: Como P (A∩ B)=P (B∩A) , ahora P (B)⋅P ( A∣B)=P ( A)⋅P (B∣A).

Independencia: P (A∩ B)=P (A)⋅P ( B).

Probabilidad total:

P ( A Δ B)= P( {A ∖ B }∪{B ∖ A})=P ( A)+ P (B)−2P( A∩ B).

P (S )=P ( ∪ni=1 {S ∩ Ai })=P ( A1)⋅P ( S∣A1 )+ P ( A2 )⋅P ( S∣A2 )+⋯+ P ( An )⋅P ( S∣An ).

Teorema de Bayes:

P (Ai∣S )=

P( Ai)⋅P (S∣Ai)

P ( Ai )⋅P (S∣Ai)

=

.

P(S )

P (A1 )⋅P (S∣A1)+ P( A2 )⋅P (S∣A2)+ ⋯+ P ( An)⋅P (S∣An)

Intersección (n): P( ∩kj=1 A j)=P ( A 1)⋅P ( A 2∣A 1)⋅P( A 3∣A 1∩ A2 )⋯P( A k∣∩k−1

j=1 A j )

k

Unión (n): P( ∪j=1 A j) =

Por tanto, P( ∪kj=1 A j) ≤

∑1≤ j≤k P (A j ) − ∑1≤i< j≤k P( Ai∩ A j ) + ⋯

⋯ + ∑1≤i< j<k ≤k P ( Ai∩ A j∩ A k ) ++ (−1)k+1 P( ∩kj=1 A j)

k

∑j =1 P( A j ) .

Mis notas:

17

Herramientas básicas de Matemáticas

Esperanza o media

Definición

➔

Para una variable aleatoria discreta: E ( X )=∑Ω x i f (x i )=∑Ω x i P( X = x i)

➔

Para una variable aleatoria continua: E ( X )=∫Ω x f ( x)dx

Para cualquier función g,

E (g ( X ))=∑Ω g ( xi ) f (x i ) y E (g ( X ))=∫Ω g ( x ) f ( x)dx .

Propiedades principales

(1) Si c es un número, E (c)=c

(2) Si c es un número, E (cX )=c E( X )

(3)

E ( X + Y )=E ( X )+ E( Y )

E ( X −Y )= E( X )−E (Y )

(4) Si c es un número, E ( X + c)=E (X )+ c (Puede ser visto como un caso particular del punto 2.)

(5) Si X e Y son independientes, E ( X⋅Y )=E ( X )⋅E (Y )

Nota: Algunas veces las propiedades (2) y (3) se resumen en

Nota: Una demostración sencilla

E (aX ±bY )=a E ( X )±b E (Y ).

E ( X −Y )= E( X +(−Y ))= E( X )+ E (−Y )=E ( X )+(−E(Y ))= E( X )−E (Y ) .

Estimador o «versión muestral»

Cuando se utiliza una muestra aleatoria simple X1,X2,...,Xn (elementos independientes e idénticamente

distribuidos), el estimador más natural de E ( X ) es la media muestral:

̄ = 1 ∑i=1 X i

X

n

n

n

∑i=1

Escrita como

( X ⋅1n ) , la media muestral recuerda a la esperanza de una variable discreta (una muestra

i

«es siempre discreta», incluso para variables continuas Xi). Algunas propiedades teóricas importantes son:

(

)

1 n

1

Xi = E

∑

i=1

n

n

( ∑i=1 X i ) = 1n ∑i =1 E ( X i ) = 1n n E ( X ) =E ( X ) =μ

n

(a)

̄ )=E

E(X

(b)

n

̄ )=Var 1 ∑ X i = 1 Var

Var ( X

n i=1

n

(

)()

2

n

(∑

n

i=1

)

Xi =

Independencia de Xi

1 n

1

σ2

Var

X

=

n

Var

(

X

)

=

∑

(

)

i

n

n 2 i=1

n2

(c) Algunas otras propiedades, similares a las de la contraparte poblacional E ( X ) , son fáciles de

̄ + c , cX =c X

̄,

X + Y = X̄ + Ȳ , ...

probar: X + c= X

Mis notas:

Varianza

Definición

➔

Para una variable aleatoria discreta:

2

Var ( X )= E([ X − E( X )]2)=∑Ω [ x i−E ( X )]2 f (x i )=∑Ω [ x i−∑Ω x j f ( x j )] f (x i )

18

Herramientas básicas de Matemáticas

➔

Para una variable aleatoria continua:

2

Var ( X )= E([ X − E( X )] 2)=∫Ω [ x−E ( X )]2 f ( x)dx =∫Ω [ x−∫Ω y f ( y)dy ] f (x )dx

Propiedades principales

(1) Si c es un número, Var (c )=0

(2) Si c es un número, Var (cX )=c 2 Var ( X )

(3)

Var ( X +Y )=Var ( X )+Var (Y )+ 2Cov( X , Y )

Var ( X −Y )=Var ( X )+ Var (Y )−2Cov( X , Y )

Las variables independientes están incorreladas (lo contrario no es siempre cierto), Cov( X ,Y )=0 ,

por lo que

Var ( X + Y )=Var ( X )+ Var (Y ) y Var ( X −Y )=Var ( X )+ Var (Y )

(4) Si c es un número, Var ( X + c)=Var ( X ) (Puede verse como un caso particular del punto 2.)

(5)

Var ( X )= E( X 2 )−E ( X )2 (La varianza se calcula aplicando la definición o esta propiedad.)

Nota: Algunas veces las propiedades (2) y (3) se resumen en

2

2

Var (aX ±bY )=a Var ( X )+b Var (Y ).

Var ( X −Y )=Var ( X +(−Y ))=Var ( X )+Var (−Y )+2Cov( X ,−Y )

(Utilizando una propiedad de la covarianza) =Var ( X )+Var (Y )+(−2Cov ( X ,Y ))=Var (X )+ Var (Y )−2Cov( X , Y ).

Nota: Una demostración sencilla

Estimadores o «versiones muestrales»

Cuando se utiliza una muestra aleatoria simple X1,X2,...,Xn, los estimadores más naturales de Var ( X ) son la

varianza muestral y la cuasivarianza muestral:

s 2=

1 n

1 n

1 n

[ X i − X̄ ] 2= ∑i =1 [ X i − ∑ j=1 X j ]

∑

i =1

n

n

n

(

2

2

y S =

n

1

[ X i− X̄ ]2

∑

i

=1

n−1

)

2

1 n

1

X

]

⋅ , la varianza muestral recuerda a

∑

j

j =1

n

n

la varianza de una variable discreta. Algunas propiedades teóricas importantes son:

(Se cumple que ns2 = (n–1)S2.) Escrita como

(a)

n

∑i=1

[ X i−

(

n

n

n

1 n

̄ ]2= 1 ∑ X i2−( X

̄ ) 2= 1 ∑ X 2i − 1 ∑ X i

[ X i− X

∑

i=1

i=1

i=1

i

=1

n

n

n

n

calculada aplicando la definición o esta propiedad.)

s 2=

(b)

E (s 2)=⋯=Var ( X )−

(c)

E (S 2 )=⋯=Var ( X )

)

2

(La varianza muestral es

Var ( X ) n−1

=

Var ( X ) . Nótese que E (s 2) → Var ( X ) cuando n crece.

n

n

Nota: Los puntos (b) y (c) justifican la existencia de la cuasivarianza muestral.

Programas informáticos: Dado que S2 es un estimador insesgado de la varianza y s2 es sólo asintóticamente

insesgado, generalmente se implementa en los programas informáticos el primero bajo el nombre «varianza»

(o variance). Para probar cuál está implementado en un programa, es suficiente evaluar la función, digamos

3

var(), con el conjunto de datos (1,2,3); entonces, ̄x =2 y ∑i=1 ( x i− ̄x )2=(1−2)2 + (2−2) 2+ (3−2)2=2 ,

por lo que si s2 está implementada, var(1,2,3)= 2/3 mientras que si S2 está implementada,

var(1,2,3)= 2/2 = 1. También se puede consultar la ayuda del programa.

19

Herramientas básicas de Matemáticas

Mis notas:

Momentos

Definición

➔

Para una variable aleatoria discreta, el momento de orden r centrado con respecto a cero es

μ r ( X )=E ( X r )=∑Ω x ri f ( x i )

y el momento de orden r centrado con respecto a la media es

r

σ r ( X )=E ([ X −E ( X )] r )=∑Ω [ x i− E( X )]r f ( xi )=∑Ω [ x i −∑ Ω x j f ( x j)] f ( x i )

➔

Para una variable aleatoria continua, el momento de orden r centrado con respecto a cero es

r

r

μ r ( X )=E ( X )=∫Ω x f (x )dx

y el momento de orden r centrado con respecto a la media es

r

σ r ( X )=E ([ X −E ( X )] r )=∫Ω [ x−E ( X )] r f ( x )dx=∫Ω [ x−∫Ω y f ( y) dy ] f ( x)dx

Estimadores o «versiones muestrales»

Cuando se utiliza una muestra aleatoria simple X1,X2,...,Xn, los estimadores más naturales posibles de los

momentos son, respectivamente

mr =

1 n

X ri

∑

i

=1

n

y

s r=

r

1 n

1 n

1 n

r

̄

[

X

−

X

]

=

[

X

−

X

]

∑

∑

∑

i

i

j

n i=1

n i =1

n j=1

Sobre la convergencia de estos estimadores a su contraparte poblacional, véase Algunos resultados teóricos.

Nota: En la literatura se utilizan distintas letras para denotar todos estos momentos.

Mis notas:

Covarianza y correlación

Definición

➔

Para un par de variables aleatorias discretas:

Cov( X ,Y )= E([ X −E ( X )][Y − E(Y )])=∑Ω

=∑Ω

➔

X

∑Ω ( [ xi −∑Ω

Y

X

X

∑Ω ( [ x i −E ( X )][ y j−E (Y )] f (x i , y j ) )

Y

x k f X ( x k )][ y j−∑Ω y l f Y ( y l )] f ( x i , y j ) )

Y

Para un par de variables aleatorias continuas:

Cov( X ,Y )= E([ X −E ( X )][Y − E(Y )])=∫Ω

=∫Ω

X

∫Ω

Y

X

∫Ω [ x− E( X )][ y− E(Y )] f ( x , y)dx dy

Y

[x −∫Ω k f X (k ) dk ][ y−∫Ω l f Y (l ) dl] f ( x , y ) dx dy

20

X

Y

Herramientas básicas de Matemáticas

En ambos casos, debe utilizarse la distribución conjunta de (X,Y) para la esperanza exterior, y las

distribuciones marginales en las interiores.

Propiedades principales

(1)

Cov( X , X )= E([( X )−E ( X )]⋅[ X −E ( X )])=E ([( X )−E ( X )] 2)=Var ( X )

(2)

Cov( X 1+ X 2, Y )=E ([( X 1+ X 2 )−E ( X 1 + X 2 )]⋅[Y −E (Y )])

=E ([ X 1+ X 2−E ( X 1)−E ( X 2 )]⋅[Y −E (Y )])=⋯=Cov ( X 1, Y )+ Cov ( X 2, Y )

(3) Si c es un número, Cov( X , c)=E ([ X −E ( X )]⋅[c−c ])=0

(4) Si c es un número, Cov( X + c ,Y )=Cov( X ,Y )+ Cov( c ,Y )=Cov( X , Y )

(5) Si c es un número, Cov( cX , Y )=E ([cX −c E( X )]⋅[Y −E (Y )])=c Cov ( X , Y )

(6)

Cov( X ,Y )=E ( X⋅Y )−E ( X ) E (Y ) (La covarianza es calculada aplicando la definición o esta

propiedad.)

Correlación

En ambos casos (variables discretas y continuas), se define en términos de las correspondientes covarianzas:

Corr ( X , Y )=

Cov( X ,Y )

Cov( X , Y )

=

√ Cov ( X , X ) √ Cov (Y , Y ) √ Var ( X ) √ Var (Y )

Las propiedades básicas de la correlación pueden deducirse de las de la covarianza.

Estimadores o «versiones muestrales»

En la literatura se definen también estimadores o «versiones muestrales» de la covarianza y la correlación.

Mis notas:

Distribución de Poisson

Suma de variables de Poisson

Teorema 1vp

Dadas variables aleatorias independientes (X1, ..., Xn) tales que Xi sigue una distribución de Poisson de

parámetro λi se tiene que

X i ∼ P( λi )

then

X 1+ X 2+ ⋯+ X n ∼ P (λ 1+ λ 2+ ⋯+ λ n)

Mis notas:

21

Herramientas básicas de Matemáticas

Distribución Normal

Estandarización

La siguiente transformación de la variable X,

Z=

X −μ

√ σ2

=

X −μ

,

σ

donde μ y σ2 son la media y la varianza de X, se llama estandarización. Como caso particular, cuando

X sigue una distribución normal, se cumple que

Teorema 1vn

Z=

Cuando X ∼N (μ , σ2 ), si

X −μ

√σ

2

X −μ

= σ , entonces Z ∼N (0 , 1)

Este resultado nos permite referir cualquier variable normalmente distribuida a la distribución normal

estándar. Como consecuencia, la tabla de esta distribución basta.

Mis notas:

Suma de variables normales

Para variables aleatorias independientes, si X, X1, X2,..., Xn siguen una distribución N(μx,σx2), Y sigue una

distribución N(μY,σY2) y c es una constante:

(1)

2

2

2

X

2

y

X + c∼N (μ X + c , σ X )

X −c∼N (μ X −c , σ X )

(

2

μ σ

X

∼N X , X2

c

c c

(2)

cX ∼ N (c μ X , c σ )

y

(3)

X + Y ∼ N (μ X + μY , σ2X + σ 2Y )

y

)

X −Y ∼ N (μ X −μY , σ2X + σ 2Y )

Algunos corolarios de los resultados anteriores son:

(a) De (1) y (2),

X −μ X

√σ

2

X

X −μ

= σ X ∼N (0 , 1)

X

(b) De (3), X 1 + X 2+ ⋯+ X n∼N (nμ X , n σ 2X )

(c) De (b) y (a),

( X 1 + X 2 +⋯+ X n)−nμ X

√n σ

2

X

∼ N (0,1)

2

X 1+ X 2+ ⋯+ X n

σ

̄ ∼N (μ X , X )

(d) De (b) y (2),

=X

n

n

̄ −μ X

X̄ −μ X X

= σ

=∼ N ( 0,1)

X

(e) De (d) y (a),

σ2X

√n

n

σ 2X σ 2Y

σ 2X σ 2Y

̄ + Ȳ ∼ N (μ X + μ X ,

̄ −Ȳ ∼ N (μ X −μ X ,

(f) De (d) y (3), X

+

) y X

+

)

n

n

n

n

√

22

Herramientas básicas de Matemáticas

X̄ −μ X

Nota: Debido al resultado (e), la cantidad

√

σ2X

n

∼ N (0,1)

se denomina versión estandarizada de la cantidad aleatoria X. Cuando la

X̄ −μ X

varianza poblacional es desconocida, es estimada, y se cumple (para una población normal) que

√

2

S

n

∼ t n−1 ,

donde S2 es la

cuasivarianza muestral y tk es la distribución t; debido a este resultado, la cantidad anterior se denomina versión studentizada de X. Ambas

cantidades son adimensionales y pueden ser vistas como medidas del error relativo al estimar la media poblacional utilizando la media muestral

como estimador.

Mis notas:

Puntos teóricos: Sobre el teorema del límite central y aproximaciones, véase Algunos resultados teóricos.

Probabilidades y cuantiles: la ecuación Fθ(a) = p

La ley de distribución de una variable aleatoria X está determinada una vez que se conocen los posibles

valores y sus probabilidades. Matemáticamente, es suficiente conocer las probabilidades de los sucesos de la

forma{X ≤ x} para cualquier x. Esta información está contenida en la función de distribución, Fθ(x) = Pθ(X ≤

x), donde θ representa los parámetros de la familia o modelo. Para leyes «con buen comportamiento», existe

otra función fθ(x) —la función de masa para variables discretas y la función de densidad para variables

continuas— tal que la función de distribución se puede escribir en términos de ella. En Inferencia Estadística,

frecuentemente necesitamos enfrentarnos a expresiones como:

P θ ( X ≤a )= p , esto es, F θ (a)= p ,

donde θ son los parámetros, a es el cuantil y p es la probabilidad.

¿Por el qué me están preguntando?

La ecuación anterior involucra a θ, a y p, y pueden preguntarnos por cualquiera de las tres cantidades. El

problema general puede formularse como:

De F θ (a)= p , encuentra la cantidad desconocida (incógnita) dadas las otras dos.

Nota: Para estadísticos, funciones que dependen de una (muestra aleatoria) simple de tamaño n, en ocasiones el interés está en el parámetro n de

Pθ(Tn ≤ x) = p.

Pregunta indirecta

De hecho, se nos puede preguntar de una forma menos directa, y necesitaremos encontrar una función de la

incógnita antes de encontrar la propia incógnita. Esto puede suceder, por ejemplo, cuando:

1

Conocemos la distribución de X, necesitamos trabajar con un suceso como {g1(X) ≤ g2(a)} y no

conocemos la distribución de g1(X). Si g1 es invertible el suceso puede escribirse como {X ≤ g1–1(g2(a))},

{X < g1–1(g2(a))}, {X ≥ g1–1(g2(a))} ó {X > g1–1(g2(a))}, dependiendo de los miembros de la desigualdad y

de cuándo g1–1 es creciente o decreciente, estrictamente o no.

2

No conocemos la distribución de X, necesitamos trabajar con un suceso como {X ≤ g2(a)} y hay un

resultado teórico que proporciona la distribución de g1(X). Entonces, el suceso puede expresarse como

23

Herramientas básicas de Matemáticas

{g1(X) ≤ g1(g2(a))}, {g1(X) < g1(g2(a))}, {g1(X) ≥ g1(g2(a))} ó {g1(X) > g1(g2(a))}, dependiendo de los

miembros de la desigualdad y de cuándo g1 es creciente y decreciente, estrictamente o no.

Sin embargo, en estas situaciones la función g1–1 ó g1 no se suele aplicar en un paso sino en varios pasos

pequeños en los que son fáciles de controlar posibles cambios en el sentido de la desigualdad. Por ejemplo, si

se conoce la distribución de X, pero el suceso está escrito como

X +1

<1 }

{2.325

la función g1(x) es (x+1)/2.325.

En un paso:

y=

x+ 1

→ 2.325 y=x + 1 → 2.325 y−1= x → g −1

1 (x )=2.325 x−1

2.325

Dado que

d −1

–1

g (x )=2.325 > 0 , la función g es estrictamente creciente, por lo que

dx

X +1

<1 } → { g

{2.325

−1

(

X +1

)< g −1 (1)

2.325

} → { X < 2.325⋅1−1 } → { X <1.325}.

En varios pasos:

X +1

<1 }={ X +1< 2.325}={ X < 2.325−1 }={ X <1.325}.

{2.325

Mis notas:

Otros tipos de sucesos

Por definición, la función de distribución Fθ(a) se define sobre los sucesos de la forma {X ≤ a}, para todo a.

Frecuentemente es necesario trabajar con otros tipos de sucesos que pueden expresarse en términos de los

anteriores.

(a) Complemento: Como { X > a }={ X ≤a }c , entonces

P θ ( X > a)=1−P θ ( X ≤a)

(b) Intervalo: Como {a1≤ X ≤a 2 }={ X < a 2 }∖ { X ≤a 1 }={ X ≤a 2 }∩{ X < a1 }c , entonces

P θ (a 1≤ X ≤a 2 )=P θ ( X ≤a 2 )−P θ ( X ≤a 1)

(c) Exclusión de la igualdad: Como { X < a }={ X ≤a }∖ { X =a }, entonces

P θ ( X < a)=P θ ( X ≤a)− Pθ ( X =a)

Para variables continuas, P θ ( X =a)=0 , ∀a

Mis notas:

24

Herramientas básicas de Matemáticas

Formas de buscar soluciones

Operando en la ecuación

Desde un punto de vista teórico:

Cuando la probabilidad p es desconocida, es suficiente evaluar la función de distribución, para los

parámetros θ dados, en el valor de la variable a. Esto implica cálculos con una suma para variables

discretas y con una integral para las continuas:

p = Fθ(a)

Cuando la incógnita es el cuantil a, es necesario invertir la función de distribución. Esto corresponde a

encontrar el valor, para los parámetros θ dados, tal que:

Fθ(a) = p

→

a = Fθ–1(p)

Cuando el parámetro(s) θ es la incógnita, en general no está determinada con unicidad dadas a y p:

por ejemplo, la igualdad de las integrales definidas de dos funciones no implica que las funciones sean

iguales, mientras que θ caracteriza al elemento de la familia. Dado que hay sólo una ecuación, puede

suceder que la distribución sea multiparámetro y todos los parámetros sean conocidos excepto uno,

pero incluso en esta situación puede existir más de una solución si la ecuación es no lineal. Cualquiera

que sea el número de soluciones, es posible resolver el problema sólo cuando puede encontrarse

algebraicamente una expresión (posiblemente multivariante) explícita:

Fθ(a) = p

→

θ = h(a,p)

Nota: El problema de estimar los parámetros de una población a partir de muestras es cualitativamente diferente de éste.

Consultando una tabla

Cuando la variable puede tomar muchos valores (infinitos, con frecuencia), sólo algunos pueden ser tabulados.

De hecho, una tabla es una colección finita de soluciones de la ecuación F θ (a)= p , ordenadas por las

cantidades θ, a y p.

25

Herramientas básicas de Matemáticas

Discreción y acotamiento

Como en una tabla sólo es posible considerar un conjunto discreto de valores de las cantidades continuas,

puede suceder que no esté en la tabla el valor en el que estamos interesados. En estos casos, todavía es posible

usar la información de la tabla para acotar la probabilidad o el cuantil desconocidos. Para una tabla que

proporciona la probabilidad de las colas inferiores, esto es, P θ ( X ≤a )= p , el acotamiento de la

probabilidad sería

a 1< a< a 2 → P θ ( X ≤a 1)< Pθ ( X ≤a)< P θ ( X ≤a 2) → p 1< P θ ( X ≤a)< p 2

donde a1 y a2 están en la tabla; por otro lado, para el cuantil sería

p 1< p< p2 → a 1< a< a 2

donde p1 y p2 están en la tabla. Véanse, por ejemplo, los ejercicios de [1].

Simetría

Las características teóricas de algunas distribuciones nos permiten simplificar sus tablas. Por ejemplo, si la

distribución es simétrica con respecto al cero, pueden considerarse sólo cuantiles positivos, dado que

P θ ( Z ≤−a ) =P θ ( Z ≥a ) =1− Pθ ( Z < a ) =1− Pθ ( X ≤a)+ Pθ ( X =a)

Reescritura de sucesos

El mismo suceso puede expresarse de diferentes formas, y cuál es la más apropiada depende de las tablas

disponibles. Por ejemplo, para calcular la probabilidad P θ (∣ X ∣> a ) , si X tiene distribución simétrica,

(a)

(b)

(c)

2 P θ ( X < −a )=2[1−P θ ( X ≥−a ) ]

2 P θ ( X > + a )=2[1−P θ ( X ≤+ a ) ]

1−P θ (∣ X ∣ ≤+ a )=1−[ P θ ( X ≤+ a ) −Pθ ( X ≤−a ) ]

Tablas de una y dos colas

Si una tabla de una cola proporciona las probabilidades de las colas inferiores

P ( X ≤ a)= p ,

queda una probabilidad de 1–p en la cola superior X > a. Si una tabla de una cola proporciona las

probabilidades de las colas superiores

P ( X > a)= p ,

26

Herramientas básicas de Matemáticas

queda una probabilidad de p en la cola superior X > a. Para una distribución simétrica, las tablas de dos colas

proporcionan usualmente las probabilidades de los intervalos centrados

P (−a< X < + a)= p ,

queda una probabilidad de (1–p)/2 en la cola superior X > a.

Aplicación a intervalos de confianza: Estos intervalos se expresan usualmente en términos del cuantil de

probabilidad de la cola superior tal que P(X > a) = α/2, donde 1–α es el nivel de confianza; entonces, si se

utiliza una tabla de una cola debe considerarse el valor

p=1 – α o p= α

2

2

para encontrar el cuantil (para tablas de probabilidades de colas inferiores y superiores, respectivamente),

mientras que si se utiliza una tabla de dos colas debe considerarse directamente el valor

p=1 – α .

Para consultar las tablas, es aconsejable tener en mente la diferencia entre el nivel de confianza y la

probabilidad.

Utilizando un programa informático

Hay muchas herramientas, desde lenguajes de programación hasta aplicaciones para dispositivos móviles,

para calcular p o a. Estas herramientas también pueden estar insertadas en páginas web para ser utilizadas en

línea.

Mis notas:

Sucesiones de variables aleatorias

Tipos de convergencia

Sea X1, X2, X3,... una sucesión de variables aleatorias definidas sobre un mismo espacio de probabilidad

(Ω,A,P).

Convergencia en distribución (en ley o D-convergencia)

d

Se dice que la sucesión {Xn} converge en distribución a X, débilmente o en ley, X n →

X , si para cualquier

función continua acotada h(x)

E ( h( X n)−h( X ) ) → 0 cuando n → ∞ .

Nota: Algunas veces se utilizan como definición otras condiciones equivalentes.

Convergencia en probabilidad (en medida o P-convergencia)

P

Se dice que la sucesión {Xn} converge en probabilidad a X, X n → X , si

P (∣ X n −X ∣ > ϵ) → 0, ∀ϵ> 0 , cuando n → ∞ .

27

Herramientas básicas de Matemáticas

Convergencia en media de orden p (o Lp-convergencia)

Lp

Se dice que la sucesión {Xn} converge en media de orden p a X, X n → X , si

E (∣ X n − X ∣ p ) → 0 cuando n → ∞ .

Convergencia casi segura (o c.s.-convergencia)

cs

Se dice que la sucesión {Xn} converge casi seguro a X, con probabilidad uno o fuertemente, X n → X , si

P ( X n− X → 0 cuando n → ∞ ) =1

Convergencia completa

c

Se dice que la sucesión {Xn} converge completamente a X, X n → X , si

∞

∑n=1 P ( ∣ X n− X∣ > ϵ) < ∞ , ∀ϵ> 0

Nota: La convergencia en distribución es cualitativamente diferente de las otras, dado que no compara las variables aleatorias Xn y X sino las

distribuciones P{Xn in a} y P{X in a} para todo a∈ A (cualquier posible evento).

Relaciones entre los tipos de convergencia

Las siguientes relaciones son ciertas siempre:

Las opuestas de algunas relaciones pueden cumplirse en casos especiales o bajo condiciones adicionales. Para

estos resultados, véase por ejemplo la sección 7.2 de [2].

Convergencia en Análisis Real

Algunos de estos tipos de convergencia se utilizan también en Análisis matemático:

Probabilidad

Análisis

En distribución

Débil

En probabilidad

En medida

En media de orden p

En media de orden p

Casi segura

Casi en todo punto

Completa

Uniforme

28

Herramientas básicas de Matemáticas

Mis notas:

Algunos resultados teóricos

Teorema del Límite Central

Hay varias versiones del Teorema del Límite Central, dependiendo de las condiciones impuestas a las

variables.

Teorema 1sv

Dadas variables aleatorias independientes (X1,..., Xn) tales que Xi tiene media finita μi y varianza finita

σi2, entonces

X 1+ X 2+ ⋯+ X n

d

→

N ( μ1+ μ 2+ ⋯+ μ n , √ σ1 + σ 2+ ⋯+ σ n )

2

2

2

o, equivalentemente,

( X 1+ X 2 + ⋯+ X n)−(μ1+ μ 2+ ⋯+ μ n )

2

1

2

2

N (0,1)

d

→

√ (σ + σ + ⋯+ σ )

2

n

Aproximación de la distribución binomial a y por la normal o la Poisson

Una de las aplicaciones del Teorema del límite central es la aproximación de las probabilidades de algunas

sumas de variables. Para el caso particular en el que Xi sigue una distribución de Bernoulli, como la suma de

variables sigue un modelo binomial, el teorema se reescribe como

Teorema 2sv

Si Y sigue una distribución binomial, dado que μ=E (Y )=n η y σ 2=Var (Y )=n η(1−η) se cumple,

cuando n crece, que

Y − E(Y )

Y −n η

d

=

N ( 0, 1 ) .

√ Var (Y ) √ n η(1−η) →

Esta versión del Teorema del límite central se utiliza para aproximar la distribución binomial por la normal

estándar. La aproximación es buena cuando n es grande y η es tal que nη es también grande. Cuando η es tan

pequeño que nη es también pequeño incluso para valores grandes de n, la binomial puede aproximarse por la

Poisson:

Teorema 3sv

Si n tiende a infinito y η tiende a cero de tal forma que nη tiende a una constante λ, se cumple que

n−x

lim f ( x ; n , η)=lim n ηn−x (1−η) x

x

()

→

e−λ λ

= f (n−x ; λ )

(n− x)!

para x≤n .

Corrección por continuidad

En el teorema 2sv el cociente sigue una distribución discreta mientras que el límite es continuo. La corrección

por continuidad puede pensarse como el proceso de «hacer continua la distribución discreta», esto es,

extender ficticiamente su función de masa a todos los posibles valores reales. Esto mejora la aproximación y

puede hacerse imaginando barras de anchura uno centradas en los valores enteros a, desde a–0.5 a a+0.5, que

son incluidas cuando el valor a está incluido. Por ejemplo:

(a)

P ( X =a) → P (a−0,5≤X ≤a+0,5)

29

(b)

P ( X ≤a) → P ( X ≤a+0,5)

Herramientas básicas de Matemáticas

(c)

(d)

P ( X <a) → P ( X ≤a−0,5)

P (a< X < b) → P(a+0,5≤X ≤b−0,5)

(c)

P (a≤X ≤b) → P (a−0,5≤X ≤b+0,5)

(e)

Otros casos.

Límites de sucesiones de variables aleatorias

De la sección 7.2 de [2]:

Teorema 4sv

d

P

Si X n → c , donde c es una constante, entonces X n → c

La convergencia en probabilidad implica la convergencia en distribución, pero lo opuesto en general no es

cierto: el anterior teorema muestra una excepción.

Teorema 5sv

d

d

Si X n → X y g :ℝ → ℝ es una función continua, entonces g ( X n ) → g ( X )

El anterior teorema también se cumple para las convergencias casi segura y en probabilidad. Al final de la

misma sección 7.2, en el ejercicio 5:

Theorem 6sv (Slutsky)

d

P

d

(a) Suponga que X n → X y Y n → c , donde c es una constante. Entonces X n⋅Y n → c⋅X y, si c

Xn d X

→ .

es no nula,

Yn

c

d

P

(b) Suponga que X n → 0 y Y n → Y , y sea g :ℝ2 → ℝ tal que g(x,y) es una función continua de

P

y para toda x, y g(x,y) es continua en x = 0 para todo y. Entonces g ( X n ,Y n) → g ( 0 , Y ).

Por otro lado, de la sección 7.3 del mismo libro:

Teorema 7sv

a.s.

a.s.

a.s.

(a) Si X n → X y Y n → Y entonces X n+ Y n →

Lp

Lp

Lp

(b) Si X n → X y Y n → Y entonces X n+ Y n →

P

P

P

(c) Si X n → X y Y n → Y entonces X n+ Y n →

d

(d) En general no es cierto que X n+ Y n → X + Y

X+Y

X+Y

X+Y

d

d

siempre que X n → X y Y n → Y

Momentos

De la sección 2.2 de [3]:

Teorema 8sv

i.

ii.

Teorema 9sv

a.s.

a.s.

mr → μ r

E (mr )=μ r

μ 2r −μ 2r

iii. Var ( mr )=

→ 0

n

i. s r → σr

ii. Se cumple que E (s r )−σ r =⋯ → 0

iii. Se cumple que Var ( s r )=⋯ → 0

Teorema 10sv

( )

2

(1)

d

̄ →

X

N μ ,σ

n

30

Herramientas básicas de Matemáticas

(2)

σ 4−σ 4

S →N σ ,

n

2

d

(

2

)

n−1 2

S , aplicando el teorema

n

4

4

n−1

2 σ 4 −σ

2 σ 4−σ

⋅N σ ,

=N σ ,

.

n

n

n

2

Si s2 es la varianza muestral y S2 es la cuasivarianza muestral, dado que s =

4sv y (a) del teorema 6sv, s 2=

n−1 2 d

S → lim n→ ∞

n

(

) (

)

Mis notas:

Estimaciones puntuales. Estadísticos y Estimadores

El mundo estadístico

Mis notas:

Tipos de consistencia

Un estimador es una sucesión de variables aleatorias: una para cada valor de n. Por tanto, los modos de

convergencia de estos tipos de sucesiones pueden aplicarse. Al mismo tiempo, la consistencia es un concepto

asintótico. Las siguientes definiciones están basadas en las diferentes formas en las que una sucesión de

variables aleatorias puede converger a una cantidad (el parámetro poblacional, en este caso). En general, las

definiciones son difíciles de manejar y usualmente se les pide a los estudiantes que trabajen con condiciones

necesarias o suficientes.

31

Herramientas básicas de Matemáticas

Consistencia en media cuadrática

De la definición de error cuadrático medio (aunque hay otras formas de medir el error), se deduce la

importante propiedad general:

2

̂

̂

̂ 2+ Var ( θ)

̂ ,

MSE ( θ)=E

( [ θ−θ]

) =⋯=[b( θ)]

̂

̂

donde b( θ)=E

( θ)−θ

es el sesgo del estimador. Se dice que un estimador es consistente en media

cuadrática para estimar θ si

̂ → 0 cuando n → ∞ .

MSE ( θ)

̂

Como las tres cantidades MSE ( θ),

̂ son no negativas, se cumple que

̂ 2 y Var ( θ)

[b ( θ)]

̂

lim n →∞ MSE ( θ)=0

↔

̂

lim n →∞ b( θ)=0

̂

lim n →∞ Var ( θ)=0

{

esto es, para la consistencia en media cuadrática de un estimador, es necesaria y suficiente la concurrencia de

insesgadez asintótica y varianza evanescente. Cualquiera de estas dos condiciones, separadamente, es

necesaria pero no suficiente.

Consistencia en media de orden 1

Un estimador de θ se dice que es consistente en media de orden 1 si

̂ ∣ ) → 0 cuando n → ∞ .

E (∣θ−θ

Como la convergencia en media cuadrática implica la convergencia en media de orden 1 en un espacio de

medida finita (debido a la desigualdad de Cauchy-Schwarz), la consistencia en media cuadrática implica la

convergencia en media de orden 1. Entonces, la condición necesaria y suficiente para la convergencia en

media cuadrática se convierte en suficiente —pero no necesaria— para la convergencia en media de orden 1:

{

lim n → ∞ b ( θ̂ )=0

̂

lim n → ∞ Var ( θ)=0

→ θ̂ es un estimador consistente en media de orden 1 de θ.

Consistencia en probabilidad

Un estimador de θ se dice que es consistente en probabilidad si

̂ ∣ > ϵ ) → 0, ∀ϵ> 0 , cuando n → ∞ .

P (∣θ−θ

Como la convergencia en media de orden 1 implica la convergencia en probabilidad (debido a la desigualdad

de Chebyshev), la consistencia en media de orden 1 implica la consistencia en probabilidad. Entonces, la

condición suficiente para la consistencia en media de orden 1 es también suficiente para la consistencia en

probabilidad, por lo que la condición necesaria y suficiente para la consistencia en media cuadrática se

convierte también en suficiente —pero no necesaria— para la consistencia en probabilidad:

{

lim n → ∞ b( θ̂ )=0

̂

lim n → ∞ Var ( θ)=0

→ θ̂ es un estimador consistente en probabilidad de θ.

Mis notas:

32

Herramientas básicas de Matemáticas

Método de los momentos

Momentos: Los momentos poblacionales y muestrales con respecto a cero se definen, respectivamente, como:

μ r (θ)=E ( X r )

y

m r ( X )=

1 n r

x

n ∑ i=1 i

Idea del método: Como mr son buenos estimadores de μr, sus valores están cerca. Entonces, tiene sentido

forzar su igualdad: tantas ecuaciones involucrando las incógnitas como parámetros en θ.

(1) Momentos centrados poblacionales y muestrales: Escribir tanto E(Xr) en función de los parámetros θ como

los momentos muestrales.

(2) Sistema de ecuaciones: Un problema algebraico.

r =1, 2, ...

μ r (θ)=mr (x 1 , ... , x n ) ,

(3) El estimador: Finalmente, en la expresión de las soluciones θ0 =h( x 1 , x 2 , ... , x n) las letras minúsculas xi

(números que representan LA muestra que teníamos) son sustituidos por las letras mayúsculas Xi (variables

aleatorias que representan CUALQUIER posible muestra que podamos tener):

θ̂ M =h( X 1 , X 2 , ... , X n) .

Nota: Si el método de los momentos es utilizado para estimar m parámetros (frecuentemente 1 o 2), las m primeras ecuaciones suelen ser

suficientes; sin embargo, si no todos los parámetros aperecen en los primeros momentos de X, deben considerarse los m momentos más pequeños

para los que aparecen los parámetros. Por ejemplo, si μ1 = 0 o si el interés está directamente en σ2 porque μ es conocido, la ecuación de primer

orden μ1 = μ = E(X) = m1 no involucra a σ y por lo tanto debe considerarse la ecuación de segundo orden μ2 = E(X2) = Var(X)+E(X)2 = σ2+μ2 = m2.

Nota: La función h es multivariante cuando hay más de un parámetro, es decir, θ = (θ1,θ2) y h = (h1,h2), con θ0,1 = h1(x1,...,xn) y θ0,2 = h2(x1,...,xn).

Mis notas:

Método de máxima verosimilitud

Función de verosimilitud: Dado θ, la función de verosimilitud

n

L( x 1 , x 2 , ... , x n ; θ)=∏i =1 f ( x i ; θ)

es un número que proporciona una medida de lo fácil o difícil (lo «probable») que es obtener la muestra

concreta x = (x1, x2,...,xn).

Idea del método: Parece razonable elegir el valor θ = θ0 que maximiza la probabilidad de la muestra obtenida

(esto es equivalente a suponer que el suceso más probable ocurrió al obtener la muestra, y que no sucedió

nada extraño). Para hacer esto, permitiremos a θ que tome todos sus posibles valores, es decir, será

considerado como una variable temporalmente.

(1) Función de verosimilitud: Escribe el producto y junta los términos que son similares.

(2) Problema de optimización: Un problema analítico.

33

Herramientas básicas de Matemáticas

En general, es casi imposible calcular la derivada de un producto de n factores (para cualquier n)

n

L( x 1 , x 2 , ... , x n ; θ)=∏i =1 f ( x i ; θ)

Como L toma valores positivos y la función log(x) convierte productos en sumas y exponentes en factores

multiplicativos a la vez que no cambia la posición de los posibles extremos, se considera en su lugar la

siguiente función:

n

log [ L( x 1, x 2,... , x n ; θ) ] =∑i=1 log [ f ( x i ; θ) ]

Después, el problema de optimización se resuelve como está descrito en la sección Optimización de

funciones: máximos y mínimos locales, esto es, resolviendo las ecuaciones

∂

∂θi log( L (x 1 , ... , x n ; θ))=0

y verificando las condiciones sobre las derivadas de segundo orden.

(3) El estimador: Finalmente, en la expresión de las soluciones θ0 =h( x 1 , x 2 , ... , x n) las letras minúsculas xi

(números que representan LA muestra que teníamos) son sustituidas por letras mayúsculas Xi (variables

aleatorias que representan CUALQUIER posible muestra que podamos tener):

θ̂ ML =h ( X 1 , X 2 , ... , X n) .

Nota: La función h es multivariante cuando hay más de un parámetro, es decir, θ = (θ1,θ2) y h = (h1,h2), con θ0,1 = h1(x1,...,xn) y θ0,2 = h2(x1,...,xn).

Propiedades de θ̂ ML :

Bajo ciertas condiciones de regularidad, el estimador existe y es único.

En ocasiones es insesgado, y siempre es asintóticamente insesgado.

Es consistente.

Cuando existe un estimador eficiente, se obtiene con este método; además, es siempre asintóticamente.

eficiente (la varianza tiende a la cota mínima de Cramér-Rao).

Si hay estimadores suficientes, es uno de ellos.

Asintóticamente, es normalmente distribuido.

Mis notas:

34

Herramientas básicas de Matemáticas

Intervalos de confianza

Definición e interpretación

Un par de cantidades aleatorias T1 y T2 tales que

1−α = P (T 1≤θ≤T 2)

forma un intervalo de confianza de probabilidad 1–α para el parámetro θ. (Nótese que para hablar de

probabilidad, alguna de las cantidades T1, θ o T2 debe ser aleatoria, y el parámetro θ lo es.) Los extremos del

intervalo son aleatorios hasta que se sustituye una muestra específica; entonces, este intervalo contendrá o no

contendrá el verdadero valor. En repetidas aplicaciones de las fórmulas del intervalo, el verdadero valor del

parámetro θ estaría contenido en un 100(1–α)% de los intervalos calculados de este modo: por ejemplo, si la

confianza es 95%, más o menos 95 de cada 100 veces el valor real desconocido estaría en el intervalo (en la

práctica, quizá las fórmulas se aplican sólo una vez...).

Nota: Una vez que se obtiene un intervalo para la varianza, P(a1 ≤ σ2 ≤ a2), dado que la raíz cuadrada positiva es una función estrictamente

creciente, un intervalo para la desviación típica está dado por P(√a1 ≤ σ ≤ √a2). (Nótese que a1 > 0 si el intervalo inicial es razonable.)

Mis notas:

Hay varios métodos para construir intervalos de confianza. Uno de los principales es el siguiente.

Método de la cantidad pivotal. Algunos pivotes

(1) Pivote T(X;θ): Selecciónalo de las tablas de estadísticos. Verificará que:

(a) Involucra el parámetro θ

(b) Su distribución es conocida

(c) Es posible hacer T(X;θ) = k → θ = g(X;k) fácilmente

Nota: T(X;θ) es una cantidad aleatoria.

(2) Reescritura del suceso: Hacer los cálculos

1−α = P (a 1≤T ( X ; θ)≤a 2) =⋯ = P (T 1 ( X ; a1, a 2)≤θ≤T 2 ( X ; a 1, a2 ))

(3) El intervalo:

I =[T 1 , T 2 ]1−α

Aplicación: Hay un número infinito de pares tales que P(a ≤ T(X;θ) ≤ b) = 1–α. Criterio: Se consideran los

cuantiles lα/2 y rα/2. Para distribuciones simétricas, esto minimiza la longitud del intervalo.

Nota: Usualmente los estadísticos involucrados en T (como s, S...) y los cuantiles (como a ...) también dependen del tamaño muestral n.

Mis notas:

Margen de error

Debido al método aplicado, para nuestros T simétricos los intervalos tomarán la forma

̂ E,

I =θ∓

35

Herramientas básicas de Matemáticas

donde E > 0 es el margen de error. En este caso, la longitud del intervalo es L = T2 – T1 = 2E y

̂

̂ E)=P (−E≤−θ̂ +θ≤+ E)=P (∣θ−θ

̂ ∣≤E )=P ∣θ̂ −θ∣≤ L

1−α=P ( θ−E≤θ≤

θ+

2

(

)

̂ ∣ como si fuese el error absoluto (distancia sin signa), la ecuación anterior dice que con probabilidad 1– α este error

Nota: Si se piensa en ∣θ−θ

será menor o igual al margen de error (la mitad de la longitud).

Mis notas:

Tamaño muestral mínimo

Un proceso estadístico con «con buen comportamiento» debería verificar que cuanta más información

disponible hay mejor debe ser la inferencia, esto es, que cuanto mayor es el tamaño muestral menor es el error.

̂ ∣ puede ser acotada en probabilidad utilizando el margen de error: dados α y E (ó L),

La distancia ∣θ−θ

cuando ME depende del tamaño muestral n, esta última cantidad puede elegirse para que

̂ ∣≤E) .

1−α=P (∣θ−θ

Método basado en el intervalo de confianza. Para los intervalos que involucran el cuantil de la distribución

normal estándar,

E=r α / 2 σ

√n →

√ n=r α / 2 σ → n= r α/2 σ → Se considera el entero mayor más cercano.

E

( E)

2

Existen tablas con estos valores. Sin embargo, el cuantil depende frecuentemente del tamaño muestral n, por

lo que

S

S

E=r n ,α / 2 n → √ n=r n ,α / 2 n ,

E

√n

donde ambos miembros de la última igualdad depende de n y no es trivial encontrarlo manipulando la

ecuación. Como el objetivo no es resolver la ecuación algebraicamente sino encontrar el menor valor natural n

que la verifica, se pueden probar distintos (es muy útil un computador).

̂

Método basado en la desigualdad de Chebyshev. Para estimadores insesgados, como E ( θ)=θ

una

̂ ∣ consiste en usar la desigualdad de Chebyshev:

posible forma de acotar en probabilidad la distancia ∣θ−θ

̂ ∣≥E )=P (∣θ−E

̂

̂ ∣≥ E)≤

P (∣θ−θ

( θ)

̂

Var ( θ)

≤α.

2

E

Esto puede utilizarse para obtener tanto el intervalo de confianza como el tamaño muestral mínimo necesario.

Por ejemplo, dados α y E, en la expresión de Var ( θ̂ n) puede elegirse el mínimo n para garantizar la última

desigualdad. Esto puede hacerse cuando θ^ es un estimador que involucra una o dos muestras (poblaciones).

36

Herramientas básicas de Matemáticas

Mis notas:

Contrastes de hipótesis

Definición e interpretación

Qué es un contraste de hipótesis. Un proceso estadístico para responder a una pregunta sobre una o más

distribuciones poblacionales, por ejemplo: ¿Es μ igual a 3? ¿Es σ menor que 14? ¿Tienen estas poblaciones la

misma varianza? ¿Sigue X una distribución exponencial?

Cómo se encuentra la respuesta. Utilizando la información muestral X = (X1,...,Xn) a través del estadístico

apropiado y aplicando una de dos metodologías equivalentes. Suponiendo que H0 is verdadera, el valor

muestral T(x;θ) es comparado con toda la distribución muestral de T(X;θ).

Decisiones incorrectas. Error de tipo I: rechazar H0 cuando es cierta. Error de tipo II: no rechazar H0 cuando es

falsa.

Interpretación. Un contraste: cuando H0 es realmente cierta, después de utilizar la muestra el contraste habrá

fallado o no la decisión correcta: ya no hay ninguna probabilidad involucrada. Varios contrastes: en repetidas

muestras de la población (aplicaciones del proceso de contraste), la regla cometería error de tipo I en 100α%

de los contrastes calculados de esta manera: por ejemplo, si la confianza es 95% (α=0.05), más o menos 95

veces de 100 la decisión sería correcta cuando H0 es cierta.

Proceso de contraste

Metodología 1: Tras seleccionar el estadístico adecuado T(X), se determina bajo H0 la región crítica o de

rechazo: la forma prestando atención a la hipótesis alternativa H1 y los valores críticos aplicado la definición

de error de tipo I α (nivel de significación).

α=P (Error tipo I )=P (Rechazar H 0 ∣ H 0 cierta)= P(T ∈ Rc ∣ θ∈Θ0 )=P (T 0∈R c ).

El estadístico bajo H0 es evaluado con la muestra x = (x1,...,xn) y se rechaza H0 si esta evaluación T0(x)

pertenece a Rc.

Metodología 2: Tras seleccionar el estadístico adecuado T(X), es evaluado bajo H0 con la muestra x =

(x1,...,xn), digamos T0(x). Entonces, se determina el valor p («p-value»)utilizando T0(x) y T0(X)

Vp=P ( X más rechazadora que x ∣ H 0 cierta )

donde la traducción de «más rechazadora que» al lenguaje matemático está determinada por la forma de la