Métodos estadísticos y valor P (P-value)

Anuncio

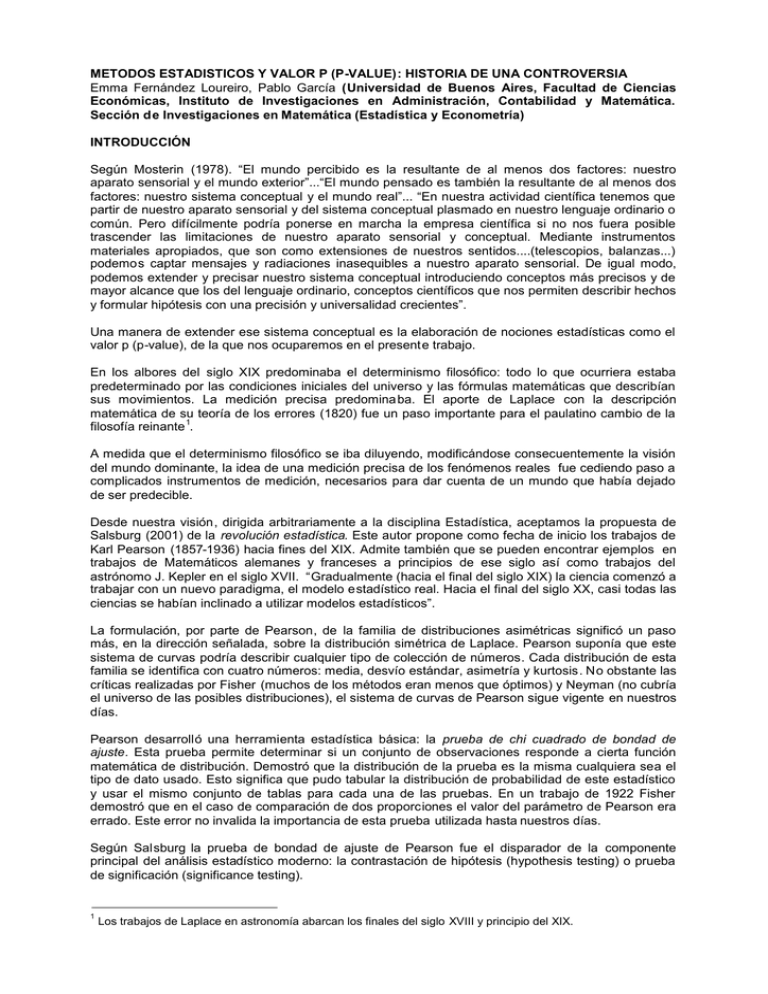

METODOS ESTADISTICOS Y VALOR P (P-VALUE): HISTORIA DE UNA CONTROVERSIA Emma Fernández Loureiro, Pablo García (Universidad de Buenos Aires, Facultad de Ciencias Económicas, Instituto de Investigaciones en Administración, Contabilidad y Matemática. Sección de Investigaciones en Matemática (Estadística y Econometría) INTRODUCCIÓN Según Mosterin (1978). “El mundo percibido es la resultante de al menos dos factores: nuestro aparato sensorial y el mundo exterior”...“El mundo pensado es también la resultante de al menos dos factores: nuestro sistema conceptual y el mundo real”... “En nuestra actividad científica tenemos que partir de nuestro aparato sensorial y del sistema conceptual plasmado en nuestro lenguaje ordinario o común. Pero difícilmente podría ponerse en marcha la empresa científica si no nos fuera posible trascender las limitaciones de nuestro aparato sensorial y conceptual. Mediante instrumentos materiales apropiados, que son como extensiones de nuestros sentidos....(telescopios, balanzas...) podemos captar mensajes y radiaciones inasequibles a nuestro aparato sensorial. De igual modo, podemos extender y precisar nuestro sistema conceptual introduciendo conceptos más precisos y de mayor alcance que los del lenguaje ordinario, conceptos científicos que nos permiten describir hechos y formular hipótesis con una precisión y universalidad crecientes”. Una manera de extender ese sistema conceptual es la elaboración de nociones estadísticas como el valor p (p-value), de la que nos ocuparemos en el presente trabajo. En los albores del siglo XIX predominaba el determinismo filosófico: todo lo que ocurriera estaba predeterminado por las condiciones iniciales del universo y las fórmulas matemáticas que describían sus movimientos. La medición precisa predomina ba. El aporte de Laplace con la descripción matemática de su teoría de los errores (1820) fue un paso importante para el paulatino cambio de la 1 filosofía reinante . A medida que el determinismo filosófico se iba diluyendo, modificándose consecuentemente la visión del mundo dominante, la idea de una medición precisa de los fenómenos reales fue cediendo paso a complicados instrumentos de medición, necesarios para dar cuenta de un mundo que había dejado de ser predecible. Desde nuestra visión, dirigida arbitrariamente a la disciplina Estadística, aceptamos la propuesta de Salsburg (2001) de la revolución estadística. Este autor propone como fecha de inicio los trabajos de Karl Pearson (1857-1936) hacia fines del XIX. Admite también que se pueden encontrar ejemplos en trabajos de Matemáticos alemanes y franceses a principios de ese siglo así como trabajos del astrónomo J. Kepler en el siglo XVII. “Gradualmente (hacia el final del siglo XIX) la ciencia comenzó a trabajar con un nuevo paradigma, el modelo estadístico real. Hacia el final del siglo XX, casi todas las ciencias se habían inclinado a utilizar modelos estadísticos”. La formulación, por parte de Pearson, de la familia de distribuciones asimétricas significó un paso más, en la dirección señalada, sobre la distribución simétrica de Laplace. Pearson suponía que este sistema de curvas podría describir cualquier tipo de colección de números. Cada distribución de esta familia se identifica con cuatro números: media, desvío estándar, asimetría y kurtosis. No obstante las críticas realizadas por Fisher (muchos de los métodos eran menos que óptimos) y Neyman (no cubría el universo de las posibles distribuciones), el sistema de curvas de Pearson sigue vigente en nuestros días. Pearson desarrolló una herramienta estadística básica: la prueba de chi cuadrado de bondad de ajuste. Esta prueba permite determinar si un conjunto de observaciones responde a cierta función matemática de distribución. Demostró que la distribución de la prueba es la misma cualquiera sea el tipo de dato usado. Esto significa que pudo tabular la distribución de probabilidad de este estadístico y usar el mismo conjunto de tablas para cada una de las pruebas. En un trabajo de 1922 Fisher demostró que en el caso de comparación de dos proporciones el valor del parámetro de Pearson era errado. Este error no invalida la importancia de esta prueba utilizada hasta nuestros días. Según Salsburg la prueba de bondad de ajuste de Pearson fue el disparador de la componente principal del análisis estadístico moderno: la contrastación de hipótesis (hypothesis testing) o prueba de significación (significance testing). 1 Los trabajos de Laplace en astronomía abarcan los finales del siglo XVIII y principio del XIX. Para nuestro propósito es necesario recordar a Ronald Fisher (1890-1962), el gran contrincante de Pearson. En 1935 escribió The Design of Experiments. La importancia de esta obra radica, según Salsburg, en la discusión respecto de las diversas formas en que podría diseñarse el experimento y sus posibles resultados. Sigue Salsburg “…después de Fisher los experimentos dependían de la idiosincrasia de cada científico. …Fue particularmente cierto en investigación en agricultura hacia fines del siglo XIX y principios del XX”. Su análisis de varianza y blocks aleatorizados tuvieron origen es esta disciplina. Dice Kuehl (2001): “Nadie ha tenido tanto impacto en los principios estadísticos del diseño de experimentos en su tiempo como Ronald A. Fisher”...”desarrolló y consolidó los principio básicos de diseño y análisis que hasta la fecha son prácticas necesarias para llegar a resultados de investiga ción válidos”. Hacia fines de la década de los 20 y principios de la de los 30 Egon Pearson (1895-1980), hijo de Karl, y Jerzy Neyman (1894-1980) afirmaron que las pruebas de significación no tendrían sentido si no hubiera, al menos, dos hipótesis posibles que llamaron: hipótesis nula (la de Fisher) y a la otra, alternativa. Esto es la conocida teoría de pruebas de hipótesis (hypothesis testing) de NeymanPearson. EL VALOR P (p-value) Origen En las pruebas de significación y diseño de experimentos Fisher utilizó el valor p (p-value) que es la probabilidad que permite declarar la significación (significant) de una prueba. Según Salsburg “El término significación (significant) en los primeros desarrollos de esta idea se usaba para indicar que la probabilidad es suficientemente pequeña como para rechazar la hipótesis planteada”. Este es el concepto que aún perdura. Sigue Salsburg: “El (Fisher) no tenía dudas acerca su importancia y utilidad (valor p). Gran parte de su Statistical Methods for Research Workers (1925) está dedicado a mostrar como se calcula el valor p. En el libro Fisher no describe de donde derivan estos tests y nunca dice exactamente que valor p puede considerarse significativo. En su lugar presenta ejemplos de cálculos y notas si el resultado es o no significativo. En un ejemplo que muestra el valor p menor que 0.01 dice: Sólo un valor en cien excederá (el test estadístico calculado) por casualidad, entonces la diferencia entre los resultados es claramente significativa”… “Para Fisher un test de significación tiene sentido sólo en el contexto de una secuencia de experimentos referidos a un tratamiento específico”... “De la lectura de los trabajos de aplicación de Fisher se puede deducir que usó los tests de significación para una de tres posibles conclusiones: Si el valor p es muy pequeño (usualmente menos de 0.01) declara que un efecto ha sido demostrado. Si el valor p es grande (usualmente mayor que 0.20) el declara que si hay un efecto es tan pequeño que ningún experimento de ese tamaño es capaz de detectarlo. Si el valor p está entre esos dos valores discute como diseñar un nuevo experimento para tener una idea mejor del efecto”. Recordemos que para Fisher la hipótesis a contrastar es que “no existe diferencia entre los tratamientos. Según Salsburg para distinguir entre la hipótesis usada por Fisher para calcular el valor p y otras posibles hipótesis Neyman y E. Pearson llamaron hipótesis nula a la hipótesis a contrastar y a la otra, hipótesis alternativa. En esta formulación, el valor p es calculado para contrastar la hipótesis nula pero la potencia de la prueba se refiere a como este valor p funcionará si la alternativa es, en los hechos, verdadera. La potencia de la prueba es una medida de cuan buena es la prueba. Dadas dos pruebas la de mayor potencia sería la mejor a usar. De modo muy sintético recordemos que la Teoría de Neyman-Pearson, cuya estructura matemática es aceptada hasta nuestros días, establece, como hemos dicho, dos hipótesis posibles: la nula y la alternativa. Según los autores existen dos fuentes de error: rechazar la hipótesis nula cuando es verdadera (nivel de significación, αo error de tipo I) y no rechazar la cunado es falsa (βo error de tipo II). Sus contrapartidas, en sentido probabilística, son las decisiones correctas de no rechazar una hipótesis cuando es verdadera (1-α) y rechazarla cuando es falsa (1-β), esto último es la potencia de la prueba. Según Gujarati (2006) (pag. 114) ”Lo ideal sería que minimizáramos ambos tipos de errores. Pero, por desgracia, para cualquier tamaño muestral, no es posible minimizar ambos errores de manera simultánea. el planteamiento clásico de este problema, incorporado en los trabajos de los estadísticos Neyman y Pearson, consiste en suponer que es más probable que un error de tipo I sea más grave, en la práctica, que uno de tipo II. Por tanto, deberíamos intentar mantener la probabilidad de cometer error de tipo I a un nivel bastante bajo, como 0.01 ó 0.05, y después minimizar el error de tipo II todo lo que se pueda”…”La única forma de reducir un error de tipo II sin aumentar un error de tipo I es aumentar el tamaño de la muestra, lo que no siempre resulta fácil”. Siguiendo a Salburg admitimos que el uso de pruebas de significación de Fisher produce un número que llamó valor p. Es una probabilidad calculada, una probabilidad asociada a los datos observados bajo el supuesto de que la hipótesis nula es verdadera. El valor p es una probabilidad, y así es como se calcula. El valor p (p-value) en el siglo XXI Si bien tratamiento del valor p se le asigna a Fisher entendemos que Karl Pearson lo usó en su Prueba de chi cuadrado para la bondad de ajuste que es anterior al la denominación de valor p según Fisher. Según sigamos el punto de vista de Fisher o el de Neyman-Pearson, en su origen, el valor p tenía significados teóricos levemente diferentes. Sin embargo, con el avance de la tecnología y la difusión de softs estadísticos su diferencia teórica, en apariencia, se desdibuja. Una selección arbitraria de los libros de texto para Administración y Economía editados en el siglo XXI nos ayudan a avalar esta idea: - BERENSON, M. L.; LEVINE, D. M.; KREHBIEL, T. C. (2001) (pag. 319): “En años recientes, con el advenimiento de los paquetes estadísticos y las hojas de cálculo, el concepto de valor p tiene una aceptación creciente…el valor p es la probabilidad de obtener un estadístico de prueba igual o más extremo que el resultado obtenido a partir de los datos muestrales, dado que la hipótesis Ho es en realidad cierta” - GUJARATI, N. G. (2006) (pag. 120): “El talón de Aquiles del planteamiento clásico para la contrastación de hipótesis es la arbitrariedad en la elección de α. Aunque 1, 5, y 10 por ciento en los valores comúnmente utilizados para α, no hay nada inviolable en estos valores…En la práctica, es preferible encontrar el valor p (es decir, el valor de probabilidad), también conocido como nivel exacto de significativadad del estadístico de prueba. Este valor se puede definir como el menor nivel de significatividad al que se puede rechazar una hipótesis nula”. Preferimos utilizar el término significación en lugar de significatividad puesto que esta última no figura en el diccionario de Real Academia Española (www.rae.es). - LIND, D. A.; MARCHAL, W. G. MASON, R. D. (2004) (pag.347): “En años recientes, debido a la disponibilidad de los programas de cómputo (software), se proporciona con frecuencia información adicional relativa a la fuerza del rechazo”… “El valor p es la probabilidad de observar un valor muestral tan extremo, o más extremo, que el valor observado, dado que la hipótesis nula es cierta”. - LEVINE, D. M.; KREHBIEL, T. C; BERENSON, M. L. (2006) (pag. 281): “La mayoría de los programas de cómputo moderno, incluyendo Excel, Minitab y SPSS calculan el valor -p al realizar una prueba de hipótesis….El valor-p es la probabilidad de obtener un estadístico de prueba igual o más extremo que el resultado de la muestra, dado que la hipótesis nula Ho es cierta…. El valor-p, que a menudo se denomina nivel de significación observado, es el nivel más pequeño en el que se puede rechazar Ho”. - NEWBOLD, P. (1997) (pag.290): “El menor nivel de significación al cual puede rechazarse la hipótesis nula se denomina valor crítico o p-valor, del contraste”. Y agrega al pie: “En los últimos años ha adquirido gran relevancia este concepto. Todos los programas estadísticos modernos proporcionan p-valores, y algunas calculadoras de bolsillo permiten su cómputo”. Si bien las ediciones que disponemos no se enmarcan en el siglo XXI, estimamos que la posición de importantes autores de libros de texto sobre Estadística no Paramétrica realizan un aporte de interés para nuestras inquietudes. - GIBBONS, J. D. (1997) (Pag. 13): “La decisión si aceptar o rechazar la hipótesis nula se realiza sobre la base de los resultados de una muestra aplicando una prueba estadística. La distribución probabilística de la prueba estadística se realiza sobre la base que la hipótesis nula es cierta”. “Seleccionada la prueba estadística se calcula a partir de la información que suministra la muestra. Con el valor numérico obtenido y la distribución probabilística de la prueba se puede calcular el valor p (p-value) o probabilidad asociada”. “El valor p es la probabilidad, cuando la hipótesis nula es cierta, de obtener un valor de la prueba que es igual a (o más extremo) (en la dirección apropiada) que su valor observado”. “El investigador puede simplemente reportar el valor p y concluir el análisis allí explicando que el valor p es la probabilidad de un resultado muestral tan extremo como lo observado cuando Ho es verdadera”. “En algunos casos el investigador puede desear tomar la decisión estadística de aceptar o rechazar la hipótesis nula. Su decisión puede basarse en el resultado del (magnitud) valor p del siguiente modo: Si el valor p es muy pequeño el investigador puede concluir que los datos no sustentan (support) la hipótesis nula. El mismo sentido si el valor p es grande el investigador podrá concluir que los datos sustentan Ho”. Entendemos que la autora se refiere a valores de p extremos, no hemos encontrado referencias a valores reportados”. Vemos que la autora va un poco más allá que la comparación entre el valor p y el nivel de significación que proponen otros autores al decir que el investigador puede reportar sólo el valor p y sobre la base de su resultado tomar la decisión de rechazar o no la hipótesis nula. - CONOVER, W. J. (1999) (pag. 101): “Los resultados de una prueba de hipótesis son más significativos si se establece también el valor p… El valor p es el nivel de significación más pequeño al que se podría rechazar la hipótesis nula para observaciones dadas”. Por último, y a modo de ejemplo de los resultados que reportan los softs presentamos una salida de EViews3. Corresponde a un ejemplo sencillo, usado en cursos de grado, sobre regresión múltiple para tres variables: volumen de producción (Y: variable dependiente), desperdicio en litros del material A (X 1) y desperdicio en gramos de material B (X2). La muestra corresponde a 25 ciclos productivos. Dependent Variable: Y Method: Least Squares Date: 00/00/00 Time: 00:00 Sample: 1 25 Included observations: 25 Variable Coefficient Std. Error t-Statistic Prob. C X1 X2 26.66597 -0.059701 -0.003251 1.339418 0.017361 0.000718 19.90863 -3.438739 -4.527469 0.0000 0.0023 0.0002 R-squared Adjusted R-squared S.E. of regression Sum squared resid Log likelihood Durbin-Watson stat 0.847974 0.834154 1.455886 46.63126 -43.26590 2.468650 Mean dependent var S.D. dependent var Akaike info criterion Schwarz criterion F-statistic Prob(F-statistic) 12.54360 3.574986 3.701272 3.847537 61.35615 0.000000 La última columna de la parte superior (Prob.) reporta los valores p para la prueba que corresponde a ordenada al origen (C) y para los coeficientes de X 1 y X2. También presenta (última fila de la última columna) el valor p para la prueba F de los coeficientes de regresión. El valor p cero indica que se rechazará siempre la hipótesis nula de que los coeficientes de las variables independientes son nulos y, por tanto, tienen, en conjunto, capacidad predictiva cualquiera haya sido el nivel de significación (α) que el investigador pudiera haber preestablecido. El mismo razonamiento se puede realizar para los valores p correspondientes a cada uno de los coeficientes. A MODO DE CONCLUSIÓN Coincidimos con Salsburg cuando afirma que “El valor p es una probabilidad, y así es como se calcula”. El valor p (p-value) se puede definir como el menor nivel de significación al que se puede rechazar una hipótesis nula cuando es verdadera. El discutido valor p se puede interpretar de distinta forma según el enfoque de Fisher o la Teoría de Neyman-Pearson. El avance de la tecnología permitió que los paquetes estadísticos reportaran el valor p. Estimamos que, desde el punto de vista de la tarea cotidiana, disponer del valor p no im plica inconsistencias. En efecto, el investigador podrá fijar de antemano el nivel de significación según lo establece la Teoría de Neyman-Pearson y, con el resultado que reporta el soft decidir sobre el rechazo, o no, de la hipótesis nula. No vemos inconveniente para que el investigador, sobre la base del valor p decida si rechaza, o no, la hipótesis nula. Esto implica necesariamente incorporar otros factores que van más allá del objetivo de este trabajo. BIBLIOGRAFÍA BERENSON, M. L.; LEVINE, D. M.; KREHBIEL, T. C. (2001): Estadística para Administración, Méjico, Pearson Education de México. Segunda edición CONOVER, W. J. (1999): Practical nonparametric statistics . USA. John Wiley & Sons. Tercera Edición. GIBBONS, J. D. (1997): Non Parametric Methods for Quantitative Analysis. U.S.A. American Sciences Press, Inc. GUJARATI, N. G. (2006): Principio de Econometría, España, McGraw-Hill/Interamericana de España. Tercera edición en español. KUEHL, R. O. (2001) Diseño de Experimentos. Principios estadísticos de diseño y análisis de investigación, Méjico. Internacional Thomson Editores. Segunda Edición. LEVINE, D. M.; KREHBIEL, T. C; BERENSON, M. L (2006): Estadística para Administración, Méjico, Pearson Education de México. Cuarta edición. LIND, D. A.; MARCHAL, W. G. MASON, R. D. (2004): Estadística para Administración y Economía, Bogotá. Alfaomega Colombiana S.A. MOSTERIN, J.: “La estructura de los conceptos científicos”. Revista “Investigación Científica” (Edición Española) No. 6, enero de 1978. NEWBOLD, P. (1997): Estadística para los Negocios y Economía, España, Prince Hall Internacional Inc. SALSBURG, D. (2001): The Lady Tasting Tea, New York, Henry Halt and Company LLC .