autocorrelación en el MBRL - Universidad Autónoma de Madrid

Anuncio

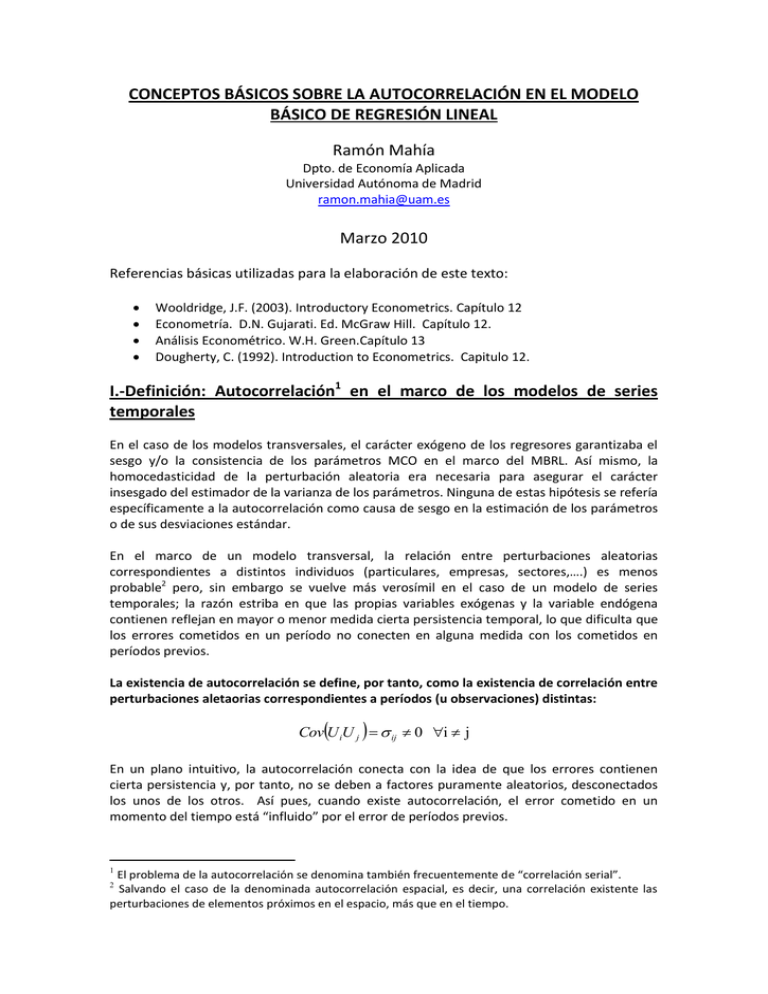

CONCEPTOS BÁSICOS SOBRE LA AUTOCORRELACIÓN EN EL MODELO BÁSICO DE REGRESIÓN LINEAL Ramón Mahía Dpto. de Economía Aplicada Universidad Autónoma de Madrid [email protected] Marzo 2010 Referencias básicas utilizadas para la elaboración de este texto: Wooldridge, J.F. (2003). Introductory Econometrics. Capítulo 12 Econometría. D.N. Gujarati. Ed. McGraw Hill. Capítulo 12. Análisis Econométrico. W.H. Green.Capítulo 13 Dougherty, C. (1992). Introduction to Econometrics. Capitulo 12. I.-Definición: Autocorrelación1 en el marco de los modelos de series temporales En el caso de los modelos transversales, el carácter exógeno de los regresores garantizaba el sesgo y/o la consistencia de los parámetros MCO en el marco del MBRL. Así mismo, la homocedasticidad de la perturbación aleatoria era necesaria para asegurar el carácter insesgado del estimador de la varianza de los parámetros. Ninguna de estas hipótesis se refería específicamente a la autocorrelación como causa de sesgo en la estimación de los parámetros o de sus desviaciones estándar. En el marco de un modelo transversal, la relación entre perturbaciones aleatorias correspondientes a distintos individuos (particulares, empresas, sectores,….) es menos probable2 pero, sin embargo se vuelve más verosímil en el caso de un modelo de series temporales; la razón estriba en que las propias variables exógenas y la variable endógena contienen reflejan en mayor o menor medida cierta persistencia temporal, lo que dificulta que los errores cometidos en un período no conecten en alguna medida con los cometidos en períodos previos. La existencia de autocorrelación se define, por tanto, como la existencia de correlación entre perturbaciones aletaorias correspondientes a períodos (u observaciones) distintas: CovU iU j ij 0 i j En un plano intuitivo, la autocorrelación conecta con la idea de que los errores contienen cierta persistencia y, por tanto, no se deben a factores puramente aleatorios, desconectados los unos de los otros. Así pues, cuando existe autocorrelación, el error cometido en un momento del tiempo está “influido” por el error de períodos previos. 1 El problema de la autocorrelación se denomina también frecuentemente de “correlación serial”. Salvando el caso de la denominada autocorrelación espacial, es decir, una correlación existente las perturbaciones de elementos próximos en el espacio, más que en el tiempo. 2 Cuando existe autocorrelación, y en un plano puramente analítico, la matriz de varianzascovarianzas de las perturbaciones de un modelo contiene ahora elementos no nulos fuera de la diagonal principal: Matriz de varianza y covarianzas Homocedástica e Incorrelacionada E (u1 ) 2 E (u 2 u1 ) E (u 2 ) 2 E (UU ' ) E (u n u1 ) E (u n u 2 ) ... . 2 0 2 ... 0 0 ... 0 2 ... E (u n ) 0 0 ... 0 ... 0 2In ... 0 ... 2 Matriz de varianza y covarianzas Heterocedástica pero Incorrelacionada E (u1 ) 2 E (u 2 u1 ) E (u 2 ) 2 E (UU ' ) E (u n u1 ) E (u n u 2 ) ... . 12 0 2 ... 0 2 0 ... 0 2 ... E (u n ) 0 0 ... 0 ... 0 i2 I n 2 ... 0 ... n2 Matriz de varianza y covarianzas Heterocedástica y con Autocorrelación E (u1 ) 2 E (u 2 u1 ) E (u 2 ) 2 E (UU ' ) E (u n u1 ) E (u n u 2 ) ... . 12 CovU 1U 2 ... 22 CovU 2U 1 CovU 3U 1 CovU 3U 2 ... 2 ... E (u n ) CovU nU 1 CovU nU 2 ... CovU 1U n ... CovU 2U n i2 I n 2 ... CovU 3U n ... n2 II.- Consecuencias de la autocorrelación en el MBRL estimado con MCO En términos generales los efectos de la presencia de autocorrelación sobre el MBRL estimado con Mínimos Cuadrados Ordinarios son extremadamente similares a los analizados para la Heterocedasticidad: - El estimador de Mínimos Cuadrados Ordinarios sigue siendo lineal, insesgado y consistente. Como ya dijimos para el caso de la heterocedasticidad, debe recordarse que la autocorrelación de la perturbación no juega ningún papel relevante en la insesgadez o la consistencia. - Sin embargo, y como primer efecto (defecto) las varianzas de los parámetros estimados por Mínimos Cuadrados Ordinarios no pueden estimarse con la expresión utilizada en presencia de autocorrelación. Dicho de otro modo, la expresión3 de la varianza de los estimadores MCO es un estimador sesgado de la verdadera varianza 3 Recuerde que en su forma matricial esta expresión es u2 V ˆ j parámetro V x j 1 R 2j 1 V (ˆ ) 2 X ' X o para un único de los parámetros. La naturaleza (tamaño y signo) del sesgo en la estimación de la varianza depende de la forma específica de autocorrelación en la perturbación pero, generalmente4, el sesgo en el cálculo incorrectamente realizado tiende a ser negativo en muchas aplicaciones, es decir, subestima el verdadero tamaño de la varianza de los parámetros. - En todo caso, sea el sesgo positivo o negativo, partiendo de una expresión incorrecta de la varianza de los parámetros, se cometerá, como en el caso de la heterocedasticidad, un error en el contraste “t” de significatividad individual, que puede llevarnos a errores en el rechazo o aceptación de las variables como significativas. Si el sesgo más frecuente es por subestimación, será también frecuente que la autocorrelación nos lleve al falso rechazo de la hipótesis nula en el contraste “t”, es decir, a la falsa aceptación de variables como relevantes que en realidad, no lo son. Los cálculos del estadísticos muestral “t” ya no podrán comprarse con los valores de referencia correctos de las distribuciones “t” y, en realidad, lo mismo ocurrirá con el resto de cálculos “derivados” de la estimación de la varianza de la perturbación aleatoria: el contraste “F” ya no se distribuirá como una “F” o los contrastes LM ya no seguirán una Chi-Cuadrado. - Una segunda consecuencia de la presencia de autocorrelación sobre el estimador MCO es que este pierde su eficiencia, deja de ser el “más preciso” entre los insesgados. En presencia de autocorrelación, el estimador eficiente es el estimador de MCG, el mismo presentado cuando se introdujo la cuestión de la heterocedasticidad: MCG X ' 1 X X ' 1Y ~ 1 Intuitivamente, la razón de que exista un estimador sin sesgo más preciso reside en que, si conocemos los patrones de evolución de los residuos, podemos utilizar estos patrones para dar más o menos importancia a las observaciones asociadas a residuos más separados de la línea de regresión (de media residual nula) en lugar de ponderar todas las observaciones por igual (como hace MCO). - Por otro lado, y con relación a los modelos que contienen variables dependientes retardadas, debe recordarse que la presencia de autocorrelación en estos modelos puede impactar además en la inconsistencia de los parámetros (este aspecto fue debidamente comentado y desarrollado en el texto referido al problema de los regresores estocásticos). III.- Causas frecuentes de autocorrelación 4 El tamaño y signo del sesgo en la estimación de la varianza depende básicamente de dos factores: del tamaño y el signo de la autocorrelación en las perturbaciones y del tamaño y el signo de la autocorrelación en los propios regresores. La autocorrelación de carácter más general es que responde a un modelo autorregresivo AR(1) positivo en la perturbación; por otro lado, la autocorrelación de las propias variables exógenas suele ser también, cuando existe, de naturaleza positiva. En estas condiciones, relativamente frecuentes, puede comprobarse que el sesgo suele infravalorar el verdadero valor de la varianza de los parámetros estimados. Al igual que en el resto de hipótesis, debe decirse que la presencia de autocorrelación es un característica esencialmente natural en todos los modelos de series temporales, los factores que se encuentran en la perturbación aleatoria (los errores) tienen inevitablemente conexiones temporales, es decir, una cierta persistencia y esto sucede, de forma inevitable, porque los fenómenos de causalidad analizados con perspectiva temporal y los acontecimientos imprevisibles que impactan en esas relaciones muestran también cierta persistencia. Este fenómeno “natural” es tanto más frecuente cuanto mayor es la frecuencia de los datos; en datos de frecuencia baja, la posibilidad de que un acontecimiento que impactó en una perturbación extienda sus efectos a la siguiente es menor. En todo caso, y más allá de la autocorrelación “natural”, y como siempre repetimos, conviene identificar algunas situaciones específicas, habituales en la econometría empírica, asociadas al riesgo de autocorrelación. 1.- Omisión de variables relevantes en el modelo especificado. Esta es, sin duda alguna, la principal causa de autocorrelación en un MBRL hasta el punto de que las pruebas de autocorrelación se consideran generalmente pruebas para evaluar si una especificación es completa o no. Efectivamente, si omitimos una variable relevante, su efecto quedará recogido en la perturbación aleatoria y en la medida en que esa variable omitida muestre una mínima persistencia y/o una evolución sistemática, la perturbación quedará “contagiada” inevitablemente de ella. En el caso de series temporales, la omisión de variables relevantes implica notables problemas de autocorrelación en tanto que algunas series presentan comportamientos temporales especialmente persistentes (clara tendencia) o sistemáticas (estacionales, o cíclicas por ejemplo) de modo que, en ausencia de variables adecuadas que expliquen esos movimientos sistemáticos, la persistencia o el “artefacto” acentúa la autocorrelación residual. En el gráfico siguiente, por ejemplo, la variable analizada es claramente estacional; si omitimos las variables que “conectan” con esa estacionalidad, el error contendrá un patrón estacional inevitable: Ilustración gráfica de un ajuste que ha omitido variables estacionales 25000 20000 15000 6000 10000 4000 2000 5000 0 -2000 -4000 -6000 99 00 01 Residual 02 03 Actual 04 05 Fitted 2.- Asincronía temporal causa – efecto cuando los datos se miden en forma “discreta”, no continua En algunos fenómenos temporales, los cambios en las variables exógenas no se transmiten siempre de forma instantánea a la variable endógena, lo cual genera un riesgo de inducir un cierto patrón autocorrelacionado en el error; si el efecto de un cambio en Xt se retrasa total o parcialmente a “t+1”, el efecto sobre Yt estará subestimado (error positivo) en tanto que el efecto en Yt+1 estará sobre estimado (error negativo). Evitar este tipo de problemas no es fácil en la práctica pero requiere atender cuidadosamente a la selección de la frecuencia de análisis correcta y/o a considerar la posibilidad de incluir retardos / adelantos de exógenas / endógenas en la especificación temporal del modelo, es decir, optar por un modelo dinámico en lugar de estático.5 3. Forma funcional incorrecta Una vez más, la utilización de una forma funcional incorrecta, por ejemplo la utilización de una función lineal en lugar de una logarítmica o potencial, puede provocar que la calidad del ajuste de la regresión (y por tanto los errores) muestre comportamientos sistemáticos en el tiempo, ajustando, por ejemplo, adecuadamente los valores pasados y mal los recientes, induciéndose de esta manera una autocorrelación positiva. Ilustración gráfica de la relación NO LINEAL entre producción y coste y resultado de un ajuste lineal para datos anuales entre 1975 y 2008 5 Un ejemplo de asincronía cásico es el debido a Kaldor, 1934 con relación al modelo la teoría “cobweb” que explicaba las fluctuaciones “cíclicas” de precios y los movimientos asincrónicos oferta – demanda en aquellos mercados en los que la oferta ha de decidirse antes de conocer los precios reales y, por tanto, ha de basarse en expectativas sobre precios. Cuando estas expectativas son “adaptativas” en lugar de “racionales”, los productores utilizarán los precios en “t” para decidir su oferta en “t+1” generando excesos o contracciones de oferta asincrónicas y cíclicas y cíclicos movimientos de precios. 2000 2000 1500 1000 1500 COSTE 500 0 300 1000 -500 200 100 500 0 -100 0 0 2 4 6 8 -200 10 75 PRODUC 80 85 90 Residual 95 Actual 00 05 F itted La relación lineal, subestima el coste de producción de los últimos años , que ha crecido potencialmente con la producción y sobrestima el coste de los años intermedios. 4. Transformaciones incorrectas de los datos. Manipular incorrectamente los datos creando “artefactos” temporales puede generar modelos con riesgo de autocorrelación. Así, por ejemplo, tomar en un modelo primeras diferencias, genera una perturbación autocorrelacionada aún cuando la perturbación del modelo en niveles no lo estuviera.6 5. No estacionariedad de las series Como se verá más adelante, la utilización de series no estacionarias (especialmente en varianza) en el análisis de regresión implica un alto riesgo de que el error se muestre también no estacionario mostrando, por tanto, una inevitable autocorrelación. IV.- ¿Cómo se detecta la presencia de Autocorrelación? Antes de plantear los métodos de detección de la autocorrelación, conviene especificar qué tipo concreto de autocorrelación es, de todas las posibles, la más probable en un modelo de regresión. Sólo de este modo, concretando la naturaleza del problema, podremos proponer métodos suficientemente eficaces de detección. Trabajaremos para ello con la hipótesis del modelo más simple y frecuente de autocorrelación, el conocido como modelo autorregresivo de orden 1 ó AR(1): ut ut 1 t |ρ|<1 El coeficiente autorregresivo “ρ” se entiende menor que la unidad en valor absoluto7 lo que sugiere que cuando se produce un “shock” de naturaleza aleatoria de tamaño “u” en un 6 La transformación de un modelo en diferencias es una práctica habitual en econometría. Las primeras diferencias reflejan el crecimiento (bruto, no porcentual) de una serie entre dos observaciones. 7 En el caso en que ρ fuese superior a 1, las perturbaciones en “t” serían mayores que en “t-1” lo que indicaría que los shocks o perturbaciones aleatorias, cuando ocurren, no tienen un efecto limitado en el momento “t” del tiempo, este “shock” queda reducido al período siguiente a un menor tamaño ρut; es decir, el “shock” aletaorio va “diluyéndose” progresivamente con el tiempo. Este modelo, sugiere que sólo existe correlación parcial entre la perturbación aleatoria de un período (t) y la del período anterior (t-1) conforme a una sencilla forma funcional lineal. En concreto, el valor de la perturbación aleatoria en “t” es una fracción del valor de la perturbación previa “t-1” dado que “ρ” es menor que la unidad. Cuando el valor del coeficiente “ρ” es positivo, dos perturbaciones consecutivas comparten valores similares y del mismo signo8 y decimos entonces que existe autocorrelación positiva. Cuando el valor del coeficiente “ρ” es negativo, las perturbaciones mantienen también valores similares pero van alternando sus signos; decimos entonces que existe autocorrelación “negativa”. La relación entre cada perturbación ut y la previa no es exacta, determinista, sino que viene condicionada por la existencia de una nueva perturbación aleatoria εt de carácter “esférico”: E t 0 V t 2 cte. Cov t , t s 0 t,s Aunque cabría pensar que el proceso real de autocorrelación fuera más complejo, por ejemplo un AR de orden superior AR(p) o un proceso de medias móviles MA(q), lo cierto es que este modelo de autocorrelación simple, captura con facilidad la mayor parte de las situaciones reales de autocorrelación. En primer lugar, la perturbación no puede seguir un proceso regular AR de orden superior, por ejemplo un AR(2), sin mostrar también una correlación parcial con el retardo de orden uno;9 es decir, el proceso verosímil sería: ut 1ut 1 2ut 2 t y nunca: ut 2ut 2 t Por otro lado, en caso de existir un patrón de autocorrelación MA (de “medias móviles”), por ejemplo un MA(1) del tipo: ut t 1 t tiempo, sino que inician un proceso de crecimiento progresivo en los sucesivos períodos; una situación, poco verosímil y que generaría demás, desde el punto de vista técnico, importantes problemas que se analizarán en una sección posterior del curso. 8 Obsérvese que esta propiedad no significa que TODOS los errores tengan siempre el mismo signo. La relación entre ut y ut-1 es de naturaleza estocástica está influida por la presencia del componente aleatorio εt que puede tomar aleatoriamente valores positivos y negativos. Por otro lado, conviene además recordar que la perturbación aleatoria ut conserva su media nula, de modo que sería imposible que todos sus valores sean de un mismo signo. 9 Esto se conoce como “ergodicidad”; una propiedad necesaria para garantizar que un proceso estocástico temporal sea ergódico es que la correlación entre las observaciones tienda a cero al aumentar la separación entre ellas. debe recordarse que, merced al teorema de Wald, siempre podrá expresarse ese proceso MA(q) como un proceso AR(p). A. Contrastes Gráficos A.1) Gráfica temporal del error La presencia de una autocorrelación severa puede observarse gráficamente analizando el gráfico secuencial (temporal) de los residuos. En una serie sin autocorrelación, el valor del residuo “hoy” no informa sobre dónde estará el valor del residuo “mañana”. Así, en una serie puramente aleatoria, no autocorrelacionada, los datos cambian frecuentemente de tamaño y signo, de positivos a negativos, de grandes a pequeños y viceversa, cruzando la media nula con asiduidad y sin mostrar ningún patrón reconocible; cuando se produce un error puntual muy elevado, la serie “no tiene memoria” y retorna al valor nulo promedio con facilidad. Sin embargo, en presencia de autocorrelación imprime un comportamiento sistemático en la serie de residuos que normalmente es visible. Los residuos muestran comportamientos predecibles en valor y en signo: En el caso de la autocorrelación positiva, los residuos consecutivos comparten valores y signos similares, mostrándose amplias zonas de sobrestimación y subestimación lo que genera visibles patrones de “ondas”. En el caso de autocorrelación negativa, los residuos muestran valores semejantes entre observaciones pero alternando el signo constantemente, generándose de este modo patrones “dentados”. A.2) Gráfica de dispersión del error con su retardo Un gráfico aún más ilustrativo es el gráfico de dispersión (Scat) del residuo con sus retardos (generalmente con el primero). Si existe autocorrelación, la nube de puntos que ilustra la conexión entre los residuos en “t” y los resiudos en “t-1” mostrará un aspecto “creciente” o “decreciente” muy ilustrativo de esa relación. GRÁFICOS SECUENCIALES DE RESIDUOS Y GRÁFICOS DE DISPERSIÓN Ejemplo de series residuales con distinto grado de autocorrelación NO autocorrelación 1,5 1 0,8 0,6 0,4 0,2 0 -0,2 -0,4 -0,6 -0,8 -1 -1,2 1 0,5 0 -1,5 -1 -0,5 0 0,5 1 1,5 -0,5 1 5 9 13 17 21 25 29 33 37 41 45 49 53 57 61 65 69 73 77 81 85 89 93 97 -1 -1,5 Autocorrelación AR(1) POSITIVA muy débil ρ=0.25 Autocorrelación AR(1) NEGATIVA muy débil ρ=0.25 1,5 1 0,8 0,6 0,4 0,2 0 -0,2 -0,4 -0,6 -0,8 -1 1 0,5 0 -1,5 -1 -0,5 0 -0,5 1 1,5 1 0,5 0 -1,5 -1 -0,5 0 -0,5 -1 1 5 9 13 17 21 25 29 33 37 41 45 49 53 57 61 65 69 73 77 81 85 89 93 97 1 5 9 13 17 21 25 29 33 37 41 45 49 53 57 61 65 69 73 77 81 85 89 93 97 -1 0,5 1,5 1,2 1 0,8 0,6 0,4 0,2 0 -0,2 -0,4 -0,6 -0,8 -1 -1,5 Autocorrelación AR(1) POSITIVA débil ρ=0.5 -1,5 Autocorrelación AR(1) NEGATIVA débil ρ=0.5 0,5 1 1,5 1,5 1,5 1 1 0,5 0,5 0 0 2 1 1,5 0,5 1 0 -2 -0,5 -1,5 -1 -0,5 0 0,5 1 0,5 0 -0,5 1,5 -0,5 -1 -2 -1 -1,5 -1 -0,5 -1,5 0,5 0 -2 -1,5 -1 -0,5 1 5 9 13 17 21 25 29 33 37 41 45 49 53 57 61 65 69 73 77 81 85 89 93 97 2 1,5 2 1,5 1 1,5 1 0,5 1 0,5 0 0,5 -0,5 -0,5 0 0,5 1 1,5 2 -1 -0,5 1 5 9 13 17 21 25 29 33 37 41 45 49 53 57 61 65 69 73 77 81 85 89 93 97 1 1 0 0 -1 0 -3 -2 -1 -1 0 -2 -3 -3 1 5 9 13 17 21 25 29 33 37 41 45 49 53 57 61 65 69 73 77 81 85 89 93 97 1 5 9 13 17 21 25 29 33 37 41 45 49 53 57 61 65 69 73 77 81 85 89 93 97 -4 -2 -5 -6 -4 B. Contrastes numéricos B.1) Contraste del Durbin - Watson Uno de los tests más estándar para la detección de la autocorrelación es el conocido como test o prueba de Durbin – Watson. Este test, propuesto POR Durbin y Watson en 1950, propone utilizar los residuos et del modelo estimado para computar el siguiente coeficiente: n DW e t 2 t et 1 2 n e t 1 2 t Para comprender los valores del DW indicativos de autocorrelación positiva, vamos a realizar una serie de sencillas transformaciones: n 2 et et 1 et2 et21 2et et 1 et t 1 2 3 4 0 -1 -4 n 2 2 4 -3 2 1 2 -2 DW 1,5 3 2 2 t 2 1 4 3 3 n 0,5 Autocorrelación AR(1) NEGATIVA severa ρ=0.95 4 -2 0 -2 Autocorrelación AR(1) POSITIVA severa ρ=0.95 -4 -0,5 -1,5 -2 -6 2 -1 -2 -1,5 1 5 9 13 17 21 25 29 33 37 41 45 49 53 57 61 65 69 73 77 81 85 89 93 97 -1,5 -1,5 -1 3 2,5 2 1,5 1 0,5 0 -0,5 -1 -1,5 -2 1,5 0 -2 -1 -1 -1,5 1 Autocorrelación AR(1) NEGATIVA moderada/alta ρ=0.75 0 -0,5 0,5 -2 Autocorrelación AR(1) POSITIVA moderada/alta ρ=0.75 1 0 -1,5 -2 1,5 -0,5 -1 -1,5 1 5 9 13 17 21 25 29 33 37 41 45 49 53 57 61 65 69 73 77 81 85 89 93 97 -1,5 -1 t 2 n e t 1 n et2 t 2 n e 2 t 2 t t 1 n et21 t 2 n e t 1 t 2 n e e 2 t 2n t t 1 e t 1 2 t Los dos primeros términos del anterior sumando son aproximadamente igual a la unidad: n e e DW 1 1 2 t 2n t t 1 e t 1 t 2 1 Por otro lado, la última de las ratios es una aproximación casi exacta a la expresión de la correlación muestral entre et y et-1: n ret ,et 1 e t 2 n e t 1 t t et et 1 et 1 et 2 n e t 2 t 1 et 1 2 Considerando que la correlación muestral entre et y et-1 es un buen estimador del coeficiente “ρ” del proceso subyacente AR(1) en las perturbaciones aleatorias10 tenemos entonces que: DW 1 1 2 ˆ DW 21 ˆ Así pues, ahora resulta más fácil interpretar los valores límites del DW: En caso de autocorrelación máxima y positiva: 1 DW 21 1 DW 0 En caso de autocorrelación máxima y negativa: 1 DW 21 (1) DW 4 En caso de que no exista autocorrelación: 0 DW 21 0 DW 2 Para evaluar si el valor del DW de un modelo de regresión refleja autocorrelación positiva, negativa o nula, no bastará con los valores extremos: ¿qué ocurre, por ejemplo, si el DW toma en nuestro modelo el valor 2,3?. Lo ideal sería disponer de la función de densidad de este estadístico para poder contrastar hipótesis sobre su valor; sin embargo, Durbin y Watson comprobaron que, lamentablemente, la distribución de este estadístico no sólo depende de los grados de libertad con los que se calcula (como siempre ocurre con cualquier estadístico e contraste) sino también de los valores de las variables exógenas “x” empleadas en la regresión. Es decir, en algunas regresiones, el valor del estadístico DW tiende a acercarse más a 2 que en otras cuando ρ=0, lo que impide utilizar valores tabulados exactos para contrastar la hipótesis de ausencia de autocorrelación. Pese a todo, existen unas tablas de Durbin Watson que, de forma aproximada, permiten establecer áreas de certeza alrededor de los valores límites examinados previamente. Para un determinado nivel de significación (o confianza) fijado por el analista, las tablas del DW ofrecerán siempre dos valores, uno inferior “di” y otro superior “ds” que habrán de situarse del siguiente modo alrededor de los valores límite del DW: 10 Aunque no se han examinado todavía en el curso las propiedades de un proceso AR(1) para una serie genérica yt, puede demostrarse que el valor del coeficiente “ρ” de un proceso de este tipo coincide con el coeficiente de correlación simple (y parcial) entre yt y yt-1. 0 2 di ds 4 4-ds 4-di Estos límites, permiten así identificar, alrededor del 2, la zona consistente con la hipótesis nula de ausencia de autocorrelación H0:ρ=0. 0 2 di ds 4 4-ds 4-di Las zonas de rechazo de la hipótesis nula son las que circundan el valor “0” y el valor “4”, es decir, los valores que claramente indican autocorrelación positiva o negativa: 0 2 di ds 4 4-ds 4-di Lamentablemente, y por la limitación antes mencionada, existen zonas de “duda” en las que el estadístico DW no permite rechazar o aceptar la hipóteis nula, son las zonas intermedias entre di y ds y entre 4-di y 4-ds. 0 2 di ds 4 4-ds 4-di Por un criterio de “prudencia valorativa”, si el valor del DW “cae” en zona de duda, conviene quizá concluir que existe autocorrelación y tratar de profundizar más en su naturaleza y corregirla, antes que arriesgar un diagnóstico en sentido contrario. B.2) Contraste “t” en el modelo AR(1) residual Un test alternativo a la prueba DW consiste en estimar el modelo simple AR(1) utilizando los residuos “e” de nuestra regresión: et et 1 t El modelo puede estimarse con o sin término independiente y en todo caso, la hipótesis nula de No Autocorrelación se asociaría con un valor estimado ρ=0, algo que podemos verificar con el contraste de significación estadística habitual “t”. El valor estimado de “ρ” es sólo un estimador consistente del verdadero valor de “ρ” por lo que, para muestras grandes, podemos utilizar el resultado del test “t” como un buen indicador de la presencia de autocorrelación en la perturbación. B.3) Contraste “t” en presencia de regresores estocásticos y prueba de Breusch - Godfrey El test DW expuesto previamente no sólo presenta la importante limitación de presentar zonas de incertidumbres sino que, además, exige el cumplimiento de algunas hipótesis adicionales. Entre ellas, la más relevante es la exigencia de exógenas deterministas en la regresión. En este sentido, la presencia de exógenas relacionadas con la perturbación ut o con ut-1 invalida el funcionamiento del test incluso para muestras grandes. Este problema, no sólo concierne al test DW, sin que afecta del mismo modo a la validez del contraste “t” sobre la regresión AR(1) residual expuesto previamente. La presencia de regresores estocásticos es una circunstancia relativamente habitual y especialmente frecuente en el caso de las series temporales cuando se utilizan aproximaciones dinámicas en las que se incluyen como explicativas las propias endógenas retardadas, como en el siguiente ejemplo: yt 1 2 x2t 3 yt 1 ut Para solucionar este problema, existen algunas pruebas adaptadas, como el estadístico “h” de Durbin que no se analizará en este texto. Alternativamente, puede realizarse una sencilla modificación de la prueba “t” para el AR(1) residual expuesto previamente consistente en incluir en la estimación del modelo residual AR(1) todos los regresores del modelo original. Es decir, si el modelo analizado es, por ejemplo: yt 1 2 x2t 3 yt 1 ut Utilizamos los residuos “et” de este modelo, y en lugar de estimar: et et 1 t estimamos alternativamente: et 1 2 x2t 3 yt 1 et 1 t De este modo, nuevamente podemos testar consistentemente la presencia de autocorrelación con el contraste “t” sobre el valor del coeficiente estimado para “ρ”. Alternativamente, Breusch y Godfrey propusieron utilizar esta regresión para computar el estadístico LM a partir del valor de su R2. Así, demostraron que si el tamaño muestral es suficientemente grande, bajo la nula de No Autocorrelación: ( N p) R 2 p2 donde “p” es el número de retardos residuales incluidos en la regresión. La razón de que aparezcan hasta “p” retardos residuales es que, aunque nosotros hemos ejemplificado este método para el caso de una autocorrelación AR(1)11, la prueba puede utilizarse para contrastar modelos de autocorrelación de orden superior AR(p) si sospechamos que están presentes en los datos. Determinar a priori el valor de los “p” retardos a incluir en la prueba no es fácil, por lo que se recomienda “probar” con distintos valores de p (1,2… quizá 3) y comparar los distintos resultados obtenidos. 11 De hecho, la prueba Breusch – Godfrey se asocia generalmente a la existencia de un orden de autocorrelación superior a uno y cuando sólo se incluye un retardo residual se conoce como M- de Durbin. V. Cómo se corrige Una vez más, como en los anteriores temas, debe decirse que la verdadera corrección de la autocorrelación pasa necesariamente por la solución de su causa. En este sentido, debe recordarse que, en muchas ocasiones12, la autocorrelación es síntoma de una especificación inadecuada insuficiente y, por tanto, la corrección de la autocorrelación implicaría necesariamente un replanteamiento de la misma. No obstante, y desde un punto de vista estrictamente técnico, pueden proponerse diversas técnicas adaptativas ante la incómoda presencia de autocorrelación. 1.- Utilización de MCG factibles en presencia de autocorrelación AR(1) Una alternativa teórica a la presencia de autocorrelación es la utilización de MCG. Sin embargo, como es sabido, la utilización de MCG exige disponer de información precisa sobre el modelo de autocorrelación existente y los parámetros que lo regulan. Desde un punto de vista práctico, la utilización de MCG no es posible de modo que debemos conformarnos con una versión “factible” de esos MCG que denominaremos, como ya ocurriera en el caso de la heterocedasticidad MCGF. La idea consiste, de hecho, en seguir utilizando el estimador MCO realizando previamente la adecuada transformación en los datos originales para que, el nuevo modelo transformado, sea un modelo libre de autocorrelación. La transformación propuesta en este caso consiste en utilizar las “semidiferencias” de los datos originales a partir del valor del coeficiente “ρ” de autocorrelación: yt* yt yt 1 x *jt x jt x jt 1 Esta transformación se explica con facilidad si partimos del modelo original en el que presuntamente existe autocorrelación AR(1). Por simplicidad, imaginemos que ese modelo es: yt 1 2 x2t ut con: ut ut 1 t Entonces, se sigue que: yt 1 2 x2t ut yt 1 2 x2t ut 1 t yt 1 2 x2t yt 1 1 2 x2t 1 t de modo que: yt yt 1 1 1 2 x2t x2t 1 t yt* 1 1 2 x2*t t 12 Algunos autores distinguen esta situación de aquella en la que la autocorrelación no viene provocada por una deficiente especificación. Gujarati, por ejemplo, define esta situación como Autocorrelación Pura. donde recordemos, habíamos definido la nueva perturbación εt como una perturbación aleatoria esférica y, por tanto, sin autocorrelación. Utilizar los datos en semi – diferencias, permite por tanto obtener estimaciones de los parámetros y sus desviaciones aparentemente libres de autocorrelación. Para el término constante. Debe observarse que no se obtendrá el verdadero valor de β1. Para evitar este problema, o bien utilizamos como término constante la expresión (1-ρ) o bien realizmaos la regresión con término constante: yt* 1 2 x2*t t y después obtenemos β1 como: 1 1 1 Para la utilización de MCGF en la práctica conviene llamar la atención sobre algunas cuestiones importantes: 1.- Evidentemente, realizar la estimación MCGF exige disponer del valor de “ρ”, o dicho con más propiedad, de una estimación de este valor. Esta estimación puede obtenerse de varias formas, todas ellas equivalentes o casi – equivalentes. Podemos, por ejemplo, utilizar el valor del DW y su relación con “ρ” DW 21 ˆ ˆ 1 DW 2 Alternativamente, podemos realizar la estimación AR(1) residual y obtener “ρ” por MCO: et et 1 t Utilizar una estimación de “ρ” parece sencillo pero, sin embargo, entraña importantes repercusiones. Efectivamente, la utilización de los datos transformados como propone MCGF resuelve, teóricamente, los problemas de la autocorrelación pero debe señalarse que eso solo ocurre si disponemos del verdadero valor de “ρ”. Si, como sucede en la práctica, usamos una estimación de “ρ”, el estimador MCGF presenta un comportamiento desconocido en muestras pequeñas. Es cierto que, en general, el esimador MCGF gana en eficiencia y suele ser consistente, pero no es insesgado y los contrastes “t” y “F” no se ajustan en realidad verdaderas distribuciones “t” y “F” aún cuando la perturbación aleatoria siga una normal. 2.- Normalmente, el cálculo y la utilización de estos estimadores de “ρ” suele realizarse de forma iterativa, y no en un único paso. Así, comenzaremos por calcular un valor estimado de “ρ” a partir del modelo original y procederemos a realizar una primera corrección del modelo. Una vez corregido, recalcularemos de nuevo el valor de “ρ” con el nuevo conjunto de residuos y realizaremos una segunda corrección sobre el modelo previamente corregido. El proceso iterativo termina cuando entre dos estimaciones sucesivas de “ρ” no exista una diferencia significativa como para seguir con correcciones adicionales13. Este método iterativo es conocido habitualmente como Cochrane – Orcutt. 13 Un valor de cambio en “ρ” inferior a 0,05 es suficientemente pequeño para ser considerado irrelevante Normalmente, esto sucede en dos o, a lo sumo, tres iteraciones. 3.- En tercer lugar, debe observarse que la transformación de los datos en semi- diferencias implica perder la primera de las observaciones de la muestra. Esta pérdida no es excesivamente relevante en la mayor parte de análisis temporales en los que se cuente con muestras de un tamaño suficiente. No obstante, existe la posibilidad de “recuperar” esa primera observación realizando para ella una transformación alternativa conocida como Prais – Winsten. 4.- En cuarto lugar, pero no por ello menos importante, debe observarse que la utilización de MCGF puede generar parámetros sensiblemente diferentes a los obtenidos en el modelo original. Este cambio en el valor de los parámetros resulta perturbador, dado que el analista espera que la corrección de la autocorrelación afecte a las varianzas de los parámetros y no a su valor. Las diferencias pueden deberse a varios factores, como la utilización de muestras no demasiado grandes o algunas propiedades de los regresores. En términos generales, resulta difícil saber si las diferencias entre la estimación MCO y MCGF son estadísticamente relevantes pero, como norma general, se desaconseja la utilización de MCGF si los resultados de los parámetros difieren clara y visiblemente de los originales. 2.- Utilización de procedimientos de inferencia robustos a la autocorrelación usando MCO Conviene recordar que el mayor de los problemas derivados de la autocorrelación es el cálculo incorrecto de la desviación estándar de los parámetros MCO. En este sentido, una primera propuesta adaptativa a la presencia de autocorrelación es concentrar la corrección en el cálculo de la varianza de los parámetros con una propuesta de corrección similar a la estimación automática corregida de heterocedasticidad de White, pero ideada para el contexto en el que exista un problema de autocorrelación. El detalle técnico sobre la propuesta de corrección excede la profundidad de este texto, debida originalmente a Newey y West (1987), pero afortunadamente la mayor parte de los programas informáticos incorporan esta corrección automática bajo la denominación Estimador Newey – West o bien estimación con errores estándar CHA (consistentes con la heterocedasticidad y la autocorrelación). Más allá de los detalles técnicos, interesa comprender las ventajas de esta estimación frente a la aplicación de MCGF. Tal y como señala Wooldridge14 esta estrategia es, en ocasiones, preferible, dado que la consistencia de MCGF exige que todos los regresores sean estrictamente exógenos y además supone a priori la existencia de un modelo de autocorrelación AR(1). En sentido contrario, la utilización de procedimientos de inferencia robustos sólo es estrictamente válido en presencia de muestras grandes, por lo que, quizá, la solución MCGF es la propicia cuando no se dispone de ellas. 14 Wooldridge, J.F. (2003). Introductory Econometrics. Epígrafe 12.5.