Tema 3: Procedimientos de Constrastación y Selección de Modelos

Anuncio

Tema 3:

Procedimientos de

Constrastación y Selección

de Modelos

1

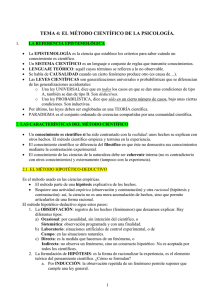

TEMA 3: PROCEDIMIENTOS DE

CONTRASTACIÓN Y SELECCIÓN DE

MODELOS

3.1) Introducción a los Modelos con Restricciones.

Estimación Restringida.

3.2) Contrastes de Selección de Modelos

- Razón de Verosimiltud

- Test de Wald

- Multiplicadores de Lagrange

- Contraste de Nulidad de un Subconjunto de

Parámetros

3.3) Contraste de Chow de Cambio Estructural.

3.4) Contraste RESET de Ramsey

2

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

MODELO

d

Y = X ⋅ β +U

U → N (ϑ , σ u2 ⋅ I )

MCO

- LINEAL

βˆMCO = ( X '·X ) · X '·Y

−1

βˆ MCO = W ⋅ Y

- INSESGADO

E ( βˆ MCO ) = β

- CONSISTENTE

lim βˆ MCO = β

n→∞

- ÓPTIMOS

PREGUNTA: ¿Se Podría Mejorar la Estimación MCO?

La incorporación al proceso de estimación de algún tipo de INFORMACIÓN

EXTRÍNSECA e INSESGADA sobre los parámetros del modelo podría

permitir una mayor precisión de los βˆMCO (varianza más pequeña).

3

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

Un Ejemplo:

MODELO NO-LINEAL

MODELO BASADO EN LA

FUNCIÓN DE PRODUCCIÓN

COBB-DOUGLAS

Yi = γ ·K iα ·Lβi ·U i

en donde

Y

K

∀i = 1,..., n

LINEALIZABLE

es el output

es el factor productivo capital

L es el factor productivo trabajo

γ , α y β Son los parámetros del modelo

U es la perturbación

¿CÓMO?

Considerando un Modelo

Doble-Log

4

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

Un Ejemplo:

MODELO NO-LINEAL

α

β

Yi = γ ·K i ·Li ·U i

LINEALIZABLE

ln(Yi ) = ln γ + α ·ln( K i ) + β ·ln( Li ) + ln(U i )

MCO

γˆ0

α̂

β̂

¿CÓMO SE INTERPRETAN

LOS COEFICIENTES

ESTIMADOS?

ELASTICIDADES

5

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

Un Ejemplo:

Vamos a suponer que disponemos de INFORMACIÓN EXTRÍNSECA E

INSESGADA que confirma la HIPÓTESIS DE RENDIMIENTOS

CONSTANTES A ESCALA

H0 :α + β = 1

β = 1−α

Incorporando la Información en el Modelo obtenemos

ln(Yi ) = ln γ + α ·ln( K i ) + β ·ln( Li ) + ln(U i )

α + β =1

Yi

Ki

ln = ln γ + α ·ln + ln(U i )

Li

Li

∀i = 1,..., n

6

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

Un Ejemplo:

Y

K

ln i = ln γ + α ·ln i + ln(U i )

Li

Li

¿QUÉ OBSERVAMOS?

Hay un Menor Número de Parámetros a Estimar

2

Las Variables del Modelo Restringido son Diferentes

Variable

Independiente

Modelo que resulta de

aplicar la restricción

β = 1−α

1

Variable

Dependiente

MODELO

RESTRINGIDO

Yi

ln

Li

Ki

ln

Li

Output por Trabajador

Capital por Unidad de Trabajo

7

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

Un Ejemplo:

PREGUNTA: ¿La Estimación MCO en el Modelo Restringido será MÁS

PRECISA que en el Modelo General?

¿ Var (αˆ MCO

Modelo Re stringido

RESPUESTA:

SÍ

¿Por qué?

Modelo General

) < Var (αˆ MCO

)?

Dado

el

mismo

número

de

observaciones n, en el modelo

restringido hay que estimar un menor

número de parámetros.

8

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

Un Ejemplo:

Yi

Ki

ln = ln γ + α ·ln + ln(U i )

Li

Li

Y1

ln

L1

Y

ln 2

L2

*

Y = .

.

.

ln Yn

L

n

K1

1 ln

L

1

K2

1 ln

L2

X* = .

.

.

.

.

.

K

1 ln n

L

n

MÍNIMOS CUADRADOS RESTRINGIDOS

(

βˆ * = βˆMCR = X *' · X *

)

−1

· X *' ·Y *

¿QUÉ VENTAJAS SE OBTIENE DE MCR?

Si la Hipótesis es cierta ….

βˆ * = βˆMCR es un estimador Lineal

Insesgado, Consistente, Óptimo y con

una menor varianza que β̂ MCO aplicado

al modelo sin restricciones.

9

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

Un Ejemplo:

PREGUNTA

1

¿CÓMO SABER SI LA HIPÓTESIS DE RENDIMIENTOS

CONSTANTES A ESCALA ES CIERTA? ¿α + β = 1?

Especificar el Contraste

H0 :α + β = 1

2

Definir el Estadístico

d

αˆ + βˆ − 1

αˆ + βˆ − 1

→ t n − K −1

t=

=

ˆ

ˆ

ˆ

Var (αˆ + β )

Var (αˆ ) + Var ( β ) − 2·Cov(αˆ , β )

3

Regla de Decisión

Si t < t n − K −1

Aceptamos H 0 : α + β = 1

10

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

Un Ejemplo:

PROCEDIMIENTO SEGUIDO EN LA ESTIMACIÓN MCR

1

Incorporar la Restricción en el Modelo General

α + β =1

2

ln(Yi ) = ln γ + α ·ln( K i ) + β ·ln( Li ) + ln(U i )

Especificar el Modelo Transformado o Restringido

Y

K

ln i = ln γ + α ·ln i + ln(U i )

Li

Li

3

Calcular los MCO del Modelo Restringido

(

βˆ * = βˆMCR = X *' · X *

)

−1

· X *' ·Y *

11

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

Un Ejemplo:

PROBLEMAS DE

SEGUIR ESTE

PROCEDIMIENTO

1

Existen complicaciones si el

número de restricciones es

mayor que 1

2

Puede suceder que el modelo

restringido sea complejo

SOLUCIÓN

Definir los Estimadores MCR de

forma general

12

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

MÍNIMOS CUADRADOS RESTRINGIDOS

De forma general vamos a suponer que existe q restricciones lineales de los

parámetros:

R·β = r

o

R·β − r = 0

en donde

R(qx ( K +1)) Matriz de Coeficientes Constantes (no estocásticos)

β ( K +1)x1 Vector con los Parámetros del Modelo

rqX 1

Vector con Valores Correspondientes a la Hipótesis Nula

13

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

MÍNIMOS CUADRADOS RESTRINGIDOS

Ejemplos de la Notación Matricial

1

H 0 : β1 = 1

R·β = r

Tenemos 1 Restricción

(q = 1)

R[1x ( K +1) ]·β [( K +1) x1] = r1x1

β0

β

1

.

[0 1 0 . . . 0]· = 1

.

.

β K

14

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

MÍNIMOS CUADRADOS RESTRINGIDOS

Ejemplos de la Notación Matricial

2

H 0 : β1 + β 2 = 0

R·β = r

Tenemos 1 Restricción

(q = 1)

R[1x ( K +1) ]·β [( K +1) x1] = r1x1

β0

β

1

.

[0 1 1 . . . 0]· = 1

.

.

β K

15

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

MÍNIMOS CUADRADOS RESTRINGIDOS

Ejemplos de la Notación Matricial

3

R·β = r

H 0 : β 0 + β1 = 3 y H 0 : β 2 − β 3 + β K = 0

R[2 x ( K +1) ]·β [( K +1) x1] = r2 x1

Tenemos 2 Restricción

β0

β

1

β2

1 1 0 0 0 . . . 0 β 3 3

0 0 1 − 1 0 . . . 1· . = 0

.

.

β K

(q = 2)

16

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

MÍNIMOS CUADRADOS RESTRINGIDOS

Ejemplos de la Notación Matricial

4

H 0 : β1 = β 2 = ... = β K = 0

R·β = r

Tenemos K Restricción

(q = K )

R[Kx ( K +1) ]·β [( K +1) x1] = rKx1

0

0

0

.

.

.

0

1 0 0 . . .

0 1 0 . . .

0 0 1 . . .

. . . . . .

. . . . . .

. . . . . .

0 0 0 . . .

β0

0 0

β1

0 0

β2

0 0

β3

=.

. ·

.

. .

.

. .

.

0

1

β K

17

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

MÍNIMOS CUADRADOS RESTRINGIDOS

Contrastar el Cumplimiento de las Restricciones

H 0 : R· β = r

(

R·βˆ − r )'·[R·Vˆar (βˆ )·R '] ·(R ⋅ βˆ − r )

F=

→F

−1

d

q , n − K −1

q

(Ver

demostración)

Otras formas equivalentes

(e ·e

*'

F=

*

− e'·e

q

e'·e

n − K −1

)

(βˆ

o

F=

*

)

(

− βˆ '·X '·X · βˆ * − βˆ

q

e'·e

n − K −1

)

*

*

e

y

β

donde

son los residuos y los coeficientes estimados de la regresión

18

restringida.

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

MÍNIMOS CUADRADOS RESTRINGIDOS

Contrastar el Cumplimiento de las Restricciones

REGLA DE DECISIÓN

· Si

F > Fq ,n − K −1,α

· Si F ≤ Fq ,n − K −1,α

Se Rechaza la Hipótesis Nula

H 0 : R· β = r

Se Acepta la Hipótesis Nula

H 0 : R· β = r

NO MCR

SÍ MCR

19

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.1) Introducción a los Modelos con Restricciones.

MÍNIMOS CUADRADOS RESTRINGIDOS

¿Cómo Calcular los EMCR?

ˆ )'·(Y − X ·βˆ )

(

β

min

SCE

=

e

'·

e

=

Y

−

X

·

ˆ

{β }

S .a. : R·βˆ = r

(

(Ver

demostración)

)

βˆR = βˆMCO + ( X '·X )−1 ·R'· R·( X '·X )−1 ·R' ·(r − R·βˆMCO )

−1

20

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.2) Contrastes de Selección de Modelos.

3.2.1) El Contraste de Razón de Verosimilitud

Sea:

· ϑ un Vector de Parámetros a Estimar.

·

H 0 la Hipótesis Nula en la que se indica alguna restricción: H 0 : R·θ = θ 0

ϑ̂u el Estimador de Máxima Verosimilitud sin tener en cuenta la restricción

· ϑ̂R el Estimador de Máxima Verosimilitud teniendo en cuenta la restricción

·

( )

( ) las funciones de verosimilitud evaluadas en

· Lˆu ϑ̂u y Lˆ R ϑ̂R

respectivamente:

Lˆu = max L(Y , ϑ )

{ϑ∈Θ}

Lˆ R = max L(Y , ϑ )

{ϑ∈W }

ϑ̂u

y

ϑ̂R

en donde Θ es el espacio de parámetros y

es un subconjunto de ese espacio:

ϑR ∈ w ⊂ Θ

ϑu ∈ Θ

21

W

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.2) Contrastes de Selección de Modelos.

3.2.1) El Contraste de Razón de Verosimilitud

Definición: La Razón de Verosimilitud

Lˆ R

λ=

Lˆu

λ ∈ [0,1]

Idea: Si λ

toma un valor muy

bajo entonces dudaremos de la

validez de la restricción (¿por

qué?).

ESTADÍSTICO DEL CONTRASTE RAZÓN DE VEROSIMILITUD:

d

RV = −2·log(λ ) = 2·[log( Lˆu ) − log( Lˆ R )]→ χ q2

donde q es el

número

de

restricciones.

Regla de Decisión:

Si

RV > χ q2,α

Se Rechaza la Hipótesis Nula de

Validez de las Restricciones.

22

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.2) Contrastes de Selección de Modelos.

3.2.2) El Contraste de Wald

Sea:

·

ϑ̂u el Vector de Parámetros Estimados obtenido sin tener en cuenta las

restricciones.

· La Hipótesis Nula en la que se indica alguna restricción:

H 0 : R·θ = ϑ0

ESTADÍSTICO DE WALD:

[

W = [R·ϑˆu − ϑ0 ] · R·Vˆar (ϑˆu )·R

'

Regla de Decisión:

Si W >

χ q2,α

d

] ·[R·ϑˆ − ϑ ]→ χ

' −1

0

2

q

Se Rechaza la Hipótesis Nula de

Validez de las Restricciones.

23

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.2) Contrastes de Selección de Modelos.

3.2.2) El Contraste de Wald

Ejemplo: El Contraste de Wald con una Restricción

H 0 : θ = θ0

H1 : θ ≠ θ 0

'

−1

W = [θˆ − ϑ0 − 0] ·[Var (θˆ)] ·[θˆ − ϑ0 − 0]

(

θˆ − ϑ )

W=

2

0

Var (ϑˆ )

Regla de Decisión:

Si W >

χ12,α

d

→ χ12

Se Rechaza la Hipótesis Nula de

Validez de las Restricciones.

24

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.2) Contrastes de Selección de Modelos.

3.2.3) El Contraste del Multiplicador de Lagrange

FUNCIÓN DE

MÁXIMA

VEROSIMILITUD

Lu (ϑ ) = max L(Y , ϑ )

{ϑ }

ϑ ∈Θ

C.P.O:

S (ϑ ) =

∂ log(Lu (Y ,ϑ ) )

=0

∂ϑ

SCORES DEL

MODELO

[(K + 1)x1]

ϑˆu S (ϑˆu ) = 0

25

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.2) Contrastes de Selección de Modelos.

3.2.3) El Contraste del Multiplicador de Lagrange

Supongamos ahora el Modelo Restringido considerando la Hipótesis Nula

H 0 : R·θ = ϑ0

Si esta Hipótesis es cierta, entonces …

∂ log(Lu (Y , ϑˆR ) )

ˆ

S (ϑR ) =

≈0

∂ϑ

Si la Hipótesis Nula es Cierta,

entonces la expresión del SCORE del

Modelo No Restringido evaluado en el

punto ϑ̂ debe ser próximo a cero.

R

26

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.2) Contrastes de Selección de Modelos.

3.2.3) El Contraste del Multiplicador de Lagrange

ESTADÍSTICO DEL CONTRASTE DEL MULTIPLICADOR DE LAGRANGE:

ˆR ) ) d 2

∂ log(Lu (Y ,ϑˆR ) )

−1 ∂ log (Lu (Y , ϑ

L=

·[Var (ϑˆR )] ·

→ χq

'

'

∂ϑ

∂ϑ

'

Regla de Decisión:

Si L >

χ q2,α

Se Rechaza la Hipótesis Nula de

Validez de las Restricciones.

Las Restricciones impuestas no son

Válidas: H 0 : R·θ = ϑ0

27

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.2) Contrastes de Selección de Modelos.

3.2.4) Contraste de Nulidad Conjunta de un Subconjunto de Parámetros

MODELO DE REGRESIÓN LINEAL MÚLTIPLE

Yi = β 0 + β1 · X 1i + β 2 · X 2i + ... + β h · X hi + β h +1 · X h +1i + β h + 2 · X h + 2i + ... + β k · X ki + U i

El Contraste a Realizar será:

H 0 : β h +1 = β h + 2 = ... = β K = 0

H1 : A lg uno ≠ 0

28

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.2) Contrastes de Selección de Modelos.

3.2.4) Contraste de Nulidad Conjunta de un Subconjunto de Parámetros

El Estadístico a emplear será:

SCE R − SCEu

d

K

−

h

F=

→ FK −h ,n − K −1

SCEu

n − K −1

en donde:

SCE R

es la Suma de los Cuadrados de los Errores del Modelo Restringido. Es

decir, es la SCE obtenida al regresar Y X 0 , X 1 ,..., X h

SCEu es la Suma de los Cuadrados de los Errores del Modelo Sin Restringir.

Es decir, es la SCE obtenida al regresar Y X 0 , X 1 ,..., X h , X h +1 , X h + 2 ,..., X K

29

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.2) Contrastes de Selección de Modelos.

3.2.4) Contraste de Nulidad Conjunta de un Subconjunto de Parámetros

La Regla de Decisión será:

· Si

F ≤ FK − h ,, n − K −1,α

Se Acepta la Hipótesis Nula de Validez de las

Restricciones.

· Si

F > FK − h ,, n − K −1,α

Se Rechaza la Hipótesis Nula de Validez de las

Restricciones.

Región

Aceptación

α

(1 − α )

FK +1, n − K −1,α

30

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.3) El Contraste de Chow de Cambio Estructural

Permanencia o Constancia Estructural

100

90

Yi = βˆ0 + βˆ1 · X 1i + ei

80

70

60

50

40

30

20

10

0

10

15

20

25

30

35

40

45

50

31

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.3) El Contraste de Chow de Cambio Estructural

Cambio Estructural

90

Yi = βˆ0 + βˆ1· X 1i + ei

80

70

Yi A = αˆ 0 + αˆ1 · X 1i + ei

Yi = βˆ0 + βˆ1 · X 1i + ei

60

50

40

30

Yi B = δˆ0 + δˆ1 · X 1i + ei

20

10

20

25

30

35

40

45

50

55

60

65

32

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.3) El Contraste de Chow de Cambio Estructural

EL CONTRASTE DE CHOW: PROCEDIMIENTO

PRIMER PASO

Realizar la Partición de la Muestra en 2 Submuestras

-. La que tiene las N A Primeras Observaciones de la Muestra

-. La que tiene las N B Últimas Observaciones de la Muestra

N A + NB = N

33

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.3) El Contraste de Chow de Cambio Estructural

EL CONTRASTE DE CHOW: PROCEDIMIENTO

SEGUNDO PASO

Especificar el Contraste de Hipótesis

H 0 : β A = β B = β

H1 : β A ≠ β B

¿ Y = X A ·β A + ε ≡ Y = X B ·β B + ε ?

-. Aceptar la Hipótesis Nula es Indicativo de Permanencia Estructural de los

Parámetros

-. Rechazar la Hipótesis Nula es Indicativo de Cambio Estructural. Los

Parámetros del Modelo no pueden considerarse constantes.

34

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.3) El Contraste de Chow de Cambio Estructural

EL CONTRASTE DE CHOW: PROCEDIMIENTO

TERCER PASO

Determinar el Estadístico

[e'·e − (e ·e

)]

'

A

'

+

e

A

B ·eB

d

K

+

1

F=

→ F( K +1),( N A + N B −2·( K +1))

'

'

e A ·e A + eB ·eB

(N A + N B − 2·(K + 1))

(

)

35

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.3) El Contraste de Chow de Cambio Estructural

EL CONTRASTE DE CHOW: PROCEDIMIENTO

CUARTO PASO

Regla de Decisión

-. Si

F ≥ F( K +1),( N A + N B − 2·( K +1)),α

Rechazar H 0

EXISTE UNA DIFERENCIA SIGNIFICATIVA ENTRE ESTIMAR

LAS REGRESIONES SEPARADAS O LA REGRESIÓN

CONJUNTA

-. Si

F < F( K +1),( N A + N B − 2·( K +1)),α

Aceptar H 0

36

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.3) El Contraste de Chow de Cambio Estructural

EL CONTRASTE DE CHOW: CUESTIONES Y LIMITACIONES

1

Es necesario determinar previamente el Punto de Corte N A . Es

un elemento fundamental ya que el contraste es muy sensible a N A

2

La situación deseable es que N A determine 2 submuestras de

tamaño aproximadamente equivalente a la mitad del tamaño

muestral. Si N A está próximo a alguno de los extremos de la

muestra es aconsejable emplear

[e'·e − e ·e ]

[e'·e − e ·e ]

'

A

d

NB

F=

→

FN B , N A − K −1

eA' ·e A

(N A − 2·(K + 1))

(

3

'

B

A

)

o

B

d

NA

F=

→ FN A , N B − K −1

eB' ·eB

(N B − 2·(K + 1))

(

)

El Test de Chow se puede emplear tanto con datos temporales37

como con datos de corte transversal.

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.4) El Contraste Reset de Ramsey

MODELO DE

REGRESIÓN LINEAL

MÚLTIPLE

Yi = β 0 + β1 · X 1i + ... + β K · X Ki + U i

FORMA FUNCIONAL LINEAL

¿Qué Sucede si la

Forma Funcional No

es la Correcta?

ESTIMADORES

SESGADOS Y POCO

PRECISOS

¿Cómo verificar que

el Modelo está Bien

Especificado?

TEST DE RAMSEY

38

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.4) El Contraste Reset de Ramsey

¿ESTÁ EL MODELO DE REGRESIÓN CORRECTAMENTE

ESPECIFICADO?

PRIMER PASO

Estimar el Siguiente Modelo

p

Yi = β 0 + β1 · X 1i + ... + β K · X Ki + ∑ γ j ·Yˆi j + U i

j =2

p

en donde

j

ˆ

γ

·

Y

∑ j i es la suma del ajuste obtenido Ŷi

elevado a distintas

j =2

potencias (generalmente p=2).

39

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.4) El Contraste Reset de Ramsey

¿ESTÁ EL MODELO DE REGRESIÓN CORRECTAMENTE

ESPECIFICADO?

SEGUNDO PASO

Especificar el Contraste de Hipótesis

¿POR QUÉ ESTE

CONTRASTE?

Si algún

γj

H 0 : γ 2 = ... = γ p = 0

H1 : a lg uno es ≠ 0

es significativo, entonces la especificación inicial es Incorrecta

Yi = β 0 + β1 · X 1i + ... + β K · X Ki + U i

MAL

ESPECIFICADO

40

TEMA 3: Procedimientos de Contrastación y

Selección de Modelos

3.4) El Contraste Reset de Ramsey

¿ESTÁ EL MODELO DE REGRESIÓN CORRECTAMENTE

ESPECIFICADO?

TERCER PASO

Determinar el Estadístico y la Regla de Decisión

1

El Estadístico F para contrastar la nulidad de un conjunto de parámetros.

Si

2

F ≥ F( P −1),(n − K + p − 2 ),α

El Modelo está MAL ESPECIFICADO.

El Estadístico t si se introduce sólo el cuadrado del ajuste (p=2).

Si

t ≥ t n − K + p − 2,α

El Modelo está MAL ESPECIFICADO.

41