econofisica

Anuncio

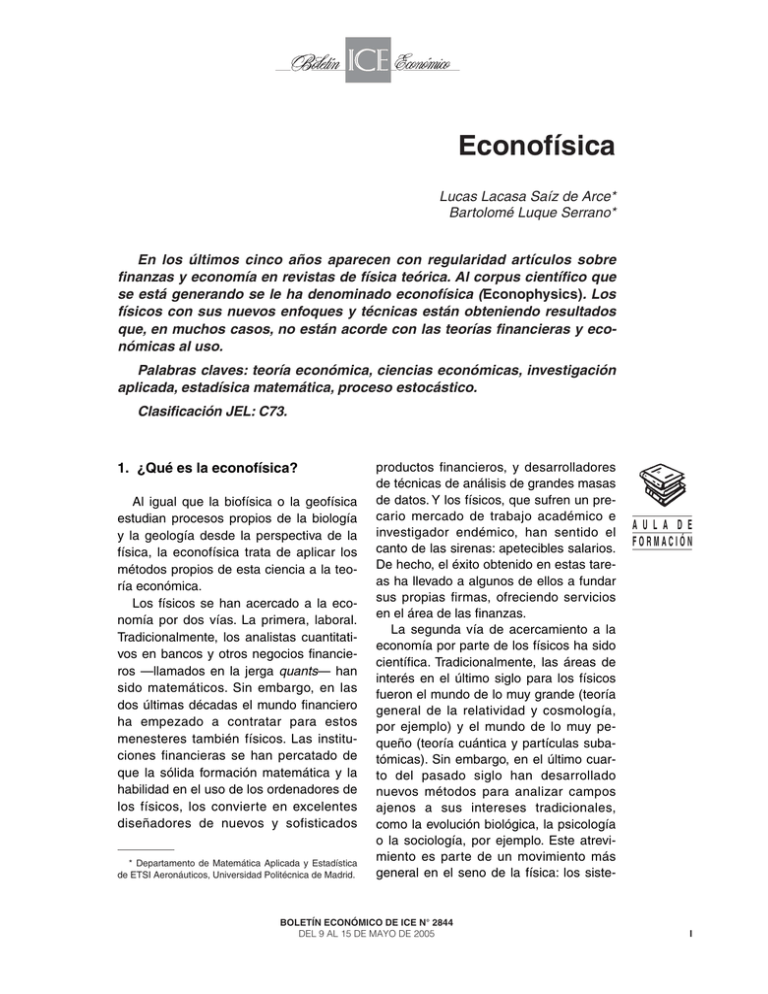

Econofísica Lucas Lacasa Saíz de Arce* Bartolomé Luque Serrano* En los últimos cinco años aparecen con regularidad artículos sobre finanzas y economía en revistas de física teórica. Al corpus científico que se está generando se le ha denominado econofísica (Econophysics). Los físicos con sus nuevos enfoques y técnicas están obteniendo resultados que, en muchos casos, no están acorde con las teorías financieras y económicas al uso. Palabras claves: teoría económica, ciencias económicas, investigación aplicada, estadísica matemática, proceso estocástico. Clasificación JEL: C73. 1. ¿Qué es la econofísica? Al igual que la biofísica o la geofísica estudian procesos propios de la biología y la geología desde la perspectiva de la física, la econofísica trata de aplicar los métodos propios de esta ciencia a la teoría económica. Los físicos se han acercado a la economía por dos vías. La primera, laboral. Tradicionalmente, los analistas cuantitativos en bancos y otros negocios financieros —llamados en la jerga quants— han sido matemáticos. Sin embargo, en las dos últimas décadas el mundo financiero ha empezado a contratar para estos menesteres también físicos. Las instituciones financieras se han percatado de que la sólida formación matemática y la habilidad en el uso de los ordenadores de los físicos, los convierte en excelentes diseñadores de nuevos y sofisticados * Departamento de Matemática Aplicada y Estadística de ETSI Aeronáuticos, Universidad Politécnica de Madrid. productos financieros, y desarrolladores de técnicas de análisis de grandes masas de datos. Y los físicos, que sufren un precario mercado de trabajo académico e investigador endémico, han sentido el canto de las sirenas: apetecibles salarios. De hecho, el éxito obtenido en estas tareas ha llevado a algunos de ellos a fundar sus propias firmas, ofreciendo servicios en el área de las finanzas. La segunda vía de acercamiento a la economía por parte de los físicos ha sido científica. Tradicionalmente, las áreas de interés en el último siglo para los físicos fueron el mundo de lo muy grande (teoría general de la relatividad y cosmología, por ejemplo) y el mundo de lo muy pequeño (teoría cuántica y partículas subatómicas). Sin embargo, en el último cuarto del pasado siglo han desarrollado nuevos métodos para analizar campos ajenos a sus intereses tradicionales, como la evolución biológica, la psicología o la sociología, por ejemplo. Este atrevimiento es parte de un movimiento más general en el seno de la física: los siste- BOLETÍN ECONÓMICO DE ICE N° 2844 DEL 9 AL 15 DE MAYO DE 2005 AU L A D E FORMACIÓN I LUCAS LACASA SAÍZ DE ARCE Y BARTOLOME LUQUE SERRANO AU L A D E FORMACIÓN II mas complejos. Era, por tanto, solo cuestión de tiempo que sus intereses alcanzaran de forma contundente a la economía. La economía y las finanzas están fuertemente matematizadas desde hace más de un siglo, con herramientas que van desde el movimiento browniano (caminatas al azar) hasta la teoría de juegos (donde se usan conceptos como equilibrio de Nash). En finanzas, por ejemplo, se ha asumido que las fluctuaciones de precios siguen una distribución normal y que los mercados funcionan de forma eficiente. A partir de ahí se ha desarrollado una extensa teoría. ¿Cómo está contribuyendo la física a la economía? Los econofísicos están mostrando fehacientemente que muchas observaciones están en desacuerdo con estas hipótesis de trabajo. Por ejemplo, a corto término las fluctuaciones son no normales, el incremento de precios está correlacionado: los signos del incremento de precios están descorrelacionados de acuerdo con la hipótesis de mercado eficiente, sin embargo, la magnitud de las fluctuaciones de precios muestran correlaciones temporales de largo alcance (Ver Caja 1: Regularidades estadísticas empíricas en precios y vuelos de Levy truncados). Una de las tesis fundamentales en la que se ha basado el estudio técnico de la economía en los últimos cien años es la llamada HME (Hipótesis de Mercado Eficiente), siendo a la vez la suposición más adoptada y menos creída. Asume, básicamente, que toda la información susceptible de ser conocida por el sistema (por ejemplo, los datos referentes a la Bolsa), está en cada paso de tiempo incorporada a los precios. Exige que el sistema, (recordemos que nuestro sistema es un enorme conjunto de individuos comprando y vendiendo acciones) sea una computadora perfecta, que integra en cada paso de tiempo toda la información rele- vante. Parece un tanto pretencioso y a todas luces nada realista. ¿Son o no aleatorios los precios de los mercados? Es decir, en otras palabras mucho más directas y jugosas: ¿existe forma segura de ganar en Bolsa? Las acciones se sobrevalúan los primeros días de enero, suelen caer con frecuencia las primeras horas de los lunes... Son hechos empíricos, bien conocidos, en contra de la aleatoriedad. ¿Podemos predecir más y con rigor? La HME (Hipótesis de mercado eficiente) asigna como probabilidad a un crash como el de octubre de 1987, una entre 1035 posibilidades: es decir, para la teoría clásica, semejante ocurrencia es imposible. Más aún, una pérdida en un día del 5 por 100 en el Dow Jones (hecho que sucede alrededor de cada dos años), debería tener una frecuencia de una cada miles de años, según HME. La teoría clásica hace aguas... La econofísica se está encargando de dar un amparo teórico a un sentimiento ampliamente extendido: la HME es completamente falsa. Y está transformando nuestro entendimiento de la económía con nuevos enfoques (Ver Caja 2: Caos y criticalidad auto-organizada). En el mundo real las estrategias usadas por los agentes manifiestan correlaciones (herd effect) que son obviadas por las teorías al uso. ¿Cómo es posible dar contenido matemático a situaciones de pánico bursátil? Los econofísicos son capaces de modelizar sistemas con muchos componentes. En contraposición con las teorías neoclásicas de equilibrio, tan caras al razonamiento neoliberal, la econofísica propone una descripción del comportamiento adaptativo de los agentes económicos frente a situaciones cambiantes. Tal enfoque es ahora posible debido a la creciente capacidad de simulación de los ordenadores y a los métodos matemáticos desarrollados en el área BOLETÍN ECONÓMICO DE ICE N° 2844 DEL 9 AL 15 DE MAYO DE 2005 ECONOFÍSICA de los sistemas complejos, que han demostrado éxitos notables en la comprensión del comportamiento de sistemas con un gran número de componentes que evolucionan e interaccionan fuertemente entre sí. El gran economista J. M. Keynes comparó la actuación de los agentes en los mercados con los participantes de un concurso que intentan adivinar a la mujer que será elegida como la más bella. La elegida finalmente no tiene por qué ser precisamente la más hermosa, sino aquella que la mayoría piensa que los demás van a elegir como la más hermosa. Pensando en esta forma de meta-actuación de los agentes, Brian Arthur creó uno de los modelos más celebrados en econofísica: El Farol, nombre tomado de un concurrido bar en Santa Fe, Nuevo Mexico. Allí todos los jueves por la noche se toca música irlandesa. Los aficionados a este tipo de música deben tomar cada semana la decisión de asistir o no a escuchar su música preferida. Lamentablemente el bar es pequeño y si los asistentes superan las sesenta personas, el ambiente se hace agobiante. Cada uno de los clientes debe tratar de inferir qué debe hacer esta semana, asistir o no, en función de sus experiencias anteriores. ¿Qué estrategia deben seguir los clientes? Brian Arthur elaboró un modelo computacional que simulaba la situación: los clientes o agentes debían decidir o no asistir al bar, a partir de un conocimiento limitado, una memoria de las asistencias anteriores y de unas estrategias de decisión. Si un cliente predecía que más de sesenta personas visitarían el bar, evitaría ir. Si predecía que la asistencia sería menor de sesenta personas, entonces decidiría asistir. Observemos que la decisión de asistir o no al bar es de carácter individual y la consecuencia de la asistencia de todos los clientes es de carác- ter colectivo. Eso puede generar situaciones paradójicas: si muchos clientes predicen «correctamente» que el bar estará poco concurrido ese jueves, entonces su decisión «acertada» los hace fracasar, porque asistirán más de 60. De manera similar, si la mayoría de clientes predicen de manera «acertada» que el bar estará lleno y deciden quedarse en casa, entonces habrán tomado una decisión «equivocada». Brian Arthur con este «modelo de juguete» abrió un nuevo camino para estudiar e iluminar esta dialéctica entre el individuo y el colectivo, esta dinámica compleja entre las partes y el todo que aparecen en muchos sistemas económicos y sociales. Las herramientas empleadas por los físicos para analizar sistemas complejos permiten ahora abordar la problemática de los agentes, ausente prácticamente en la economía clásica (Ver Caja 3: Juegos de minoría). Por supuesto, la econofísica tiene sus detractores. Argumentan fundamentalmente que no es posible extraer conclusiones válidas de experimentos físicos en condiciones controladas de laboratorio para casos empíricos reales de la economía. Estos últimos son resultado de acontecimientos ocurridos en los mercados que difícilmente vuelvan a repetirse con toda exactitud. En otras palabras: que no pueden hacerse experimentos en los mercados financieros como no pueden hacerse experimentos de la historia. Pero como han señalado R. N. Mantenga y H. E. Stanley, dos fundadores de la econofísica, esa característica es compartida por varios campos de la física como son la cosmología, la astrofísica o la climatología, por ejemplo, sin mayores problemas. La actividad de los físicos en economía ha dejado de ser episódica y una comunidad científica con características propias ha comenzado a emerger. Usan BOLETÍN ECONÓMICO DE ICE N° 2844 DEL 9 AL 15 DE MAYO DE 2005 AU L A D E FORMACIÓN III LUCAS LACASA SAÍZ DE ARCE Y BARTOLOME LUQUE SERRANO FIGURA 1 DISTRIBUCIÓN EMPÍRICA Y TEÓRICA IPC 1999 Nota: Distribución empírica (líneas y círculos) y teórica (líneas) de las diferencias de precio en el índice IPC durante en año 1999 en escala semilogaritmica. Si las variaciones de precios siguieran una caminata aleatoria, la curva teórica, que corresponde a una distribución gaussiana, y la empírica debían coincidir. Nótese que las colas de la distribución empírica son mucho más gruesas que las de la distribución teórica clásica. Fuente: Cortesía de Ricardo Mansilla, UNAM. AU L A D E FORMACIÓN la geometría fractal, la teoría de procesos estocásticos, los fenómenos críticos y, de modo general, la física de los sistemas complejos. El tiempo dirá si esos nuevos enfoques son una moda pasajera o un profundo cambio de perspectiva en la forma de entender la economía. 2. Caja 1: Regularidades estadísticas empíricas en precios y vuelos de Levy truncados Una de las propiedades básicas del mercado es la fluctuación de precios. Existe un encendido debate sobre la forma funcional de la distribución de precios. Inicialmente se pensaba que la distribución acumulada de log-returns convergía a una distribución normal para intervalos temporales grandes. Sin embargo, las medidas reales muestran claramente la existencia IV de fat tails en las distribuciones (probabilidades para valores extremos mayores que las esperadas para una normal). En la Figura 1 podemos ver el desajuste entre la teoría clásica y los datos empíricos. En la gráfica se muestra la distribución empírica y la distribución teórica de las variaciones de precios del IPC durante todo el año 1999 en escala semilogarítmica. Para la construcción de la misma se utilizaron datos intra-día (todas las anotaciones registradas en el mercado a lo largo del día. Durante el año 1999 se tuvieron para el IPC 1.103.483 registros). Si admitimos que las diferencias de precios siguen una ley normal, entonces: Tomando logaritmos a ambos miembros de esta ecuación, se tiene: BOLETÍN ECONÓMICO DE ICE N° 2844 DEL 9 AL 15 DE MAYO DE 2005 ECONOFÍSICA De modo que en escala semilogarítmica deberíamos ver la gaussiana como una parábola. Como puede observarse en la imagen la diferencia entre esa «parábola gaussiana» que asume la teoría clásica y los datos de mercados no se ajustan en absoluto. Desde luego estas diferencias eran conocidas desde hace mucho tiempo. En los años 60, B. Mandelbrot y E. Fama sugirieron que la distribución ajustaba a una distribución estable de Levy como generalización del teorema del límite central. Pero posteriormente se encontraron más complicaciones. Si bien la distribución se acerca a una normal para intervalos grandes, el valor absoluto de los log-returns (tomado a veces como definición de volatilidad) decae como una ley de potencias para valores altos. Y esto es incompatible con una distribución de Levy. Ha habido que esperar hasta 1994, para que dos econofísicos, R.Mantenga y E.Stanley, dieran con el marco adecuado para describir esta fenomenología. Usando «vuelos de Levy truncados» (VLT) describieron con éxito notable el comportamiento pseudo-gaussiano de la distribución de precios. Este trabajo, y posteriores, permiten estimar cuantitativamente la probabilidad de que una determinada diferencia de precios (o la fluctuación de un precio), ocurra de forma más exacta que la teoría clásica. 3. Caja 2: Caos y criticalidad auto-organizada Otra área donde la econofísica está obteniendo nuevos resultados es en el análisis de datos. Los econofísicos están utilizando nuevas herramientas, como las que provienen de la ya madura teoría del caos determinista. Toda la maquinaria desarrollada para analizar trayectorias caóticas en los últimos 30 años se está aplicando al inmenso torrente de datos que nos ofrece cada día el sector económico. En teoría del caos se estudian sistemas no lineales que presentan sensibilidad extrema a las condiciones iniciales. Un sistema se dice caótico, si dos condiciones iniciales infinitamente próximas, evolucionan al cabo de poco tiempo de modo muy diferente. La Bolsa es un sistema altamente no lineal, si su dinámica es caótica significaría que es impredecible. Existen, sin embargo, sistemas en la naturaleza que presentan lo que los físicos llaman caos débil. Son sistemas donde la predicción es posible aunque sólo a corto término. Si la Bolsa se comportara de esta manera la posibilidad de predicción sería posible. Muchos fenómenos naturales exhiben caos débil, entre ellos los sistemas críticos auto-organizados. Pongamos un ejemplo de juguete: un reloj de arena. En él, los granos al caer van formando un pequeño montón de arena con cierta pendiente. A medida que van cayendo los granos se producen pequeñas avalanchas de arena de muy diversos tamaños, de tal modo que la pendiente permanece constante, se auto-regula. El sistema está siendo perturbado y se «auto-organiza» disipando arena mediante avalanchas para mantener la pendiente. La distribución de los tamaños de las avalanchas sigue una ley de potencias que los físicos relacionan con fenómenos críticos como son las transiciones de fase (el paso de un sólido a líquido, por ejemplo). Ese tipo de distribuciones se han encontrado en multitud de fenómenos naturales y cuando los físicos se topan con ellas sospechan que se hayan frente a un sistema crítico. Los econofísicos han descubierto que, BOLETÍN ECONÓMICO DE ICE N° 2844 DEL 9 AL 15 DE MAYO DE 2005 AU L A D E FORMACIÓN V LUCAS LACASA SAÍZ DE ARCE Y BARTOLOME LUQUE SERRANO AU L A D E FORMACIÓN por ejemplo, las fluctuaciones de las tasas de crecimiento de los tamaños de compañías decaen siguiendo leyes de potencias. Y han observado leyes semejantes en la distribución de salarios, el número de empleos, etcétera. En concreto, la distribución del PIB por países sigue una la ley de potencias, un resultado inexplicable a partir de las teorías económicas estándar, que encaja perfectamente en las explicaciones alternativas que ofrece la econofísica. La pregunta que nos llevó a esta Caja era: ¿Es predecible o no la Bolsa? Al hilo de lo expuesto, los econofísicos A. Johansen y D. Sornette, conectaron la fenomenología dispar de los crashes bursátiles y la teoría de predicción de terremotos. Según muchos físicos los terremotos son un ejemplo de fenómeno crítico autoorganizado. Johansen y Sornette utilizaron las herramientas matemáticas que habían utilizado previamente a la predicción de terremotos, para explicar el comportamiento de los índices financieros antes de los crashes. Como resultado tienen en su haber una sorprendente predicción de la fecha en la que ocurrió el crash del NASDAQ del 14 de abril de 2000. 4. Caja 3: Juegos de minoría Para explicar el comportamiento de los precios necesitamos entender el comportamiento de los agentes de los que depende. Está claro, que los agentes económicos no se comportan de forma totalmente racional y que, sin duda, esto juega un papel crucial en los precios. Pero, ¿cómo podemos ir más allá de esta afirmación? Se han propuesto modelos complicados como el SFI. A pesar de que exhibe características propias del mercado como la clusterización de la volatilidad y fat tails, es difícil de analizar por la com- VI plicación intrínseca de las simulaciones numéricas. De filosofía opuesta, por su extrema sencillez, tenemos El Farol, el punto de partida de toda una serie de modelos de agentes. Entre ellos los más conocidos son los llamados «juegos de minoría» (Minority Games), propuestos inicialmente en 1997 por Damián Challet y Yi-Cheng Zhang. Básicamente, un juego de minoría es un modelo donde un grupo de agentes toma decisiones sucesivas teniendo en cuenta los éxitos y fracasos de sus decisiones pasadas. Para ser más precisos, consideremos un número impar N de agentes que toman decisiones sucesivamente dentro de un conjunto de dos posibles, que llamaremos 0 ó 1; comprar o vender; ir o no ir al bar, etc. Como en el juego de los chinos, estas decisiones se toman de manera simultánea por cada uno de los agentes participantes. Una vez que todos han hecho pública su decisión, ganarán aquellos que estén en el grupo de la minoría (de ahí el nombre del modelo). Se llama decisión ganadora en una iteración o repetición del juego a aquella que tomaron los agentes en minoría. Por ejemplo, supongamos que N = 11, y que en una de las iteraciones, 9 de ellos deciden comprar y 2 vender. Ganan entonces los vendedores. ¿Qué tiene que ver esto con los mercados? Los agentes económicos consiguen ventajas si se encuentran en minoría. Si muchos agentes quieren comprar y muy pocos quieren vender (acciones bursátiles o cualquier producto que se nos ocurra) entonces los precios subirán como consecuencia de la diferencia entre la oferta y la demanda, favoreciendo a los que están en la minoría, que son los vendedores. De manera similar, si hay muy pocos compradores y muchos vendedores, entonces los precios se irán a la baja como consecuencia de la desproporción BOLETÍN ECONÓMICO DE ICE N° 2844 DEL 9 AL 15 DE MAYO DE 2005 ECONOFÍSICA entre la oferta y la demanda, para beneficio en este caso de los compradores que son la minoría. La única información pública de que disponen los agentes en estos modelos es la lista de las decisiones ganadoras en los instantes de tiempo anteriores. Como sólo son posibles dos acciones, entonces el histórico del sistema es simplemente una cadena de ceros y unos, tan larga como iteraciones del sistema se haya producido. Supongamos que los tres últimos dígitos del histórico fueron: 0, 1, 0. De izquierda a derecha representan la sucesión de las decisiones ganadoras en las tres últimas jugadas. Para ser más precisos, hace tres iteraciones quedaron en minoría los que eligieron 0, hace dos los que eligieron 1 y en la última jugada los que eligieron 0. ¿Cómo usan los agentes la información que provee esta cadena binaria de decisiones exitosas anteriores? En primer lugar, como tienen racionalidad limitada, memoria no infinita, sólo recuerdan los últimos valores de la serie binaria, digamos, los últimos tres valores, como en nuestro ejemplo. A partir de esos valores anteriores los agentes deben inducir cuál es su actuación correcta en la próxima ronda del juego. Para ello hacen uso de estrategias. Una estrategia es un procedimiento que reconoce la situación actual y sugiere, a partir de ésta, una actuación. En particular, si la memoria de nuestros agentes es de tres pasos de tiempo, debe ser capaz de decidir para 23 = 8 posibles historias. Así, una estrategia puede representarse como muestra la Tabla 1. Dicha Tabla nos dice por ejemplo, que si las últimas tres decisiones ganadoras hubieran sido 0 0 1, la columna señalada como histórico (2), entonces esta estrategia le aconsejaría al agente elegir 1 en la próxima ronda del juego (el dígito con fondo gris). TABLA 1 REPRESENTACIÓN DE UNA ESTRATEGIA 0 1 1 1 0 1 0 0 0 0 0 0 0 1 0 1 0 0 1 1 1 0 0 1 0 1 1 1 0 1 1 1 (1) (2) (3) (4) (5) (6) (7) (8) Fuente:Elaboración propia. Al inicio de una simulación, cada agente recibe s estrategias como la descrita más arriba. Existen varias maneras distintas de asignarlas, usarlas o hacerlas evolucionar. Y cada una de ellas ha generado alguna variante de los juegos de minoría. ¿Cómo juegan los agentes en este universo-mercado simulado en el ordenador? Dada una historia, un conjunto de ceros y unos, cada uno de los agentes toma una decisión a partir de una de sus estrategias. Se decide cuál es el grupo que quedó en la minoría, los que están en 0 o los que escogieron 1. Con el símbolo correspondiente a la decisión se actualiza el histórico, poniendo como dígito binario más reciente la última decisión ganadora y eliminando el más antiguo. Y se vuelve a comenzar. Lo que obtenemos es una sucesión de ceros y unos, el resultado colectivo de decisiones individuales, del que los econofísicos extraen conclusiones muy interesantes. Por ejemplo, es sorprendente que, a pesar de la sencillez de estos modelos, exhiben una transición entre eficiencia (predicción imposible del mercado) e ineficiencia en función de la capacidad estratégica (memoria) de los agentes. La sobresimplificación extrema de este modelo y sus variantes los aleja mucho de la realidad. Es el precio a pagar por resolverlos y entender en profundidad su funcionamiento. Semejante estrategia de abordaje en sistemas complejos y mecánica estadística ha sido enormemente fructífera bajo técnicas de renormalización e hipótesis de universalidad, y los econofísicos esperan que reporte resulta- BOLETÍN ECONÓMICO DE ICE N° 2844 DEL 9 AL 15 DE MAYO DE 2005 AU L A D E FORMACIÓN VII LUCAS LACASA SAÍZ DE ARCE Y BARTOLOME LUQUE SERRANO dos semejantes en economía. Minority Game es uno de los primeros pasos firmes para abordar situaciones más realistas donde las decisiones de los agentes afectan a los precios y los precios a las decisiones. A priori estos modelos pueden parecer juegos de salón, pero lo cierto es que son los primeros intentos de introducir comportamientos individuales en la teoría económica, que en muchos casos no son racionales y tan solo disponen de una información incompleta. Estos modelos han sido capaces ya de aportar las primeras explicaciones con marco matemático de fenómenos colectivos bien conocidos en la Bolsa como son el efecto manada o el pánico generalizado; fenó- menos inabordables con las herramientas clásicas. Bibliografía 1. MANSILLA, Ricardo (2003): Introducción a la Econofísica, Ed. Equipo Sirius. 2. BOUCHAUD, J. P. y POTTERS, M. (2000): Theory of Financial Risk: From Statistical Physics to Risk Management, Univ. Press, Cambridge, Reino Unido. 3. MANTENGA, R.N. y STANLEY, H.E. (1999): Introduction to Econophysics: Correlations and Complexity in Finance, Cambridge Univ. Press, Cambridge, Reino Unido. 4. http://www.unifr.ch/econophysics/ Foro de discusión, opinión y artículos que intenta aglomerar a la comunidad econofísica. AU L A D E FORMACIÓN VIII BOLETÍN ECONÓMICO DE ICE N° 2844 DEL 9 AL 15 DE MAYO DE 2005