Toma de Decisiones Por Brooks Carder y Patrick Ragan

Anuncio

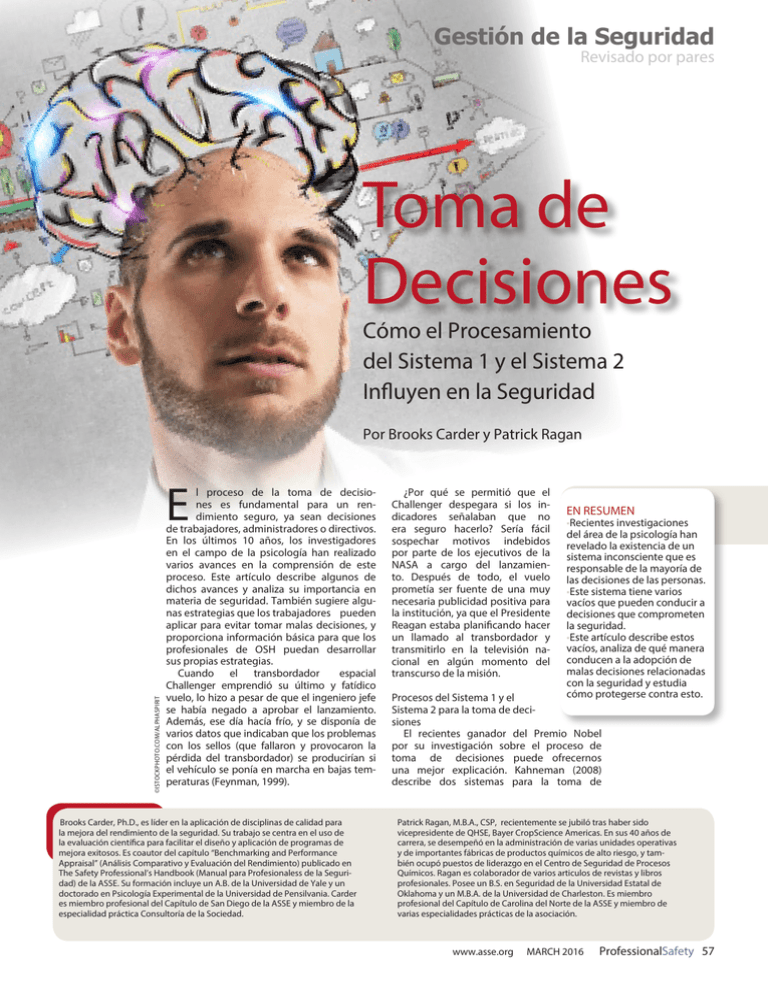

Gestión de la Seguridad Revisado por pares Toma de Decisiones Cómo el Procesamiento del Sistema 1 y el Sistema 2 Influyen en la Seguridad Por Brooks Carder y Patrick Ragan ©ISTOCKPHOTO.COM/ALPHASPIRIT E l proceso de la toma de decisiones es fundamental para un rendimiento seguro, ya sean decisiones de trabajadores, administradores o directivos. En los últimos 10 años, los investigadores en el campo de la psicología han realizado varios avances en la comprensión de este proceso. Este artículo describe algunos de dichos avances y analiza su importancia en materia de seguridad. También sugiere algunas estrategias que los trabajadores pueden aplicar para evitar tomar malas decisiones, y proporciona información básica para que los profesionales de OSH puedan desarrollar sus propias estrategias. Cuando el transbordador espacial Challenger emprendió su último y fatídico vuelo, lo hizo a pesar de que el ingeniero jefe se había negado a aprobar el lanzamiento. Además, ese día hacía frío, y se disponía de varios datos que indicaban que los problemas con los sellos (que fallaron y provocaron la pérdida del transbordador) se producirían si el vehículo se ponía en marcha en bajas temperaturas (Feynman, 1999). Brooks Carder, Ph.D., es líder en la aplicación de disciplinas de calidad para la mejora del rendimiento de la seguridad. Su trabajo se centra en el uso de la evaluación científica para facilitar el diseño y aplicación de programas de mejora exitosos. Es coautor del capítulo “Benchmarking and Performance Appraisal” (Análisis Comparativo y Evaluación del Rendimiento) publicado en The Safety Professional’s Handbook (Manual para Profesionaless de la Seguridad) de la ASSE. Su formación incluye un A.B. de la Universidad de Yale y un doctorado en Psicología Experimental de la Universidad de Pensilvania. Carder es miembro profesional del Capítulo de San Diego de la ASSE y miembro de la especialidad práctica Consultoría de la Sociedad. ¿Por qué se permitió que el Challenger despegara si los indicadores señalaban que no era seguro hacerlo? Sería fácil sospechar motivos indebidos por parte de los ejecutivos de la NASA a cargo del lanzamiento. Después de todo, el vuelo prometía ser fuente de una muy necesaria publicidad positiva para la institución, ya que el Presidente Reagan estaba planificando hacer un llamado al transbordador y transmitirlo en la televisión nacional en algún momento del transcurso de la misión. EN RESUMEN •Recientes investigaciones del área de la psicología han revelado la existencia de un sistema inconsciente que es responsable de la mayoría de las decisiones de las personas. •Este sistema tiene varios vacíos que pueden conducir a decisiones que comprometen la seguridad. •Este artículo describe estos vacíos, analiza de qué manera conducen a la adopción de malas decisiones relacionadas con la seguridad y estudia cómo protegerse contra esto. Procesos del Sistema 1 y el Sistema 2 para la toma de decisiones El recientes ganador del Premio Nobel por su investigación sobre el proceso de toma de decisiones puede ofrecernos una mejor explicación. Kahneman (2008) describe dos sistemas para la toma de Patrick Ragan, M.B.A., CSP, recientemente se jubiló tras haber sido vicepresidente de QHSE, Bayer CropScience Americas. En sus 40 años de carrera, se desempeñó en la administración de varias unidades operativas y de importantes fábricas de productos químicos de alto riesgo, y también ocupó puestos de liderazgo en el Centro de Seguridad de Procesos Químicos. Ragan es colaborador de varios articulos de revistas y libros profesionales. Posee un B.S. en Seguridad de la Universidad Estatal de Oklahoma y un M.B.A. de la Universidad de Charleston. Es miembro profesional del Capítulo de Carolina del Norte de la ASSE y miembro de varias especialidades prácticas de la asociación. www.asse.org MARCH 2016 ProfessionalSafety 57 decisiones. El Sistema 2 es el proceso consciente con el que la mayoría está familiarizado. Es racional y responde a la información nueva, y debido a que es deliberativo, es un proceso relativamente lento. Las operaciones del Sistema 2 requieren atención. Kahneman (2008) enumera varias actividades que serían manejadas por el proceso del Sistema 2: •Centrar la atención en los payasos de un circo. •Buscar una mujer con el cabello blanco. •Mantener una velocidad de caminata más rápida a lo que se está acostumbrado. También se encarga de tareas complejas. Por ejemplo: •Comparar el valor total de dos lavadoras. •Comprobar la validez de un argumento lógico complejo. El Sistema 1 es un proceso inconsciente que los seres humanos utilizan para tomar la mayoría de las decisiones, aunque no estén conscientes de su procesamiento. Algunos ejemplos de actividades gestionadas por el Sistema 1 son: •Orientarse hacia la fuente de un ruido repentino. •Responder cuál es el resultado de 2 + 2. •Conducir un coche en una carretera vacía. •Comprender frases sencillas. •Reconocer que “un alma dócil y prolija, con pasión por los detalles” se asemeja a un estereotipo laboral. El Sistema 1 puede realizar algunos cálculos complejos. Por ejemplo en el béisbol, cuando un jardinero central experimentado se aproxima rápidamente al lugar en que aterrizará la bola de un batazo de aire, está haciendo un cálculo que tomaría un tiempo considerable si se realiza con el Sistema 2. La mayoría de las personas no son conscientes de la complejidad de esta decisión y probablemente no podrían realizar ese cálculo. En su lugar, una persona simplemente va a donde la bola va a caer. Además de sus amplias capacidades, el Sistema 1 contiene vacíos que suelen llevar a la adopción de malas decisiones. Según Kahneman (2008), estos vacíos incluyen: 1) El descuido de la ambigüedad y represión de la duda. 2) El sesgo de confirmación, que es la tendencia a ignorar la evidencia que entra en conflicto con la hipótesis que uno tenía inicialmente. 3) La coherencia emocional exagerada (efecto halo). Esta es la tendencia a no creer nada de lo que dice, por ejemplo, una figura de confianza (que es la razón por la que las celebridades son utilizadas en la publicidad). 4) La creencia de que la evidencia que uno ve es todo lo que hay. 5) El exceso de confianza. 6) Vincular el sentido de facilidad congnitiva con las ilusiones de la realidad, los sentimientos agradables y un estado de atención menor. 7) Distinguir entre lo sorpresivo y lo normal. 8) Inferir e inventar causas e intenciones. Así como la toma de decisiones del Sistema 1 puede haber sido responsable del lanzamiento del Challenger, también podría haber sido responsable de imputar motivos indebidos a los ejecutivos que decidieron dar luz verde al lanzamiento. 9) Sustituir a veces una pregunta más fácil por una difícil. 10) Aversión a la pérdida. Si se le pide a una persona que elija entre dos apuestas, cuando una de ellas tiene mayores expectativas de rentabilidad, pero a la vez una pequeña posibilidad de una pérdida mayor en comparación con la otra, la mayoría de las personas evitará la pérdida y elegirá aquella opción con una expectativa de rentabilidad menor. 58 ProfessionalSafety MARCH 2016 www.asse.org 11) Preferencia por el status quo. Efecto potencial sobre la seguridad Varios de estos vacíos pueden respaldar decisiones que van en contra de la seguridad. Por ejemplo, los números 1 (descuido de la ambigüedad), 2 (sesgo de confirmación) y 5 (exceso de confianza) pueden conducir a la adopción de un curso de acción sin una revisión suficiente. El número 4 (creencia de que la evidencia que uno ve es todo lo que hay) podría llevar a que la persona no busque más información, por asumir que las pruebas disponibles son todo lo que hay. El antídoto para una toma de decisiones seguras es invocar el Sistema 2. Todo proceso reflexivo invoca el Sistema 2. Por ejemplo, dicho proceso dará lugar a preguntas tales como: ¿Con qué otros métodos alternativos se puede realizar esta tarea? ¿Cuál alternativa es la más segura? ¿Tiene toda la información correspondiente sobre cómo hacer esto? ¿Qué tipo de información podría estar faltando?¿Cuál es la razón para decidir hacerlo de esta manera? ¿Se trata de un caso de “siempre lo hemos hecho de esta manera, así que vamos a continuar con el status quo”? Vacíos del Sistema 1: Un ejemplo bien conocido Según las características y vacíos del Sistema 1, es razonable la hipótesis que dice que el Sistema 1 fue el origen de la decisión de lanzar el Challenger. Un vacío de la toma de decisiones del Sistema 1 es el exceso de confianza. Sin duda, los ejecutivos de la NASA fueron demasiado confiados. Feynman (1999) sostiene que estas personas estimaron la probabilidad de que ocurriese una falla catastrófica en el orden de 1 en 1.000 misiones. Feynman y los ingenieros de vuelo consideraron esta probabilidad en el orden de 1 en 100. Se demostró que esta última estimación era correcta, con dos fallas catastróficas en menos de 200 vuelos. El segundo vacío es “lo que se ve es todo lo que hay”. Las personas tienden a pensar que las pruebas de la cuales son conscientes son toda la evidencia que hay. Quizás los ejecutivos de la NASA no estaban al tanto de los datos sobre las fallas de los sellos. Ciertamente estaban conscientes del hecho de que no se había producido ninguna falla catastrófica hasta el momento. Otro vacío importante es la preferencia por el status quo, que en este caso sería proceder con el lanzamiento. Muchas personas en la misma posición que los ejecutivos de la NASA probablemente habrían tomado la misma decisión, apoyándose en el Sistema 1. Por último, el vacío de aversión a la pérdida habría favorecido claramente la decisión de continuar con el lanzamiento. Aunque esta explicación de los vacíos del Sistema 1 podría absolver a los ejecutivos de tener motivos impropios, no les exime de la responsabilidad de tomar una mala decisión. No se tiene que llevar una vida basada en los comandos del Sistema 1. Los buenos ejecutivos deben ser capaces de tomar decisiones importantes en el modo del Sistema 2. La toma de decisiones determina en gran medida el control del rendimiento de la seguridad, ya sea la decisión de un operador de primera línea de ignorar un procedimiento, la decisión de un gerente sobre cómo motivar a los empleados a seguir los procedimientos, o la decisión de un directivo sobre cómo llevar a cabo las capacitaciones de los nuevos gerentes. Durante los últimos 21 años, los autores han utilizado encuestas sobre actitudes y creencias para facilitar la toma de decisiones y para determinar las áreas que necesitan mejoras (Carder y Ragan, 2012). Este proceso ha demostrado ser un método eficaz para mejorar el rendimiento de la seguridad. La aplicación de los últimos avances en psicología ha generado nuevas herramientas para comprender la toma de decisiones y tener influencia en ella, lo que eventualmente mejora el rendimiento de la seguridad. Una mejor toma de decisiones en la seguridad Como una persona responsable de la toma de decisiones que guardan relación con la seguridad, el profesional de OSH debe entender cómo funcionan estos sistemas, cómo protegerse contra sus inconvenientes y cómo maximizar sus oportunidades. Cada día las personas viven en el modo del Sistema 2, pero no pueden experimentar directamente el proceso del Sistema 1. Sin embargo, pueden estar conscientes de las conclusiones a las que llegan a través de su intuición y actuar en consecuencia. La existencia del Sistema 1 se deduce a partir de un gran número de experimentos realizados por Kahneman y muchos otros investigadores. Veamos el “problema de Linda” de Kahneman (2008). En esta situación, se le dijo a un sujeto: “Linda tiene 31 años, es soltera, franca y muy brillante. Cuando aún era estudiante, le interesaban muchísimo los asuntos relacionados con la discriminación y la justicia social, y también participaba en manifestaciones antinucleares”. Luego, se le preguntó: ¿Qué es más probable? Linda trabaja en un banco. O Linda es empleada bancaria y activista del movimiento feminista”. Kahneman (2008) señala que un 85% de los estudiantes de Princeton y un 33% de los estudiantes de posgrado en ciencias sociales tuvieron la segunda alternativa de respuesta. Y esa es la respuesta incorrecta. Hay muchas más personas que trabajan en un banco que personas que son empleados bancarios y además activistas del movimiento feminista, así que la primera respuesta es lo más probable. La respuesta incorrecta proviene del proceso intuitivo del Sistema 1. Es común que el Sistema 2 deje pasar ese tipo de respuestas sin recurrir a más evidencias. Veamos otro ejemplo de un problema que suele responderse con el Sistema 1 (Frederick, 2005). Tenemos un estanque con nenúfares. El número de estas plantas se duplica cada día. En 48 días, cubrirán todo el estanque. ¿En cuánto tiempo cubrirán la mitad del estanque? Sin pensar mucho, es lógico que si en 48 días cubren todo el estanque, en la mitad de ese tiempo (24 días) cubrirán la mitad. Esta es una respuesta del Sistema 1. No obstante, esta respuesta ignora el hecho de que los nenúfares están aumentando geométricamente. Si su número se duplica para cubrir todo el estanque en el día 48, deben haber cubierto la mitad del estanque en el día 47. Por lo tanto, la respuesta correcta es 47 días. El pensamiento del Sistema 1 saca conclusiones apresuradas y puede ignorar hechos importantes, como la tasa de crecimiento geométrico. Este escenario se incluyó en dos preguntas similares de la investigación de Frederick (2005).La puntuación fue diferente en cada universidad. Un cuarenta y ocho por ciento de los estudiantes del MIT tuvo las tres respuestas correctas. En una universidad de élite, el 64% de los estudiantes tuvo las tres mal. Según Frederick (2005), incluso aquellos que resolvieron el problema sostuvieron que la respuesta de los 24 días fue lo primero que se les vino a la mente. Para un ejemplo particularmente dramático del Sistema 1 en el trabajo, se mostró a las personas pares de imágenes por tan sólo 200 milisegundos (Ballew y Todorov, 2007). Se les pidió que decidieran cuál de los hombres de las fotografías era más competente. Sin que los sujetos supieran, las fotos eran de candidatos rivales en las elecciones gubernatoriales. Las respuestas de la persona más competente representan el 64% de los ganadores de las elecciones. Según Ballew y Todorov (2007), esto sugiere que muchos votantes recurren únicamente al Sistema 1 Tabla 1 Consecuencias de los vacíos del Sistema 1 para la seguridad para analizar el rostro de un candidato y así tomar una decisión sobre por quién votar. ¿Qué tan probable es encontrar una sola persona que admita que votó por un candidato basándose en la apariencia de su rostro? La Tabla 1 enumera varios vacíos del Sistema 1 y algunas de las posibles consecuencias para el rendimiento de la seguridad. Además de sus amplias capacidades, el Sistema 1 contiene vacíos que suelen llevar a la adopción de malas decisiones. Consecuencias del Sistema 1 para la seguridad Es razonable suponer que todo empleado que realice una tarea relativamente rutinaria esté funcionando principalmente bajo el Sistema 1, sin importar cuán peligrosa pueda ser la tarea cuando comete un error. Muchos vacíos del Sistema 1 apoyan la hipótesis de que todo está bien incluso cuando existen pruebas que sugieren lo contrario. De hecho, se esperaría que las personas involucradas experimenten el sentido de facilidad cognitiva, sentimientos agradables y un estado de atención menor. Existe un enfoque general para abordar tales cuestiones y consiste en invocar la forma de pensar del Sistema 2 para revisar las conclusiones ofrecidas por el Sistema 1. Esto podría incluir preguntas tales como: “¿Cuáles serían otras formas de hacer estas tareas? ¿Estas serían más seguras o más peligrosas?” Las respuestas no son tan importantes como la aplicación del patrón de pensamiento del Sistema 2 en estas cuestiones, tal como lo exige el subterfugio de los vacíos del Sistema 1. Soll, Milkman y Payne (2015) postulan una novedosa propuesta para no caer en los vacíos del Sistema 1, en especial aquella del exceso de confianza: el análisis premortem. Cuando se planifica un proyecto, los participantes asumen que ocurrió un incidente. El primer paso, decidir cuál fue el incidente, es el paso inicial para evitar el vacío. Todos los involucrados deben evaluar los riesgos. El siguiente paso es determinar por qué ocurrió el incidente; esto proporciona una visión más profunda de los riesgos que el exceso de confianza no llega a tocar. Soll, et al. (2015) también analizan el vacío de aversión a la pérdida, que puede causar la continuación de un www.asse.org MARCH 2016 ProfessionalSafety 59 tal proceso seguiría las técnicas de cambio de actitud (Festinger y Carlsmith, 1959). Las ideas de Kahneman (2008) se aplican asimismo a la investigación de incidentes. Por ejemplo, estas ideas ayudan a explicar el porqué las personas actuaron de una manera determinada y el porqué lo hicieron así durante un incidente. ¿Se esperaba que actuaran con la deliberación del Sistema 2 cuando el tiempo necesario para realizar la tarea se limitaba a una escala del Sistema 1? La comprensión de los vacíos del proceso de pensamiento del Sistema 1 también ofrece respuestas respecto a por qué los informes de los testigos presenciales del mismo incidente pueden diferir tanto. Los vacíos del Sistema 1, como el descuido de la ambigüedad y la deducción e invención, pueden provocar que los testigos llenen los vacíos de la historia; este proceso los ayuda a que un evento que no tenía sentido pase a tenerlo. Sin embargo, no son conscientes de que su mente está involucrada en este proceso. Por tanto, todo investigador de incidentes debe reconocer que estos vacíos pueden entrar en juego durante las entrevistas. Al comprender y reconocer los dos sistemas de la toma de decisiones en el trabajo, los profesionales de OSH pueden evaluar los riesgos de manera más eficaz, investigar incidentes y desarrollar planes estratégicos. curso de acción peligroso para evitar perder el tiempo y el esfuerzo que ya se han dedicado a algo. Muchos de los principales incidentes han ocurrido porque se prosiguió con una tarea a pesar de que habían pruebas de que el proceso no estaba siguiendo el camino correcto. Soll, et al. (2015) utilizan como ejemplo el alpinismo. Muchos escaladores han muerto tratando de llegar a la cima del Monte Everest, cuando las condiciones del tiempo cambiaron desfavorablemente o cuando era demasiado tarde. Su solución es un “cable de tracción”: un plazo concreto para llegar a un determinado punto. Si bien no hay una analogía sencilla para esto en una operación de producción, debiese haber una amplia discusión de cómo un proceso podría salirse del camino y qué hacer al respecto. Los vacíos del Sistema 1 son, al menos, un gran problema tanto para la suite ejecutiva como para la fábrica, ya que las malas decisiones que toman los ejecutivos a menudo tienen un efecto mucho más amplio. Las decisiones en torno al lanzamiento del Challenger son un ejemplo perfecto. Bailey y Petersen (1989) sostienen que las encuestas de percepción son la mejor manera de evaluar el rendimiento de un sistema de seguridad en comparación con los recuentos de incidentes. Carder y Ragan (2012) llegan a una conclusión similar basándose en sus 20 años de experiencia y en un número considerable de investigaciones sobre la medición de la eficacia de un sistema de seguridad. Las encuestas son superiores a los recuentos de incidentes. A Petersen (2000) le desconcierta el porqué es tan difícil lograr que los ejecutivos comprendan esto. Los vacíos del Sistema 1 pueden tener una explicación. Primero, a través de los recuentos de incidentes se mantiene el statu quo. Segundo, el vacío de “lo que ves es todo lo que hay” sugiere que muchos ejecutivos no solicitarán información sobre este tema y asumirán que la evidencia que tienen es todo lo que hay. La ilusión de de la realidad conduce a sentimientos agradables y a un sentido de facilidad cognitiva. Una manera de abordar esto sería pedir a estos ejecutivos que elaboren un argumento de por qué las encuestas son superiores a los recuentos de incidentes. Este ejercicio les exigiría considerar nuevas pruebas. Y también 60 ProfessionalSafety MARCH 2016 www.asse.org Conclusión Existen otros hallazgos de Kahneman (2008) que vale la pena profundizar. Los profesionales de OSH pueden utilizar los últimos avances en el campo de la psicología para que sea más probable que la toma de decisiones para la seguridad sea apropiada, lo cual en última instancia conducirá a un menor número de incidentes. Al comprender y reconocer los dos sistemas de la toma de decisiones en el trabajo, los profesionales de OSH pueden evaluar los riesgos de manera más eficaz, investigar incidentes y desarrollar planes estratégicos. PS Referencias Bailey, C. y Petersen, D. (Feb. de 1989). Using perception surveys to assess safety program effectiveness. Professional Safety, 34(2), 22-26. Ballew, C.C. y Todorov, A. (2007). Predicting political elections from rapid and unreflective face judgments. Proceedings of the National Academy of Sciences, 104(46), 17948-17953. Carder, B. y Ragan, P. (2012). Benchmarking and performance appraisal criteria. In J. Haight (Ed.), The safety professionals handbook (pp. 249-277). Des Plaines, IL: ASSE. Festinger, L. y Carlsmith, J.M. (1959). Cognitive consequences of forced compliance. Journal of Abnormal and Social Psychology, 58, 203-210. Feynman, R.P. (1999). The pleasure of finding things out. Nueva York, NY: Basic Books. Frederick, S. (2005). Cognitive reflection and decision making. Journal of Economic Perspectives, 19(4) 25-42. Kahneman, D. (2008). Thinking fast and slow. New York, NY: Farrar, Straus y Giroux. Petersen, D. (2000, Jan.). Safety management 2000: Our strengths and weaknesses. Professional Safety, 45(1), 16-19. Soll, J.B., Milkman, K.L. y Payne, J.B. (2015, May). Outsmart your own biases. Harvard Business Review. Retrieved from https://hbr.org/2015/05/outsmart-your -own-biases