Notas de clase 4 PCA(parte B)

Anuncio

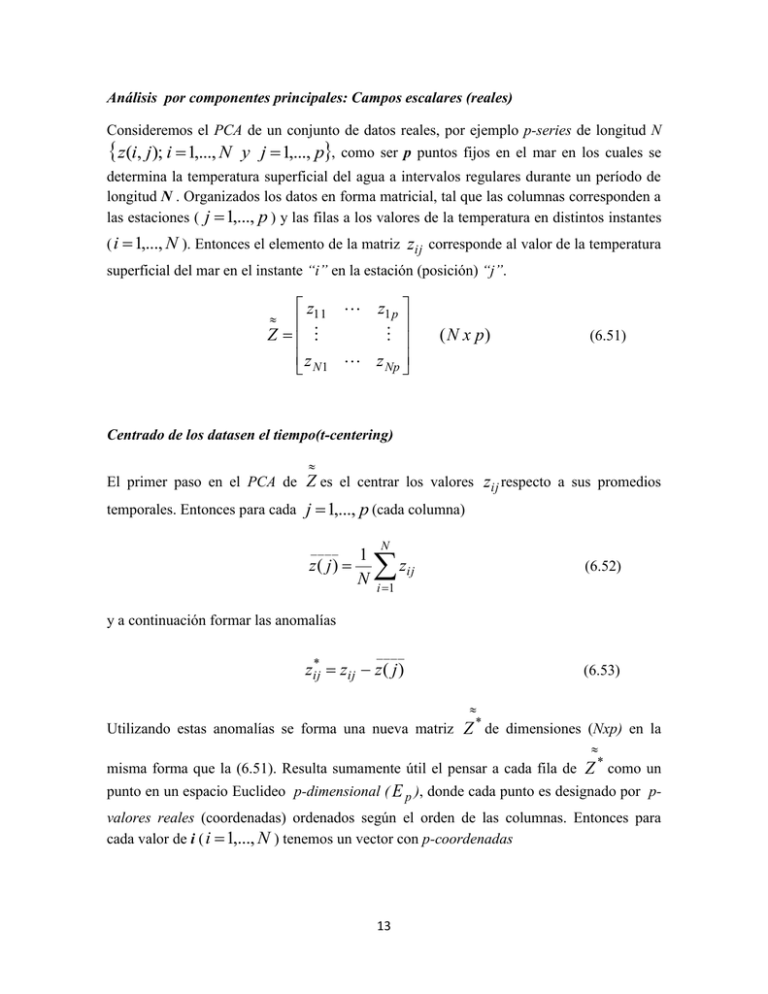

Análisis por componentes principales: Campos escalares (reales) Consideremos el PCA de un conjunto de datos reales, por ejemplo p-series de longitud N z(i, j); i 1,..., N y j 1,..., p, como ser p puntos fijos en el mar en los cuales se determina la temperatura superficial del agua a intervalos regulares durante un período de longitud N . Organizados los datos en forma matricial, tal que las columnas corresponden a las estaciones ( j 1,..., p ) y las filas a los valores de la temperatura en distintos instantes ( i 1,..., N ). Entonces el elemento de la matriz zij corresponde al valor de la temperatura superficial del mar en el instante “i” en la estación (posición) “j”. z11 z1 p Z z N 1 z Np ( N x p) (6.51) Centrado de los datasen el tiempo(t-centering) El primer paso en el PCA de Z es el centrar los valores zij respecto a sus promedios temporales. Entonces para cada j 1,..., p (cada columna) ____ 1 z( j) N N z (6.52) ij i 1 y a continuación formar las anomalías zij* ____ zij z ( j ) (6.53) * Utilizando estas anomalías se forma una nueva matriz Z de dimensiones (Nxp) en la * misma forma que la (6.51). Resulta sumamente útil el pensar a cada fila de Z como un punto en un espacio Euclideo p-dimensional ( E p ), donde cada punto es designado por pvalores reales (coordenadas) ordenados según el orden de las columnas. Entonces para cada valor de i ( i 1,..., N ) tenemos un vector con p-coordenadas 13 zi* * T ( zi*1 , zi*2 ,, zip ) (px1) (6.54) Entonces T * * * * Z z1 z 2 ... z N (Nxp) (6.55) * El conjunto de datos Z se representa en E p como una constelación de N puntos. La dispersión de la muestra y la matriz de dispersión * Consideraremos ahora la dispersión de los datos Z como un conjunto de N puntos en E p , a lo largo de eje con la dirección un vector unitario e (e1 ,...., e p )T que pasa por el * centro de la nube de puntos z Med ___ ___ ___ * * * T ( z1 , z2 ,..., z p ) . La proyección de z i* sobre e es T * T * zi e e zi p z * ij e j j 1 T donde e e 1 . Definimos la dispersión e de Z * a lo largo de e como 2 T zi* e e i 1 N T T * * e zi zi e i 1 N 14 T N T e e zi* zi* e i 1 (6.56) Podemos pensar e como una dispersión (o varianza) muestral: para cada elección de * e tendremos en E p una dispersión de Z a lo largo de e . Por analogía con S dada por la * (6.46) definimos la matriz de dispersión de Z de dimensiones (pxp): S N T z i* z i* i 1 T * * Z Z (6.57) Si sij es el elemento de S en su i-ésima fila y j-éima columna, entonces de la (6.57) tendremos que N sij z i, j 1,..., p * * T ij ( zij ) (6.58) i 1 * Podemos ahora escribir la dispersión muestral de Z a lo largo de e , es decir e , dada por (6.56), como T e e S e 0 (6.59) Observe el lector que de (6.57) o (6.58), se deduce que S es simétrica, es decir S ( S )T (6.60) A partir de la propiedad de simetría (6.60) se obtiene una relación muy interesante. Si a y b son dos vectores de dimensiones (px1), entonces 15 ( a )T S b ( b )T S a (6.61) Las auto estructuras del PCA Consideremos ahora el siguiente problema que consiste en encontrar las direcciones e en E p para las cuales ( e ) tiene valores extremos (máximos o mínimos). Este problema nos introducirá en ciertos conceptos centrales del álgebra de las PCA, que denominarmos las autoestructuras de la matriz de dispersión S . Si e es una dirección donde ( e ) tiene un valor extremo, entonces para cualquier pequeña perturbación e de la dirección de e , tendríamos, a primer orden en e : ( e e) ( e ) (6.62) Ahora ( e e) ( e e) S ( e e) T ( e ) S ( e ) 2 (e) S ( e ) (e) S (e) T T T donde hemos hecho uso de la (6.61). A primer orden en e , tenemos que (e)T S (e) =0. Entonces ( e e) ( e )T S ( e ) 2 (e)T S ( e ) Para satisfacer la (6.62) se debe cumplir que (e) S ( e ) 0 T (6.63) Sin embargo no podemos utilizar cualquier perturbación tales que e e satisfagan la condición de ortonormalidad 16 e de e , únicamente aquellas ( e e)T ( e e) ( e e) ( e e)T 1 (6.64) condición que a primer orden en e requiere que: (e)T e 0 (6.65) Entonces las perturbaciones e son ortogonales a e , es decir sólo cambian la dirección de e . Note el lector que por convención, las componentes de e son adimensionales. Entonces si l es cualquier número real con las dimensiones de los elementos de S , podemos combinar la (6.63) y la (6.65) de forma tal que podemos escribir una identidad, a primer orden en e , de la forma (e)T S ( e ) l (e)T ( e ) 0 (6.66) tal que (e) S ( e ) l ( e ) 0 T (6.67) Si e 0 la (6.70) se cumple si y sólo si S (e) l (e) (6.68) Esta es la ecuación que gobierna las direcciones de e , de dispersión extrema. Las soluciones no triviales (es decir e 0 ) de este conjunto de p ecuaciones lineales para las componentes de e [e(1),...,e( p)]T ocurren sólo para valores especiales de l. En la teoría del álgebra lineal se demuestra que para matrices simétricas tales como Matrices y Álgebra Lineal, S (ver Notas de Sección 2.13) generalmente tiene p autovectores E p e j [e j1, e j 2 ,, e jp ]T (soluciones de (6.68) ) y p valores reales no negativos asociados lj que se denominan autovalores, tal que 17 S ej l j ej j 1, , p (6.69) En forma matricial, si hacemos E [e1,, e p ] l1 0 L 0 (6.70) ( pxp) 0 0 0 l2 0 0 diag[l1 ,, l p ] 0 l p ( pxp) (6.71) donde por construcción l1 l2 l p 0 Entonces la generaliz ación correspondiente a la (6.699 será S E EL (6.72) El ordenamiento de los autovalores lj en forma decreciente es sólo a los efectos de identificar el correspondiente e j cuando los lj son distintos. El número de autovalores no * * nulos ( l 0 ) es igual al rango de la matriz Z . El rango de Z en (6.55) es el número de filas o columnas linealmente independientes en dicha matriz, lo que es equivalente a decir ' j * que es el orden de la submatriz cuadrada más grande al Particionar Z , cuyo determinante no se anula (ver Notas: Matrices y Álgebra Lineal, sección 2.8). En general el rango de la * matriz Z es el menor valor entre la longitud de las series y el número de series * ( rank( Z ) min[N 1, p]) . En la práctica N-1 p y ya veremos más adelante como calcular los autovalores, en el caso en que el número de series es muy superior a la longitud de las mismas. Los autovectores e j y e j pertenecientes a distintos autovalores l j y lk 18 de S en (6.69) son ortogonales. Consideremos la ecuación (6.69) para e j y e j y multiplicamos las mismas en el primer caso por ( e ) k y en el otro por ( e ) j (ek )T ( S e j ) (ek )T (l j e j ) (e j ) ( S ek ) (e j ) (lk ek ) T T De estas relaciones y teniendo en cuenta (6.61) obtenemos que (e j )T ek (l j lk ) 0 (6.73) Si l j l k entonces (e j ) ek 0 . Si l j lk , es posible en la práctica, encontrar valores T de e j y e j que satisfacen (6.73) y que sean ortogonales , pero no necesariamente son únicos (degeneración).. Entonces en general podemos siempre encontrar autovectores que satisfagan el hecho que sean ortonormales (e j ) e j jk T j , k 1,..., p Recordando como definimos los vectores en la forma e j è j1 e j 2 e jp versión escalar de la (6.74), para j, k 1,, p , será (6.74) T entonces la p e jh ekh jk (propiedad de ortonormalidad) (6.75) h 1 Mientras que se versión matricial es ( E) E I p T 19 (6.76) donde I p es la matriz identidad de dimensiones (pxp), similar a la definida en (6.31) para T el caso bi-dimensional. A partir de la (6.76) podemos pensar a la matriz ( E) (de dimensiones pxp) como la matriz inversa de la matriz E , ya que también E ( E )T I p (6.77) Una representación muy útil de S se puede obtener de la (6.72) y la (6.77) S E L ( E)T (6.78) Representaciones básicas de los conjuntos de datos:Fórmulas de Análisis y de Síntesis * La representación de la matriz de datos Z en términos de las componentes principales surge de la siguiente forma. Utilizando la (6.77) podemos plantear la siguiente identidad * * T * T Z Z E ( E ) Z E ( E ) (6.79) y definimos la matriz * AZ E ( Nxp ) (análisis) (6.80) Entonces la (6.79) tomará la forma * Z A ( E )T ( Nxp ) (síntesis) (6.81) Las ecuaciones (6.80) y (6.81) son una generalización de las ecuaciones (6.29) y (6.30) vistas para el caso bi-variacional. de forma tal que (similar a la (6.27), utilizando una notación más convencional para la matriz (el primer subíndice indica la columna, mientras que el segunda la fila) 20 a11 a p1 A a1 N a pN (6.82) Otra representación alternativa, consiste en definir vectores de dimensión Nx1, tal que Como en el caso bi-variacional a la matriz A la denominamos matriz amplitud y (en forma similar la (6.27)) la podemos pensar como construida por Nx1 vectores a j a j1 , a j 2 ,, a jN T (6.83) de forma tal que la (6.82) toma la forma A a1 a2 a p (6.84) Con esta notación la (6.80) (análisis), la matriz amplitud toma la siguiente forma a j Z* ej ( j 1,..., p) (análisis) (6.85) La fórmula (6.85) o su equivalente la (6.80) conforman la base del PCA. Los vectores a j son los vectores componentes prinipales (o amplitudes) en E p , mientras que los e j son los autovectores. Las propiedades del PCA Derivaremos algunas propiedades de las componentes principales de un conjunto de datos * Z de dimensiones Nxp. Las series correspondientes a las componentes principales [ ak (i) : i 1,..., N ], j 1,..., p son no correlacionadas a pares. Esto se deduce de la definición de A dada en (6.80) 21 T T * * T * * A A Z E Z E ( E ) Z Z E T ( E )T ( S E ) ( E )T ( E L) L Es decir A A L T (6.86) Utilizando la versión vectorial la (6.86) toma la forma (a j )T ak l j jk 1/ 2 Note el lector que l j (6.87) tiene las mismas dimensiones que los elementos de la matriz de * datos Z . Utilizando (6.86) podemos resolver (6.81) para E . Entonces, multiplicando cada lado de la T (6.81) sobre la izquierda por ( A) , y utilizando (6.86), suponiendo que todos los valores de * L son positivos, podemos encontrar una representación de E , usando Z y T E Z * A L A 1 (6.88) o en forma vectorial T e j l Z * a j 1 j j 1,..., p (6.88 a) La descomposición por valores singulares(singular value decomposition) SVD de un conjunto de datos 22 La descomposición por valores singulares de un conjunto de datos, realmente se obtiene a partir de la fórmula de síntesis (6.81) para el PCA. De (6.87) para cada l j , podemos definir la componente principal adimensionalizada j a j / l 1j / 2 (6.89) Por lo tanto definimos una matriz de amplitudes adimensionalizada (matriz de componentes adimensionalizada) en forma similar a la (6.84): A [1 p ] (Nxp) (6.90) donde j [1 j , 2 j ,, Nj ]T j 1,, p (6.91) Obviamente 1/ 2 A A L 1/ 2 L diag [ l11 / 2 ,, l1p/ 2 ] (6.92) y la (6.86) toma la forma A A I p T (6.93) Las fórmula equivalente a la (6.81) será * T 1/ 2 Z A L E ( Nxp ) (6.94) Los datos originales (valores no centrados) se obtendrán reescalando los datos de acuerdo a la (6.53) zij* ____ z ( j ) zij . 23 La ,ecuación (6.94) constituye una forma que se denomina descomposición por valores * singulares (SVD) del conjunto de datos Z , que veremos más adelante en detalle Ejemplo I: Supongamos que estamos frente a un proceso de control de calidad, que consiste en determinar la concentración de un determinado compuesto químico en una solución; y que la determinación se realiza por dos métodos diferentes sobre 15 muestras. Los 15 pares de valores (resultados obtenidos por el Método 1 y el 2) son ordenados en una matriz de datos donde los valores de las concentraciones son los individuos. Los resultados obtenidos por el Método 1 y los del Método 2 representan las variables. Es decir que * nuestra matriz de datos ( Z ) tendrá una dimensión de (15 x 2) (caso bi-variado, E2 ). Individuos o Nro. De Muestra Método 1 Método 2 1 10.0 10.7 2 10.4 9.8 3 9.7 10.0 4 9.7 10.1 5 11.7 11.5 6 11.0 10.8 7 8.7 8.8 8 9.5 9.3 9 10.1 9.4 10 9.6 9.6 11 10.5 10.4 12 9.2 9.0 13 11.3 11.6 14 10.1 9.8 15 8.5 9.2 Tabla I 24 Figura 2 . En primer lugar graficaremos los resultados de acuerdo a la Figura 1. Este esquema simple (Figura 2) suele dar alguna información sobre la muestra tomada, tanto en la disposición de los individuos como al comportamiento de las variables En primer lugar, podemos apreciar sí existe algún valor fuera de rango (outlier) o cualquier otra aberración en la medición (efecto que aparentemente no ocurre en este caso). También podemos observar si existe alguna relación entre variables (entre métodos de análisis en este caso) en base a la disposición de los individuos (concentraciones). Es decir, podríamos obtener alguna información básica por la simple inspección del gráfico. Sin embargo, hasta este método tan simple se complica si se han medido más de dos variables, por ejemplo p-variables. El problema surge en tales casos porque gráficos como el anterior, deben ser realizados tomando las variables de a pares, no permitiendo ver la relación en forma conjunta para todas las variables. Teóricamente para p-variables, los individuos tienen una representación en un espacio E p (espacio Euclideo de dimensión p), mediante sus coordenadas ( zi1 , zi 2 , .... , zip ) , pero no es posible representarlas gráficamente en forma conjunta. El PCA se presenta como una alternativa plausible para el análisis de varias variables. 15 Entonces calculamos los valores medios de cada variable Z (1) z i 1 15 i1 10.0 y 15 Z (2) z i 1 i2 15 10.0 . Se determinan las anomalías de los datos respecto de los valores medios (6.2). Debemos calcular ahora la matriz de dispersión S dada por la (6.46) (o la 25 matriz de covarianzas C dada por la (6.43)). Recuerde el lector que entre ambas hay un factor constante N-1=14. Para nuestro caso 0.7986 C 0.6793 T * * 11.1804 9.5102 S Z Z 9.5102 10.2802 0.6793 0.7343 Utilizando la matriz de covarianzas calculamos L (C L) E 0 que tendrá solución si det(C L) det(C l I 2 ) 0 Entonces 0.6793 0.7986 l det 0.12496 15329 2 0 0.7343 l 0.6793 l1 1.4465 (6.95) l2 0.086 Los autovectores se obtienen de la misma (6.72) haciendo 0.6793 e11 0.7986 l1 0.6793 e 0 0 . 7343 l 1 21 0.7986 l2 0.6793 y dando como resultado e 1 0.7236 0.6902 e2 0.6902 0.7236 Estos autovectores conforman la matriz: E 0.7236 0.6902 0.6902 0.7236 la que es ortonormal, esto es: T T ( e 1 ) e 1 (e2 ) e 2 1 y 26 (e1 ) e 2 0 T 0.6793 e12 0 0.7343 l2 e22 El ACP está destinado a explicar la estructura de varianza-covarianza a través de unas pocas combinaciones lineales de las variables originales. Sus objetivos generales son: 1) reducción de datos; 2) interpretación. Algebraicamente, las componentes principales son * * combinaciones lineales particulares de las p variables Z1 ,, Z p .sujetas a una condición de ortogonalidad. Figura 3 Utilizando nuevamente nuestro ejemplo de los dos métodos de análisis, podemos ver que: Geométricamente, estas combinaciones lineales representan la selección de un nuevo sistema de coordenadas, obtenido por rotación del sistema original de ejes coordenados 27 (Figuras 3). En la Figura 3, e11 0.7236 es el coseno del ángulo entre el antiguo eje y el nuevo eje-Método 1 ; mientras que e21 0.6902 es el coseno del ángulo entre el nuevo eje y el correspondiente eje-Método 2 . El nuevo eje relacionado con e 1 , corresponde a la línea de regresión. La Figura 3 contiene las mismas relaciones para e 2 . Excepto para valores de p = 2 o 3, la ecuación (6.95) no es utilizada en la práctica, en su lugar se aplican procesos iterativos que permiten obtener numéricamente las raíces y vectores característicos. Las Componentes Principales La matriz de covarianzas C [en su defecto la matriz de dispersión S o incluso la matriz de correlación, Corr , tal que C Corr cuando los datos son estandarizados según la (6.41)] es el punto de partida del PCA. Según la definición de C (6.43), para p-variables, S ij es la covarianza de la i-ésima variables de la variable Z i* Z i* * y la Z j ; mientras que Sii es la varianza * de la matriz de datos Z . Si la covarianza no es nula, esto está indicando que existe cierta relación lineal entre ambas variables. La magnitud de dicha relación está representada por el coeficiente de correlación ij . Sij ij (6.96) Sii S jj La rotación de los ejes principales (ver Figura 3) transforma las p-variables Z1 , Z 2 ,, Z p correlacionadas entre sí, en un conjunto de p-nuevas variables (componentes principales) no correlacionadas, a1 , a2 ,, a p . Los ejes coordenados de las nuevas variables están descriptos por los autovectores ei ( I 1,, p) , que forman la matriz E de cosenos directores utilizados en la transformación obtenida de la (6.81) A Z E . Se puede comprobar (cosa que no 28 haremos aquí) que tal rotación, cuando E es la matriz de autovectores de C , produce los máximos autovalores l i (i 1, ..., p) . El trabajar con las variables Z i (6.51) o con las variables centradas Z j ____ Z j Z ( j) (6.55), es totalmente equivalente desde el punto de vista del PCA, ya que Cov ( Z k , Z j ) Cov ( Z k , Z j ) (6.97) Entonces, de acuerdo con la (6.81) A Z E .las nuevas variables rotadas se obtendrán de acuerdo a la relación : AZ E Es decir: A a11 a12 ...... a1 p z11 z12 ...... z1p e11 e12 ...... e1 p a21 a22 ...... a2 p z 21 z 22 ...... z 2 p e21 e22 ...... e2 p .......... .......... .. .......... .......... ..... .......... .......... .. a N1 a N 2 .......a Np z N 1 z N 2 ...... z Np e p1 e p 2 ....... e pp (6.98) En forma vectorial, para cada nueva componente a1 Z e1 a p Z ep . (6.98 a) Definición 1: Llamamos Primera Componente Principal a la variable a1 , que es la combinación lineal de las filas (individuos) de Z varianza máxima (l1 ) . Propiedad : Var ( a1 ) = (l1 ) 29 y que por la (6.86) y (6.87) tiene En segundo lugar, queremos hallar otra dirección ( e2 ), ortogonal a e1 , de forma tal que los individuos (filas) de Z proyectados sobre ella tengan varianza residual máxima. ( l2 ). La condición de ortogonalidad se impone para asegurar que las proyecciones sobre e1 y sobre e2 no estén correlacionadas. Definición 2: Llamamos Segunda Componente Principal a la variable a 2 , que es la combinación lineal de las filas de Z , no correlacionada con a1 , y que posee varianza residual máxima. Propiedad: a) Var( a1 ) = l2 como l 1 l 2 entonces Var( a1 ) Var( a 2 ). b) Cov( a1 ,a2 ) = 0 Si repetimos el procedimiento buscando una tercera, cuarta, quinta,...., dirección ortogonal a las anteriormente definidas, y que tenga una varianza residual máxima, se puede comprobar que las direcciones que cumplen estas condiciones son las de e3 , e4 , e5 ,....... Definición 3: Lamamos j-ésima Componente Principal a la variable a j , que es la combinación lineal de las filas de Z , no correlacionada con las ak (k j ) , que tiene varianza residual máxima. Propiedad: a) Var( a j )= l j con Var( a1 ) Var( a 2 ) ...... Var( a j ) b) Cov( a j , a k ) = 0 si jk , Reconstrucción de la varianza total 30 j,k = 1, 2, ... , p Llamaremos Varianza Total a la suma de las varianzas de las Z j : Varianza Total = Var( Z 1 ) + Var( Z 2 ) + .... + Var( Z p ) = = S11 S 22 ..... S pp traza( C ) (6.99) De acuerdo a la (6.86) se tiene que: = traza( C )=traza( L )=Var( Z 1 Varianza Total ) + Var( Z 2 ) + .... + Var( Z p ) (6.100) Por lo tanto, las Componentes Principales han redistribuido la Varianza Total haciendo que las primeras acumulen la máxima cantidad de varianza posible. Cada Componente Principal acumula una proporción de la Varianza Total igual a: lp l1 l2 : : ....... : Var .Total Var .Total Var .Total Entonces, para las primeras k Componentes Principales se verifica que: Porcentaje de la varianza total acumulada por las primeras l l .... l k k-ésimas Componentes Principales = 1 2 x100 p l (6.101) j j 1 Obviamente, sí k = p se reconstruye el 100% de la varianza. Si, en lugar de la matriz C , utilizamos la de correlación ( Corr), entonces Sii 1 para todo i. En consecuencia, la traza de Corr contiene la Varianza Total, que es igual al número de variables p. c Varianza Total = traza ( Corr ) = traza ( L )= p En consecuencia, para las primeras k Componentes Principales: 31 Porcentaje de la varianza total estandarizada que acumulan l1c l2c .... lkc x100 las primeras k-ésimas Componentes Principales = p (6.101a) Si para un determinado valor de k ( k p) se reconstruye un porcentaje elevado de la Varianza Total, se puede reemplazar las p variables originales por las k primeras Componentes Principales, con poca pérdida de información. Por ejemplo en el caso de nuestro control de calidad (caso bivariado) la primera Componente Principal ( a1 ) acumula el 94.39% de la Varianza Total, lo que implica que el caso bivariado puede transformarse en un caso univariado, utilizando a a1 como única variable (en lugar de Z1 y Z 2 ), con muy poca pérdida de información. Interpretación de las Componentes Principales Cuando medimos las variables Z j , sabemos qué, los individuos representan los valores obtenidos de los pesos, longitudes, números de representantes de una dada especie, caudales, etc. Hemos definido nuevas variables ( a j ) que tienen ciertas propiedades estadísticas, pero si no podemos interpretarlas en términos de la disciplina donde estamos trabajando, no servirán de mucho. Para eso utilizaremos un criterio estadístico coherente con el usado hasta ahora: Como a j son una combinación lineal de las Z j , sería razonable pensar que entre las a j , aquellas que estén más fuertemente correlacionadas con las variables originales ( Z j ) serán las que más aporten a su interpretación. Calculemos, entonces, la correlación entre a j y cada una de las Z j . Para ello debemos describirlas en función de las variables centradas (6.53) de la forma aj Z ej y 32 Z j Z j (6.102) donde e j es el j-ésimo autovector de C y i es el vector unitario con todos sus elementos iguales a cero, salvo el i-ésimo, que vale 1. Podemos definir la matriz de covarianzas en notación matricial (a menos del factor constante N-1) de la forma: T C (Z ) Z T C (Z ) Z o Entonces, utilizando (6.102): Cov ( Z i , a j ) = T Z j aj = T Z i T T T T Z Z ej = Z e j = i T = i C e j = i l j e j = l j i e j = l j eij (6.103) donde eij es el i-ésimo elemento del autovector e j . Luego, en forma similar Cov ( Z i , a j ) ij Corr ( Z i , a j ) Var ( Z i ) Var (a j ) l j eij sii l j lj sii eij (6.104) (i, j 1,, p ) donde hemos utilizado la propiedad a) de la Definición 3 Si partimos de la matriz E eij de los autovectores, las correlaciones se calculan multiplicando cada columna ( j ) de la matriz E por la raíz cuadrada del autovalor correspondiente ( l j ) y dividiendo cada fila ( i ) por la raíz cuadrada de la varianza respectiva ( sii ). 33 Obtenemos, de esta forma una matriz [ij ] de Correlaciones entre Variables y Componentes Principales, mediante el siguiente procedimiento Multiplicar por l1 l2 ...... l ..... e11 e12 ..... e1 p e21 e22 ..... e2 p ..... ..... ..... ...... e p1 e p2 ...... e pp p Dividir por S11 S 22 ........ S pp Matriz de Autovectores E Es decir: l1 s11 e11 l1 = s22 e21 l2 s11 e12 ...... l2 s22 e22 ....... l p e1 p s11 l p s22 e2 p (6.105) .......... .......... .......... .......... .......... l1 s pp e p1 l2 s pp e p 2 ......... l p s pp e pp Si se trabaja con la matriz de correlación ( Corr en lugar de C ), la expresión de [ij ] se simplifica porque las varianzas Sii =1. 34 Una ventaja adicional de trabajar con la matriz Corr es que sí los Sii =1 para todo i=1,…,p, entonces, de acuerdo a la (6.104) ij l j eij Donde hemos utilizado la condición de consecuencia: Proporción de la varianza de Z i ( ij ) 2 l j y “ortonormalidad” de los autovectores. En reconstruida por las k primeras Componentes Principales = i21 i22 .... ik2 Para interpretar las Componentes, debemos observar las columnas de (6.106) por separado. En cada una de ellas se tiene las correlaciones de la respectiva a j con cada una de Las variables Z i las Z i . que posean mayor correlación con a j serán las que más aporten a la explicación de esta Componente Principal. Para completar la interpretación debemos considerar el signo de estas correlaciones. Si todas tienen el mismo signo, a j podría Z i interpretarse como la “abundancia” o “escasez” de las variables involucradas. Si tienen signos opuestos, esto indicaría que hay una oposición entre las variables de uno y otro signo: hay individuos que tienen mucho de las variables positivas y poco de las negativas y viceversa. Para el ejemplo bivariado (Ejemplo I) utilizado hasta ahora, tenemos que: = 0.974 0.969 0.227 0.248 Esto significaría que la Primera Componente Principal ( a1 ) tiene alta correlación (positiva) con ambas variables, Z 1 (Método 1) y Z 2 (Método 2), lo que implica que la nueva variable tiene “abundancia” de las antiguas variables. Entonces el problema 35 bivariado puede ser reducido a un problema univariado, sustituyendo las variables Z 2 Z 1 y por a1 sin una pérdida significativa de información. Para fijar conceptos, antes de hacer aplicaciones específicas en geofísica (que tienen sus particularidades), plantearemos un nuevo ejemplo. Ejemplo II: Supongamos que se quiere realizar un estudio morfométrico de 5 cráneos de una misma especie, midiendo en cada individuo el Largo Total (LT), el Ancho Máximo (AM) y Altura Media (Hm). Entonces: Individuos = 5 cráneos de una misma especie Variables = Z1 = (LT) Z 2 = (AM) Z 3 = (Hm) Los datos ordenados en forma de una matriz de n filas (5 individuos) y p columnas (3 variables) Z1 Z 2 Z 3 8 4 1 9 7 Matriz de datos = Z = 6 2 4 1 8 5 2 10 6 3 Tabla II ____ Entonces, Z (1) 8.40 ____ Z (2) 5.00 Y la matriz de datos centrados tendrá la forma 36 ____ Z (3) 1.80 0.4 1.0 0.8 0.6 1.0 0.2 Z 1.4 1.0 0.8 0.4 0 1.6 1.0 1 .3 La matriz de Covarianzas = C = 0.85 1 .0 1 .0 0.85 0.75 l 1 2.77915 Los autovalores de C : 1 .0 0.2 1.2 0.75 0.70 l 2 0.14128 l 3 0.07962 Mientras que la matriz de autovectores de C , tiene la forma 0.66368 E = 0.71312 0.22581 0.57481 0.67938 0.45611 0.47867 0.17291 0.86080 Las Componentes Principales se pueden calcular según (6.98) lo que nos dará: a1 a2 a3 0.532 0.142 1.223 A= 1.069 0.286 0.419 1.887 0.181 0.084 0.170 0.320 0.262 2.211 0.254 0.216 La Varianza Total = (traza de C ) =1.3 + 1.0 + 0.7 = ( l1 l2 l3 ) = 2.7792 + 0.1412 +0.0796 = 3. El porcentaje de la Varianza Total reconstruido por a1 = 92.64% El porcentaje de la Varianza Total reconstruido por a 2 = 4.71% 37 El porcentaje de la Varianza Total reconstruido por a3 = 2.65% La matriz de correlación entre las Componentes Principales y las Variables, de acuerdo a (6.105) será 0.97038 = 0.23504 0.05588 0.95826 0.25530 0.12870 0.95377 0.07766 0.29.32 La primera Componente, a1 , tiene correlaciones altas y de igual signo con las tres variables LT, AM y Hm , por lo que puede ser interpretada como el “tamaño” del cráneo. Los cráneos que tengan altos valores de las tres variables ( por ejemplo el quinto craneo) tomarán valores altos de a1 . La segunda Componente, a 2 , tiene las correlaciones más altas con LT y AM pero con signos opuestos: contrasta el largo y el ancho de los cráneos. Los cráneos “estirados” (más largos y menos anchos que el promedio) tendrán valores altos de a 2 (por ejemplo el primero); los más "aplastados" (menos largos y más anchos que el promedio) tomarán valores bajos de a 2 (segundo, tercero y cuarto). La tercera Componente, a3 , tiene su mayor correlación (-0.29032) con AM, con la que esta última Componente es fundamentalmente la "altura media" del cráneo. 38