Confusión e interacción:su abordaje en el análisis

Anuncio

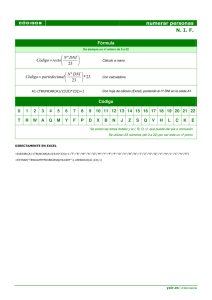

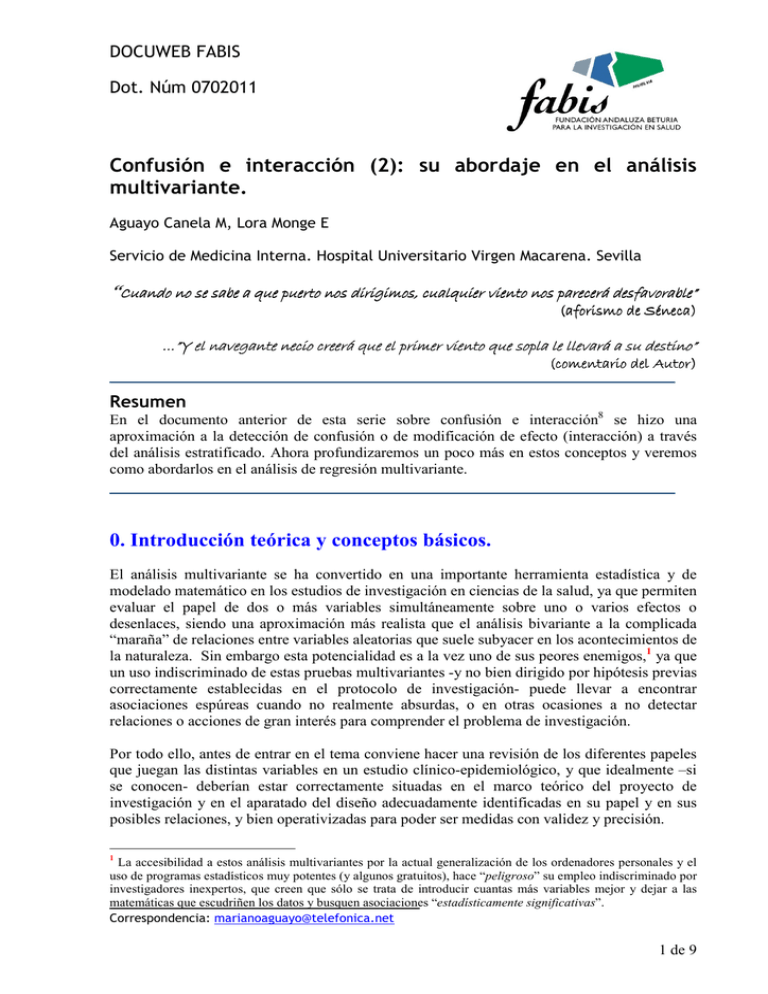

DOCUWEB FABIS Dot. Núm 0702011 Confusión e interacción (2): su abordaje en el análisis multivariante. Aguayo Canela M, Lora Monge E Servicio de Medicina Interna. Hospital Universitario Virgen Macarena. Sevilla “Cuando no se sabe a que puerto nos dirigimos, dirigimos, cualquier viento nos parecerá desfavorable” (aforismo de Séneca) creerá erá que el primer viento que sopla le llevará a su destino” …”Y el navegante necio cre (comentario del del Autor Autor) utor) Resumen En el documento anterior de esta serie sobre confusión e interacción8 se hizo una aproximación a la detección de confusión o de modificación de efecto (interacción) a través del análisis estratificado. Ahora profundizaremos un poco más en estos conceptos y veremos como abordarlos en el análisis de regresión multivariante. 0. Introducción teórica y conceptos básicos. El análisis multivariante se ha convertido en una importante herramienta estadística y de modelado matemático en los estudios de investigación en ciencias de la salud, ya que permiten evaluar el papel de dos o más variables simultáneamente sobre uno o varios efectos o desenlaces, siendo una aproximación más realista que el análisis bivariante a la complicada “maraña” de relaciones entre variables aleatorias que suele subyacer en los acontecimientos de la naturaleza. Sin embargo esta potencialidad es a la vez uno de sus peores enemigos,1 ya que un uso indiscriminado de estas pruebas multivariantes -y no bien dirigido por hipótesis previas correctamente establecidas en el protocolo de investigación- puede llevar a encontrar asociaciones espúreas cuando no realmente absurdas, o en otras ocasiones a no detectar relaciones o acciones de gran interés para comprender el problema de investigación. Por todo ello, antes de entrar en el tema conviene hacer una revisión de los diferentes papeles que juegan las distintas variables en un estudio clínico-epidemiológico, y que idealmente –si se conocen- deberían estar correctamente situadas en el marco teórico del proyecto de investigación y en el aparatado del diseño adecuadamente identificadas en su papel y en sus posibles relaciones, y bien operativizadas para poder ser medidas con validez y precisión. 1 La accesibilidad a estos análisis multivariantes por la actual generalización de los ordenadores personales y el uso de programas estadísticos muy potentes (y algunos gratuitos), hace “peligroso” su empleo indiscriminado por investigadores inexpertos, que creen que sólo se trata de introducir cuantas más variables mejor y dejar a las matemáticas que escudriñen los datos y busquen asociaciones “estadísticamente significativas”. Correspondencia: [email protected] 1 de 9 Aguayo Canela, Mariano DocuWeb fabis.org Así, en un problema de investigación clínica, aunque normalmente se evalúa un binomio principal, en general una “causa” y un “efecto”, caben distinguir los siguientes tipos de variables y sus relaciones, resumidas en la figura 1: • VARIABLE DEPENDIENTE: es la variable respuesta, resultado, desenlace o efecto (outcome en inglés), la que se desea comprender o predecir. • VARIABLE INDEPENDIENTE o FACTOR EN ESTUDIO: es la principal variable que los investigadores intentarán relacionar con la respuesta o variable dependiente, evaluando su influencia o relación causal. • VARIABLES CONFUNDENTES o FACTOR DE CONFUSIÓN: Es una variable externa a la relación principal que se evalúa y anterior en el tiempo al posible factor de estudio, aunque de alguna manera relacionada tanto con él como con la variable dependiente, de forma que su presencia distorsiona la medida de asociación entre la variable dependiente y la variable independiente2 (se dice que sesga o confunde la estimación de dicha medida, ya sea una OR o un RR), y… a. puede observarse un efecto donde en realidad no existe (relación espúrea) b. puede hallarse una exageración de una asociación real (confusión positiva) c. puede encontrarse una atenuación de una asociación real (confusión negativa) d. excepcionalmente puede incluso alterar el sentido de la asociación real, invirtiéndolo (efecto paradójico) • VARIABLES MODIFICADORAS DE EFECTO o de INTERACCIÓN: Es una variable que interactúa con la variable independiente modificando su efecto sobre la variable dependiente. A veces aumenta el efecto del factor de estudio, hablándose de efecto sinérgico. Otras veces reduce, elimina o incluso invierte el efecto del factor en estudio, y se habla de antagonismo, efecto supresivo o efecto antagónico. • VARIABLES NO CONTROLADAS: Así se conoce de forma genérica a cualquier variable que tiene efecto o asociación con la variable dependiente pero que no está relacionada con el factor en estudio o variable independiente. Se tratan de otros factores que explican parte del efecto evaluado, por lo que su no inclusión en el estudio conlleva a interpretaciones incompletas del fenómeno estudiado y a modelos con menor capacidad predictiva. • VARIABLES INTERMEDIARIAS: Se trata de cualquier variable que se sitúe, dentro de la cadena causal, entre la variable dependiente y el factor de estudio. Pueden asociarse estadísticamente a las variables principales del estudio y conducir a diferentes estimaciones de la relación principal que se evalúa si se tienen en cuenta o no en el análisis (ajuste), comportándose de forma muy similar a los factores de confusión, con los que se diferencian únicamente en que las variables intermediarías sí forman parte de la cadena etiológica. • VARIABLES “POSTERIORES”: Se trataría de variables cuya actuación en la cadena causal es posterior al efecto o desenlace (variable dependiente), incluso pudiera ser consecuencia de éste. 2 Sus características quedaron establecidas en la primera parte de este documento: debe ser un factor de riesgo para el efecto que se evalúa, debe estar relacionada con la variable independiente y debe excluirse que se trate de un eslabón intermedio en la cadena causal. DocuWeb fabis.org 2 de 9 Confusión e interacción (2): su abordaje en el análisis multivariante. VARIABLE MODIFICADORA DE EFECTO fabis.org, 2007 VARIABLE NO CONTROLADA VARIABLE INDEPENDIENTE VARIABLE DEPENDIENTE (Factor en estudio, criterio, exposición, causa) (Resultado, “outcome”, efecto) Variable Intermediaria VARIABLE CONFUNDENTE (Factor de confusión, efectos mezclados) VARIABLE “POSTERIOR” Figura 1. Se muestran los principales tipos de variables que pueden existir en un diseño de investigación (en recuadros) y sus relaciones (con flechas, siendo las marcadas en azul las que tienen sentido “etiológico” o “causal” y las rojas las que tienen sentido de asociación “estadística”). La relación fundamental que se evalúa es la que se sitúa sobre el recuadro amarillo, esto es, la asociación (causal o no) entre la variable dependiente y el factor en estudio o variable independiente principal, constituyendo el objetivo en sí del estudio analítico. Sin embargo su estimación puede verse influida, en diferentes formas, por terceras variables. Cualquier estudio analítico bien diseñado debería evaluar la relación entre la variable independiente y la variable dependiente (objetivo principal) para obtener una estimación no sesgada y precisa de la medida de asociación (una OR o un RR) entre ambas. Como ya sabemos, los sesgos nacen de diseños y mediciones incorrectas, y de la presencia de factores de confusión no controlados. Para conseguir esto último -el control de los factores confundentes- hay cinco estrategias fundamentales, tres en la fase del diseño y dos en la fase del análisis: 1. Emparejamiento o “matching”: consiste en seleccionar individuos emparejados por el factor presumiblemente confundente. Es una estrategia empleada en los estudios caso-control. 2. Restricción: consiste en restringir el estudio al grupo de individuos en los que no esté presente el factor presumiblemente confundente, aún a expensas de perder información y capacidad de generalización de resultados. 3. Asignación aleatoria: es el procedimiento más perfecto para controlar la confusión, no sólo para factores conocidos sino también para factores desconocidos o no medidos. DocuWeb fabis.org 3 de 9 Aguayo Canela, Mariano DocuWeb fabis.org La distribución de los individuos a los grupos de comparación por mecanismos exclusivamente aleatorios (la randomización típica de los ensayos clínicos aleatorizados) hará que, en muestras grandes, se balanceen por igual diferentes factores, de manera que pierdan su capacidad de alterar o mezclar los efectos medidos. Su limitación es que sólo es aplicable a estudios experimentales en los que el investigador manipula o decide la exposición (variable dependiente), y no tiene aplicación en los estudios analíticos. 4. Análisis estratificado: es un procedimiento -en la fase de análisis- que permite obtener medidas de asociación entre las variables principales del estudio en los diferentes estratos establecidos por terceras variables presumiblemente confundentes. (Ha sido objeto de revisión en el documento anterior) 5. Análisis multivariantes: Los modelos de regresión múltiple (lineal, logística, de Cox) son excelentes herramientas para controlar el efecto de terceras variables, ya que permiten –como su nombre indica- evaluar simultáneamente las relaciones entre más de dos variables. Las dos últimas son estrategias de control de la confusión empleadas en la fase de análisis de los datos. Requieren por tanto, que los factores o variables que deseen controlarse se hayan tenido en cuenta en el diseño del estudio y se hayan recogido de forma válida y precisa en los individuos estudiados. Sólo así será posible “ajustar” por dichas variables en los análisis estadísticos. Ajustar y controlar son términos sinónimos en este sentido y pueden usarse alternativamente. De hecho, ajustar por una tercera variable implica controlar o reducir su variabilidad, por ejemplo dejándola fija o constante. Sin embargo, controlar la relación principal por una tercera variable tiene implicaciones, al disminuir la variabilidad de las otras dos variables (exposición y respuesta). El descenso en la variabilidad de la respuesta (v. dependiente) implica una menor incertidumbre en el devenir de los acontecimientos y, con el mismo número de individuos, un estudio más preciso y más informativo; por el contrario, al disminuir la variabilidad en la exposición o intervención (v. independiente) se puede perder eficiencia estadística. Ajustar por una tercera variable tiene por tanto pros y contras, que el investigador debe valorar: con ello conseguirá establecer mejor (sin sesgo) el efecto de una determinada exposición o intervención, independientemente de los efectos de otras variables, pero quizás a expensas de incrementar el error aleatorio o incluso de alejarse del auténtico objetivo del estudio, haciendo irreal su aplicación. En general, las técnicas de ajuste estadístico permitirán controlar el efecto de terceras variables que puedan influir en la relación entre la exposición (variable independiente) y la respuesta (variable dependiente). Por supuesto esto requiere el conocimiento previo de que dichas variables pueden afectar a la relación evaluada (lo que enfatiza la adecuada revisión teórica y bibliográfica previa al diseño de cualquier investigación), y su recogida y registro en el estudio. Por ello, antes de llevar a cabo cualquier análisis estadístico multivariante con las variables incluidas en el estudio, los investigadores deberían –bajo la óptica del conocimiento previo del problema- intentar clasificar las variables y establecer una estrategia de análisis, tal y como se propone en el cuadro siguiente: DocuWeb fabis.org 4 de 9 Confusión e interacción (2): su abordaje en el análisis multivariante. TIPO DE VARIABLE Estrategia en el análisis Dependiente INCLUIR SIEMPRE Independiente INCLUIR SIEMPRE Confundente PROBAR ANTES Modificadora de efecto (V. de interacción) PROBAR ANTES Intermedia NO INCLUIR Posterior NO INCLUIR fabis.org, 2007 Comentario / Observación Es el efecto o resultado, la variable que intenta modelizarse, exlicarse, predecirse… Se incluirá siempre en el modelo de regresión. Es la exposición o causa, la variable principal elegida como predictora, factor de riesgo, factor causal… Se incluirá siempre en el modelo de regresión, y si no se detecta asociación con la v. dependiente se explorará la relación incluyendo otras variables posiblemente explicativas, confundentes o modificadoras de efecto, que pudiesen estar sesgando o alterando la verdadera asociación entre ellas. Son variables asociadas a la exposición y a la vez predictoras del efecto o resultado, y pueden alterar la relación principal evaluada. Su inclusión en el modelo multivariante hará que se modifique la medida de asociación entre la v. independiente y la v. dependiente, representada por el coeficiente de regresión (b) y su error estándar (ee). El investigador decidirá si este cambio mejora el modelo de regresión y, por tanto, debe mantenerse dicha variable confundente para reducir o controlar un posible sesgo. Son variables que interactúan con la v. independiente modificando su acción sobre la v. dependiente, por lo que deben ser tenidas en cuenta ya que son explicativas de la relación principal evaluada, aportando información adicional importante sobre cómo es dicha relación. En los modelos multivariantes suelen incluirse si sus coeficientes de regresión son estadísticamente significativos. Actúan de forma parecida a los factores de confusión pero forman parte de la cadena causal, por lo que en parte son efecto del factor de estudio o v. independiente (y en este sentido no modificables externamente), y por ello su inclusión en el análisis puede ser innecesaria y aumentar el error aleatorio. Incluirlas en el modelo puede producir un sesgo por sobreajuste. 1. Como operar en el análisis multivariante. Los modelos de regresión multivariante constituyen actualmente una poderosa herreamienta como técnica de control, de forma que se emplean extensamente para evaluar o medir el efecto de una determinada exposición (X) sobre una respuesta (Y) en presencia de terceras variables (X1, X2, X3,…, Xi) susceptibles de producir fenómenos de confusión e interacción. Debe ser el investigador quién determine el conjunto de las i potenciales variables de control, que deberán ser recogidas –junto con las variables principales X e Y objeto del estudio- de forma sistemática y precisa. La identificación de estas variables de control, que fundamentalmente dependen del objetivo del estudio, se realizará a partir de los conocimientos teóricos y de una sólida revisión bibliográfica de investigaciones previas en las que hayan sido exploradas. Si no se tienen en cuenta y no se miden, los resultados del estudio pueden ser incorrectos, sesgados o inválidos. A continuación se describen los pasos que deben darse para llevar a cabo un análisis multivariante: DocuWeb fabis.org 5 de 9 Aguayo Canela, Mariano DocuWeb fabis.org Paso 1: Construcción de una matriz de datos con las variables principales del estudio (X e Y) y con el conjunto de las i variables susceptibles de control. Esta matriz de datos debería sustentarse en la correcta identificación del papel jugado por las variables (ver figura 1), y contendrá la mayor cantidad de variables medidas, siempre y cuando tengan una justificación teórica y no sean ni variables posteriores ni variables intermedias en la relación principal evaluada (X → Y). Pueden añadirse a la matriz algunas funciones de las variables (Xin, logXi, 1/Xi, etc.) que puedan mejorar el ajuste del modelo, sobre todo si se conoce o sospecha que la relación entre ellas y la variable respuesta (Y) no es lineal. Paso 2: Evaluación bivariante y análisis estratificado. Debería evaluarse la relación simple entre la variable dependiente (Y) y la independiente (X) y obtener una medida “cruda” de dicha asociación. Esta será una medida sesgada -en presencia de confusión- o promedio -en presencia de interacción-. Así mismo debería explorarse, para las variables de control (X1, X2, X3,…, Xi), la posible asociación simple con la variable respuesta (Y), para evaluar su efecto en el estudio. Estas medidas de asociación (OR, RR) así obtenidas deben interpretarse con cautela y sirven para tener una idea sobre si hay o no confusión y/o interacción. De hecho deben completarse con el análisis estratificado o multivariante, introduciendo una tercera variable (Xi) cada vez en la evaluación de la relación principal estudiada (X → Y) y observando si cambian los índices, tanto en magnitud como en dirección. • En el ANALISIS ESTRATIFICADO, las categorías de la variable de control serán las que establecen la estratificación, y para cada estrato se obtendrá una medida de asociación. • Si llevamos a cabo directamente el ANALISIS MULTIVARIANTE introduciendo entre las variables predictoras (“covariables” o “independientes” en el programa SPSS) la independiente (X) y la de control (Xi), obtendremos un coeficiente de regresión de X sobre Y ajustado por Xi. Paso 3: Incluir en el modelo todas las potenciales variables de control. Establecidas las variables a controlar, el análisis multivariante debe iniciarse incluyéndolas todas en el modelo (conocido así como modelo máximo inicial, por contener todos los términos de confusión y de interacción), y debe obtenerse la estimación de los parámetros. Para llevar a cabo este procedimiento no se pueden utilizar las funciones automáticas de regresión de la mayoría de los programas estadísticos, sino que debe ser el analista quién conduzca la acción; en el programa SPSS esto supone emplear la opción “Introducir” (“Enter” en la versión en inglés). Si el subconjunto de i variables de control es elevado conviene seleccionar, como variables a controlar e incluir en los modelos, un número más reducido, en base a: - incluir las más importantes desde el punto de vista clínico o epidemiológico incluir las que tienen una interpretación más clara dejar fuera las que están medidas de forma subjetiva o poco fiable DocuWeb fabis.org 6 de 9 Confusión e interacción (2): su abordaje en el análisis multivariante. - fabis.org, 2007 si varias miden aspectos parecidos, incluir sólo la más fácil de medir o la que se obtenga a menor coste Paso 4: Valorar posibles efectos de interacción. Antes de evaluar la confusión, debe evaluarse la interacción, ya que a veces dichos fenómenos coexisten en la misma variable Xi, y si no se hace así y se procede directamente a ajustar por ella se perderá la ocasión de explicar más correctamente el fenómeno estudiado. En el artículo anterior se explicó como puede evaluarse la interacción o modificación de efecto en el análisis estratificado, tanto en un modelo multiplicativo (OR, RR) como en un modelo aditivo (RA), al detectarse valores diferentes en los estratos establecidos por la tercera variable y, a su vez, diferentes del valor global o crudo, que resulta un promedio de los otros. En el análisis de regresión multivariante (lineal o logística), los términos de interacción tienen carácter multiplicativo y se anotan por: X*Xi Ciertamente se pueden generar términos de interacción de 2º orden (con dos variables modificadoras de efecto X*Xi*Xj), 3er orden (con tres variables modificadoras de efecto X*Xi*Xj*Xk) o incluso superiores, pero son de difícil interpretación clínica y pueden dar problemas de colinealidad, por lo que no son aconsejables. Igual ocurre con términos multiplicativos de variables de confusión (Xi*Xj). Debe seguirse, en la inclusión de términos multiplicativos de interacción, el llamado principio jerárquico,3 que supone que en una familia de modelos jerárquicos, si se elimina un término cualquiera, todos los términos de mayor orden en los que intervenga también deben ser eliminados; y a la inversa, si se incluye un término cualquiera, todos sus términos de menor orden deben estar presentes en el modelo. La presencia de interacción o modificación de efecto se valora, en los modelos de regresión multivariante, con pruebas de significación estadística. Esto es, deberían quedar en el modelo los términos de interacción que sean estadísticamente significativos y, según el principio jerárquico, todos los términos elementales o de orden menor que los contengan. Y deberían, alternativamente, eliminarse del modelo aquellos términos de interacción cuyos coeficientes de regresión no sean estadísticamente significativos y, por ende, los términos de mayor orden que los contengan. Si hay varias interacciones en el modelo, debe evaluarse el conjunto de interacciones empezando por las de orden mayor, con una prueba de significación global (chunk test) sobre el decremento de R2 producido al estimar el modelo máximo sin estos términos de interacción: si el resultado de la prueba es estadísticamente NO significativo se procede a eliminar del modelo el conjunto de interacciones, mientras que si es estadísticamente significativo se pasa a explorar el grado de significación de cada interacción, dejando en el modelo aquellas que son estadísticamente significativas y eliminando el resto. En el modelo deben de quedar, por el principio jerárquico, aquellos términos e interacciones de orden menor que sean componentes de las interacciones retenidas. El proceso sigue 3 Bishop, Fienberg, Holland (1975) DocuWeb fabis.org 7 de 9 Aguayo Canela, Mariano DocuWeb fabis.org entonces evaluando las interacciones de orden menor con una prueba de significación global (chunk test), de forma similar a lo explicado antes para las interacciones de orden mayor, eliminándolas todas si el resultado es estadísticamente NO significativo, o pasando a evaluar cada interacción de primer orden si la prueba global es significativa. Al final nos debe quedar un modelo que contiene todos los términos de confusión, los términos de interacción que han resultado estadísticamente significativos y los términos retenidos por el principio jerárquico. Paso 5: Valorar la presencia de confusión. La decisión de eliminar o dejar en el modelo de regresión los términos de confusión no deben tomarse en razón de los resultados de una prueba de significación, puesto que su objetivo es estimar sin sesgo (o ajustadamente) el coeficiente de la exposición o v. independiente (X), y que mide la contribución de X en explicar o predecir Y. Se tratará por tanto de incluir en la ecuación final sólo aquéllos términos de confusión que producen cambios científicamente importantes en el comportamiento del modelo y, en último extremo, el la relación entre X e Y. En este caso el procedimiento es más laborioso, puesto que conlleva comparaciones entre el modelo de referencia (que contiene el término de confusión evaluado) y el modelo reducido (que no lo tiene), valorando los cambios de los coeficientes de la variable independiente X y de los términos de interacción y de sus componentes retenidos en el paso anterior. Aquí no hay pruebas estadísticas para tomar la decisión, pudiendo ser orientativo el criterio de mantener aquellos términos de confusión cuya eliminación modifica en más de un 10% el valor neto del coeficiente de regresión principal.(Ref. 5) Al evaluar varios factores de confusión de la manera antes comentada, se obtendrán diversos modelos de regresión. El modelo final se elige entre los submodelos con diferencias clínicamente relevantes sobre el modelo de referencia, teniendo en cuenta, además de ventajas teórico-prácticas en su aplicación, el que estime el efecto (Y) de forma más precisa (con menor error estándar o IC95% más estrecho). Referencias bibliográficas. 1. Doménech JM, Sarriá A. Análisis multivariante: modelos de regresión. Unidad Didáctica 8: Confusión e interacción. Editorial Signo. Barcelona, 1997. 2. De Irala-Estévez J, Martínez-González MA. Errores en la estimación de medidas de asociación en estudios epidemiológicos. En: Epidemiología Aplicada. Ariel Ciencias Médicas. Editorial Ariel S.A. Barcelona, 2004. Capítulo 7, páginas 257-346. 3. De Irala-Estévez J, Martínez-González MA. Variables modificadoras de efecto. En: Epidemiología Aplicada. Ariel Ciencias Médicas. Editorial Ariel S.A. Barcelona, 2004. Capítulo 8, páginas 347-370. 4. Cobo E, Buekens P. Necesidades y limitaciones del ajuste. Med Clin (Barc) 1990; 95: 702-708. DocuWeb fabis.org 8 de 9 Confusión e interacción (2): su abordaje en el análisis multivariante. fabis.org, 2007 5. de Irala J, Martínez-González MA, Guillén-Grima F. ¿Qué es una variable de confusión? Med Clin (Barc) 2001; 117: 377-385. 6. Cobo E, Corchero C. Ajuste: qué variables, cómo y cuándo. FMC 2003; 10(10): 741742. 7. Cobo E. Análisis multivariante en investigación biomédica: criterios para la inclusión de variables. Med Clin (Barc) 2002; 119(6): 230-237. 8. Aguayo M. Confusión e interacción (1): Qué son, qué suponen y cómo manejarlas en el análisis estratificado. DocuWeb-fabis. Huelva: Fundación Andaluza Beturia para la Investigación en Salud.[en línea] Disponible desde Internet en: <http://www.fabis.org/html/?page_name=DocuWeb> [consultado el 07/05/2007] DocuWeb fabis.org 9 de 9